Le intelligenze artificiali evolvono rapidamente e hanno un ruolo sempre più centrale in molti processi decisionali in ambito di cybersicurezza. Garantire l’affidabilità dei sistemi di AI è un elemento chiave per questa evoluzione, ed è anche lo scopo del progetto Spatial, un consorzio di dodici partner provenienti da otto stati dell’UE finanziato dal programma Horizon 2020.

Cos’è il progetto Spatial

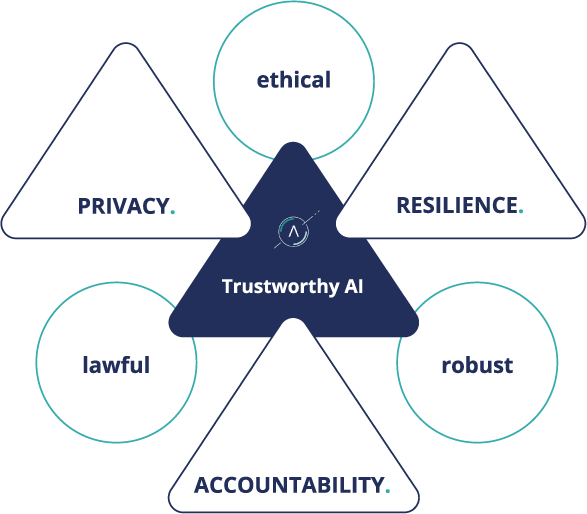

Spatial ha l’ambizione di massimizzare l’affidabilità e la resilienza delle soluzioni di cybersicurezza guidate da un’intelligenza artificiale. Il programma prevede cinque aree di ricerca principali, affidate a più membri del consorzio, che collaboreranno per svilupparle.

- Trasparency and Explainability

Lereti neurali profonde non sono trasparenti by design. Spiegare perché, dopo la fase di addestramento, l’AI prenda una decisione piuttosto che un’altra è un compito complesso. Sono in sviluppo metodi e processi in grado di rendere spiegabile e comprensibile il modello di funzionamento dei software di apprendimento automatico.

- Resilience and Privacy

Tutti i modelli d’intelligenza artificiale basata sul machine learning hanno bisogno di molti dati e di una fase di apprendimento. Questo rende i risultati suscettibili a bias presenti nei dati originali e sensibili a eventuali attacchi esterni che sfruttano gli schemi decisionali ricavati durante il training per hackerare il funzionamento del sistema. Un’AI affidabile deve essere sicura sotto questo punto di vista e deve anche garantire la privacy dei soggetti in qualche misura coinvolti nella raccolta dati.

- Societal Impact

Da più di mezzo secolo si discute di etica delle macchine dotate di una qualche forma di intelligenza artificiale. Adesso, con l’esponenziale crescita delle applicazioni pratiche dell’AI, serve un framework di regolamentazioni e standardizzazioni che guidino gli sviluppatori e i ricercatori nella giusta direzione.

- Education

Gli ambiti applicativi dell’AI e del machine learning sono tantissimi. Occorre formare personale specializzato in grado di rispondere alle future esigenze del mercato, riguardanti la parte tecnica e legislativa delle applicazioni per la cybersicurezza.

- Business Models

La ricerca trova il suo scopo ultimo nell’applicazione pratica. Le esigenze di cybersicurezza di enti pubblici e privati diventano sempre più specifiche, dando vita a nuove opportunità di business ancora da esplorare.

Tre domande sul progetto Spatial

F-Secure è un partner chiave nel progetto Spatial Horizon 2020 della Commissione Europea. Collaborerà con il mondo accademico e altri player di caratura internazionale per aumentare l’affidabilità e la sicurezza dell’intelligenza artificiale e della gestione dei dati nelle applicazioni di sicurezza informatica. Abbiamo fatto qualche domanda a Andrew Patel, ricercatore senior dell’Artificial Intelligence Center of Excellence di F-Secure, per approfondire la mission del progetto Spatial.

Se gli algoritmi di machine learning sono in grado di generalizzare abitudini e comportamenti degli utenti a partire dai dati c’è un rischio per la privacy. Quali strumenti ci sono per assicurare la riservatezza del dato?

“L’uso dell’apprendimento automatico apre metodi più rispettosi della privacy per la condivisione dei dati, come la condivisione di modelli, la condivisione di variabili latenti e altri stati del modello interno e la condivisione di elementi embedded, che non contengono informazioni direttamente identificabili. Poiché esistono attacchi di inferenza (progettati per determinare i dati utilizzati durante l’addestramento del modello), rendiamo anonime le informazioni identificabili prima della vettorizzazione. Le tecniche crittografiche, come la privacy differenziale, possono essere utilizzate per proteggere ulteriormente i modelli di apprendimento automatico da attacchi di inferenza e meccanismi simili che violano la privacy.”

È stato dimostrato che il comportamento dei modelli di Machine Learning può essere hackerato con una certa facilità. Esistono soluzioni efficaci nel contrasto di questo fenomeno?

“Esistono diversi attacchi avversari contro i modelli di apprendimento automatico, a seconda del tipo di modello impiegato e dell’obiettivo dell’avversario. Abbiamo condotto uno studio completo su questi attacchi nell’ambito del progetto Horizon 2020 denominato. Abbiamo anche dettagliato i meccanismi di mitigazione (dalla letteratura attuale) contro alcuni attacchi attuali. Più di recente, abbiamo eseguito studi più approfonditi sugli attacchi contro i sistemi di apprendimento automatico distribuiti e sviluppato un serie di mitigazioni contro i nostri attacchi proposti. Le mitigazioni contro gli attacchi avversari tendono ad essere specifiche del tipo di modello attaccato e dell’attacco stesso. È quindi importante eseguire un processo di threat modelling progettato per comprendere le motivazioni di un avversario e i possibili modi in cui potrebbe attaccare un sistema, simulare tali attacchi e quindi sviluppare difese che si possano dimostrare efficaci contro tali attacchi.”

Nell’ambito del progetto vengono utilizzate o sperimentate tecniche di XAI (eXplainable Artificial Intelligence) per garantire l’affidabilità dei processi decisionali AI-guided?

“Alcuni dei modelli con cui lavoriamo sono, per impostazione predefinita, abbastanza spiegabili, poiché sono costruiti utilizzando meccanismi con spiegabilità intrinseca (come gli alberi decisionali). Per i casi più complessi, utilizziamo strumenti e tecniche di visualizzazione per facilitare la spiegazione del modello.”

Durante l’intervista, F-Secure ci ha mostrato uno strumento che “visualizza i limiti decisionali di alcuni modelli semplici e illustra come cambiano mentre sono sotto attacco.”

Milioni di persone in tutto il mondo affidano la sicurezza dei loro dati, e quindi delle loro attività private e professionali, a reti neurali sempre più avanzate. Progetti di collaborazione come Spatial potranno trovare nuove soluzioni per garantire non solo che l’AI funzioni, ma che sia anche affidabile e trasparente così come dovrebbe essere qualsiasi software che abbia accesso ai nostri dati.