L’AI spiegata agli umani

Si scrive “bias” si legge “pregiudizi algoritmici”. Sono questi uno dei principali motivi di preoccupazione per l’AI. Perché i bias la rendono inaffidabile, parziale e a volte anche pericolosa.

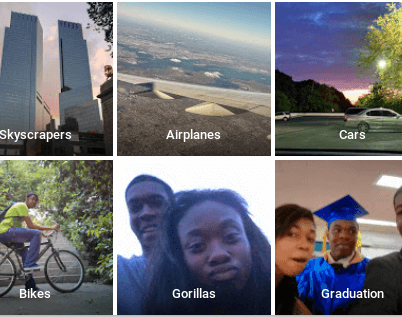

L’intelligenza artificiale, difatti, è caduta talvolta in clamorosi e imbarazzanti errori. È sufficiente accennare al “caso dei gorilla”, un incidente del 2015, quando il modello AI di Google Photos che forniva una descrizione alle immagini indicò come gorilla due persone di colore. Una delle persone coinvolte, lo sviluppatore Jacky Alciné, lo segnalò su Twitter e Google si scusò profusamente (il tweet nel frattempo è stato cancellato, ma è presente una copia qui).

La descrizione di AI Google Photos che ha fatto infuriare i ragazzi ritratti nella foto (e non solo loro)

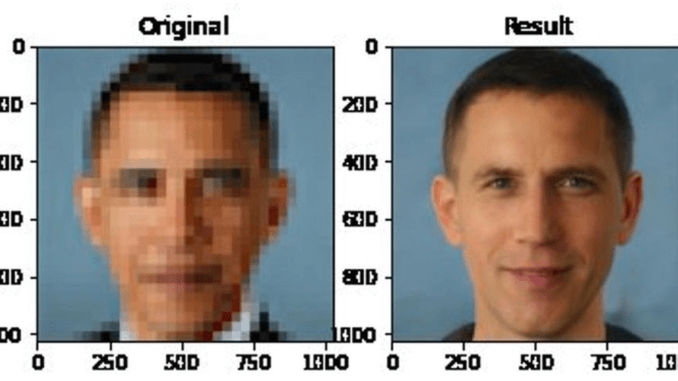

Volendo citare un esempio più recente, accaduto nel giugno 2020, si può parlare dell’”Obama bianco”. In questo caso l’algoritmo StyleGAN di NVIDIA (lo stesso usato per creare volti che non esistono) era stato utilizzato per eseguire l’upscaling di alcune foto, ovvero un aumento di definizione grazie alla “previsione” di quali potrebbero essere le informazioni mancanti.

L’algoritmo Pulse prende un’immagine a bassa risoluzione e la ricostruisce (approssimando i pixel) per aumentare la risoluzione

Purtroppo per il modello, ma soprattutto per noi che abbiamo dovuto assistere a questa nuova e imbarazzante débâcle, i dataset usati per il training probabilmente non contenevano abbastanza volti di persone di colore – sicuramente non abbastanza di Barack Obama – per consentire alla rete neurale di migliorare le sue previsioni e ricreare il volto che tutti ci aspettavamo.

Bias, i limiti dei modelli di computer vision

Veniamo a oggi. In questi giorni si parla insistentemente di un nuovo caso, ovvero il “bikini della politica americana” Alexandria Ocasio-Cortez (nota anche come AOC). Uno studio sui bias condotto da due ricercatori, Ryan Steed e Aylin Caliskan, ha evidenziato i limiti dei modelli di computer vision che si basano sul machine learning non supervisionato, ovvero senza etichettatura delle immagini di training, una novità abbastanza recente, poiché in genere l’addestramento per questi algoritmi è supervisionato da esseri umani.

SimCLR di Google e iGPT di OpenAI (quest’ultimo basato sul modello di elaborazione del linguaggio naturale GPT-2) sono gli algoritmi testati dai ricercatori, che hanno dimostrato come anche un modello non supervisionato, quando è addestrato su un dataset contenente pregiudizi anche semplicemente impliciti, crea delle dei pattern che potremmo considerare socialmente sconvenienti.

Scopo dei ricercatori in realtà era creare una tecnica per quantificare le associazioni pregiudizievoli fra le rappresentazioni di concetti sociali e le caratteristiche delle immagini. Per farlo hanno addestrato i due algoritmi sul dataset di ImageNet 2012 (un grande dataset contenente 14 milioni di immagini) dopodiché hanno deciso di dare in pasto a iGPT, fra le altre, questa fotografia di AOC.

Foto di AOC scattata da David Pexton per The New Yorker

In realtà non è stata fornita la fotografia per intero: i ricercatori hanno mandato in input solo la parte superiore dell’immagine, fino a circa il collo della deputata statunitense. Dal collo in giù sarebbe stato compito del modello finire di disegnare l’immagine.

Le stesse istruzioni sono state eseguite anche per altre fotografie di persone diverse, uomini e donne. Ma, mentre nelle immagini contenenti volti maschili il modello ha creato nella maggior parte dei casi corpi e vestiti compatibili con una situazione di business o comunque lavorativa, tradendo quindi un’associazione fra uomini e carriera, nel caso delle donne l’intelligenza artificiale non è stata altrettanto rispettosa.

Nella maggior parte dei casi le foto contenenti volti femminili venivano infatti completate con bikini o top corti, e questo nonostante la porzione di immagine fornita agli algoritmi non contenesse nulla che facesse pensare a una spiaggia o a una situazione “informale”. Neanche un ambiente serio e professionale impediva ai modelli di AI di produrre, per le donne, immagini sessualizzate nel 52,5% dei casi (non solo bikini, ma ad esempio anche seni molto grandi), a fronte di un mero 7,5% quando si trattava di uomini (ad es. con petti senza camicia o parzialmente scoperti).

Anche la foto di Alexandria Ocasio-Cortez è stata spesso completata dall’intelligenza artificiale con immagini di corpi in bikini o in abiti succinti. Fra l’altro, i ricercatori hanno ricevuto critiche su Twitter per aver pubblicato tali immagini, seppur pesantemente pixelate per via della bassa risoluzione con cui sono state condotte queste operazioni. Le proteste hanno convinto gli autori della ricerca a rimuovere del tutto le immagini di AOC in bikini dal PDF (ancora disponibili però nelle prime versioni del documento su arXiv) e a usare per i loro test solo volti di persone generati artificialmente.

C’è da dire tuttavia che senza la finta immagine di Ocasio-Cortez in bikini probabilmente questo paper sui bias non avrebbe avuto la stessa copertura mediatica. Ormai molti di coloro che lavorano nel settore si sono assuefatti all’idea che i dataset che troviamo su Internet portino con sé pregiudizi razziali o di genere. Persone di colore scambiate per gorilla, Obama bianco e AOC in bikini sono solo la punta dell’iceberg di un problema molto più profondo.

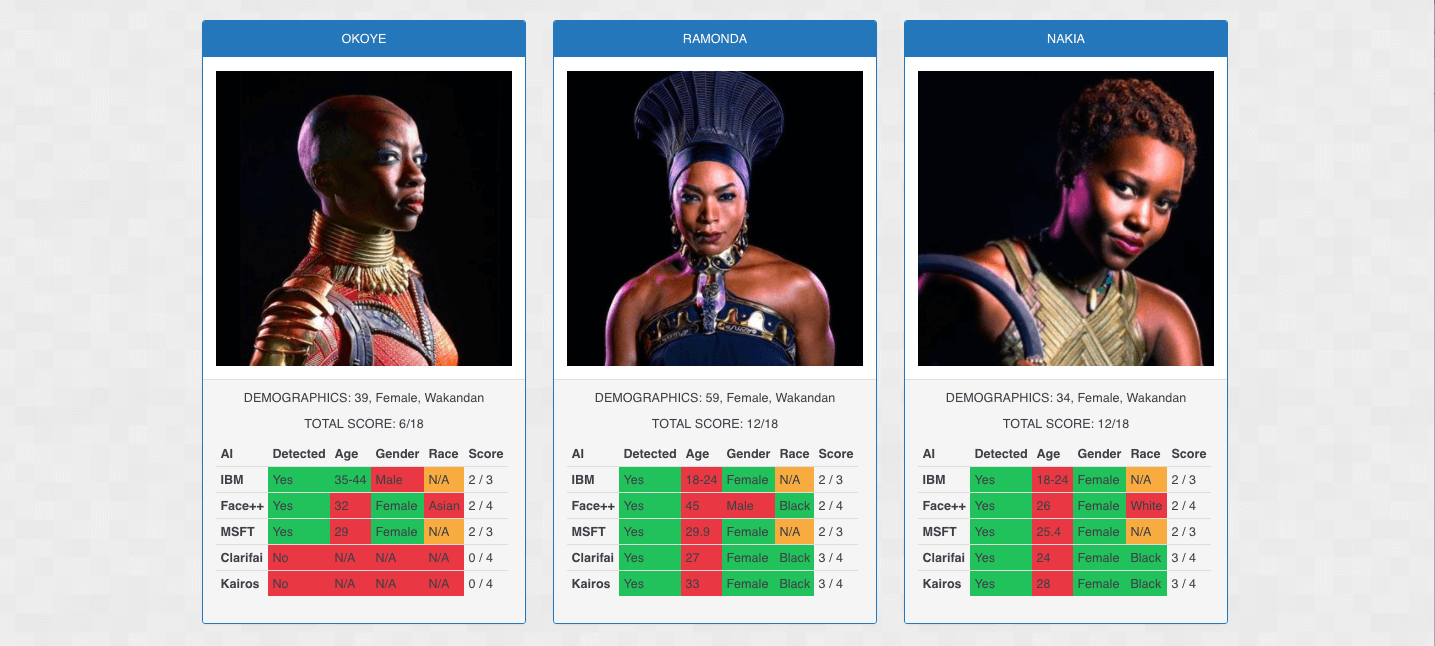

The Black Panther Scorecard, creato nel febbraio 2018, mostra come gli algoritmi di società diverse etichettano l’età, il genere e la razza di alcune attrici e attori.

Ripensare la costruzione dei dataset

La realtà è che noi tutti sappiamo bene che i dataset costruiti da materiale raccolto alla rinfusa su Internet, se da una parte sono utili perché danno ai nostri modelli la possibilità di addestrarsi su un’immensa quantità di esempi (e di confrontarsi con i soliti benchmark), dall’altra inseriscono nel nostro sistema AI una bomba a tempo.

È vero che tutti i dataset creati dagli esseri umani, anche quelli fatti con più cura possibile, si portano appresso qualche bias implicito. Ma a volte questa è una comoda scusa che ci raccontiamo quando andiamo a prendere il solito dataset pubblico, gratuito e gigantesco con cui addestrare il nostro nuovo modello.

Video: “Come combatto i bias negli algoritmi”, Joy Buolamwini, laureata al MIT che lavora con software di analisi facciale e si sta impegnando per ridurre le discriminazioni e i pregiudizi di razza e sesso.

Per questo motivo si dovrebbe ripensare la costruzione dei dataset, iniziando a farla con la cura che necessitano, introducendo una vera e propria pulizia-by-design che consentirà a chi realizza modelli di machine learning di avere meno sorprese possibili, sia sul piano etico sia magari anche sul piano degli attacchi adversarial.

Del resto, anche i decisori politici statunitensi hanno compreso che per aiutare il settore dell’intelligenza artificiale a fare un salto di qualità vi sia bisogno di creare e fornire dataset gratuiti e puliti, o comunque il più puliti possibile. Gli USA infatti, con la pioggia di miliardi che faranno piovere sul settore nei prossimi anni, hanno pensato fra le altre cose anche a finanziare la creazione di dataset di qualità, disponibili gratuitamente per tutti i ricercatori.

La parte in salita sarà convincere chi costruisce modelli a usare solo dataset puliti e costruiti con determinati criteri, scartando quelli che già in passato hanno dimostrato di avere numerosi bias. Non sarà facile, ma sarà necessario per scongiurare che l’intelligenza artificiale diffonda e amplifichi ulteriormente i pregiudizi della nostra società.