La rivoluzione nello sviluppo dei sistemi di intelligenza artificiale è stata alimentata da avanzamenti tecnologici in aree come il machine learning, la computer vision e il processing del linguaggio naturale. Questi sviluppi hanno permesso ai sistemi di intelligenza artificiale di apprendere e migliorare continuamente dall’esperienza, migliorando la loro capacità di comprendere e risolvere problemi complessi in diversi settori. Gli sviluppi nell’intelligenza artificiale hanno portato a importanti innovazioni in diverse industrie, come il trasporto autonomo, la sanità, la finanza e il retail. Ad esempio, i veicoli autonomi utilizzano l’intelligenza artificiale per navigare in modo sicuro e preciso su strade trafficate, mentre i sistemi di assistenza sanitaria utilizzano l’intelligenza artificiale per diagnosticare patologie e prescrivere trattamenti personalizzati ai pazienti. Ma fino a quando sarà possibile lo sviluppo dei sistemi di AI generativa, i LLM?

Lo sviluppo dei sistemi di AI e le questioni etiche

La rivoluzione nello sviluppo dei sistemi di intelligenza artificiale sta anche sollevando importanti questioni etiche e di responsabilità, poiché l’intelligenza artificiale può prendere decisioni che hanno un impatto significativo sulla vita delle persone. Pertanto, è importante che gli sviluppatori di intelligenza artificiale e le industrie che la utilizzano lavorino per garantire la trasparenza, la giustizia e la responsabilità nell’utilizzo di tali sistemi.

Queste ultime fanno parte di alcune delle problematiche legali che coinvolgono i sistemi di intelligenza artificiale e soprattutto che sollevano il quesito riguardante quanto potranno svilupparsi ancora questi sistemi?

LLM e tokenizzazione

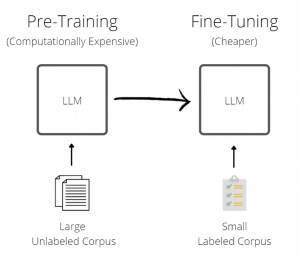

Come sappiamo, l’intelligenza artificiale si basa principalmente su tecniche di machine learning (apprendimento automatico) che consentono ai sistemi di apprendere da dati di training e migliorare le loro prestazioni senza la necessità di essere esplicitamente programmato.

I LLM si basano sull’utilizzo di tecniche di machine learning per lo sviluppo di sistemi di elaborazione del linguaggio naturale. Questo tipo di sistemi può essere utilizzato per una vasta gamma di applicazioni, tra cui il riconoscimento del linguaggio umano, l’analisi dei sentimenti, le risposte alle domande, la traduzione automatica e molto altro ancora.

Per lo sviluppo di tali sistemi, è importante avere un grande set di dati di training di alta qualità da utilizzare durante l’addestramento del modello. Inoltre, questi sistemi richiedono spesso l’utilizzo di tecniche di elaborazione del linguaggio naturale come la tokenizzazione, l’analisi grammaticale e la disambiguazione delle parole.

Nello specifico, la tokenizzazione è il processo di conversione di un elemento di dati, come un numero di carta di credito o un nome utente, in una serie di caratteri casuali alfanumerici chiamati token. Il token può essere utilizzato al posto dell’informazione originale per transazioni di sicurezza, come ad esempio accedere a un sito web, senza dover compromettere o divulgarne il contenuto. In questo modo, la tokenizzazione protegge l’identità e i dati personali dell’utente.

Le tecniche di big data

Per ingrandire i sistemi di LLM, è possibile utilizzare tecniche come l’elaborazione di grandi volumi di dati (big data), che consiste nell’analisi di grandi quantità di dati per rilevare modelli e trend significativi.

In generale, lo sviluppo e l’ingrandimento dei sistemi di LLM richiede l’utilizzo di competenze specialistiche in intelligenza artificiale, machine learning e elaborazione del linguaggio naturale.

Le tecniche di big data prevedono:

- Analisi dei dati: un approccio metodologico utilizzato per esaminare, interpretare e comprenderne i dati. Ciò implica l’uso delle tecnologie del software per esaminare i dati in modo da ottenere informazioni pertinenti.

- Data mining: il processo di esplorazione e analisi dei dati allo scopo di rilevare schemi e correlazioni che possono aiutare a ottenere una conoscenza approfondita dai dati.

- Machine learning: questa tecnica implica l’uso di algoritmi che possono migliorare il loro comportamento in modo autonomo quando vengono alimentati con più dati.

- Analisi previsionale: un processo che utilizza le informazioni storiche per identificare trend e modelli che possono aiutare a fare previsioni.

- Elaborazione del linguaggio naturale: questa tecnologia utilizza tecniche di intelligenza artificiale per capire il linguaggio parlato o scritto dagli utenti.

- Visualizzazione dei dati: l’uso di grafici e diagrammi per rappresentare i dati in modo da facilitare la comprensione.

- Cloud computing: offre servizi di archiviazione e elaborazione dei dati basati su una rete remota di server che possono essere utilizzati dalle aziende senza dover acquistare o gestire un’infrastruttura IT costosa.

I costi per lo sviluppo dei sistemi LLM

Ingrandire i sistemi LLM comporta dover affrontare costi molto elevati, vediamo quali:

- sviluppo: sviluppare nuovi algoritmi e modelli di AI richiede tempo e risorse umane, che possono costare molto ai team di ricerca e sviluppo.

- acquisizione di dati: i sistemi di AI richiedono grandi quantità di dati di training per funzionare correttamente. L’acquisizione, la gestione e l’elaborazione dei dati possono essere costosi.

- elaborazione dei dati: una volta che i dati di input sono stati acquisiti, devono essere elaborati in modo da essere adatti all’addestramento del modello. Ciò richiede spesso una notevole capacità di calcolo e quindi può essere costoso.

- infrastruttura: l’elaborazione dei dati richiede un’infrastruttura informatica adeguata. Ciò può richiedere l’acquisto di server dedicati o l’utilizzo di servizi cloud, che possono costare molto.

- manutenzione: i modelli di AI richiedono una costante manutenzione e aggiornamento per rimanere al passo con i cambiamenti nel mondo reale. Ciò richiede tempo e risorse, che possono essere costosi.

- sicurezza: l’AI può essere vulnerabile agli attacchi informatici e alle violazioni della sicurezza. I costi associati alla protezione dei dati e alla sicurezza delle applicazioni di intelligenza artificiale possono essere elevati.

Complessivamente, l’ingrandimento dei sistemi di AI richiede una significativa quantità di risorse e investimenti, che possono essere costosi per le aziende e le organizzazioni che cercano di sviluppare tali tecnologie.

Come ovviare ai limiti di memoria: gli approcci alternativi utilizzati

Un altro tema molto importante relativo allo sviluppo di sistemi di LLM è quello dei limiti di memoria e degli approcci alternativi che vengono utilizzati.

I limiti di memoria dei sistemi LLM di AI dipendono dal tipo di architettura utilizzata, dalla dimensione del set di dati di input e dal tipo di algoritmo di machine learning impiegato. In generale, i sistemi LLM di AI richiedono molta memoria per elaborare grandi quantità di dati e fornire risultati precisi. Inoltre, i limiti di memoria possono variare da un dispositivo all’altro, sulla base delle specifiche tecniche e delle prestazioni hardware, ma questi strumenti non sono illimitati.

Ci sono diversi approcci che possono essere adottati per superare i limiti di memoria dei sistemi di LLM:

- Compressione dei dati: non si memorizzano tutti i dati, ma questi vengono compressi e memorizzati in un formato più compatto. Questo diminuirà la quantità di spazio di storage necessario, consentendo di memorizzare più dati nella stessa area di memoria.

- Utilizzo di tecniche di memoria virtuale: si utilizza uno storage di massa per conservare i dati, come un disco rigido, e vengono memorizzati solo quando necessario. Questo consente di utilizzare una quantità limitata di memoria fisica per rispondere a una grande quantità di richieste di dati.

- Archiviazione esterna: se la quantità di dati da memorizzare supera le capacità di memoria del sistema di LLM, i dati possono essere archiviati su un dispositivo di archiviazione esterno, come un disco rigido o un’unità flash USB. In questo modo si può accedere ai dati conservati solo quando sono necessari.

- Utilizzo di tecnologie di cloud storage: i dati possono essere memorizzati su server remoti e acceduti tramite una connessione internet. Questo consentirà di superare i limiti di memoria dei sistemi di LLM e di accedere ai dati in modo efficiente da qualsiasi luogo del mondo.

- Utilizzo di tecnologie di distribuzione dei dati: usare diversi dispositivi di memoria invece di conservare tutti i dati su un singolo dispositivo di memoria. Questo consentirà di superare i limiti di memoria dei sistemi di LLM e di aumentare la disponibilità e la ridondanza dei dati.

Sviluppo dei LLM: cosa ne pensano gli esperti

Sui limiti all’espansione dei LLM si sono espressi diversi esperti. Joshua Bengio, direttore scientifico del Mila, un importante istituto di ricerca sull’intelligenza artificiale del Quebec, sostiene che ci siano buone ragioni per credere che questa crescita dei sistemi LLM non potrà protrarsi all’infinito, poiché i costi per l’addestramento diventeranno spropositati.

Sam Altman, capo di OpenAI, sostiene che si sia arrivati ormai al limite della crescita di questi sistemi e che verranno migliorati in altri modi.

Un documento pubblicato nell’ottobre 2022 conclude che: “lo stock di dati linguistici di alta qualità sarà presto esaurito, probabilmente prima del 2026”.

Infine, Yann LeCun, importante figura dell’AI mondiale, in un dibattito alla New York University ha sostenuto che i LLM sono “condannati” e che gli sforzi per controllare la produzione falliranno.

Conclusioni

La rivoluzione nello sviluppo dei sistemi di intelligenza artificiale sta anche sollevando importanti questioni etiche e di responsabilità, poiché l’intelligenza artificiale può prendere decisioni che hanno un impatto significativo sulla vita delle persone. Pertanto, è importante che gli sviluppatori di intelligenza artificiale e le industrie che la utilizzano lavorino per garantire la trasparenza, la giustizia e la responsabilità nell’utilizzo di tali sistemi.

Queste ultime fanno parte di alcune delle problematiche legali che coinvolgono i sistemi di intelligenza artificiale e soprattutto che sollevano il quesito riguardante quanto potranno svilupparsi ancora questi sistemi?