Secondo Sam Altman, CEO di OpenAI, l’era dei modelli di intelligenza artificiale sempre più grandi sta volgendo al termine, poiché i vincoli di costo e i rendimenti decrescenti frenano l’incessante scalabilità che ha caratterizzato i progressi del settore.

Parlando a un evento del MIT a metà aprile, Altman ha affermato che ulteriori progressi non verranno da “modelli grandissimi”. E in un recente articolo di Wired ha dichiarato: “Penso che siamo alla fine dell’era in cui ci saranno questi modelli giganteschi. Li miglioreremo in altri modi”.

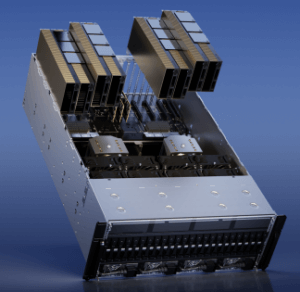

Spesa esorbitante e insostenibile per le GPU

Anche se Altman non l’ha citato direttamente, uno dei principali fattori che hanno determinato il passaggio dal concetto di “scalare è tutto ciò che serve” è la spesa esorbitante e insostenibile per l’addestramento e l’esecuzione dei processi grafici necessari per i modelli linguistici di grandi dimensioni (LLM). ChatGPT, ad esempio, ha richiesto più di 10mila GPU per l’addestramento e richiede ancora più risorse per il funzionamento continuo.

Nvidia domina il mercato delle GPU con una quota di mercato dell’88% circa. Le ultime GPU H100 di Nvidia, progettate specificamente per l’intelligenza artificiale e l’elaborazione ad alte prestazioni (HPC), possono costare fino a 30.603 dollari per unità – e anche di più, su eBay.

L’addestramento di un LLM all’avanguardia può richiedere centinaia di milioni di dollari di calcolo, ha dichiarato Ronen Dar, cofondatore e Chief technology officer di Run AI, una piattaforma di orchestrazione del calcolo che accelera le iniziative di data science mettendo in comune le GPU.

Poiché i costi sono saliti alle stelle mentre i benefici si sono livellati, l’economia di scala si è opposta a modelli sempre più grandi. I progressi verranno invece dal miglioramento delle architetture dei modelli, dall’aumento dell’efficienza dei dati e dall’avanzamento delle tecniche algoritmiche oltre la scala del copia-incolla. L’era dei dati, dei calcoli e delle dimensioni dei modelli illimitati, che ha trasformato l’AI nell’ultimo decennio, sta volgendo al termine.

Altman: le dimensioni, falsa misura della qualità dei modelli

Non tutti concordano sul fatto che la crisi delle GPU sia alla base dei commenti di Altman. “Penso che sia in realtà radicato in un’osservazione tecnica dell’ultimo anno, secondo la quale potremmo aver reso i modelli più grandi del necessario”, ha detto Aidan Gomez, cofondatore e CEO di Cohere, che compete con OpenAI nello spazio LLM.

In un articolo di TechCrunch sull’evento del MIT si legge che Altman considera le dimensioni come una “falsa misura della qualità del modello”.

“Penso che ci si sia concentrati troppo sul numero di parametri, forse il numero di parametri tenderà sicuramente ad aumentare. Ma questo mi ricorda molto la corsa ai Gigahertz nei chip negli anni ’90 e 2000, dove tutti cercavano di puntare a un numero elevato”, ha detto Altman.

Tuttavia, il fatto che Elon Musk abbia appena acquistato 10mila GPU per data center significa che, per ora, l’accesso alle GPU è tutto. E dato che l’accesso è così costoso e difficile da ottenere, si tratta certamente di una crisi per tutte le aziende focalizzate sull’AI, tranne che per quelle più ricche di risorse. E anche le tasche di OpenAI non sono così profonde. Anche loro, a quanto pare, potrebbero essere costretti a guardare in una nuova direzione.