Nell’ambito dell’intelligenza artificiale, il GPT-3 è, a oggi, il modello di linguaggio più potente di sempre. E la sua innovazione è continua e costante. All’inizio del mese di gennaio 2021, OpenAI ha rilasciato due nuovi modelli che presentano un ulteriore passo in avanti delle capacità e dell’estensione della loro creazione.

È bastato chiedere al sistema di mostrare “una poltrona a forma di avocado” per dimostrare la capacità della macchina di poter trarre “ispirazione” da una richiesta rispettando due oggetti totalmente non correlati tra di loro: una poltrona e un frutto.

I due nuovi modelli di OpenAI

L’idea di fondo è il poter permettere, grazie a due nuovi modelli che combinano NLP (Natural Language Processing), un sottocampo di studi inerenti linguistica, informatica e intelligenza artificiale che si occupa delle interazioni tra computer e linguaggio umano, in particolare di come programmare i computer per elaborare e analizzare grandi quantità di dati in linguaggio naturale, e il riconoscimento delle immagini per poter ottenere una migliore comprensione di concetti che, per noi umani, sono immediati o – nel modo in cui direbbe qualcuno – quotidiani come lo sono i due concetti espressi nella domanda iniziale: l’idea di una poltrona e l’idea di un avocado.

DALL-E e CLIP, questi sono i nomi dei modelli, riescono a combinare insieme linguaggio e immagini in un modo che renderà le intelligenze artificiali in grado di comprendere sempre meglio sia le parole sia ciò a cui si riferiscono.

L’apprendimento senza supervisione, auto-supervisionato o l’apprendimento senza dati che siano stati precedentemente etichettati dall’uomo, è una sfida di vecchia data del mondo dell’apprendimento automatico. Solo in tempi recenti questi temi hanno riscontrato successo, perché diversi modelli hanno raggiunto ottimi risultati su una vasta gamma di attività linguistiche.

Tuttavia, il punto è riuscire a lavorare con la stessa qualità anche nella classificazione delle immagini. L’obiettivo dichiarato, per questi due modelli, è proprio quello di comprendere e colmare questa lacuna.

Di fatto, con gli ultimi studi rilasciati, OpenAI ha dimostrato due cose:

- un singolo modello di deep-learning potrebbe essere addestrato per utilizzare il linguaggio naturale in una estesa varietà di modi semplicemente fornendo grandi quantità di testo;

- scambiando il testo con le immagini (quindi con pixel) lo stesso approccio potrebbe essere utilizzato per addestrare un’AI capace di completare immagini che vengono fornite solo come dei semilavorati.

In sostanza: GPT-3 riesce a imitare il modo in cui le persone usano le parole e a prevedere ciò che vediamo.

GPT-3: una migliore comprensione di testo e immagini

Le persone vivono in un mondo che vedono e interpretano anche con gli occhi e, per questo, “verranno resi disponibili modelli che saranno in grado di comprendere sempre meglio sia il testo che le immagini. L’intelligenza artificiale sarà in grado di capire sempre meglio la lingua parlata perché potrà vedere cosa significano parole e frasi”, dice Ilya Sutskever, capo scienziato di OpenAI, che ha dato importanti contributi al campo del deep learning, oltre a essere il co-inventore (con Alexander Krizhevsky e Geoffrey Hinton) di AlexNet, una rete neurale convoluzionale – un tipo di rete neurale artificiale in cui lo schema di connettività che esiste tra i neuroni è ispirato dall’organizzazione della corteccia visiva animale.

Come funzionano DALL-E e CLIP

Con i loro studi, i ricercatori di OpenAI stanno investendo i loro sforzi per dare ai modelli linguistici una migliore comprensione dei concetti quotidiani che gli esseri umani usano per dare un senso alle cose.

I due nuovi modelli, DALL-E e CLIP, affrontano questo problema da prospettive differenti.

Con una prima analisi, CLIP (Contrastive Language-Image Pre-training) può sembrare un altro sistema di riconoscimento delle immagini. La vera differenza sta nel fatto che il sistema riesce a riconoscere le immagini non da esempi etichettati in set di dati preparati e resi disponibili (così come fanno la maggior parte dei modelli esistenti), ma da immagini e didascalie prese liberamente e direttamente dalla rete Internet.

Il sistema è in grado di apprendere cosa c’è in un’immagine da una descrizione piuttosto che da un’etichetta composta da una sola parola come potrebbe essere “cane”, “sedia” o “banana”.

Si tratta di una rete neurale che apprende in modo efficiente concetti visivi dalla supervisione del linguaggio naturale. CLIP può essere applicato a qualsiasi benchmark di classificazione visiva fornendo semplicemente i nomi delle categorie visive da riconoscere, in modo simile alle funzionalità “zero-shot” (il modello non viene addestrato su nessun dato specifico e viene valutato, sui dati riconosciuti, come test finale) di GPT-2 e GPT-3.

L’addestramento del modello CLIP viene effettuato facendogli prevedere quale didascalia dovrà essere applicata, partendo da una selezione casuale di 32.768 etichette, per una particolare immagine.

La maggior parte dei sistemi di riconoscimento delle immagini è addestrata per identificare determinati tipi di oggetti, come possono essere i volti (ad esempio per poter lavorare con i video di sorveglianza) oppure gli edifici (per casi d’uso legati alle immagini satellitari).

Invece, come GPT-3, CLIP può permettersi di non avere formazione, di non avere necessità di training.

Tra l’altro, proprio per questa ragione, rispetto ad altri modelli di riconoscimento delle immagini, questo permette di essere meno soggetto a “bias”, potremmo dire “preconcetti”, che potrebbero essere introdotti – soprattutto in maniera involontaria – da esempi contraddittori o da set di dati utilizzati per l’addestramento che hanno al loro interno pregiudizi (che potrebbero essere personali, ambientali o di altro tipo).

Questa potrebbe essere una preoccupazione in meno: per il fatto di non dover necessitare di una fase di addestramento, questi modelli non possono apprendere (eventuali) pregiudizi umani.

Il secondo modello, DALL·E, non riconosce le immagini: le disegna.

Si tratta di una rete neurale che crea immagini da sottotitoli di testo per un’ampia gamma di concetti esprimibili in linguaggio naturale.

Per il suo nome, il team ha deciso di utilizzare un portmanteau (in francese “mot-valise”: si tratta di una parola costruita tramite la combinazione di una o più parti di altre parole come potrebbe essere “smog” derivante da smoke + fog o “motel” da motor + hotel) dell’artista Salvador Dalì e WALL-E della Pixar.

I risultati raggiunti da GPT-3

Una versione ridotta di GPT-3, con “solo” 12 miliardi di parametri, addestrata per generare immagini da descrizioni di testo: ha una serie diversificata di funzionalità, inclusa la creazione di versioni antropomorfizzate di animali e oggetti, la combinazione di concetti non correlati in modi plausibili, il rendering del testo e l’applicazione di trasformazioni alle immagini esistenti. Ricevuta una breve descrizione espressa in linguaggio naturale, come potrebbe essere “un dipinto di un coniglio seduto in un campo all’alba” o “una vista in sezione trasversale di una noce”, DALL·E è in grado di generare molte immagini corrispondenti alla richiesta ricevuta.

Onestamente, i risultati sono sorprendenti (paper), anche se – a volte – ancora contrastanti.

La richiesta di vedere “una finestra di vetro colorato con l’immagine di una fragola blu” produce molti risultati corretti, ma anche alcuni che hanno finestre blu e fragole rosse (che è il concetto “naturale” che noi umani diamo a una fragola). Altri, a dire il vero, non contengono nemmeno qualcosa che possa somigliare a una finestra oppure a una fragola.

I risultati, presentati dalla squadra di OpenAI in un post sul loro blog, sono stati classificati da CLIP (senza intervento umano) che è stato in grado, per ogni didascalia, di selezionare 32 immagini, prodotte da DALL·E, che ritiene corrispondano meglio alla descrizione richiesta.

Non siamo ancora alla perfezione ma, certamente, come afferma Mark Riedl – che lavora su NLP e creatività computazionale presso il Georgia Institute of Technology di Atlanta – “questa è una serie impressionante di esempi”.

Così, per poter testare la capacità di DALL·E, i ricercatori gli hanno richiesto oggetti che si riteneva fosse stato impossibile essere già stati visti o trovati sulla rete internet: “una poltrona di avocado” o anche “un ravanello in tutù che cammina con un cane.”

In entrambi i casi, l’intelligenza artificiale ha generato immagini che combinavano questi concetti in modi assolutamente plausibili. Nelle immagini generate, in particolare, le poltrone sembrano assolutamente essere tutte delle sedie e degli avocado.

La sorpresa, ma anche lo stupore, deriva dal fatto che il modello è perfettamente in grado di prendere due concetti non correlati tra loro e metterli insieme in un modo che si traduca in qualcosa di plausibile, di funzionale.

Probabilmente, per questo esempio, il risultato potrebbe dipendere dal fatto che un avocado tagliato a metà potrebbe, con un minimo sforzo di fantasia, assomigliare a una poltrona con lo schienale alto, con la parte dove si trovava il nocciolo come parte per il cuscino.

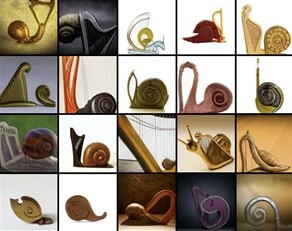

Allo stesso modo è utile dire che, altri esempi come potrebbero essere le immagini elaborate per la richiesta di “una lumaca fatta come un’arpa“, sono certamente meno interessanti, meno buoni come risultati, con immagini che combinano lumache e arpe in modi strani.

GPT-3, quali sono i suoi limiti

DALL·E è il tipo di modello che proprio lo scienziato Riedl voleva sottoporre al test “Lovelace 2.0”, un esperimento mentale ideato nel 2014 con lo scopo di sostituire il test di Turing come punto di riferimento per misurare l’intelligenza artificiale.

Partendo dal concetto che la capacità di fondere concetti in modi creativi è, senza dubbio, una dimostrazione di intelligenza, il ricercatore fa presente che chiedere a un computer di disegnare una foto di un uomo che tiene in mano un pinguino è sicuramente un test di intelligenza nettamente migliore del chiedere a una chatbot di ingannare un essere umano in una conversazione: “Il vero test è vedere fino a che punto l’AI può essere spinta al di fuori della sua zona di comfort”.

Per Ani Kembhavi, dell’Allen Institute for Artificial Intelligence (AI2), “La capacità del modello di generare immagini da un testo, anche piuttosto stravagante, mi sembra molto interessante”.

I risultati sembrano obbedire alla semantica desiderata, il che è – senza ombra di dubbio – piuttosto interessante e impressionante. Al momento i modelli conosciuti fino a oggi, in grado di generare immagini da un testo, non hanno mostrato il livello raggiunto da OpenAI in due ambiti:

- esecuzione, riuscendo a disegnare più oggetti

- capacità di ragionamento spaziale

Ad ogni modo, DALL·E mostra alcune limitazioni nel momento in cui vengono inclusi, nella richiesta, troppi oggetti. Tra l’altro, a volte, riformulare una richiesta con parole che significano la stessa cosa, a volte, produce risultati diversi.

Al momento si sta cercando di capire se il modello, a volte, si limita a imitare immagini che ha già incontrato online, piuttosto che generarne di nuove.

Tuttavia, la maggior parte dei ricercatori di intelligenza artificiale è concorde nel fatto che il linguaggio di base nella comprensione visiva è certamente un buon modo per rendere le AI più intelligenti.

Sebbene il deep learning (l’apprendimento profondo) abbia rivoluzionato la visione artificiale, gli approcci attuali presentano diversi problemi importanti, tra cui:

- i set di dati utilizzati per le fasi di training dei modelli sono laboriosi e costosi da creare

- si insegna solo un insieme ristretto di concetti visivi

- i modelli realizzati possono avere un’ottima qualità di risultato in un ambito e uno soltanto

- richiedono uno sforzo significativo per adattarsi a un nuovo ambito

I modelli presentati da OpenAI mirano anche ad affrontare e risolvere questi problemi.

In un benchmark di performance, i ricercatori hanno dimostrato che, senza utilizzare nessuno degli originali 1,28 milioni di esempi etichettati di ImageNet, il sistema è in grado di avere le stesse prestazioni del ResNet507 originale, uno “zero-shot” impressionante. Per Sutskever “il futuro consisterà in sistemi come questo”. Concetto sul quale sono assolutamente d’accordo.