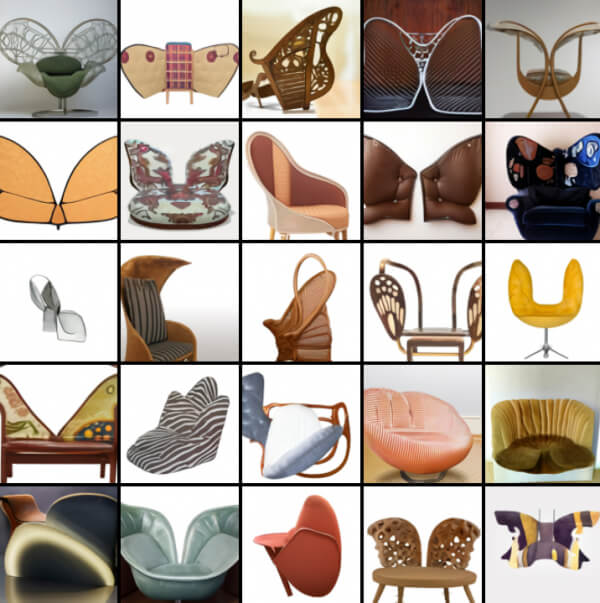

Di recente OpenAI ha rilasciato un modello di intelligenza artificiale chiamato DALL-E che produce immagini da descrizioni testuali esprimibili in linguaggio naturale. Il sistema richiede un input di testo o testo+immagine e rilascia un output in immagini. Questo significa, per fare un esempio, che se l’utente scrive “una sedia con la forma di farfalla” il modello restituisce diverse versioni di una sedia a forma di farfalla, immagini realizzate in quel momento dal sistema e non trovate su Internet come farebbe qualsiasi motore di ricerca.

Ecco alcuni esempi dell’output appena descritto:

Come funziona DALL-E

DALL-E (il nome è un omaggio sia a Salvador Dalì sia al robottino WALL-E della Pixar) è una variante del famoso modello di elaborazione del linguaggio naturale GPT-3. Ma mentre GPT-3 crea testi, anche molto convincenti e spesso indistinguibili da quelli creati da una mente umana, DALL-E, con i suoi 12 miliardi di parametri, è specializzato nella realizzazione di interpretazioni grafiche.

Il dataset di DALL-E è composto da coppie testo-immagine che consente al modello di avere una rappresentazione grafica dei singoli termini. Ma a parte questo training iniziale, che è un po’ come mostrare a un bambino un’immagine e insegnargli come si scrive, la successiva combinazione di concetti (a volte creando vere e proprie chimere), l’antropomorfizzazione di oggetti o animali, la modifica di immagini esistenti, la creazione di emoji o il rendering dei testi è tutta farina del sacco di DALL-E, al quale è possibile chiedere astrazioni come un ibrido fra un riccio e una carota e ottenere le immagini che seguono:

Il sistema può ricevere in input anche istruzioni abbastanza dettagliate, come ad esempio “un piccolo pinguino che indossa un cappello blu, guanti rossi, camicia verde e pantaloni gialli”, ma quando deve iniziare a creare associazioni o quando le parti da comporre sono tante DALL-E ha la tendenza a “dimenticarsi” qualcosa per strada.

Nell’esempio del pinguino appena descritto si può vedere come di solito uno o due degli indumenti siano colorati correttamente, ma è difficile che il sistema riesca a disegnarli tutti e quattro con i colori corretti.

DALL-E, quali errori può commettere

Un’altra possibilità è mandare in input sia una stringa di testo sia un’immagine. La cosa interessante è che in alcuni casi i ricercatori hanno notato delle qualità emergenti nel modello, come la capacità nota come zero-shot reasoning (in questo caso sarebbe da chiamare zero-shot visual reasoning), che consente al modello di realizzare diverse attività semplicemente con una descrizione e un aiuto visivo, senza che la classificazione fosse stata precedentemente programmata.

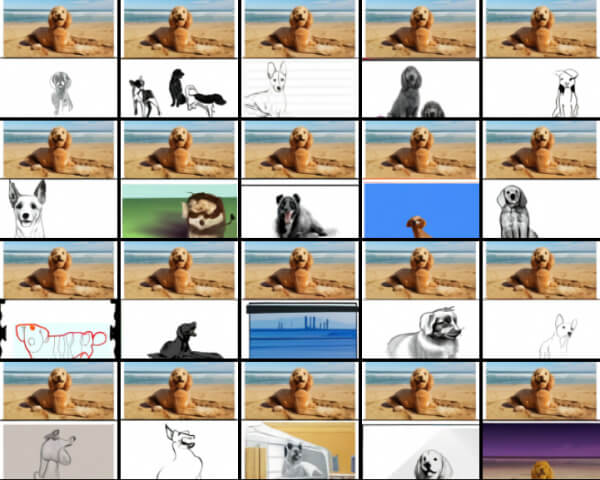

Ne è un esempio la seguente sfilza di immagini, dove è stato chiesto al modello “fai un disegno di questo cane”, aggiungendo la foto di un cane sulla spiaggia:

Oppure quest’altro esempio di una teiera in input assieme all’istruzione “la stessa identica teiera con ‘gpt’ scritto in basso”:

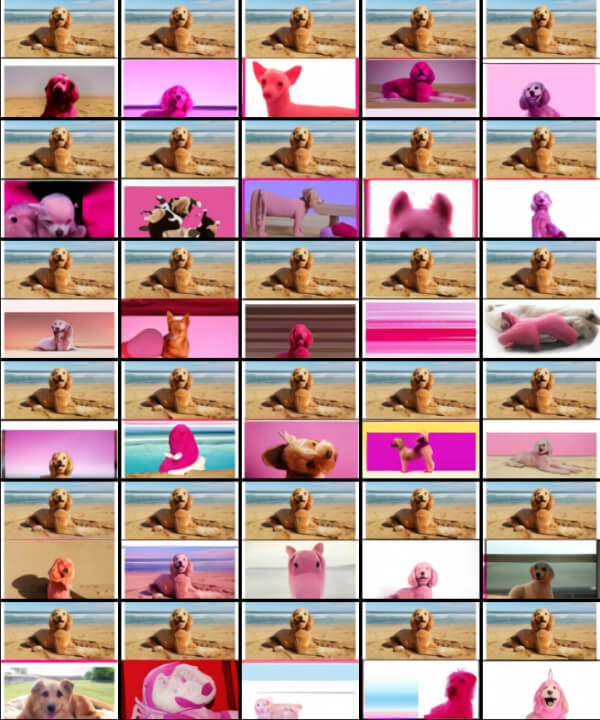

Un altro caso dove il modello non sempre riesce nell’intento è la modifica delle immagini, come mostra l’esempio seguente dove è stato chiesto a DALL-E di colorare il cane in rosa. Per farlo deve individuare correttamente i contorni, separandolo dallo sfondo e applicare le modifiche indicate. Molti dei risultati che seguono sono tutt’altro che “intelligenti”:

Come si vede dagli esempi riportati fin qui, DALL-E spesso tende a creare versioni proprie dell’immagine, anche quando era stato istruito a replicare l’immagine di input tale e quale. Si tratta del rovescio della medaglia di un sistema addestrato a “riempire gli spazi” non descritti dall’input.

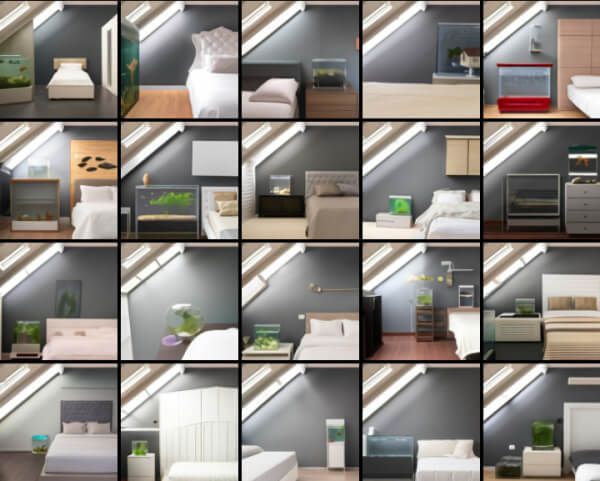

Come dimostra quest’altro esempio, dove viene chiesto al sistema di disegnare “una camera da letto soppalcata con un letto bianco accanto al comodino. accanto al letto c’è una vasca per il pesce” e aggiungendo come aiuto questo minimo prompt visuale:

Il risultato sarà tutta una serie di versioni della camera:

Come si può vedere il modello ha realizzato diversi tipi di acquario, di letto, di comodino, spesso variando le posizioni e aggiungendo altri mobili come un armadio, mensole, soprammobili.

DALL-E, le potenzialità per il business

Sono queste caratteristiche emergenti che fanno di DALL-E un sistema potenzialmente molto interessante per quanto riguarda i possibili usi, rendendolo adatto a studi creativi, interior designer e – perché no – al settore della moda; in genere a tutte quelle attività dove c’è bisogno di fantasia visiva. Un sistema del genere aiuterebbe i creativi a ottenere nuove ispirazioni o a provare in pochi secondi concetti che sarebbero stati lunghi da impostare graficamente uno per uno.

Basta vedere quello che ha realizzato in pochi attimi quando gli ho chiesto di creare alcune lampade a forma di orchidea:

I ricercatori di OpenAI non hanno creato DALL-E con un obiettivo specifico in mente. Avevano a disposizione un modello molto performante come GPT-3 e lo hanno modificato per dar vita a questo nuovo sistema, che porta la creatività del modello precedente verso il mondo delle immagini.

DALL-E 2, quali differenze dal primo modello

Nel marzo 2022 OpenAI ha rilasciato la versione aggiornata, chiamata semplicemente DALL-E 2, in grado di realizzare creazioni di qualità ancora superiore e di manipolare le immagini da un sistema AI. Le novità sono: la capacità di eseguire modifiche selettive, la possibilità di generare immagini simili ma diverse dall’originale e la tecnologia con cui opera la rete neurale generativa.

Conclusioni

E proprio come GPT-3 sarà il mercato a inventare nuovi servizi che sfrutteranno le capacità del modello, facendo tuttavia emergere una domanda che per ora non ha una risposta chiara: di chi sarà il copyright di un’immagine generata da DALL-E su input dell’utente? OpenAI a questo riguardo non si è pronunciata. In passato, con il suo modello musicale MuseNet, l’azienda aveva dichiarato di non detenere il copyright della musica in output, chiedendo tuttavia allo stesso tempo agli utenti di non usarla per scopi commerciali. Un atteggiamento simile è stato adottato anche per il prodotto Jukebox.

DALL-E però apre tutta una serie di scenari sul diritto d’autore che difficilmente si riusciranno a risolvere con una nota a piè di pagina.

Video: DALL-E, un GPT-3 per le immagini? – di Sebastian Schuchmann

Data di prima pubblicazione: 21 gennaio 2021