Probabilmente, per chi si occupa, si interessa o segue le evoluzioni nell’ambito dell’intelligenza artificiale, la sigla “GPT-3” non è nuova. Per chi non l’avesse mai sentita, per provare a darne una spiegazione rapida, GPT-3 è il modello di linguaggio più potente di sempre. GPT-3 è anche uno dei “linguaggi visivi“, come spieghiamo più avanti.

In maniera semplificata, potremmo dire che è un sistema di completamento automatico (GPT = generative pre-trained transformer), un po’ come fanno i motori di ricerca di internet quando suggeriscono come completare i termini che stiamo scrivendo, però di testi complessi.

Cosa può fare GPT-3, verso i linguaggi visivi

Questo generatore di linguaggio è in grado di scrivere articoli e saggi in totale autonomia, ad esempio, come ha fatto il giornale “The Guardian”, dando semplici istruzioni come queste: “Scrivi un breve editoriale di circa 500 parole. Mantieni il linguaggio semplice e conciso. Concentrati sul motivo per cui gli esseri umani non hanno nulla da temere dall’AI”.

Il suo predecessore, GPT-2, rilasciato lo scorso anno, era già in grado di scrivere testi molto ben realizzati, in una gamma di stili differenti a seconda della frase che veniva data come input del documento stesso.

GPT-3, però, riesce a fare un grande balzo in avanti: il modello ha oggi qualcosa come 175 miliardi di parametri (ovverosia, i valori che la rete neurale utilizzata nel modello cerca di ottimizzare durante il suo addestramento), rispetto al numero – che già sembrava enorme – di 1,5 miliardi di GPT-2.

Questo lavoro del “San Francisco-based AI lab” di OpenAI, azienda americana di ricerca e sviluppo che ha come missione il garantire che l’intelligenza artificiale vada a vantaggio di tutta l’umanità, riesce a essere utilizzato come:

- motore di ricerca basato su domande

- chatbot che ti permette di parlare con personaggi storici

- meccanismo per rispondere a domande mediche

- scrittore di tablature per chitarra

- scrittore di narrativa creativa

- completamento automatico anche di immagini, non solo di testo

Per molti versi, questo sistema è visto sia come una meraviglia, sia ancora come un miraggio.

Nel momento in cui gli chiediamo il colore di una pecora potremmo ottenere sia bianco che nero, per il fatto di conoscere il modo di dire “la pecora nera”. Di fatto, questo, è il problema che si ha spesso con modelli linguistici: poiché si basano esclusivamente sul testo, mancano di buon senso legato al contesto.

GPT-3 e la capacità di “vedere” la lingua

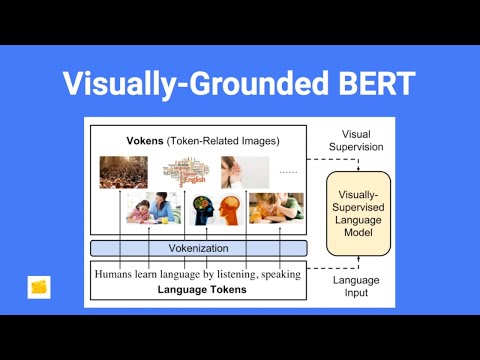

Su questo tema, i ricercatori dell’Università del North Carolina sono riusciti a progettare una nuova tecnica per cambiare questa situazione: chiamata “vokenization“, offre a modelli linguistici come GPT-3 la capacità di “vedere” e, quindi, di comprendere e apprendere meglio.

Certamente non è questa la prima volta che i ricercatori cercano di combinare modelli linguistici con la visione artificiale per poter sfruttare e combinare i punti di forza dei due ambiti di studio. I modelli linguistici come GPT-3 vengono addestrati attraverso un apprendimento non supervisionato, che non richiede un intervento umano per procedere con etichettature manuali dei dati.

Per contro, i modelli di analisi sulla visione artificiale, come i sistemi di riconoscimento degli oggetti, imparano e migliorano la loro comprensione tramite astrazioni del mondo fornite dal testo. Combinare entrambi i tipi di intelligenza artificiale è più facile a dirsi che a farsi: non è così semplice come mettere insieme un modello di linguaggio esistente con un sistema di riconoscimento degli oggetti esistente. Quello che è necessario fare è un nuovo modello, partendo da zero, con un set di dati che include sia testo che immagini, un set di dati in “linguaggio visivo”.

In questo caso, l’approccio più comune per la cura di un simile set, è compilare una raccolta di immagini con didascalie descrittive. Per capirci potremmo avere una descrizione come “un gatto bianco seduto vicino a una valigia aperta riempita con vestiti” rispetto a una classica, semplice, etichetta di “gatto”.

Un set di dati in linguaggio visivo, quindi, può insegnare a un modello di intelligenza artificiale non solo come riconoscere gli oggetti ma anche come si relazionano e agiscono l’uno sugli altri, usando verbi e preposizioni. È evidente che un processo come questo richiede una grande quantità di tempo e, infatti, questo è il motivo per cui i set di dati in linguaggio visivo, oggi, sono così pochi. Per dare un’idea, un popolare set di dati di solo testo come Wikipedia (in inglese) potrebbe contenere quasi 3 miliardi di parole, mentre il set di dati in linguaggio visivo come Microsoft Common Objects in Context (MS COCO) ne contiene solo 7 milioni.

Semplicemente, in questa situazione, non ci sono dati sufficienti per poter addestrare modelli di intelligenza artificiale per qualcosa di utile.

La tecnica del “vokenization“, finalmente, aggira questo problema: utilizzando metodi di apprendimento non supervisionati, è in grado di ridimensionare la piccola quantità di dati in MS COCO alle dimensioni di Wikipedia in inglese.

GPT-3, “vokenization” e linguaggi visivi

Nel linguaggio dell’intelligenza artificiale, le parole utilizzate per addestrare i modelli linguistici sono note come token. Quindi, i ricercatori dell’UNC, hanno deciso di chiamare voken l’immagine associata a ciascun token nel loro modello di linguaggio visivo.

Da questo ragionamento, vokenizer è ciò che viene definito algoritmo, in grado di trovare vokens per ogni token e la vokenization è ciò che viene chiamato come intero processo. Invece di iniziare con un set di dati di immagini e scrivere manualmente frasi da utilizzare come didascalie – un processo molto lento – i ricercatori hanno iniziato con un set di dati linguistici e hanno utilizzato l’apprendimento senza supervisione per abbinare ogni parola con un’immagine pertinente.

Il tema di fondo diventa quindi capire come poter effettivamente trovare un’immagine pertinente per ogni parola. Su questo problema ritorna quindi utile il modello GPT-3, che ha rappresentato un importante passo avanti nell’applicazione dell’apprendimento senza supervisione all’elaborazione del linguaggio naturale (NLP, Natural Language Processing).

Tramite nuovi sviluppi, questi modelli ottengono la capacità di apprendere osservando come le parole vengono utilizzate nel contesto così da creare una rappresentazione matematica di ogni parola, nota come “incorporamento di parole”, basata su quello stesso contesto.

Grazie a questa tecnica, l’incorporamento della parola “gatto” potrebbe mostrare, ad esempio, che è spesso usata con le parole “miao” e “bianco”, ma meno spesso con le parole “corteccia” o “viola”. Questo, di fatto, è il modo in cui i modelli riescono ad approssimare il significato delle parole e come GPT-3 può scrivere frasi simili a quelle umane, riuscendo ad assemblare le parole in frasi e le frasi in paragrafi.

Video: Vokanization – Deep Learning Explainer

La scansione delle immagini per i modelli visivi

Insieme a questa tecnica, ne esiste un’altra parallela che può essere utilizzata anche per le immagini: invece di eseguire la scansione del testo per i modelli di utilizzo delle parole, esegue la scansione delle immagini per i modelli visivi.

Per fare un esempio, questo sistema è in grado di studiare il numero di volte in cui un gatto si trova su un letto rispetto alla frequenza con cui si trova in cima a un albero così da incorporare, al termine “gatto”, queste informazioni contestuali. L’intuizione dei ricercatori è stata il poter utilizzare entrambe le tecniche di incorporamento sul set di dati MS COCO, convertendo le immagini in incorporamenti visivi e le didascalie in incorporamenti di parole.

Tramite un grafico tridimensionale riescono così a vedere le correlazioni tra un termine e un altro: gli incorporamenti visivi che sono strettamente correlati agli incorporamenti di parole appariranno più vicini nel grafico. In altre parole, nel nostro esempio, l’incorporamento del gatto come immagine dovrebbe (in teoria) sovrapporsi all’incorporamento del gatto come testo. A questo punto diventa facile iniziare ad abbinare le immagini con le parole.

Molto interessante notare che, poiché le immagini e le parole vengono abbinate in base ai loro incorporamenti, vengono di conseguenza abbinate anche in base al contesto. Un punto molto utile quando una parola può avere significati completamente diversi: si pensi alla parola “rotta” intesa come percorso di un aereo o come una tazza fatta a pezzi. Oppure “cambio” inteso come tasso di cambio di una moneta o leva del cambio di un’autovettura.

Il token è la parola “cambio” in entrambi i casi ma, nella prima parte, il contesto suggerisce che la parola si riferisce a informazioni monetarie. Nella seconda, il contesto suggerisce che la parola si riferisce a una vettura, quindi il vocalizzo mostrerebbe l’interno di un’automobile.

Definiti i processi e gli algoritmi, i ricercatori hanno utilizzato gli incorporamenti visivi e di parole che hanno creato con MS COCO per addestrare il loro algoritmo di vokenizer. Una volta addestrato, il vokenizer è stato quindi in grado di trovare le voci per i token di Wikipedia in inglese.

Quanto fatto fino a oggi non è perfetto: l’algoritmo ha trovato solo voci vocali per circa il 40% dei token. Ma, ad ogni modo, si tratta pur sempre del 40% di un set di dati che ha quasi 3 miliardi di parole. Grazie a questo lavoro, i ricercatori hanno riqualificato un modello di linguaggio noto come BERT, un modello open source nato prima di GPT-3.

Grazie a questo, hanno poi testato il migliorato BERT su sei diversi test di comprensione linguistica, tra cui SQuAD che chiede ai modelli di rispondere a domande di comprensione della lettura su una serie di articoli (SQuAD, Stanford Question Answering Dataset, è un set di dati utile per la comprensione della lettura, composto da oltre 100mila domande su una serie di articoli di Wikipedia, in cui la risposta a ciascuna domanda è un segmento di testo dal corrispondente passaggio di testo). Il risultato ottenuto è stato molto soddisfacente.

Video: Una lezione su SQuAD – stanfordonline

Sebbene questo lavoro sia ancora agli inizi, è evidente come si sia di fronte a un’importante svolta concettuale per far funzionare l’apprendimento senza supervisione per i modelli di linguaggio visivo anche (e forse soprattutto) per riuscire a collegare i sensi di una macchina a un testo.