La vicenda dei sistemi artificiali progettati per dialogare in lingue storico-naturali, come l’italiano e l’inglese, ha ormai oltre cinquant’anni, da quando, nel 1966, Joseph Weizenbaum sviluppò Eliza. Da allora i chatbot sono stati parte del panorama dell’intelligenza artificiale, per altro con un ruolo relativamente modesto nella percezione sociale e plausibilmente anche di molti addetti ai lavori. Anche per questo, quanto sta succedendo dal 30 novembre 2022, con l’annuncio della possibilità di interagire pubblicamente e gratuitamente con ChatGPT, merita un’attenta considerazione. E il fenomeno è a maggior ragione interessante, ricordando che il nucleo di questo chatbot è stato prima GPT-3 e da metà marzo 2023 GPT-4, un sistema di Natural Language Processing generativo disponibile – via API e playground – dal 2020. Se poi si aggiunge che il knowledge cutoff di ChatGPT è al settembre 2021, e quindi che il sistema non è in grado di fornire informazione su eventi recenti, ci si ritrova davvero a chiedersi quali siano le cause dell’hype che si è generato, e come ha senso affrontare questa situazione.

Per la prima volta, un chatbot in grado di dialogare usando la nostra lingua

Al proposito proponiamo quella che ci sembra più una constatazione che un’ipotesi: per la prima volta nella storia, è ampiamente diffusa nella società umana un’entità non-umana che mostra di essere in grado di dialogare con noi nelle nostre lingue, e questo con proprietà lessicale e semantica, abilità argomentativa e accesso a una enorme quantità di informazione. Insomma, sappiamo quanto sia socialmente rilevante la capacità di una conversazione contestuale, specifica, colta, e, per la prima volta, abbiamo la prova di non essere gli unici ad avere questa capacità.

La questione se la “entità non-umana” pensa, capisce, ragiona, … davvero, o solo simula di farlo, non è rilevante: l’ipotesi prescinde da questo, e ha a che vedere solo con il comportamento dell’entità: è capace di dialogare.

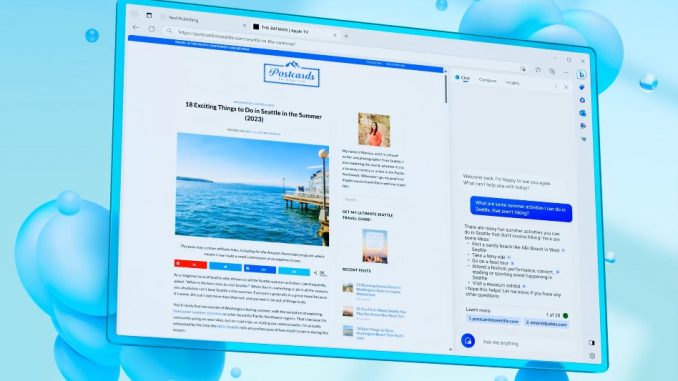

I casi d’uso si sono dimostrati limitati in pratica solo dalla ancora scarsa esperienza che finora abbiamo potuto sviluppare (nel web cominciano a essere proposti i primi cheat sheet, come questo, e le prime applicazioni che incorporano funzionalità di chatbot via API).

Abbiamo dialogato con ChatGPT, magari avendogli specificato di mettersi nei panni di un certo personaggio (Giulio Cesare o il cliente difficile che dovremo incontrare domani, in questo caso per prepararci alla riunione con una simulazione…), gli abbiamo chiesto di scriverci le bozze di testi vari (email, presentazioni commerciali, comunicati stampa, questionari…), di farci parafrasi, riassunti, schematizzazioni (anche nella forma di mappe concettuali), e traduzioni di testi a cui eravamo interessati, di scrivere codice Python o HTML e JavaScript (ma anche LaTeX, SVG…) a partire da specifiche, e di spiegare il comportamento, ottimizzare, documentare codice esistente, convertirlo in un altro linguaggio…

E con ChatGPT abbiamo discusso di ChatGPT stesso (e dei suoi simili, come Bard e LLaMA, che nel frattempo si sono resi o si stanno rendendo disponibili) e di quello che sta succedendo e che potrebbe succedere con la diffusione sempre più ampia di agenti artificiali sempre più intelligenti: capisce, in qualche senso, quello che scrive? com’è possibile che, spesso così eloquente, commetta poi errori su questioni fattuali anche banali, che paia quasi incapace di elementari calcoli, e che alterni, a volte negli stessi dialoghi e sugli stessi soggetti, posizioni creative e profonde e affermazioni superficiali?

Da una parte, questi sono segnali che la sua è una comprensione aliena, diversa da quella che siamo abituati a osservare negli individui della nostra specie. Dall’altra, dobbiamo ammettere che, se applicassimo a ChatGPT i criteri con cui a scuola gli insegnanti cercano di individuare la comprensione profonda degli studenti (“fammi un esempio”, “fammi una sintesi”, “spiegami con le tue parole”, …), ne dovremmo concludere che assai spesso passa con successo le verifiche (e anche gli esami universitari…).

A proposito degli esseri umani siamo pronti ad ammettere che l’intelligenza non è binaria – si può essere più o meno intelligenti – e che esistono tipi diversi di intelligenza, come ha ben mostrato Howard Gardner in termini di “intelligenze multiple”: potrebbe essere che dovremo estendere il radar, per includere le nuove forme di intelligenza che manifestano i chatbot?

ChatGPT scrive di cose che non conosce

Tutto ciò è palesemente destabilizzante: tanto l’interazione in forma di chat è semplice, quanto è complesso ciò che produce tale interazione, considerando anche che gli stessi sviluppatori di ChatGPT sostengono, in “Educator considerations for ChatGPT”, pubblicato in gennaio 2023, che “we are still in the early days of understanding how this technology will be used and what kinds of applications people might explore using it”.

Certo, possiamo essere sicuri che, per il momento, ChatGPT e i suoi simili scrivono di cose che non hanno mai visto, per l’ovvio motivo che non hanno occhi, né telecamere, per vedere (e rimandiamo a un altro contesto le riflessioni a proposito di quello che potrebbe ulteriormente cambiare quando i chatbot fossero non solo connessi “in tempo reale” al web – come è la chat di Bing e come sarà lo stesso ChatGPT con un plugin – ma appunto diventassero parte di un sistema dotato di sensori, eventualmente diffusi, nelle prospettive, complementari ma entrambe inquietanti, del panopticon e del panpsichismo).

Almeno per il momento, ChatGPT e i suoi simili sono degli abili, eloquenti affabulatori, che hanno letto qualche triliardo di parole e le hanno assimilate – con strategie che nessuno conosce nei dettagli – nei valori dei loro 1011 parametri (1012 nel caso di GPT-4). Quello che rispondono alle nostre domande non deriva, almeno per ora, da un contatto diretto con il mondo empirico, e questo pone la questione dell’affidabilità dell’informazione che ci viene fornita, cosa resa evidente dagli errori che questi sistemi compiono. D’altra parte, anche in questo dobbiamo ristrutturare quello che abbiamo imparato in decine di anni di sviluppo del software: con eccezioni minori e non rilevanti, gli errori che i chatbot commettono non sono bug, perché nessuno ha mai scritto una regola / un algoritmo che ha condotto a produrre quell’errore, perché il testo che contiene quell’errore non è il risultato di una regola / di un algoritmo, ma di un addestramento profondo guidato dai testi letti (si usa infatti il termine “deep learning”: nel caso degli esseri umani, apprendimento e addestramento, “learning” e “training” rispettivamente, hanno significati ovviamente diversi, mentre per gli agenti artificiali, almeno per ora, i due concetti sono usati in modo non così chiaramente distinto).

ChatGPT può commettere errori di ragionamento

La verità di ChatGPT è, almeno per ora, l’opinione prevalente, secondo un criterio di prevalenza complesso e che può dipendere anche da fattori stocastici se l’iperparametro di temperatura non è nullo. È molto interessante che possiamo chiedergli di includere nelle sue risposte un’indicazione della certezza delle risposte stesse (“vorrei che nelle tue risposte tu dichiarassi il grado di certezza che attribuisci a quanto scrivi, mettendo in fondo a ogni tua risposta a cui questa condizione si applica un testo del tipo “[certezza: x]”, dove x è un valore tra 0 (nessuna certezza) e 1 (completa certezza)”), ma anche in questo caso la questione di “chi controlla il controllore” rimane. Questo dovrebbe essere tenuto sempre ben presente quando si interagisce con un chatbot. Non ci vuole ingannare e non c’è nessun “grande fratello” che sta controllando e orientando le sue risposte, ma può sia commettere errori “di ragionamento”, sia essere stato addestrato in modo distorto, ricordando che “large datasets based on texts from the internet overrepresent hegemonic viewpoints and encode biases potentially damaging to marginalized populations”, come è stato notato.

Conclusioni

In tutto ciò la posta in gioco è grande, per le opportunità che offre ma anche per i rischi che contiene. Abbiamo il coraggio di ammettere che non sappiamo cosa succederà: non rifugiamoci dietro ai tranquillizzanti, ma infondati, “non è…” (intelligente, creativo, …) e “non può…” (scrivere programmi complessi, risolvere nuovi problemi, …), e invece sperimentiamo e confrontiamoci tra noi: è il meglio, e forse la cosa più interessante in questo interessante periodo che stiamo vivendo, che possiamo fare. Ed è probabilmente la strategia migliore per mitigare i rischi e cogliere le opportunità che questi strumenti ci prospettano.