GPT è uno degli LLM che funziona meglio in zero-shot, vale a dire che se gli viene fatta una domanda risponde correttamente, in genere, alla prima delle risposte. Rimane il fatto, però, che GPT migliora esponenzialmente in più shot e, dunque, è consigliabile fargli una domanda e poi man mano dargli altre informazioni chiedendogli di riformulare meglio la risposta.

GPT non esercita pensiero matematico, razionale, etico o strategico: è nato solo per completare e generare testi. Come può essere impiegato in campo legale? E a che punto è la regolamentazione dell’AI?

Quali sono i principali limiti di GPT?

Osservando come funziona l’intelligenza artificiale stiamo imparando a vedere come funziona il nostro cervello e ci siamo accorti che tanto di quello che pensiamo essere bravura competenza e creatività è, molto spesso, semplicemente esperienza, metodo e ripetizione. La massima parte di quello che serve per essere competenti in un lavoro non è il pensiero critico, razionale o logico, ma è il metodo. Molte volte noi, senza rendercene conto, semplicemente ripetiamo cose che abbiamo visto fare più e più volte.

Tanto è vero che GPT-4 ha passato tutti e tre gli esami di avvocato negli Stati Uniti con uno score molto buono, e ha passato anche altri esami di facoltà come biologia, chimica, medicina, ecc. Li ha passati proprio perché, come detto, nella normalità dei casi se hai abbastanza training set la risposta più probabile è in genere anche la risposta corretta.

GPT, fagocitando tutto quello che c’è su internet di indicizzato, ha appreso le dipendenze statistiche tra parole diverse e le ha codificate come parametri nella sua rete neurale. GPT non sa le cose, ma conosce le probabili parole successive di una serie di discorsi che noi iniziamo.

Questo spiega perché ad esempio un LLM non sappia invece risolvere problemi matematici. Provando, ad esempio, a insistere con ChatGPT dicendo più volte che 2+2 fa 7 e non 4, alla fine ChatGPT si “convincerà” che 2+2 fa effettivamente 7…

Inoltre, un LLM ha le “allucinazioni”. Se si chiede, ad esempio, il record del mondo per l’attraversamento della manica a piedi, ChatGPT inventa e racconta con dovizie di particolari l’anno e il nome del soggetto che ha attraversato a piedi la manica.

Con allucinazioni artificiali si intendono risposte fiduciose da parte dell’intelligenza artificiale che però sono sbagliate. Il problema non è tanto il fatto che le risposte siano sbagliate, quanto la fiducia che l’intelligenza artificiale ripone nella risposta e la verosimiglianza della stessa, perché creata da un sistema che ha un bagaglio di conoscenze amplissimo e dunque i concetti sembrano estremamente articolati e dettagliati. Il termine deriva dal concetto di psicologia dell’allucinazione perché condivide caratteristiche simili all’allucinazione psicologica, come ad esempio il fatto che il sistema sia ignaro del fatto che sta allucinando, esattamente come l’uomo è ignaro del fatto che sta allucinando.

Quali sono i possibili utilizzi di GPT nel settore legale

Alla luce di queste considerazioni, possiamo dire che GPT non funziona con i quesiti legali perché c’è il serio rischio che inventi la soluzione qualora non sia presente nel suo dataset; tuttavia, se lo si corregge suggerendogli di cambiare prospettiva, lo si riesce a guidare verso la soluzione giusta. Si tratta sostanzialmente di avere lo stesso comportamento che si avrebbe nei confronti di un praticante avvocato che sta imparando.

Una delle funzioni migliori è l’explainer. Si può chiedere a ChatGPT di spiegare uno stesso concetto a destinatari diversi e ChatGPT modifica e adatta la risposta in base allo specifico destinatario richiesto, che sia un bambino di 5 anni o un manager d’azienda. Ciò non toglie che sia assolutamente necessario verificare la bontà della risposta prima di utilizzarla per qualsiasi scopo difensivo, ma consente di avere punti di vista differenti che possono essere molto utili quando si affronta una strategia difensiva.

GPT è utile, poi, per fare traduzioni di testo, preparare syllabus e contenuti di corsi a livello universitario. È inoltre stato addestrato con decine di interazioni per renderlo più empatico e gentile degli esseri umani. Uno studio pubblicato sulla rivista Jama Internal Medicine evidenzia come un gruppo di tre professionisti ha confrontato le risposte che davano i medici da quelle che dava ChatGPT e il risultato è stato che il panel di professionisti ha preferito le risposte di ChatGPT il 79% delle volte e le risposte di ChatGPT sono risultate di altissima qualità nel 79% dei casi contro il 22% delle risposte dei medici; inoltre, il 45% delle volte le risposte di GPT sono state schedate come empatiche o molto empatiche contro il 5% delle risposte dei medici. Sarebbe interessante effettuare la stessa ricerca nel settore legale.

In definitiva, GPT, ad oggi, può essere utile a un avvocato per superare il “blocco dello scrittore” quando deve essere redatto un atto oppure quando è necessario trasformare un testo in bozza in una prima versione di un atto. La capacità di GPT di riassumere testi è straordinariamente efficiente e quando viene esercitata su un testo predefinito dall’utente (ad esempio gli appunti prodromici alla redazione di un atto) la percentuale delle allucinazioni diminuisce radicalmente fino ad arrivare a un livello prossimo allo zero.

Quali sono i limiti dal punto di vista legale di Open AI ad oggi?

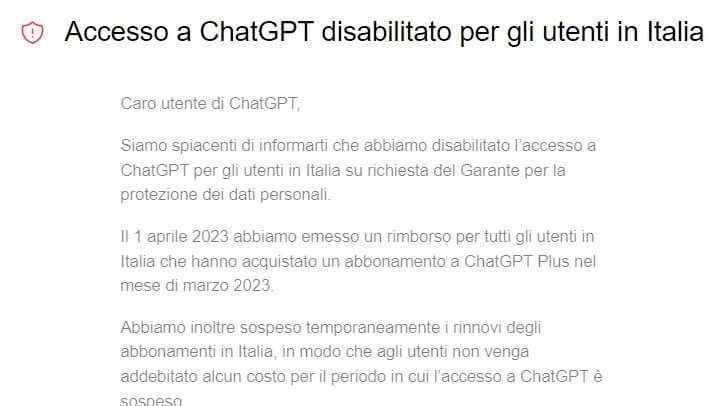

Allo stato, Open AI è stata oggetto di un provvedimento da parte dell’Autorità Garante per la Protezione dei Dati Personali il 30 marzo scorso che ha disposto la sospensione del servizio ChatGPT per quattro ragioni: la mancanza di una informativa agli utenti e a tutti gli interessati i cui dati vengono raccolti da OpenAI; l’assenza di un’idonea base giuridica in relazione alla raccolta dei dati personali e al loro trattamento per scopo di addestramento dell’algoritmo; l’inesattezza dei dati trattati, in quanto non sempre le informazioni fornite da ChatGPT corrispondono al dato reale e, infine, l’assenza di qualsivoglia filtro per la verifica che l’età degli utenti sia maggiore di tredici anni.

ChatGPT è stato riattivato in Italia il 28 aprile, dopo che OpenAI ha fatto pervenire una nota nella quale ha illustrato le misure introdotte in ottemperanza alle richieste del Garante.

In particolare, ad esempio, oggi chiunque è informato in maniera più chiara della circostanza che i propri dati personali – anche se non utente della piattaforma – potrebbero essere stati utilizzati per l’addestramento degli algoritmi e chiunque, utente o non utente, può chiedere a OpenAI che i propri dati personali non siano più utilizzati per tale addestramento. Inoltre, chiunque, qualora ritenga che ChatGPT generi contenuti inesatti sul suo conto, può chiedere e ottenere che i contenuti in questione non vengano più generati o, meglio, che i propri dati personali non compaiano più nei contenuti in questione. L’informativa sulla privacy, poi, è ora immediatamente identificabile nel flusso di registrazione e gli utenti italiani già registrati vengono invitati a confermare di essere maggiorenni o ultratredicenni con il consenso dei genitori prima di riprendere a utilizzare il servizio mentre quelli non registrati devono indicare la loro età nel flusso di registrazione.

Tuttavia, il vero problema riguarda il training set da cui ChatGPT attinge e ha attinto per diventare quello che è: innanzitutto non è chiara la base giuridica (legittimo interesse?) con cui questi dati sono stati raccolti e, in secondo luogo, ChatGPT, come già detto, non sa distinguere quali siano attendibili e quali no, ma solamente quali siano probabili e quali no.

Quali saranno le limitazioni dal punto di vista legale di Open AI nel prossimo futuro?

Al netto delle altalenanti dichiarazioni di Sam Altman in merito alle scelte della politica legislativa Europea in tema di intelligenza artificiale, il Regolamento (AI Act) è stato votato il 14 giugno dal Parlamento e ha iniziato l’iter negoziale tra Consiglio d’Europa e Commissione; si presume che entrerà in vigore a primavera 2024 con i consueti due anni di attesa prima della sua concreta applicazione. Nella speranza che tali tempi vengano ridotti, si è aperto sullo sfondo uno scenario dove Stati Uniti ed Europa potrebbero varare un codice di condotta comune finalizzato a regolare entro poche settimane impatto e sviluppo dell’intelligenza artificiale in modo volontaristico.

Tornando alla proposta di Regolamento Europeo, si può affermare che l’intelligenza artificiale generativa è stata “recuperata in zona Cesarini”, in quanto l’11 maggio è stato inserito dai relatori Brando Benifei e Dragoş Tudorache un emendamento ad hoc in forza del quale tali sistemi devono:

- a) rispettare gli obblighi di trasparenza in forza dei quali le persone fisiche siano informate del fatto di stare interagendo con un sistema di AI;

- b) sviluppare un training set che non violi i diritti fondamentali dei cittadini europei con particolare riferimento alla privacy;

- c) mettere a disposizione una sintesi di tutti i training set utilizzati.

Come era intuibile, il Regolamento – che era stato ipotizzato prima dell’avvento della “rivoluzione generativa” – punta a regolare la sostanza, ossia il training set di dati da cui OpenAI attinge e che ai sensi dell’articolo 10 devono essere “essere pertinenti, rappresentativi, esenti da errori e completi”.

In attesa di sapere quali saranno gli esiti legislativi, la norma di riferimento che oggi abbiamo a disposizione è l’art. 22 del Regolamento sulla privacy (GDPR) ai sensi del quale “l’interessato ha diritto di non essere sottoposto a una decisione basata unicamente sul trattamento automatizzato, compresa la profilazione, che produca effetti giuridici che lo riguardano o che incida in modo analogo significativamente sulla sua persona”. Questa norma prevede che vi sia sempre un intervento umano in grado di contestare la decisione presa o di esprimere la propria opinione con riferimento al trattamento automatizzato. Sarà davvero strategico ricordare questo importante tassello normativo attualmente in vigore in attesa che vengano approvate normative di settore più dettagliate.

GPT, un breve riepilogo della tecnologia

GPT (Generative Pretrained Transformer) è un LLM (Large Language Model) rilasciato da OpenAI nel 2018. A differenza dei modelli di AI tradizionali, che devono essere addestrati su un gran numero di dati per imparare a eseguire compiti specifici (come il riconoscimento di immagini, la traduzione automatica o la guida di veicoli autonomi), i modelli linguistici di grandi dimensioni (LLM) sono un tipo di intelligenza artificiale progettato per imitare la capacità di elaborazione del linguaggio umano. Utilizzano tecniche di apprendimento profondo, come le reti neurali, e vengono addestrati su grandi quantità di dati testuali provenienti da varie fonti, tra cui libri, articoli, siti web e altro. L’addestramento approfondito consente a un LLM di generare testi altamente coerenti e realistici analizzando gli schemi e le connessioni all’interno dei dati su cui sono stati addestrati e usando questa conoscenza per prevedere quali parole o frasi è probabile che appaiano successivamente in un contesto specifico. Questa capacità di comprendere e generare il linguaggio è utile in vari campi dell’elaborazione del linguaggio naturale (NLP), come la traduzione automatica e la generazione di testi.

GPT-3 e GPT-4

Nel 2020 viene rilasciata una nuova versione, GPT-3, addestrata su un enorme dataset di testo (570GB con una dimensione del modello di 175B parametri). ChatGPT è una variante di GPT-3, sviluppata per il dialogo con gli utenti.

Il 14 marzo 2023 è stato lanciato l’ultimo modello della serie, GPT-4, che migliora i modelli di GPT-3, aumentando la correttezza fattuale delle risposte e abbassando il livello di allucinazioni, vale a dire gli errori fattuali e di ragionamento.

Soffermandoci su GPT-3, questo modello è stato addestrato su 5 set di dati: Common Crawl – un’organizzazione che effettua il crawling, ossia lo scandaglio e la memorizzazione del web, e mette a disposizione del pubblico tutti i propri archivi e set di dati – da cui provengono circa il 60% delle informazioni di GPT-3; Web text 2; Books1; Books2 e tutto l’universo di Wikipedia.

Da un punto di vista dell’hardware, GPT-3 ha 96 strati di decodifica, è costruito su un sistema che ha 285.000 core di CPU, 10.000 unità di elaborazione grafica e 400 Gbps di connettività di rete per ogni server GPU.