Nel suo keynote al Computex di Taipei, il fondatore e CEO di Nvidia, Jensen Huang, ha presentato una nuova serie di sistemi, software e servizi che sfruttano la potenza dell’AI generativa per rimodellare diversi settori, dalla pubblicità alla produzione alle telecomunicazioni.

Huang ha dichiarato di ritenere che queste innovazioni non solo faciliteranno nuovi modelli di business, ma miglioreranno anche in modo significativo l’efficienza dei modelli esistenti in una moltitudine di settori.

Video: Il keynote di Nvidia al Computex 2023

Uno dei punti salienti del keynote è stato il lancio ufficiale di Grace Hopper, una piattaforma che combina la CPU Nvidia Grace ad alta efficienza energetica con la GPU Nvidia H100 Tensor Core ad alte prestazioni. Questo modulo all-in-one consente alle aziende di ottenere prestazioni AI senza precedenti, ha dichiarato Huang.

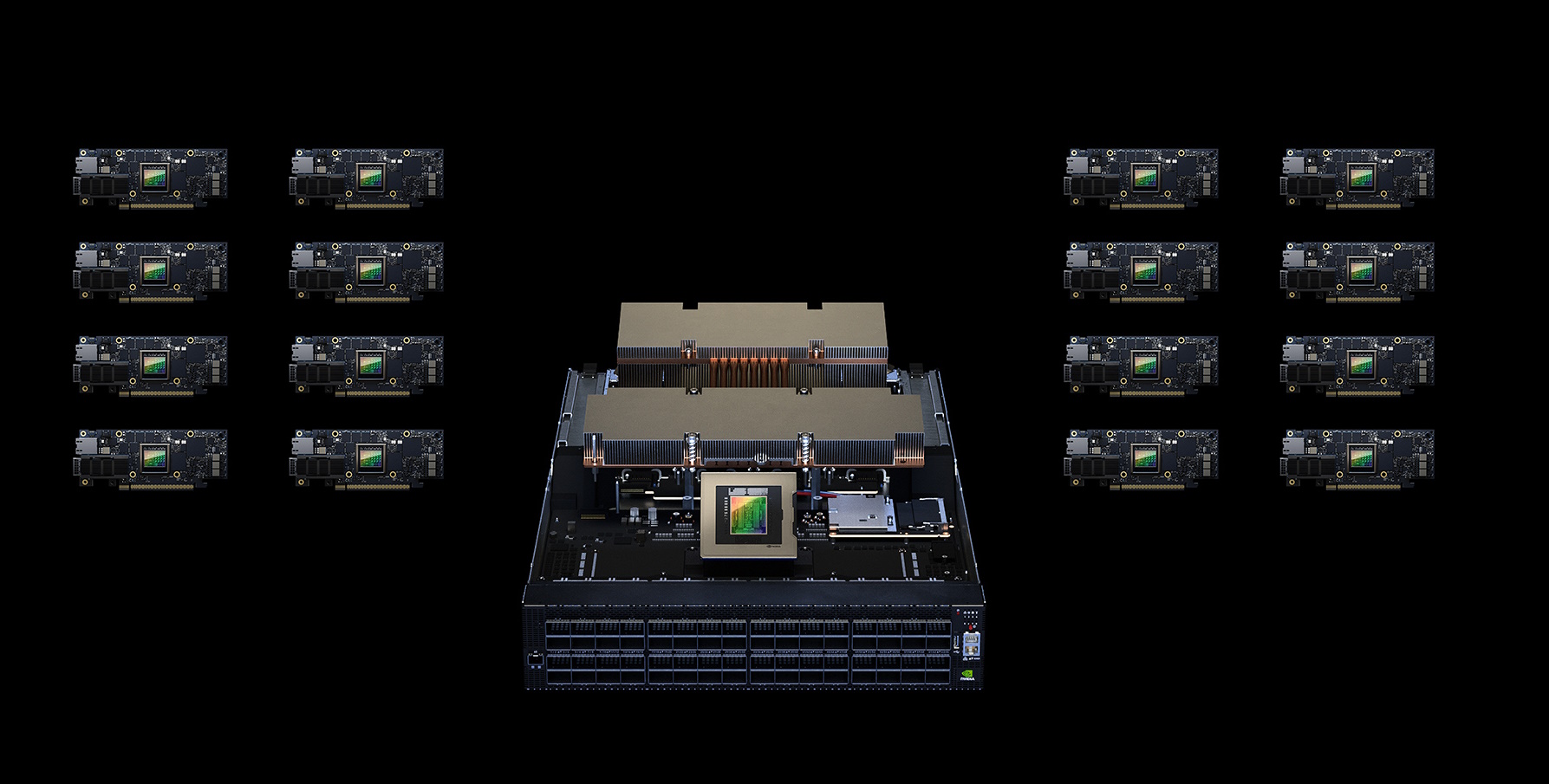

Huang ha presentato inoltre DGX GH200, un supercomputer di intelligenza artificiale con ampie capacità di memoria, in grado di integrare fino a 256 Nvidia Grace Hopper Superchip in una singola GPU di dimensioni da data center.

DGX GH200, un exaflop di prestazioni e 144 terabyte di memoria condivisa

Con un exaflop di prestazioni e 144 terabyte di memoria condivisa, il DGX GH200 supera i suoi predecessori di quasi 500 volte, consentendo agli sviluppatori di costruire modelli linguistici intricati per chatbot GenAI, algoritmi avanzati per sistemi di raccomandazione e sofisticate reti neurali a grafo per attività come il rilevamento delle frodi e l’analisi dei dati. Huang ha dichiarato che giganti tecnologici come Google Cloud, Meta e Microsoft stanno già esplorando le capacità di DGX GH200 per i loro carichi di lavoro di AI generativa.

Huang ha sottolineato che “i supercomputer DGX GH200 AI integrano le più avanzate tecnologie di calcolo accelerato e di rete di Nvidia, spingendo i confini dell’AI”.

Huang ha anche presentato Nvidia Avatar Cloud Engine (ACE) for Games, un servizio di foundry che consente agli sviluppatori di creare e distribuire modelli AI personalizzati per il parlato, la conversazione e l’animazione. ACE equipaggia i personaggi non giocabili con abilità di conversazione, consentendo loro di rispondere alle richieste con personalità realistiche in continua evoluzione.

Il toolkit comprende modelli di base dell’intelligenza artificiale come Nvidia Riva per il rilevamento e la trascrizione del parlato, Nvidia NeMo per la generazione di risposte personalizzate e Nvidia Omniverse Audio2Face per l’animazione di queste risposte.

Inoltre, Nvidia ha annunciato la collaborazione con Microsoft per promuovere l’innovazione nell’era dell’AI generativa per i PC Windows. La partnership prevede lo sviluppo di strumenti, framework e driver avanzati che semplificano il processo di sviluppo e distribuzione dell’AI sui PC.

La collaborazione mira a potenziare ed espandere la base installata di oltre 100 milioni di PC con GPU RTX dotate di Tensor Cores, aumentando così le prestazioni di oltre 400 applicazioni e giochi Windows accelerati dall’intelligenza artificiale.

Sfruttare l’AI generativa per la pubblicità digitale

Nel suo keynote Huang ha affermato che il potenziale dell’AI generativa si espande al settore della pubblicità digitale, in cui Nvidia collabora con l’organizzazione di servizi di marketing WPP. Insieme, le aziende hanno sviluppato un innovativo motore di contenuti sulla piattaforma Omniverse Cloud.

Questo motore consente ai team creativi di collegare i loro strumenti di progettazione 3D, come Adobe Substance 3D, per creare gemelli digitali dei prodotti dei clienti all’interno dell’Omniverse di Nvidia. Utilizzando strumenti GenAI formati su dati di provenienza responsabile e alimentati da Nvidia Picasso, questi team saranno ora in grado di produrre rapidamente set virtuali.

Nvidia ha dichiarato che questa nuova capacità consente ai clienti di WPP di generare una moltitudine di annunci, video ed esperienze 3D personalizzate per i mercati globali, accessibili su qualsiasi dispositivo web.

Focus sui digital twin

L’azienda ha inoltre annunciato di essersi concentrata con successo sul settore manifatturiero, un’industria da 46.000 miliardi di dollari che comprende circa 10 milioni di fabbriche. Huang ha sottolineato che, sfruttando le tecnologie Nvidia, produttori di elettronica come Foxconn Industrial Internet, Innodisk, Pegatron, Quanta e Wistron stanno passando ai flussi di lavoro digitali, avvicinando la visione di fabbriche intelligenti completamente digitali alla realtà.

Secondo Huang, “le più grandi industrie del mondo creano oggetti fisici. Costruendole prima in digitale, possiamo risparmiare miliardi”.

L’integrazione di Omniverse e di API di intelligenza artificiale generativa ha permesso a queste aziende di stabilire connessioni tra strumenti di progettazione e di produzione, costruendo così repliche digitali delle loro fabbriche, note come gemelli digitali o digital twin.

Inoltre, le aziende utilizzano Nvidia Isaac Sim per simulare e testare i robot e Nvidia Metropolis – un framework di intelligenza artificiale per la visione – per l’ispezione ottica automatizzata. L’ultima novità dell’azienda, Nvidia Metropolis for Factories, consente di creare sistemi di controllo qualità personalizzati, offrendo ai produttori un vantaggio competitivo e consentendo loro di sviluppare applicazioni AI all’avanguardia.

Una nuova gamma di supercomputer AI e soluzioni server versatili

Nvidia ha anche rivelato che è in corso la costruzione del supercomputer di intelligenza artificiale Nvidia Helios, che dovrebbe essere operativo entro la fine dell’anno. Il supercomputer utilizzerà quattro sistemi DGX GH200 interconnessi con la rete Nvidia Quantum-2 InfiniBand, in grado di fornire una larghezza di banda fino a 400 Gb/s. Di conseguenza, il throughput dei dati per l’addestramento di modelli di intelligenza artificiale su larga scala sarà notevolmente migliorato.

Oltre a questo sviluppo innovativo, Nvidia ha presentato Nvidia MGX, un’architettura di riferimento modulare che consente ai produttori di sistemi di creare in modo efficiente ed economico diverse configurazioni di server su misura per applicazioni AI, HPC e Nvidia Omniverse.

Con l’architettura MGX, i produttori possono sviluppare CPU standardizzate e server accelerati utilizzando componenti modulari. Queste configurazioni supportano una gamma di GPU, CPU, unità di elaborazione dati (DPU) e adattatori di rete, compresi i processori x86 e Arm.

Inoltre, le configurazioni MGX possono essere inserite in chassis raffreddati ad aria e a liquido. In testa all’adozione dei progetti MGX ci sono QCT e Supermicro, con le rispettive introduzioni previste per agosto. Si prevede che altre aziende importanti come ASRock Rack, ASUS, GIGABYTE e Pegatron seguiranno l’esempio.

L’impatto di Nvidia sull’infrastruttura 5G e sul cloud networking

Huang ha annunciato collaborazioni per rivoluzionare l’infrastruttura 5G e il cloud networking. Ad esempio, una partnership con un importante gigante delle telecomunicazioni in Giappone svilupperà una rete distribuita di data center che sfrutterà le DPU Grace Hopper e BlueField-3 di Nvidia all’interno di sistemi modulari MGX.

Incorporando gli switch spectrum ethernet di Nvidia, i data center faciliteranno la fornitura della tempistica precisa richiesta dal protocollo 5G. Questo porterà a una maggiore efficienza spettrale e a un consumo energetico ridotto. La piattaforma è promettente per diverse applicazioni, tra cui la guida autonoma, le fabbriche di intelligenza artificiale, la realtà aumentata e virtuale, la computer vision e i digital twin.

Inoltre, Huang ha presentato Nvidia Spectrum-X, una piattaforma di rete appositamente progettata per migliorare le prestazioni e l’efficienza dei cloud AI basati su Ethernet. Combinando gli switch Ethernet Spectrum-4 con le DPU e il software BlueField-3, Spectrum-X offre un incremento di 1,7 volte delle prestazioni e dell’efficienza energetica dell’AI. I principali produttori di sistemi come Dell Technologies, Lenovo e Supermicro offrono già Nvidia Spectrum-X, gli switch Spectrum-4 e le DPU BlueField-3.

Centri di supercalcolo per l’AI generativa

Nvidia sta inoltre facendo passi da gigante nella creazione di centri di supercalcolo per l’AI generativa in tutto il mondo.

In Israele, ad esempio, l’azienda sta costruendo Israel-1, un supercomputer all’avanguardia all’interno del suo data center locale. Israel-1 comprende server Dell PowerEdge, la piattaforma di supercomputing Nvidia HGX H100 e la piattaforma Spectrum-X con DPU BlueField-3 e switch Spectrum-4. Il suo obiettivo principale è quello di accelerare le attività di ricerca e sviluppo locali.

A Taiwan, inoltre, sono attualmente in fase di sviluppo due nuovi supercomputer: Taiwania 4 e Taipei-1. Taiwania 4, costruito da ASUS e il cui lancio è previsto per l’anno prossimo, utilizza CPU Grace basate su Arm e una rete InfiniBand Quantum-2 di Nvidia. Nvidia ha dichiarato che si tratta di uno dei supercomputer asiatici più efficienti dal punto di vista energetico.

D’altra parte, Taipei-1, che è di proprietà e gestito da Nvidia, sarà caratterizzato da 64 supercomputer DGX H100 AI, 64 sistemi Nvidia OVX e networking Nvidia.