Anche nel 2023, le organizzazioni proseguiranno nel percorso di consapevolezza delle potenzialità e delle sfide che comporta l’AI e dovranno, altresì, dimostrare di essere in grado di gestirne i rischi. Le autorità di regolamentazione, a livello globale, proseguiranno nella definizione del necessario quadro legislativo per affrontare le implicazioni legali ed etiche che possono scaturire da un uso improprio o non corretto dell’AI.

Lo scenario 2023 dell’AI in un white paper

Come si evince da un recente white paper dalla società di consulenza Dentons – intitolato “AI 2023 key trends and developments“, il 2023 sarà caratterizzato da una maggiore conoscenza dei diversi aspetti di utilizzo dell’AI oltre che da una necessaria consapevolezza delle sfide e delle implicazioni etiche e legali che l’utilizzo di questa tecnologia implica. Vediamo quali sono i temi sui quali si sofferma il documento.

“AI 2023 key trends and developments”: i punti chiave del white paper

AI trasparente

La complessità delle problematiche di responsabilità dell’AI comporta sempre più la necessità di garantire che i modelli di AI siano accuratamente testati; gli algoritmi siano elaborati utilizzando dati di qualità; il processo decisionale attuato dalla tecnologia sia comprensibile e spiegabile.

Pertanto, anche quest’anno, il tema della trasparenza occuperà un ruolo centrale. Si ritiene che numerosi governi definiranno quadri normativi atti a stabilire garanzie procedurali in termini di elaborazioni eseguite dall’AI prima di giungere a una decisione in modo da tutelare i singoli cittadini e, al contempo, soddisfare le aspettative delle autorità di vigilanza.

AI affidabile

Si tratta di indagare se i sistemi di AI siano affidabili, verificando sia i bias scaturiti dai dati con cui sono alimentati gli algoritmi, sia il comportamento degli algoritmi stessi. L’affidabilità dell’AI dovrebbe far crescere la fiducia di chiunque stia considerando di implementare l’AI e di coloro le cui vite potrebbero essere influenzate da questa implementazione. Ovvero, maggiore è l’adozione dell’AI, maggiore è la necessità di conoscere gli standard in base ai quali l’AI è stata sviluppata.

È doveroso evidenziare che l’affidabilità dell’AI scaturisce dall’armonia degli standard che si convertono in leve strategiche e fondamentali per garantire la coerente implementazione di misure di garanzia della tecnologia. Pertanto, si ritiene che nel 2023 prevarrà la volontà di fornire una regolamentazione più armoniosa dell’AI a livello internazionale in modo facilitare il rispetto di varie norme e regolamenti in più giurisdizioni e, di conseguenza, aumentare la fiducia delle persone nella tecnologia.

Metaverso

Stiamo assistendo alla convergenza tra mondo reale e mondo virtuale che si basa sull’AI. In questo contesto diventa fondamentale sviluppare norme e regolamentazioni per affrontare le tematiche di proprietà intellettuale e di responsabilità in termini sia di utenti, sia di fornitori di piattaforme software basate sull’AI (che consentono la creazione di innumerevoli contenuti ed esperienze immersive).

Nonostante le numerose sfide, nel 2023 e negli anni a seguire, si assisterà a un’adozione e a un utilizzo maggiore del metaverso per le sue potenzialità in termini di: operazioni di transazione; fornitura e consumo di beni e servizi; modalità di ricerca, ecc.

AI nel processo di selezione

Le organizzazioni che utilizzano l’AI nel processo di selezione possono incorrere in rischi di responsabilità a fronte di discriminazioni involontarie derivanti dai dati utilizzati per addestrare i sistemi di AI. Tuttavia, l’utilizzo dell’AI nel processo di selezione – nonostante in passato si siano verificati episodi di discriminazione – è destinato a incrementare nel 2023 a fronte dell’introduzione di ulteriori misure volte a ridurre i rischi di discriminazione/parzialità.

Inoltre, considerando che sistemi di AI sono inizialmente sviluppati e addestrati dagli esseri umani – anche nel caso in cui i dati di addestramento risultino imparziali – ci sarà sempre un elemento umano e, quindi, un rischio di “distorsioni” che possono influenzare il set di dati. Ancora, molti sistemi di AI imparano continuamente e gli algoritmi si evolvono a seconda di come viene utilizzato il sistema. Ne consegue che l’AI – anche se non presenta bias nella fase iniziale – può sviluppare tendenze “distorte” nel tempo.

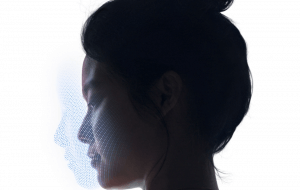

AI per il riconoscimento facciale

L’AI viene utilizzata nei sistemi di riconoscimento per scansionare le immagini dei volti e abbinarle a degli identificatori univoci di un database di immagini. Interessante notare che, se da un lato si assiste a un trend crescente di utilizzo di tecnologie di riconoscimento facciale AI – ad esempio per dimostrare l’identità di una persona come parte dell’accesso a dispositivi, accessi ad app bancarie ecc. – dall’altro lato, negli ultimi anni, questa tecnologia è stata sempre più utilizzata per esercitare la sorveglianza pubblica da parte delle forze di polizia e delle autorità di controllo di regimi teocratici e autoritari.

Nell’ottobre 2022 la società di consulenza Statista ha riferito che il mercato del riconoscimento facciale – che nel 2021 era stato valutato in circa 5 miliardi di dollari – è destinato a crescere fino a 12,67 miliardi di dollari entro il 2028.

Inoltre, i maggiori dibattiti sul riconoscimento facciale in tempo reale si sono svolti in UE scaturiti nella incisiva posizione del Garante europeo della protezione dei dati, ovvero: il riconoscimento automatizzato dei volti dei cittadini negli spazi pubblici viola, di fatto, i diritti fondamentali di privacy e di libertà e, pertanto, dovrebbe essere vietato. In quest’ottica, nel 2023 assisteremo a numerosi tentativi regolamentari atti a disciplinare alcuni usi della tecnologia di riconoscimento facciale soprattutto per contrastarne l’uso coercitivo in Paesi antidemocratici.

AI nel settore sanitario

L’AI è sempre più impiegata nel settore sanitario sia per prevedere le esigenze future dei pazienti e monitorarne la salute (tramite l’acquisizione dei dati dalle cartelle cliniche digitalizzate, le telecamere termiche, i robot medici) sia per la ricerca di nuovi farmaci, ecc. Un trend che continuerà anche nel 2023 e negli anni futuri, a tal punto che la società di consulenza Statista prevede che il mercato globale dell’AI nel settore sanitario – che nel 2021 risultava pari a 11 miliardi di dollari – raggiungerà i 188 miliardi di dollari nel 2030. Inoltre, sarà sempre più fondamentale garantire la salvaguardia dei dati sensibili dei pazienti in termini di protezione e di privacy.

AI e diritti di proprietà intellettuale

Nei prossimi anni le organizzazioni che creeranno o impiegheranno tecnologie di AI addestrate utilizzando dati personali e/o informazioni/dati protetti da diritti di proprietà intellettuale probabilmente saranno sottoposte a un maggiore controllo normativo.

Le autorità di regolamentazione, a livello globale, continueranno anche nel 2023 a perseguire un equilibrio tra vantaggi e sfide che l’utilizzo dell’AI comporta, soprattutto in termini di dati personali e protezione della proprietà intellettuale.

AI generativa

L’AI generativa è assurta ad hype del 2023. ChatGPT di OpenAI ne è un esempio, che si distingue per la capacità di generare testi, immagini, discorsi, video e prototipi tecnologici basati sulle istruzioni inserite dall’utente e che comporta sfide in termini giuridici nel caso di utilizzo di una grande quantità di opere protette da proprietà intellettuale secondo modalità che potrebbero essere in contrasto con le normative vigenti.

Pertanto, nel 2023 assisteremo ad azioni atte a regolamentare i casi in cui le opere generate dall’AI presentano contenuti protetti da proprietà intellettuale e che potrebbero dare adito a problemi di privacy o di protezione dei dati.

Regolamentazione dell’AI

Numerose organizzazioni di normazione – a varie latitudini – stanno lavorando a un quadro normativo dell’AI e tale trend continuerà anche nel 2023 e, precisamente:

- UK – prevede di pubblicare un White Paper per fornire un quadro generale – e non una normativa – adattabile ai diversi settori e in grado di garantire la trasparenza di utilizzo dell’AI.

- UE – sta adottando un approccio più strutturato e rigido alla regolamentazione dell’AI. Di fatto, l’AI act – che sarà pubblicato nel corso del 2023 – prevede la classificazione di rischio inaccettabile, alto o basso relativo all’AI. Senza dimenticare che a settembre 2022 è stata pubblicata la AI liability directive in base alla quale chi è stato danneggiato da aziende che impiegano l’AI può presentare reclami. La nuova Direttiva vuole essere una misura per prevenire i potenziali danni causati dall’AI e da determinati suoi utilizzi, oltre a prevedere un risarcimento nei casi in cui si sia già verificato un danno.

- USA – Lo scorso anno è stato introdotto il progetto dell’AI bill of rights che stabilisce cinque principi chiave per la protezione dei diritti degli americani per quanto riguarda l’impatto dell’AI. Inoltre, nel luglio 2022, l’House Energy and Commerce Committee ha approvato l’American Data Privacy and Protection Act (ADPPA) che propone standard nazionali in materia di dati personali raccolti dalle aziende e di processo decisionale dell’IA. Pertanto, si ritiene che Il governo USA si focalizzerà su un’ulteriore regolamentazione del processo decisionale sull’AI.

Conclusioni

L’attuale prospettiva di fornire una regolamentazione più armoniosa dell’AI a livello internazionale sarà ovviamente vantaggiosa per le organizzazioni che operano in più giurisdizioni, oltre a contribuire al rispetto di varie norme e regolamenti locali ai fini di coerenza tra tutte le giurisdizioni.

Lo sforzo globale per regolamentare l’AI influenzerà inevitabilmente il modo con cui le nuove tecnologie saranno costruite, vendute e utilizzate. È quanto mai necessaria un’etica per rendere questa tecnologia compatibile con la vita che vogliamo vivere. Si tratta di rendere il valore morale assimilabile alle logiche digitali/tecnologiche.

Pertanto, se in passato – quando si trattava di tecnologia – l’unica questione etica consisteva nel definire il suo utilizzo e il suo utilizzatore, oggigiorno assistiamo ad una ulteriore evoluzione. Ovvero, come afferma Paolo Benanti – francescano e docente alla Pontificia Università Gregoriana – ci troviamo di fronte all’algoretica che altro non è che il tentativo di vivere la tecnologizzazione della società in modo attivo, definendo i valori fondanti della società stessa.

Il cammino è ancora lungo e impervio e sarà interessante capire se il 2023 sarà l’anno della svolta per gestire le sfide e i rischi dell’AI.