Il titolo è ripreso da un intervento fatto recentemente per presentare il White paper sviluppato da Anitec-Assinform sul tema del contributo che l’AI può dare allo sforzo di ripresa dopo la pandemia. Il White paper è nato dalla collaborazione tra i rappresentanti di una ventina di aziende associate ad Anitec-Assinform e ha segnato un passo in avanti rispetto ai molti documenti prodotti sul tema AI a livello europeo, tra cui quello recente sugli aspetti etici e regolatori, tenendo anche in conto le evoluzioni a livello mondiale. Partiamo proprio da questo background su cui è stato sviluppato il White paper.

AI e prodotti smart

Che l’intelligenza artificiale abbia fatto enormi progressi sotto il profilo della sua applicazione è indubbio. Vi sono talmente tanti prodotti e servizi basati su AI che questa è entrata nel linguaggio del marketing, per cui oggi abbiamo lo spazzolino da denti intelligente, l’auto intelligente, l’assistente personale intelligente…. A livello di produzione ci sono i robot intelligenti, le supply chain intelligenti, i materiali intelligenti…

Quanto del dichiarato abbia un concreto riscontro sia in termini di intelligenza percepita, sia in termini di tecnologie di AI utilizzate è un altro discorso. Vi sono risponditori automatici (chatbot) che usano massicce dosi di AI e ci sembrano piuttosto stupidi quando interagiamo con loro al punto da generare un senso di frustrazione. Per contro abbiamo sistemi di irrigazione automatica, con sensori di umidità e connessione a Internet per informarsi sulle probabilità di pioggia che ci paiono molto intelligenti e che non usano alcuna tecnologia AI.

Elementi emergenti nell’AI

Il panorama è quindi molto variegato. Tuttavia, come osservato dal gruppo di lavoro dell’IEEE (Institute of Electrical and Electronics Engineers) sulla realtà digitale di cui faccio parte, alcuni elementi dirompenti stanno emergendo:

- fare AI oggi non richiede più la disponibilità di enormi quantità di dati, spesso è sufficiente tener traccia del modo in cui cambiano certi insiemi di dati (imparare dallo scorrere del tempo, auto-creazione di dati e loro valutazione rispetto a obiettivi…). Le GAN, Generative Adversarial Networks, stanno aprendo nuove opportunità alle piccole medie imprese che di dati non ne hanno tantissimi ma che possono contare su flussi continui, dalle supply chain, dai dealers e sempre più dagli utilizzatori (la profilatura oggi non la fa solo Netflix, anche chi vende un bar-B-Q potenzialmente può profilare l’utilizzatore);

- esistono tool-kit che permettono di sviluppare AI a basso costo e con un bagaglio di competenze contenuto, aprendo di fatto al suo impiego in un numero crescente di settori (low code e no-code software);

- sviluppare AI attraverso machine learning non necessariamente comporta l’utilizzo di cloud o di supercomputer. Nuovi chip, a basso costo, integrabili in una varietà di prodotti consumer, permettono di rendere “intelligenti” i prodotti (quasi tutti i nuovi telefonini e tablet oggi hanno questo tipo di chip). Questo significa disporre di intelligenza locale;

- sempre più spesso ai prodotti si affianca una immagine digitale che risiede nel cloud (del fornitore di servizi, del produttore, e ben presto, nello spazio personale di ciascun utilizzatore). Questa immagine digitale, o digital twin, diventa sempre più un complemento del prodotto, un servizio che si va ad aggiungere, ad esempio adattando le interazioni sulla base dell’utilizzatore. Questo digital twin in qualche modo disaccoppia il produttore dall’utilizzatore ma al tempo stesso crea un ponte tra i due, consentendo l‘erogazione di servizi, trasformando di fatto il prodotto in un servizio;

- come conseguenza degli ultimi due fattori, intelligenza locale e digital twin nel cyberspace, si assiste all’emergere di una intelligenza diffusa, derivante dalla interazione tra una moltitudine di elementi (prodotti) intelligenti.

Tutti questi fattori sono già presenti oggi e la loro evoluzione li renderà sempre più determinanti nei prossimi anni, condizionando il modo di sviluppare, offrire e fruire di prodotti e servizi. Viene quindi ad essere impattata sia la catena dell’offerta sia quella della domanda, rinforzandosi e accelerando l’evoluzione l’una dell’altra.

L’AI nel White paper di Anitec-Assinform

Queste tendenze sono state il punto di partenza del White paper prodotto dal gruppo di lavoro Anitec-Assinform.

Perché parlare di un cacciavite del futuro quando ho sottolineato la massiccia e pervasiva presenza di AI oggi?

Il fatto è che per poter reggere il paragone con un cacciavite, l’AI dovrebbe:

- essere uno strumento che chiunque, avendolo sottomano, saprebbe come utilizzare e questo ad oggi non è il caso, abbiamo bisogno di specialisti;

- esistere in un mondo di “viti”. Le viti per l’AI sono i dati e se è vero che di dati ce ne sono una valanga non è spesso vero che questi siano accessibili e utilizzabili.

Si sta lavorando su entrambi questi versanti e il PNRR dovrebbe contribuire, insieme a diverse iniziative a livello europeo, a superare questi scogli.

Il White Paper ha insistito molto sulla necessità che l’AI non sia trattata nel PNRR come un capitolo a sé stante su cui vengono erogati dei fondi, piuttosto sia concepita come una infrastruttura abilitante su cui occorre continuare a investire per il suo sviluppo e – estremamente importante – sul suo utilizzo. Per fare questo la formazione a tutti i livelli da istituti tecnici/università a forza lavoro e imprenditori è fondamentale.

Gaia-X nel White paper sull’AI

Sul versante “dati”, l’iniziativa Gaia-X ha le carte in regola per definire/costruire i data space che danno combustibile alla AI e anche qui il PNRR deve dare spinta verso lo sviluppo dei data space, anche perché questi rappresentano il tessuto di congiunzione tra vari attori in una filiera diventando quindi elemento abilitante nella transizione/industria 4.0.

Questi elementi sono ben rappresentati su alcune filiere trattate nel White paper. Altre filiere verranno aggiunte nel prosieguo in quanto questo documento rappresenta un work in progress che dovrà proseguire aggregando man mano le esperienze e le esigenze che emergono dai settori produttivi.

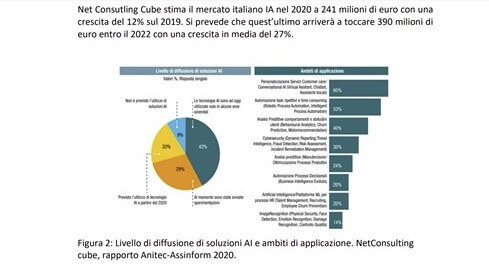

L’Italia pur avendo numerose eccellenze nel settore, sia sul versante accademico sia in quello industriale e di system integrator, è complessivamente indietro rispetto all’Europa che a sua volta è indietro rispetto ai colossi USA e Cina, che continuano a investire molto più di noi in ricerca e in applicazione. La crescita attesa in Italia è significativa ma resta inferiore a quella prevista in Europa quindi la tendenza è verso un ulteriore allargamento del gap, il che significa meno competitività per le nostre imprese e minor incremento del livello dei servizi per i cittadini. Ecco, quindi, l’assoluta necessità di far leva sulla opportunità del PNRR per colmare il divario, tenendo anche conto che la specificità italiana basata su un tessuto di piccole medie imprese oggi può fruire delle possibilità offerte dalle nuove tecnologie AI, visto che queste mettono in gioco anche i “piccoli”.

Conclusioni

Il futuro è ancora da scrivere e mai come in questo caso dipenderà dalla capacità di fare sistema. In fondo questo è sia l’auspicio, sia la motivazione del lavoro fatto in Anitec-Assinform e dell’impegno che continuerà a essere profuso su questo versante.