L’inarrestabile ascesa dell’intelligenza artificiale sta comportando diverse trasformazioni nel campo della scienza e dell’assistenza sanitaria, con un impatto positivo sulla creatività e sulla produttività umana. Grazie ai progressi della tecnologia moderna, i ricercatori continuano a sviluppare vari strumenti alimentati dall’AI, con il fine di creare e trasformare diversi sistemi e processi. In questo contesto, ChatGPT è indubbiamente “la star del momento”. La punta di diamante dell’azienda statunitense OpenAI continua a ottenere continui riconoscimenti per l’esecuzione di vari tipi di compiti in diversi settori, tra cui spicca quello sanitario.

ChatGPT nel settore sanitario, fra luci e ombre

Lo scorso febbraio, i ricercatori del Massachusetts General Hospital (MGH) e della startup statunitense AnsibleHealth hanno scoperto[1] che ChatGPT è in grado di superare il non facile United States Medical Licensing Examination, l’esame per l’ottenimento della licenza medica negli Stati Uniti. Inoltre, la loro ricerca indica che lo ChatGPT potrebbe avere un impatto persino sulla formazione dei medici. Affinché il potenziale di questa tecnologia non vada sprecato, è necessario porre in essere alcuni passaggi miranti a massimizzare le capacità dell’intelligenza artificiale. Tra questi, mantenere un obiettivo orientato al business, dare priorità alle persone, preparare un numero sufficiente di dati “proprietari” e fare investimenti adeguati nell’infrastruttura tecnologica, nell’architettura, nel modello operativo e nella struttura di governance all’interno dei nosocomi e dei centri di ricerca. Tuttavia, la crescita di ChatGPT solleva anche questioni relative alla responsabilità nell’uso dell’intelligenza artificiale, in particolare per quanto riguarda i rischi legali, etici o di reputazione che vi potrebbero essere coinvolti.

Creare controlli di valutazione del rischio nella fase di progettazione, nonché implementare i principi dell’intelligenza artificiale per impostazione predefinita (in attesa di una legislazione in materia al di qua e al di là dell’Atlantico) dovrebbero essere due importanti priorità per le aziende sanitarie che volessero utilizzare strumenti come ChatGPT. Reinventare (o ripensare) i processi per consentire all’intelligenza artificiale di ottenere un “posto di rilievo” è fondamentale, soprattutto in un contesto in cui l’uso di tale tecnologia nel mondo dell’assistenza sanitaria continua a crescere man mano che i ricercatori scoprono i vari modi in cui essa può fornire supporto.

Si pensi che ChatGPT è in grado di rispondere a domande di primo e secondo ordine in linea con il Competency-Based Medical Education (CBME) per la microbiologia[2]. Il CBME è un approccio basato sui risultati finalizzato alla progettazione, l’implementazione e la valutazione dei programmi educativi e per la valutazione dei discenti attraverso un percorso formativo che utilizza determinate competenze o abilità. I ricercatori hanno osservato che uno dei motivi principali per cui è stato condotto questo studio è dovuto alle poche prove a disposizione relative alle capacità di ChatGPT di rispondere a domande di primo e secondo ordine. Questo studio ha coinvolto diversi ricercatori nella preparazione di sei domande in base ad otto moduli prestabiliti. I ricercatori hanno definito le domande di primo ordine come le più semplici e quelle di secondo ordine come le più complesse. Dopo aver verificato la validità dei contenuti e l’inserimento delle domande in ChatGPT, i ricercatori hanno scoperto che tale strumento ha raggiunto un’accuratezza complessiva dell’80%, con differenze limitate nella capacità di rispondere ai due tipi di domande. Questi risultati hanno portato a concludere che ChatGPT è in grado di rispondere a diverse tipologie di domande relative alla microbiologia.[3]

Utilizzo di ChatGPT nella radiologia clinica

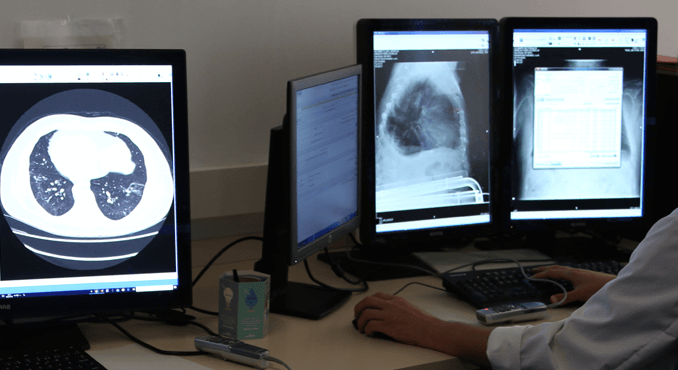

Un articolo pubblicato alcuni mesi fa sul Journal of the American College of Radiology (JACR)[4] ha analizzato i potenziali benefici, le insidie e le implicazioni etiche dell’utilizzo di modelli linguistici di grandi dimensioni (come ChatGPT di OpenAI), nell’ambito della radiologia clinica. Gli autori del documento hanno sottolineato che ChatGPT e altri chatbot alimentati dall’intelligenza artificiale hanno il potenziale per rivoluzionare il mondo della radiologia; l’articolo ha analizzato come queste tecnologie possano servire come strumenti di assistenza per radiologi e medici di altre specialità. I ricercatori hanno, inoltre, evidenziato che ChatGPT e strumenti simili potrebbero supportare il passaggio della radiologia clinica a un modello incentrato sul paziente e aumentare l’assistenza fornita dai radiologi in ospedale.

Gli autori dell’articolo hanno indicato che strumenti come ChatGPT presentano molteplici vantaggi “potenziali”, ben potendo essere utilizzati per fornire ai pazienti referti di diagnostica per immagini accessibili e “semplificati”. Tale tipologia di referti è, in genere, complessa e i medici radiologici hanno spesso il gravoso compito di spiegarli ai pazienti. Una chatbot ben potrebbe utilizzare il referto di imaging più complesso per generare una versione più semplice che, secondo gli autori del documento, potrebbe contribuire a rafforzare l’accesso dei pazienti ai loro documenti sanitari e a migliorare la comprensione delle loro condizioni di salute. Ciò potrebbe, persino, migliorare la soddisfazione da parte dei pazienti dei nosocomi. I ricercatori hanno anche sottolineato che ChatGPT potrebbe fornire assistenza al paziente prima delle procedure di radiologia, rispondendo a domande e fornendo dettagli sulle procedure a cui si sottoporranno, valutando la preparazione del paziente prima di ogni procedura programmata e fornendo al medesimo paziente rassicurazioni e supporto prima della procedura.

Inoltre, chatbot come ChatGPT potrebbero essere utilizzati per contribuire all’istruzione e alla formazione dei radiologi. L’articolo in esame afferma che ChatGPT potrebbe essere addestrato su referti e immagini radiologiche per generare casistiche simulate, che verrebbero, poi, interpretate e studiate dagli specializzandi in radiologia. In questo modo, spiegano gli autori, gli specializzandi potrebbero esercitarsi nell’interpretazione di una maggiore varietà di casi in un ambiente simulato e a “rischio zero” per i pazienti.

ChatGPT per la stesura di articoli scientifici

ChatGPT potrebbe, inoltre, essere utilizzato per generare contenuti e assistere i ricercatori nella stesura di articoli scientifici, aiutando gli autori nella ricerca della letteratura, nell’organizzazione dei contenuti, nella generazione di grafici e tabelle, nell’adattamento dello stile e nella traduzione dei propri articoli in lingue diverse da quella propria. Tuttavia, prima di implementare qualsiasi chatbot in un contesto clinico o di ricerca, le parti interessate devono considerare le limitazioni e le implicazioni etiche che derivano dall’uso di tali sistemi di intelligenza artificiale in campo sanitario. I ricercatori hanno evidenziato diversi problemi legati all’uso di ChatGPT, tra i quali spiccano: la trasparenza sul suo funzionamento, la privacy e la protezione dei dati dei pazienti, le sfide legate all’accuratezza e all’affidabilità, le implicazioni etiche dei contenuti generati dall’intelligenza artificiale nella ricerca e la garanzia che i chatbot non sostituiscano “tout-court” il giudizio e le competenze umane.

Il documento pubblicato sul JACR è stato persino parzialmente scritto dalla stessa ChatGPT, in un’azione che, secondo gli autori, è servita a mettere in mostra le straordinarie capacità della tecnologia in esame.[5]

ChatGPT nella predizione della disabilità e della mortalità

In un articolo pubblicato nel maggio scorso su Cureus, alcuni ricercatori hanno ipotizzato[6] che la combinazione di ChatGPT con le “intuizioni” dello studio “Global Burden of Disease” (programma di ricerca globale sulle malattie che valuta la mortalità e la disabilità dovute a patologie, lesioni e fattori di rischio principali) potrebbe contribuire a creare uno strumento di valutazione e di pianificazione assistito dall’intelligenza artificiale. Utilizzando questo strumento, i medici potrebbero sviluppare piani di cura personalizzati che tengano conto delle preferenze e degli stili di vita dei pazienti. Questo strumento sfrutterebbe i Big Data dello studio Global Burden of Disease, che aiuta a fornire una visione completa della disabilità e della mortalità nel tempo in diversi Paesi, nei diversi generi e nelle diverse età. La ricerca contiene dati significativi su lesioni, fattori di rischio e malattie che portano alla perdita della salute nell’uomo. Lo studio è stato progettato per incorporare sia la prevalenza di un fattore di rischio o di una malattia sia il danno relativo da essa causato.

Con questi dati, i sistemi sanitari possono confrontare i problemi di salute e il loro impatto per migliorare l’assistenza e affrontare le disparità che vi sono all’interno delle varie nazioni. I ricercatori hanno indicato che l’ampio focus dello studio Global Burden of Disease limita la sua utilità per i piani medici personalizzati; ChatGPT, in tal caso, potrebbe essere in grado di aiutare a risolvere questo problema. Il chatbot di OpenAI elabora rapidamente grandi quantità di informazioni, ma la sua precisione e la qualità delle sue risposte – come è noto – dipendono dai dati sui quali si addestra. Utilizzando i grandi volumi di dati di alta qualità presenti sul Global Burden of Disease con ChatGPT, ogni limite in proposito potrebbe essere superato. Dopo aver affrontato adeguatamente queste limitazioni, i ricercatori hanno proposto un modello in cui i medici utilizzano ChatGPT per combinare le informazioni sul Global Burden of Disease con le caratteristiche dei singoli pazienti, col fine di generare piani di cura personalizzati.

Questo potrebbe portare alla creazione di uno strumento di valutazione e di pianificazione unico nel suo genere; tuttavia, gli autori avvertono che ciò richiederebbe una supervisione significativa da parte di esperti, compresi frequenti aggiornamenti basati sui cambiamenti nella letteratura medica o sulle esigenze dei pazienti, nonché una valutazione da parte di esperti per garantire che lo strumento sia accurato e non comporti i pregiudizi “tipici” dell’intelligenza artificiale. Per integrare con successo le ChatGPT con il Global Burden of Disease, gli operatori sanitari e le parti interessate devono adottare un approccio collaborativo, equilibrato e dinamico. Ciò comporta l’incorporazione di entrambe le risorse in un’assistenza personalizzata, valutando al contempo in modo critico ed etico i risultati ottenuti. Riconoscendo i punti di forza e i limiti di ciascun sistema, si otterrà una base migliore per decisioni mediche personalizzate e raccomandazioni sanitarie specifiche. A tal fine, gli autori raccomandano agli operatori sanitari e alle altre parti interessate di rimanere vigili sulle potenziali insidie del modello, come l’accuratezza, la privacy e la capacità di cogliere le “sfumature individuali”.

Conclusioni

Uno strumento del genere potrebbe presentare anche potenziali problemi legati a bias (pregiudizi) di selezione, interoperabilità e definizioni incoerenti. Per combattere queste sfide, i ricercatori hanno affermato che le parti interessate devono fornire una formazione adeguata a coloro che utilizzano lo strumento, garantire equità, accuratezza, trasparenza, conformità ai requisiti etici e legali e promuovere la collaborazione interdisciplinare. Per il futuro, gli autori hanno indicato la necessità di approfondire la ricerca sull’integrazione dei chatbot nell’assistenza sanitaria e su come le nuove funzionalità introdotte da questi strumenti, come la navigazione Internet in diretta o i plug-in, possano essere utilizzate nelle applicazioni cliniche.[7]

Note

- Performance of ChatGPT on USMLE: Potential for AI-assisted medical education using large language models. PLOS. https://journals.plos.org/digitalhealth/article?id=10.1371/journal.pdig.0000198 ↑

- Assessing the Capability of ChatGPT in Answering First- and Second-Order Knowledge Questions on Microbiology as per Competency-Based Medical Education Curriculum. Cureus. https://www.cureus.com/articles/143752-assessing-the-capability-of-chatgpt-in-answering-first–and-second-order-knowledge-questions-on-microbiology-as-per-competency-based-medical-education-curriculum#!/ ↑

- AI, ChatGPT Poised to Potentially Transform Healthcare, Science. HealthITAnalytics.com. https://healthitanalytics.com/news/ai-chatgpt-poised-to-potentially-transform-healthcare-science ↑

- New Horizons: The Potential Role of OpenAI’s ChatGPT in Clinical Radiology. Journal of the American College of Radiology. https://www.jacr.org/article/S1546-1440(23)00259-4/fulltext ↑

- Researchers Highlight Pros and Cons of ChatGPT in Clinical Radiology. HealthITAnalytics.com. https://healthitanalytics.com/news/researchers-highlight-pros-and-cons-of-chatgpt-in-clinical-radiology ↑

- ChatGPT-4 and the Global Burden of Disease Study: Advancing Personalized Healthcare Through Artificial Intelligence in Clinical and Translational Medicine. Cureus. https://www.cureus.com/articles/158585-chatgpt-4-and-the-global-burden-of-disease-study-advancing-personalized-healthcare-through-artificial-intelligence-in-clinical-and-translational-medicine#!/ ↑

- Researchers Propose ChatGPT-Based Personalized Disease Burden Tool. HealthITAnalytics.com. https://healthitanalytics.com/news/researchers-propose-chatgpt-based-personalized-disease-burden-tool ↑