Hugging Face ha presentato un servizio cloud che consente agli sviluppatori di accedere a grandi cluster di calcolo per l’addestramento di modelli linguistici di grandi dimensioni (LLM): “Training Cluster-as-a-Service”. Il servizio del repository open-source offre agli utenti l’accesso alle GPU di Hugging Face, di cui l’azienda dispone a migliaia, tra cui le Nvidia H100 e A100.

Gli sviluppatori possono utilizzare il servizio per addestrare modelli testuali o multimodali che vanno da sette a 70 miliardi di parametri. Gli utenti possono inserire il proprio set di dati o collaborare con Hugging Face per costruirne uno.

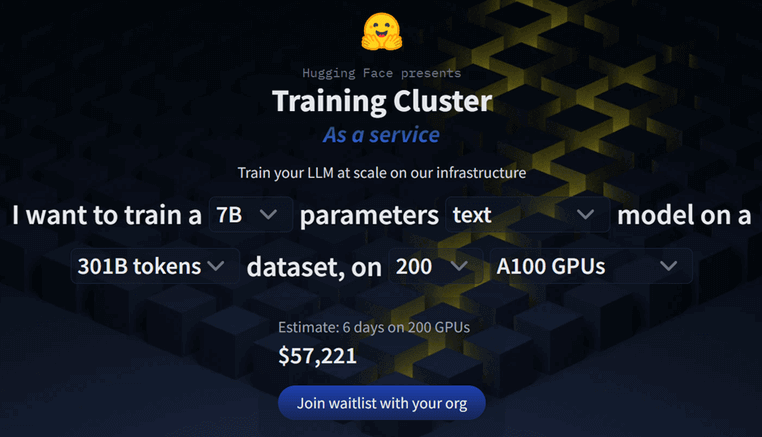

Training Cluster-as-a-Service di Hugging Face dispone anche di un calcolatore dei costi di addestramento. Ad esempio, se si volesse addestrare la versione 7B di Meta Llama 2 su 301 miliardi di token utilizzando 200 GPU Nvidia A100, il costo stimato sarebbe di 57.221 dollari per sei giorni.

Per accedere a Training Cluster-as-a-Service di Hugging Face bisogna iscriversi a una lista di attesa

Per accedere al cluster di formazione Hugging Face-as-a-Service, gli sviluppatori dovranno iscriversi a una lista d’attesa.

Hugging Face ha dichiarato che il nuovo servizio è sicuro, in quanto non memorizza i dati dell’allenamento e gli utenti hanno accesso all’intero risultato dell’allenamento, ai registri e ai checkpoint.

Hugging Face ha molta esperienza nell’addestramento di modelli linguistici di grandi dimensioni, avendo fatto parte del team di BigScience che ha costruito BLOOM e ha rilasciato una serie di modelli propri, tra cui StarCoder (con l’aiuto di Salesforce) e HuggingChat.

Il nuovo Training Cluster-as-a-Service di Hugging Face arriva in un momento in cui l’hardware per la formazione dell’AI sta diventando sempre più scarso. La domanda è salita alle stelle con l’ondata di AI generativa. I governi stanno cercando di acquistare chip per creare centri di formazione nazionali. Nuove startup di AI, come Inflection, stanno utilizzando i loro finanziamenti per acquistare GPU. E le società di venture capital stanno persino sfruttando le connessioni per accaparrarsi chip di AI da offrire alle loro società in portafoglio.

Julien Chaumond, CTO e cofondatore di Hugging Face, ha dichiarato su X (Twitter) che il nuovo servizio consente alle aziende di accedere a hardware scarso. “L’accesso a un grande cluster di calcolo è fondamentale per l’addestramento di modelli su larga scala, ma storicamente è stato difficile assicurarsi l’accesso a un gran numero di acceleratori hardware, anche con un budget elevato”.