OpenAI, la società sostenuta da Microsoft dietro DALL-E e ChatGPT, ha iniziato il 2023 presentando Point-E, un sistema di intelligenza artificiale in grado di generare rappresentazioni di modelli 3D da prompt di testo.

Point-E funziona allo stesso modo dello strumento di immagine di OpenAI DALL-E: basta digitare qualcosa come “un corgi che indossa un cappello da Babbo Natale” e il sistema genererà la risposta, in questo caso, una rappresentazione di un modello 3D.

In un documento, OpenAI afferma che il suo metodo basato sull’intelligenza artificiale per la generazione di oggetti 3D ha prodotto contorni per modelli in soli 1 o 2 minuti su una singola GPU.

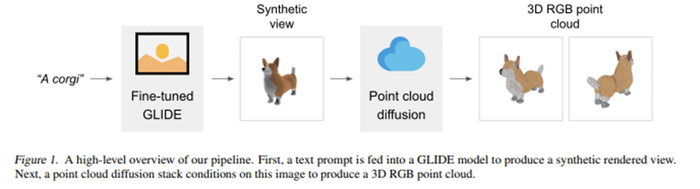

Spiegando il processo, il documento dice: “Il nostro metodo genera prima una singola vista sintetica utilizzando un modello di diffusione da testo a immagine, quindi produce una nuvola di punti 3D utilizzando un secondo modello di diffusione che condiziona l’immagine generata”.

Point-E è composto da due modelli: text-to-image e image-to-3D.

Come funziona Point-E

Per produrre un oggetto 3D da un prompt di testo, Point-E campiona un’immagine utilizzando il modello da testo a immagine; quindi, campiona un oggetto 3D condizionato dall’immagine campionata.

Il modello text-to-image, analogamente al DALL-E di OpenAI, passa prima al setaccio grandi quantità di dati di immagine e testo per abbinare il prompt desiderato, mentre il modello image-to-3D viene addestrato su un set di dati più piccolo di modelli 3D e dati immagine.

Fonte: OpenAI

Secondo OpenAI, entrambi questi passaggi possono essere eseguiti “in una manciata di secondi e non richiedono costose procedure di ottimizzazione”.

Point-E non genera modelli, ma piuttosto viste di punti, che possono essere convertite in una mesh utilizzando i formati di file STL o PLY per creare il modello 3D in piattaforme come Unity, Maya e Blender.

Secondo i ricercatori di OpenAI, Point-E ha il potenziale per “democratizzare la creazione di contenuti 3D per una vasta gamma di applicazioni” tra cui realtà virtuale, giochi e design industriale.

Il team di ricerca di OpenAI ha rilasciato il codice di valutazione e i modelli tramite GitHub. Un esempio di Point-E può essere dimostrato tramite Hugging Face.

Point-E, quali sono i limiti

Il team dietro il metodo di generazione, tuttavia, ha riconosciuto i suoi limiti, ma ha sottolineato il ritmo di Point-E, dicendo: “Mentre il nostro metodo è ancora inferiore allo stato dell’arte in termini di qualità del campione, è uno o due ordini di grandezza più veloce da campionare, offrendo un compromesso pratico per alcuni casi d’uso”.

Point-E non è l’unico strumento basato sull’intelligenza artificiale in grado di generare rappresentazioni di modelli 3D. A ottobre, Google ha presentato DreamFusion, uno strumento di intelligenza artificiale generativa in grado di generare rappresentazioni 3D di oggetti senza dati 3D. DreamFusion utilizza invece immagini 2D di un oggetto generato dal modello di diffusione testo-immagine Imagen per comprendere le diverse prospettive del modello che sta tentando di generare.