Si chiama Gen-1 il nuovo modello di AI video-to-video che può generare nuovi video da quelli esistenti. Lo ha sviluppato Runway ML, il laboratorio di ricerca che ha co-sviluppato il modello text-to-image Stable Diffusion.

Gen-1 è un modello di diffusione video guidato dai contenuti. Modifica i video in base a descrizioni visive o testuali in base all’output desiderato.

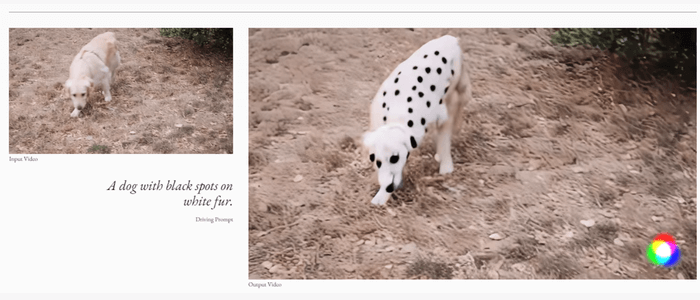

Ad esempio, gli utenti possono caricare il video di un cane con il pelo bianco, digitare il prompt di testo, “un cane con macchie nere sul pelo bianco” e il modello genererà una nuova versione del video esistente con l’output desiderato.

Runway afferma che il suo nuovo modello è simile a “filmare qualcosa di nuovo, senza filmare nulla. Nessuna luce. Nessuna telecamera”, e lo pubblicizza come in grado di generare video mantenendo la qualità e la flessibilità dell’originale.

Secondo Runway, Gen-1 è “in grado di applicare in modo realistico e coerente la composizione e lo stile di un’immagine o di un prompt di testo al video di destinazione”.

Come funziona Gen-1

L’approccio video-to-video è stato ottenuto addestrando congiuntamente il modello su immagini e video. Tali dati di addestramento consentono a Gen-1 di modificare interamente al momento dell’inferenza senza ulteriore formazione o pre-elaborazione per video poiché utilizza immagini di esempio come guida.

Tra i casi d’uso per cui Gen-1 potrebbe essere implementato, secondo Runway, includono la personalizzazione, il rendering e il mascheramento

Attualmente, solo una manciata di utenti invitati ha avuto accesso a Gen-1, anche se Runway è impostato per lanciare pubblicamente il modello in poche settimane. Gli utenti che desiderano accedere a Gen-1 devono iscriversi a una lista d’attesa.

Esiste una versione free, con limitazioni nella risoluzione del video, e versioni a pagamento: Pro a 12 dollari al mese per editor e Team a 28 dollari al mese per editor; entrambe supportano risoluzioni video 4K.

“Runway Research è dedicata alla costruzione di sistemi di intelligenza artificiale multimodali che consentiranno nuove forme di creatività. Gen-1 rappresenta un altro dei nostri passi avanti fondamentali in questa missione”, sostengono i creatori di Stable Diffusion.

Un documento che delinea completamente il modello è disponibile tramite arXiv.

L’intelligenza artificiale generativa per i video non è una novità. Lo scorso settembre, mentre il mondo stava iniziando il suo fascino per i modelli di intelligenza artificiale text-to-image, i ricercatori di Meta hanno presentato Make-A-Video, un sistema di intelligenza artificiale in grado di generare video da prompt di testo. Make-A-Video può anche creare video da immagini o prendere video esistenti e crearne di nuovi.