Con i rischi di allucinazioni, perdita di informazioni sui dati privati e conformità normativa che l’AI deve affrontare, c’è un crescente coro di esperti e fornitori che affermano che c’è una chiara necessità di un qualche tipo di protezione. Ecco allora che alcune aziende stanno progettando firewall e “guardrail” per i dati AI.

Arthur Shield, il firewall per gli LLM

Una delle organizzazioni che sta sviluppando tecnologie per proteggersi dai rischi dei dati AI è Arthur AI, con sede a New York. La società, fondata nel 2018, ha raccolto oltre 60 milioni di dollari fino ad oggi, in gran parte per finanziare la tecnologia di monitoraggio e osservabilità dell’apprendimento automatico. Arthur AI prende il nome da Arthur Samuel, che è in gran parte accreditato per aver coniato il termine “apprendimento automatico” nel 1959 e aver contribuito a sviluppare alcuni dei primi modelli registrati.

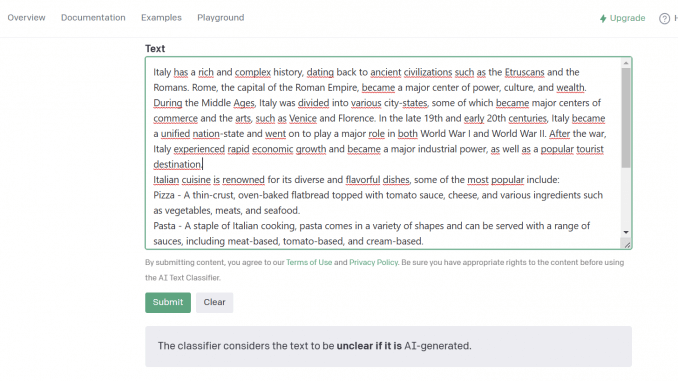

Arthur AI sta facendo un ulteriore passo avanti nella osservabilità AI con il lancio di Arthur Shield, che è essenzialmente un firewall per i dati AI. Con Arthur Shield, le organizzazioni possono implementare un firewall che si trova di fronte a modelli linguistici di grandi dimensioni (LLM) per controllare i dati in entrata e in uscita per potenziali rischi e violazioni delle policy.

“C’è una serie di vettori di attacco e potenziali problemi come la perdita di dati che sono enormi problemi e bloccanti per l’effettiva distribuzione di LLM”, commenta Adam Wenchel, cofondatore e CEO di Arthur AI. “Abbiamo clienti che stanno per implementare LLM, ma sono bloccati in questo momento e stanno usando questo prodotto per sbloccarsi”.

Come funziona il firewall AI

Nel mondo del networking, un firewall è una tecnologia collaudata, che filtra i pacchetti di dati dentro e fuori da una rete.

È lo stesso approccio di base che Arthur Shield sta adottando, solo che lo fa con i prompt che entrano in un LLM e i dati che escono. Wenchel ha notato che alcuni prompt che vengono utilizzati con LLM possono essere abbastanza complicati. I prompt possono includere input di utenti e database, nonché incorporamenti di sideload.

“Quindi stiamo prendendo tutti questi dati diversi, li stiamo concatenando insieme e li stiamo inserendo nel prompt LLM, ottenendo poi una risposta”, spiega Wenchel. “Insieme a questo, ci sono un certo numero di aree in cui è possibile ottenere il modello per inventare cose e allucinazioni e se si costruisce maliziosamente un prompt, è possibile farlo restituendo dati molto sensibili“.

Arthur Shield fornisce una serie di filtri predefiniti che imparano continuamente e possono anche essere personalizzati. Tali filtri sono progettati per bloccare i rischi noti, come i dati potenzialmente sensibili o tossici, dall’immissione o dall’output di un LLM.

Un “guardrail” o un firewall per l’AI?

La sfida di fornire una qualche forma di protezione contro l’output potenzialmente rischioso dell’AI generativa è quella che più fornitori stanno cercando di risolvere.

Nvidia ha recentemente annunciato la sua tecnologia NeMo Guardrails, che fornisce un linguaggio di policy per aiutare a proteggere gli LLM dalla perdita di dati sensibili o da risposte errate allucinate. Wenchel ha commentato che dal suo punto di vista, mentre i guardrail sono interessanti, tendono ad essere più focalizzati sugli sviluppatori.