Nel panorama tecnologico attuale gli strumenti, che abbiamo a disposizione, non sono più sufficienti per risolvere degli specifici problemi con una complessità estremamente complessa, quindi si deve per forza ricorrere a un nuovo modo di vedere e studiare la realtà della fisica, che non è più quella del silicio e dei transistor, si deve indagare e testare se veramente i nuovi hardware fotonici corredati di software con reti neurali siano in grado di fornire dei risultati stupefacenti e inaspettati ma comunque necessari per il nostro futuro. Anche per l’AI si è aperta l’era dei computer quantistici.

Intelligenza artificiale, nel mondo di device e algoritmi quantistici

Il concetto di “entanglement”, definito da Erwin Schrödinger come “la peculiarità della meccanica quantistica”, è basato sul principio di sovrapposizione degli stati e sulla non separabilità degli stati delle parti di un sistema composto. Coppie di fotoni entangled in polarizzazione possono essere create quando un fascio laser attraversa un cristallo non-lineare come il beta borato di bario; il cristallo converte un fotone ultravioletto in due fotoni di energia più bassa (nell’infrarosso vicino), l’uno polarizzato orizzontalmente (cono rosso), l’altro polarizzato verticalmente (cono blu). I fotoni che viaggiano lungo l’intersezione dei due coni non hanno una polarizzazione definita, ma le loro polarizzazioni risultano complementari all’atto della misura. Consideriamo due fotoni entangled in polarizzazione e pensiamo di distribuirli a due utenti, che chiameremo “Alice” e “Bob”, situati a una certa distanza dalla sorgente dei fotoni. Quando Alice esegue una misurazione sul suo fotone per sapere se è polarizzato orizzontalmente o verticalmente, ciascuno dei due risultati è ugualmente probabile. La misurazione da parte di Bob ha la stessa probabilità, ma l’entanglement garantisce che il risultato della sua misura sia anticorrelato a quello ottenuto da Alice: se Alice vede un fotone polarizzato orizzontalmente, Bob lo vede verticale e viceversa; questo a patto che gli apparati di misura siano ruotati dello stesso angolo. Prima che venga effettuata la misurazione, i due fotoni non hanno polarizzazione propria: l’entanglement garantisce che le due misure ottenute siano opposte. La sovrapposizione quantistica quindi il collasso dello stato o funzione d’onda all’atto della misura permettono la generazione di sequenze di bit identiche, a meno di sequenze complementari. Le sequenze, inoltre, sono perfettamente casuali, essendo uguali le probabilità di ottenere una polarizzazione verticale o una polarizzazione orizzontale.

Tuttavia, per garantire l’assoluta sicurezza non basta una sola base, ma occorre che Alice e Bob misurino con due basi di polarizzazione diverse, quindi si ha come si dice in gergo la cosiddetta distillazione della chiave di riconoscimento. Ciascun utente è pertanto equipaggiato con apparecchiature opto-elettroniche atte a rilevare singoli fotoni (single photon avalanche diodes), che etichetta temporalmente (timestamp) per sincronizzare la distillazione, e poi si scegliere casualmente una base (beam splitter) su cui misurare la polarizzazione. Dato che il teorema della meccanica quantistica (no-cloning theorem) stabilisce che non si possono effettuare copie perfette di uno stato quantistico, la seconda rivoluzione quantica avvia anche una nuova produzione di circuiti con porte e connessioni fisiche, che diventano sempre più piccole e presto saranno fatte solo da una manciata di atomi. I fotoni sono insuperabili come Qubit in termini di tempi di decoerenza, mobilità e realizzabilità delle operazioni ad alta fedeltà a singolo Qubit. Finora, gli esperimenti di entanglement in ottica sono stati molto chiari e un processore ottico di tipo quantico avrebbe ovviamente un vantaggio nel collegarsi a una “rete” quantistica, quindi di tipo neurale. Il calcolo quantistico tutto-ottico è diventato possibile quando, nel 2001, vi è stata la svolta nota come lo schema KLM (rif. Knill-Laflamme-Milburn Nature, 409,46,2001), che ha dimostrato che il calcolo quantistico è scalabile ed è possibile utilizzando solo sorgenti a singolo fotone, con rivelatori e circuiti ottici lineari. Quindi i problemi più importanti sono la scalabilità reale dei circuiti quantistici e la capacità di eseguire porte logiche quantistiche con tassi di errore al di sotto della soglia di tolleranza agli errori, con la loro incorporazione su larga scala di circuiti quantistici con risorse fisiche reali e rivelatori a singolo fotone confezionati su un chip ottico. In pratica la matrice ottica riconfigurabile di Mach Zehnder interconnessa fornisce la rappresentazione dello spazio di Hilbert- Schmidt, dove vive di fatto il calcolo quantistico. Questo sistema integrato su chip può essere sia fotonico che plasmonico (rif. II). Sfruttando questa idea siamo in grado di ottenere tutte le porte quantistiche universali come Swap, Cnot, Cphase, Toffoli per due qubit e per casi multiqubit. L’obiettivo più importante è la possibilità di eseguire deterministiche misurazioni della campana: negli schemi ottici usuali la probabilità di successo delle misurazioni della campana è ½, mentre la nuova architettura offre la possibilità di discriminare tutti gli stati di Bell, in modo che la teoria del “teleportation” possa diventare completamente deterministica (rif. I e III).

Deep learning e computer quantistici

In realtà nell’ambito dei calcolatori quantistici l’AI, che è una metodologia ovvero una disciplina per la soluzione anche di problemi di categoria data-driven, che fa uso di architetture deep, assume l’accezione di “Deep learning”. Quindi considerando implementazioni di architetture in fase di inferenza, l’hardware può essere costituito da porte quantistiche universali come Swap, Cnot, Cphase, Toffoli lavorano in modalità parallela e non sequenziale come le porte logiche AND, NOT o NAND dei registri dei calcolatori classici costruiti con transistor e microchip di silicio.

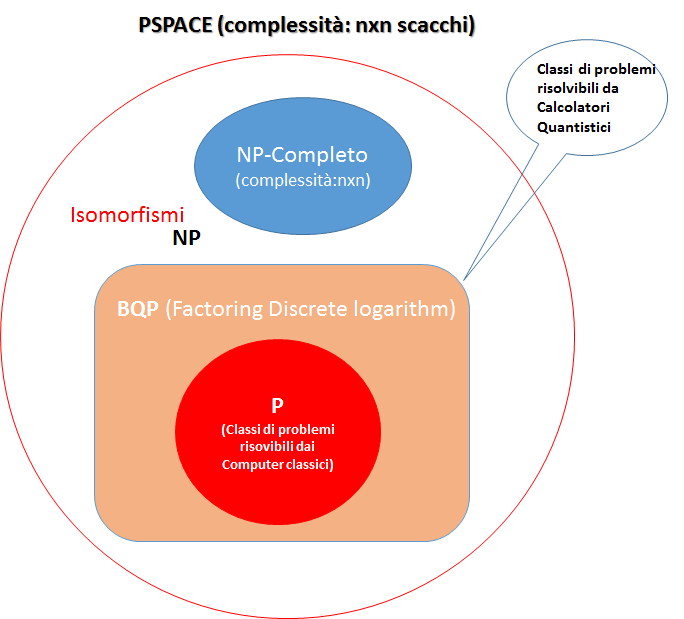

Il mondo della fisica quantistica oltre all’hardware ha generato anche lo sviluppo degli algoritmi quantistici, ad esempio Deutsch-Jozsa, Grover, Simon, Shor, hanno portato all’introduzione di una nuova classe di complessità dei problemi, che è identificata con la sigla BQP (codice ISO639-3, classe di complessità comprendente i problemi risolubili in tempo polinomiale da un elaboratore di tipo quantistico), che contiene tutti i problemi, che sono risolvibili efficientemente con una macchina quantistica, infatti non scontato che in assoluto un algoritmo quantistico sia più efficiente per risolvere il problema, dipende dalla sua tipologia di complessità.

Potrebbe essere che un classico algoritmo sequenziale in determinati ambiti sia più efficiente, di algoritmo che utilizza la logica quantistica. Si deve capire dove collocare questa classe di problemi che sono risolti tramite la logica quantistica che opera in modalità trasversale rispetto alla sequenzialità degli algoritmi classici. Si sono trattati tramite una carrellata di algoritmi quantistici, studiati a livello accademico, gli eventuali limiti intrinseci della tipologia di calcolo quantistico, che è legata storicamente alla Macchina di Turing (MdT) ed al calcolo probabilistico, vedendo se si possono effettivamente a livello teorico superare i limiti del calcolo classico degli elaboratori. Quindi una macchina quantistica in linea teorica è in grado di replicare il funzionamento di una macchina classica e risolvere delle tipologie di problemi molto più velocemente di un computer classico. Esistono però dei limiti legati alla natura squisitamente probabilistica della meccanica quantistica. Un registro si può trovare in una qualsiasi sovrapposizione dello stato zero e dello stato , perché ci sono i fenomeni di interferenza quantistica, in ogni caso la misura dello stato del Qubit fornirà il valore o il valore con una certa probabilità, quindi è necessario sviluppare tecniche risolutive diverse a seconda del problema. Esistono problemi di carattere applicativo, come la scelta del miglior sistema adatto a rappresentare i Qubits ed i fenomeni di decoerenza quantistica dovuti all’interazione del registro con l’ambiente circostante. Degli studiosi affermano che confrontare l’ambito classico e quello quantistico non sia possibile in quanto hanno dinamiche fisiche e strutturali di calcolo completamente diverse. Per capire gli eventuali vantaggi di un calcolatore quantistico si deve tenere presente la Macchina di Turing classica, in questo caso si riescono ad apprezzare anche i benefici degli algoritmi di tipo quantistico.

Machine learning e computing versus deep learning e reti neurali

Il potenziale dell’AI è tanto più dirompente quanto più è sviluppato l’ecosistema tecnologico e umano nel quale si sviluppano e si implementano gli algoritmi, che costituiscono l’insieme aperto degli algoritmi data driven, ossia il “Machine Learning”.

Il “Machine Learning”, secondo Tom Mitchel, si può capire andando ad analizzare le domande, a cui tentano di rispondere le tecnologie di computing e statistica. Il “Machine Learning” di fatto è un insieme di algoritmi, che impara dai dati e arriva a un output senza delle regole predefinite all’inizio del percorso, come accade per gli algoritmi classici, che eseguono un flusso logico costituito da operatori booleani. Quindi il “Machine Learning” è un approccio software per scoprire associazioni e pattern tra dati in una modalità trasversale, che utilizza “reti shallow”. Esistono diversi tipi di algoritmi generali, che permettono al software di apprendere in modalità: supervised, unsupervised, reinforcement algorithms.

Invece il “Deep learning” si riferisce a un apprendimento automatico, che si basa sull’organizzazione complessa di reti concettuali, quindi si basa su reti neurali profonde (deep neural network), ossia le reti neurali con due o più strati intermedi (hidden layers).

Le reti neurali Deep Learning (apprendimento profondo), diverse dalle Shallow Learning (apprendimento superficiale) usate per il Machine Learning, rappresentano reti di fattori o concetti sempre più astratti, che sono così complesse che possono includere svariati milioni di connessioni tra i nodi, neuroni artificiali, in questo caso si ha una modalità di progressione in parallelo, che è simile alla modalità di funzionamento del cervello umano, ossia in uno scenario del genere non si ha più un input, che produce un output attraversando un algoritmo con un flusso sequenziale. Quindi a differenza della programmazione tradizionale, la rete neurale viene addestrata da molti esempi di dati di input che corrispondono a dati di output. Una volta che la rete ha imparato è in grado di dare risposte (dati di output) a fronte di dati di input anche mai visti in fase di addestramento. E proprio la capacità di scovare i legami più profondi, i trend non evidenti, le relazioni indirette tra i record è oggi messa a dura a prova. In un contesto di network come quello attuale in cui i dati proliferano e si moltiplicano, appare quasi impossibile capire quali sono quelli rilevanti, quelli che nel mondo anglosassone si chiamano “right data”, senza il supporto di tecnologie adeguate. Tecnologie come il “Machine Learning”, che è divenuto un sostegno fondamentale per gli approcci decisionali di tipo “data driven” è un elemento essenziale delle advanced analytics, per tale motivo con il “decision making” ci si avvicina al parallellismo strutturale dei percorsi, che è peculiare del pensiero umano. In tale contesto il “Machine Learning” si lega al business intelligence, che sfocia in tecnologie come la blockchain.

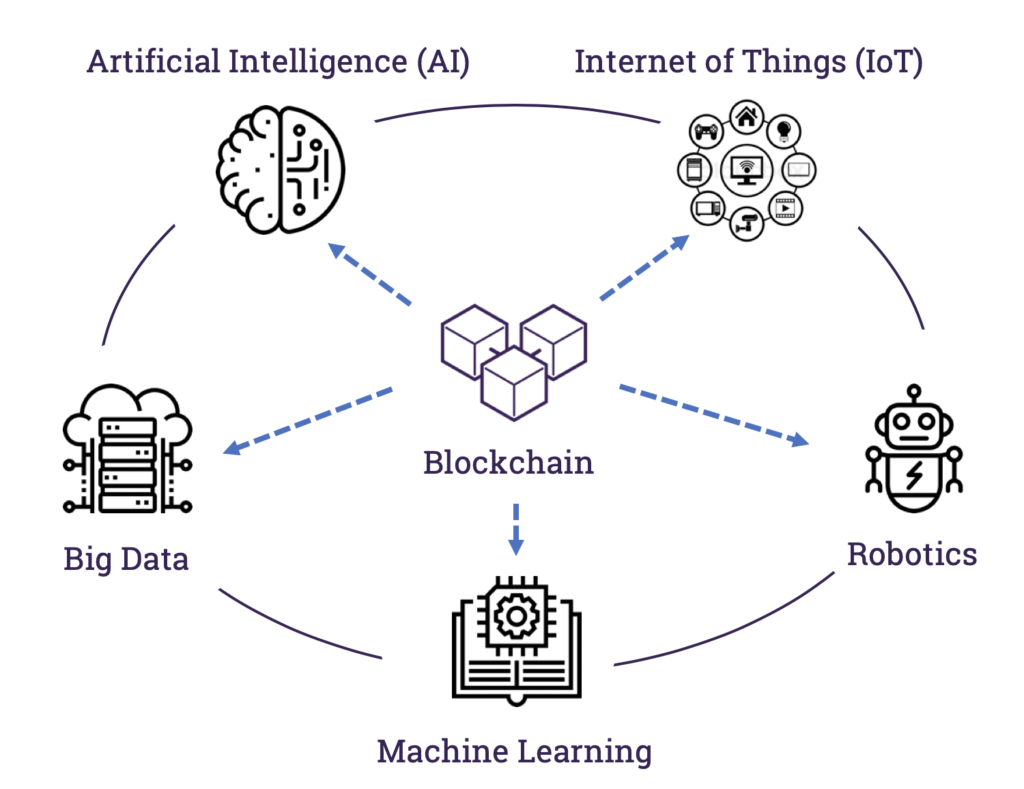

Analizzare l’AI senza tener conto delle tecnologie a essa complementari sarebbe riduttivo e fuorviante. Sarebbe come giudicare un’automobile solo dalla potenza del suo motore, senza evidenziare tutti gli altri elementi. Il progresso riscontrato nelle applicazioni di AI nell’ultimo decennio non è solo dovuto all’avanzamento della ricerca nello specifico campo dell’AI, ma è anche il risultano del progresso ottenuto a livello mondiale relativamente alle performance delle unità di elaborazione sia di calcolo sia di elaborazione grafica (GPU), inoltre sono attivamente coinvolte nel processo le tecnologie di banda larga fissa e mobile, nella nanotecnologia e nell’Internet of Things (IoT).

Considerando che problemi di apprendimento complessi per il “Machine Learning”, nonché per il Deep Learning, potrebbero essere implementati in modo efficace su macchine quantistiche, attualmente la D-Wave sta costruendo dei prototipi, che sono stati anche acquistati dalla NASA, che collabora con Google. Tralasciando le possibili applicazioni nel ramo della crittografia, si può ragionevolmente pensare che i fenomeni quantistici possono essere sfruttati per realizzare macchine in grado di apprendere in modalità “Deep Learning”, usando reti neurali Deep, che potrebbero essere incredibilmente utili nella risoluzione di problemi complessi come il riconoscimento di immagini o del parlato (speech recognition, che è disponibile anche a livello consumer dal 2012), una traduzione linguistica simultanea o l’analisi genomica di laboratorio, considerando eventuali ricerche scientifiche come la ricostruzione delle catene strutturali virologiche.

Algoritmi quantistici e AI: lo stato dell’arte

L’AI non potrà svilupparsi appieno, né in Italia, né altrove, se gli altri elementi di questo ecosistema non saranno considerati in modo appropriato e sostenuti. In un ecosistema tecnologico, il potenziale complessivo è definito dall’anello più debole, quindi un insufficiente sviluppo dell’Internet of Things (IoT) o della connettività a banda larga fissa e mobile può depauperare in modo sostanziale l’impatto dell’AI sul tessuto imprenditoriale e sociale del Paese.

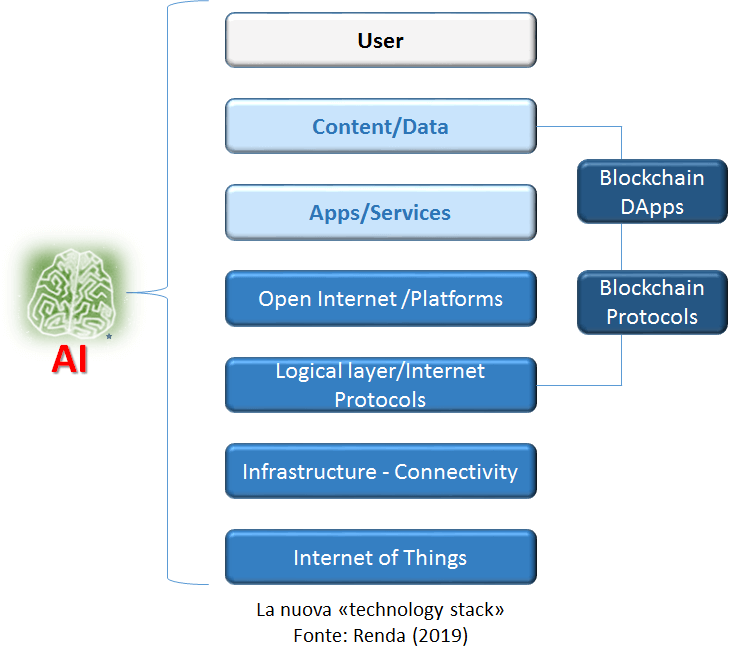

Nello specifico esistono fortissime sinergie tra AI ed i vari elementi della technology stack.

Con la diffusione delle tecnologie legate alla distributed ledger technologies, di cui ad esempio la blockchain è un caso specifico, avere una tecnologia che promette costi computazionali ineguagliabili porterebbe a veri propri salti nel futuro, anche se per ora si deve per distinguere dove veramente sono applicabili queste tecnologie quantistiche, che promettono scenari rivoluzionari.

Recentemente in un intervista di giugno 2020 a Tommaso Calarco, direttore del Centro di Controllo Quantistico di Jülich in Germania, si sottolinea che il mondo della tecnologia quantistica è in rapida evoluzione e si arriverà presto anche alla mappatura del genoma umano, anche se precisa che la biodiversità è di importanza fondamentale per la società, per cui ci deve essere una vigilanza degli sviluppi tecnologici relativamente alla sensoristica, alle comunicazioni sicure, alla diagnostica ed alla computazione quantistica (rif.III). Ci saranno fibre ottiche e transistor con migliaia di elettroni e fotoni con campi di applicazione delle tecnologie quantistica, invece di avere transistor con elettroni che producono bit con zeri ed uni, nella tecnologia quantistica si avrà un fotone alla volta, il QBIT, che non è copiabile e non è intercettabile. Oggi la crittografia di WhatsApp ad esempio è a tempo, mentre per la sicurezza dei dati a livello dei governi si devono eseguire delle comunicazioni non spiabili, quindi con singolo fotone, che si potrebbe assimilare a un piccolo magnetino. Nel cervello un neurone è come un magnetino che si accende e si spenge, quindi si potrebbero eseguire delle diagnosi accurate del sistema nervoso tramite un singolo fotone come elettrone. Attualmente in Germania si sta sviluppando il progetto Bosh con sensori quantistici per leggere il percorso celebrale nei prossimi 10/15 anni, per soggetti che hanno problemi di comunicazione.

Per sviluppare le comunicazioni con fotoni singoli servono collegamenti in fibra ottica, quindi per comunicazioni sicure tra le città europee, l’Italia è in prima linea con Galileo ed il CNR, c’è un budget messo a disposizione dalla commissione europea (EuroQCI).

Tramite le nuove frontiere della computazione quantistica, si potrebbero sviluppare nuove medicine e vaccini senza fare test, tramite un simulatore quantistico, però ci vorranno almeno dai dieci ai venti anni per i vaccini, fertilizzanti o l’ideazione di nuovi materiali. Relativamente alla “AI” i computer quantistici daranno una grande accelerata per tale sviluppo tecnologico. Per gli algoritmi c’è ancora molta ricerca scientifica, che deve essere svolta per svilupparli al meglio al servizio dei cittadini. Ci vorrà un arco temporale della durata di cinque o sette anni per sapere realmente se il computer quantistico funzionerà e sarà più potente di qualsiasi calcolatore classico.

Conclusioni

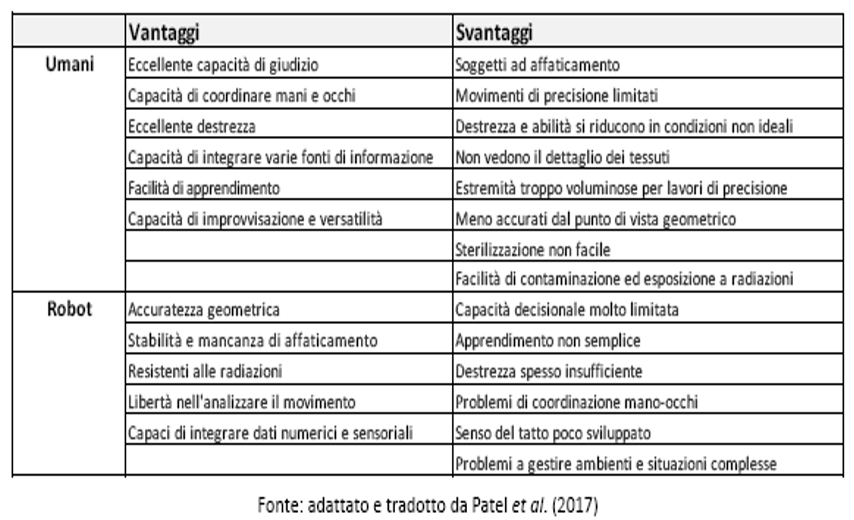

Concludendo, l’AI dipende prevalentemente dalla componente umana, e dunque dalla capacità e dalla competenza dei soggetti che sviluppano, implementano e utilizzano gli algoritmi. Tali competenze non sono soltanto quelle tecniche, di coding o prettamente scientifiche come le STEM (scienza, tecnologia, ingegneria, matematica). Se si vuole una diffusione dell’AI antropocentrica, è necessario che le competenze umane siano complementari alle capacità delle macchine, e che gli individui si specializzino in tutte quelle attività nelle quali l’essere umano è ancora superiore alla macchina, per cui nelle attività, che consistono nel saper utilizzare la macchina al meglio.

Di seguito una tabella in cui sono elencati i punti di forza e debolezza rispettivamente di umani e robot:

Concludendo la tecnica di AI maggiormente in crescita è quella del “Machine Learning”, che richiede una significativa quantità di dati annotati, inoltre tali dati spesso non sono “liberi”, ma detenuti da soggetti, come grandi piattaforme on-line, che da qualcuno sono definite “superstar firm”, vedi Facebook e WhatsApp, che hanno centinaia di milioni di utenti in tutto il mondo.

Le dimensioni di tali imprese superstar ha conseguente rilevanti anche per l’AI, in quanto hanno il materiale (Big Data), su cui sviluppare il “Machine Learning”, nessuno attualmente può eguagliare la disponibilità dei dati del settore privato, per cui combinando tale realtà con una tecnologia quantistica, che promette una velocità ad ora non attuabile, si avrebbe il famoso “salto tecnologico” nell’era del quantum computing, dei computer quantistici, e delle reti neurali Deep, che per ora si tratta di tecnologie futuriste non ancora totalmente mature per l’environment tecnologico attuale, che in pratica prometterebbe di avvicinarsi al tipo di funzionamento in modalità parallela, che è utilizzata dalle sinapsi del cervello umano.

Reference:

- INTRASYSTEM ENTANGLEMENT GENERATOR AND UNAMBIGUOS BELL STATES DISCRIMINATOR ON CHIP (2019) Author: Fabio Antonio Bovino ©2019 IEEE Department SBAI, SAPIENZA University of Rome via Antonio Scarpa 14/16, 00161, Rome May 2019 [https://ieeexplore.ieee.org/document/8683820/]

- On Chip IntraSystem Quantum Entangled States Generator (2017) Author: Fabio Antonio Bovino Quantum Technologies Lab, LEONARDO –Finmeccanica Piazza MonteGrappa n.4 – 00195 Roma (ITALY) [https://ieeexplore.ieee.org/document/8086532/]

- STRUCTURE AND METHOD FOR PROCESSING QUANTUM INFORMATION – EP3109803 – 2016 Inventor: Fabio Antonio Bovino Quantum Technologies Lab, LEONARDO [https://worldwide.espacenet.com/publicationDetails/biblio?II=2&ND=3&adjacent=true&locale=en_EP&FT=D&date=20161228&CC=EP&NR=3109803A1&KC=A1]

- Realismo e località: teoremi di Bell e “gioco” CHSH Matteo G. A. Paris Applied Quantum Mechanics Group Dipartimento di Fisica, Università degli Studi di Milano, Italy;

- THE IMPACT OF QUANTUM TECHNOLOGIES ON THE EU’S FUTURE POLICIES (2018), Adam M. Lewis, AML Martino Travagnin, MT 2018;

- Realismo e località: teoremi di Bell e “gioco” CHSH Matteo G. A. Paris Applied Quantum Mechanics Group Dipartimento di Fisica, Università degli Studi di Milano, Italy;

- Nonlocality & Communication Complexity, Wim van Dam Wolfson College Centre for Quantum Computation Department of Physics, University of Oxford;

- J.Millman, A.Grabel, Microelettronica;

- Scott Aaronson, Simon Benjamin, oxfordquantum Quantum Complexity Theory, Fall 2010. (Massachusetts Institute of Technology: MIT OpenCourseWare).org/stories/, 2014;

- John von Neumann, First Draft of a Report on the EDVAC, 1945.

- Intervista Tommaso Calarco – Direttore Centro di Controllo Quantistico di Julric in Germania del 17 giugno 2020;

- Algoritmo Deutsch Jozsa (“Rapid solution of problems by quantum computation” nel 1992): risolve il problema D.J. con un’unica valutazione di Uf (Richard Cleve, Artur Ekert, Chiara Macchiavello e Michele Mosca nel 1998)

- David Deutsch (1985) un articolo intitolato “Quantum theory, the Church-Turing principle and the universal quantum computer”

- Principles of Quantum Computation and Information-Volume I: Basic Concepts (G Benenti, G Casati, G Strini – 2004)

- Algoritmo di ricerca di Grover e General Problem Solver (o G.P.S.) (Programma per computer creato nel 1957 da H. A. Simon, J. C. Shaw e Allen Newell)

- “A scheme for efficient quantum computation with linear optics” (E. Knill, R. Laflamme & G. J. Milburn, Nature volume 409, pages 46–52(2001)

- Philip Kaye, Raymond Laflamme, Michele Mosca “An introduction to quantum computing”

- “Direct Measurement of Nonlinear Properties of Bipartite Quantum States” Fabio Antonio Bovino, Giuseppe Castagnoli, Artur Ekert, Paweł Horodecki, Carolina Moura Alves, and Alexander Vladimir Sergienko Phys. Rev. Lett. 95, 240407 – Published 9 December 2005

- Cenni: P. W. Shor Algorithms for quantum computation: Discrete log and factoring, 1994 (https://ieeexplore.ieee.org/abstract/document/365700) (R. Crandall, C.Pomerance Prime Numbers: A Computational perspective, 2001)