La voce, un’onda che attraversa lo spazio e il tempo, uno spostamento d’aria che vibra su diverse frequenze per generare timbri, emozioni, cadenze, accenti, sempre diversi. L’unica definizione disponibile, fino a qualche anno fa. Con il progressivo avvento dell’intelligenza artificiale, ora siamo in presenza del Voice cloning basato su Deep Learning. Vediamo di cosa si tratta

Gli esordi: il digital cloning

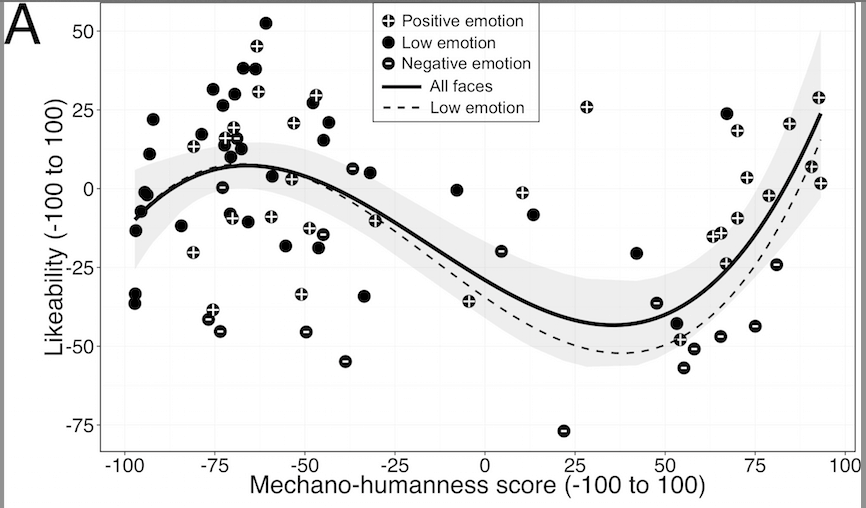

Nel 1970, lo studioso nipponico di robotica Mashito Mori, pubblica sulla rivista Energy “Uncanny Valley” uno studio sul rapporto tra verosimiglianza antropomorfica e accettazione emozionale verso i robot. Il prof. Mori dipinge su un grafico cartesiano la nostra inclinazione ad accettare di buon grado istruzioni da un robot molto simile a una persona, e più malamente istruzioni da un robot pixellato appena fuggito da Minecraft.

Apprendiamo che gli studi sul digital cloning vengono avviati oltre 50 anni fa. Dal lavoro di Mori a oggi sono stati fatti molti passi avanti sia nella teoria che nella tecnica. In particolare, la capacità computazionale delle GPU e l’ormai straripante applicazione delle tecniche di Deep Learning hanno reso possibile raggiungere un ottimo livello di realismo sul task di Voice cloning. L’attenzione dei media, alcuni fatti rilevanti che hanno fatto discutere la stampa e l’opinione pubblica internazionale, nonché le possibili applicazioni malevole della tecnologia hanno provveduto al resto, attivando così una leva potente, quella della curiosità.

Voice cloning, come funziona

Fisica e matematica sono sottostanti al processo di generazione della voce. Flusso, pressione, portata, cavità, risonanza e formanti generano un modello matematico di vibrazione e spostamento dell’aria, in fisica lo definiamo anche suono, al nostro orecchio lo definiamo anche voce. Il prof. Yoshua Benjo ha fornito gli strumenti per affrontare questi problemi con l’intelligenza artificiale, con il suo ramo più costoso e pesante, il Deep learning, dunque, diverse aziende hanno implementato soluzioni di Voice cloning a intelligenza artificiale. In sostanza, con questa tecnica si può ricreare una voce sintetica del tutto simile all’originale.

Per realizzare il voice cloning si utilizzano due componenti principali, un motore TTS (Text To Speech) e un vocoder. Il motore TTS è quello che, dato un testo, lo divide e lo rappresenta in fonemi. Un fonema corrisponde all’unità logica alla base della produzione di un suono, in molti casi corrisponde anche a una specifica lettera o carattere, ma non sempre e non necessariamente in modo univoco. La “pésca” come sport e la “pèsca” come frutto contengono entrambi la lettera “e”, ma con fonemi diversi caratterizzati dalla differenza di accento. Il vocoder è invece il componente ad AI che applica lo stile del clone ai fonemi generati e letti dal sistema TTS. Il vocoder lavora sullo spettro e sulle formanti di ogni singolo fonema, modificando ed alterando l’influenza spettrale al fine di renderla compatibile con il clone che si intende eseguire.

Senza scendere in un dettaglio tecnico implementativo, il vocoder necessita di training Deep Learning. Molte ore di calcolo GPU e molta corrente elettrica possono creare un vocoder estremamente preciso e sofisticato. Il materiale di training è costituito da un corpus “voce e testo” del clone da eseguire, si può partire da pochi minuti o pochi secondi di audio a salire per realizzare un clone, dipende molto dal livello di precisione ricercato e dalla finalità per cui si esegue il clone. Il risultato finale è un vocoder, ovvero un modello ad AI che utilizza tecniche di Deep learning, in grado di adattare l’output del sistema TTS alla voce del clone ricercato.

Per applicazioni che richiedano qualità cinema o videogame, il training può essere eseguito anche sul TTS e direttamente sulla voce del clone, questo al fine di aumentare la verosimiglianza del risultato sintetico rispetto alla realtà. La realizzazione di un modello TTS from scratch richiede però centinaia di ore di materiale di training “voce e testo” e la giustapposizione di tutti i fonemi disponibili nella lingua del clone. Per chi ha confidenza con la matematica sarà facile intuire come il numero di permutazioni dei fonemi all’interno di un linguaggio ha una tendenza esponenziale.

Voice cloning, problemi e opportunità

Illustrato il percorso storico che ci ha regalato questa tecnologia e assaggiata la tecnica che la rende possibile, bisogna fare i conti con i problemi e con le opportunità che la tecnologia offre. Indubbiamente l’effetto WoW è pressoché garantito da un buon vocoder Deep learning. Analizziamo alcuni degli impatti che porta con sé.

Tra le applicazioni positive troviamo certamente quella di poter tradurre un corso on-line in qualunque lingua del mondo, con un effetto molto umano e naturale, così come accade ai robot costruiti bene nel grafico di Mashito Mori. Per chi segue un corso, poter ascoltare una voce naturale è importante, certamente non perturba l’attenzione dell’allievo come accadrebbe invece se il corso fosse tenuto da un personaggio o da una figura con la voce di una “Alexa guasta”.

Nelle arti, al fine di costruire la digital immortality o al fine di generare nuovi contenuti, la tecnologia del Voice cloning può rendere possibile la creazione di contenuti che includano la voce di un attore del passato. I fan dell’attore andranno in visibilio e ringrazieranno la produzione per questo sforzo.

Ma possono accadere anche cose spiacevoli in questo processo. Un attaccante che abbia per obiettivo la disinformazione potrebbe generare il Voice cloning di una figura politica che insulti o derida la controparte al fine di destabilizzare la situazione corrente.

Sistemi non molto sicuri che impieghino l’autenticazione biometrica basata su voice-fingerprinting potrebbero essere tratti in inganno e ignari, autenticare un clone in luogo della supposta persona reale che si stia identificando. L’uomo del call center o la mamma sono solo alcuni esempi di questi sistemi poco sicuri che tendono a fidarsi della voce altrui senza ricorrere a ulteriori sistemi di autenticazione forte.

Nel diritto è ormai entrato, soprattutto per le utilities, il “contratto telefonico”, ovvero quella procedura che registra un operatore e un cliente che eseguono un contratto mediante proprio l’utilizzo della loro voce. Ecco che un’opportunità può tramutarsi anche in un rischio all’epoca dell’AI.

A ciò si aggiungono le svariate implicazioni etiche della riproduzione non autorizzata, della riproduzione fuori contesto e delle eventuali autorizzazioni che bisognerebbe richiedere sia a chi presti la voce al clone, sia a chi l’ascolterà forse non essendo a conoscenza della natura sintetica del contenuto.

The “dupe effect”

Seppur intervengano anche leggi e normative, diverse da paese a paese e da continente a continente, un aspetto che va sottolineato è quello del duping verso l’audience. Immaginando un utilizzo su larga scala della tecnologia (fatto che a dire il vero che non dobbiamo attenderci così distante), io spettatore facente parte di un’audience diffusa, potrei trovarmi al cinema, o potrei fruire un’altra tipologia di contenuto e chiedermi assiduamente se stia ascoltando un originale in carne e ossa, piuttosto che un clone sintetico. Ammettendo di dover essere in qualche modo avvisato, chi e quando dovrebbe farlo? Con quali modalità? Dunque, in uno scenario di utilizzo massiccio della tecnologia, lo spettatore potrebbe sentirsi ingannato (duped) in ogni momento o portato a credere di esserlo anche in una situazione genuina, magari da un semplice glitch di riproduzione ambientale.

La psicologia sociale ci insegna come gli effetti sulla massa siano amplificati. Un ascoltatore che abbia il dubbio sulla genuinità del parlatore potrebbe maturare quindi il dubbio anche sul contenuto che si sta trasmettendo. Se nei prossimi messaggi di fine anno il nostro Presidente della Repubblica ci parlasse dell’importanza della vaccinazione Covid e gran parte di noi pensasse che si tratti di una trasmissione fake, generata da un gruppo eversivo a favore della “dittatura sanitaria”, cosa accadrebbe? Instillare un semplice dubbio, in masse di persone, può essere molto pericoloso.

L’industria dell’AI cloning

Grandi e piccole aziende si sono avventurate sul percorso del Voice cloning e sulla generazione di audio basato su costruzioni Neural voices. Dagli Usa a Israele, passando per l’Asia, molti players hanno compreso le potenzialità della tecnologia e stanno investendo nella sua realizzazione, talvolta a testa bassa puntando ai risultati, talvolta cercando l’effetto mediatico prodotto dalla “resurrezione dei morti” o dal deep fake che spopola sui social. Ecco alcuni esempi.

La compagnia Descript ha utilizzato la voce dell’indimenticato Anthony Baurdain per creare un clone da inserire all’interno di un documentario. Il successo mediatico dell’operazione sta ancora combattendo con l’etichetta distopica affidata da molti commenti social e una causa con gli eredi del noto personaggio televisivo.

La compagnia Lyrebird è ancora alle prese con diverse azioni legali in California per le accuse di identity theft and impersonation ricevute a seguito della pubblicazione di un software di AI cloning.

Il panorama è affollato anche da altre aziende come Resemble AI, Respeecher, Murf AI ed altre.

Casi eclatanti e processi ancora in corso trascurando, la differenza tra queste aziende non la fa molto la tecnologia sottostante, quanto il framework legislativo a cui esse rispondono e i processi che dunque esse plasmano per il controllo e l’utilizzo di questa potente tecnologia. La fiducia che possiamo profondere nell’industria del AI Voice cloning dipende strettamente dalle norme e dalle pratiche etiche che gli attori produttivi rispettano nella sua erogazione; ecco, dunque, che un’azienda di diritto italiano deve essere molto accorta nella realizzazione e nella somministrazione di contenuti AI generated, cosa che invece un’azienda del far east può svolgere con ben maggiore disinvoltura e “rischio”.

Voice cloning, gadget o tecnologia socialmente utile?

Il Voice cloning è una tecnologia, il suo utilizzo e le finalità per cui viene utilizzata ne determinano il risvolto etico e l’impatto sociale atteso. Il dibattito sull’intelligenza artificiale e sulle sue caratteristiche etiche imperversa tra catastrofisti e tecno-entusiasti il cui rapporto dialogico riempie le pagine delle riviste e la fantasia delle persone che si informano sui social network.

Oggi il Voice cloning ad AI può apparire come un’applicazione ludica dai fini commerciali e frivoli, intrattenimento sintetico per fare scherzi agli amici; potremmo pensare che al pari dei filtri Instagram per le foto, a breve i social network forniranno filtri vocali per la voce e ancora avanti su questa linea. Bisogna però pensare alle persone che hanno perso l’uso della voce e che oggi possono riaverne una sintetica, molto somigliante alla loro, grazie a questa tecnologia; all’importanza di una voce molto umana che fornisce istruzioni in luogo di un robot glitchato che gracchia in ambienti dove la concentrazione di chi ascolta è un fattore importante. Un giorno potremmo aver bisogno di questa tecnologia per scopi o opportunità che non ancora conosciamo.

Video: What is voice cloning? (in inglese)

What’s next

L’AI è già tra noi, in vari modi e in varie forme. L’AI è matematica che modella la realtà che percepiamo e in quanto tale, può anche riprodurne le sfaccettature in un ambiente sintetico. Oltre i principi fisici che regolano la creazione della voce nel corpo umano, oltre le applicazioni di TTS e vocoder che disegnano formanti e oltre i problemi giudiziari e regolatori che contornano il fenomeno dell’intelligenza artificiale, non è forse corretto dipingere un futuro catastrofico o roseo su tecnologie che stiamo ancora sperimentando e realizzando. Forse faremo a meno dell’AI Voice cloning, o forse diventerà normale per tutti comunicare con voci sintetiche da cambiare a seconda dell’occasione. Nel prossimo immediato futuro, un videogame potrebbe completare l’installazione e chiederci di fornirgli la nostra voce per “cucirla” su un personaggio del gioco. A breve, tra il macabro e il malinconico, potremmo forse a breve dialogare con un caro estinto, in una illusione sintetica molto sofisticata. Per ora, probabilmente la nostra carta migliore è quella dell’osservazione e del ragionamento, trascurando la fanta-AI.

Il task di AI Voice Cloning si trova in questo momento a un livello così avanzato che si è già alzata l’asticella. I gruppi di lavoro nell’ambito della ricerca si stanno concentrando su nuove frontiere di applicazione, come quella di “trasferimento dello stile” o dell’espressività neurale. Il trasferimento di stile, nell’ambito della produzione di voci sintetiche corrisponde alla capacità di una rete neurale di acquisire il parlato di due persone, di cui una sorgente e una target, e generare una nuova voce che parli come la prima (ovvero che erediti dalla prima il motore TTS) ma con la cadenza della seconda (ovvero che implementi un vocoder sulla seconda). L’espressività neurale è invece la capacità di una rete neurale di prendere un modello di Voice cloning e aggiungervi i parametri di espressività, al fine di generare nuovi contenuti vocali che possano sembrare felici, tristi, trionfanti o solenni.