AI e composizione automatica della musica: la storia degli ultimi cinque decenni colpisce per l’impressionante numero e varietà di sistemi sviluppati per affrontare quasi ogni sfaccettatura del processo di composizione, dall’armonia al contrappunto. A partire dagli anni Cinquanta (è del 1958 Illiac Suite, scritta da Hiller e Isaacson grazie alla composizione assistita), centinaia di ricercatori hanno applicato gli strumenti dell’intelligenza artificiale ad aspetti specifici della composizione musicale, con una varietà di tecniche che ricalca da vicino l’evolversi della disciplina nell’arco di mezzo secolo. Senza considerare l’ambito, altrettanto fiorente, della composizione assistita dal computer (Computer-Aided Algorithmic Composition, CAAC), oggi integrata nei prodotti commerciali, dallo storico Max al più recente Ableton Live. Un quadro di riferimento specifico, che tuttavia meriterebbe una trattazione a parte, è dato dalla relazione con gli altri media, dalla sonificazione dei videogame (Yannakakis e Liapis 2015[1]) alla performance interattiva (Camurri, 2013[2]).

L’AI applicata alla composizione automatica della musica

Nonostante sia impossibile tracciare confini rigidi nell’uso delle varie tecniche dal punto di vista cronologico, l’amplissima ricognizione effettuata da Fernández e Vico nel 2013 sulle tecniche di intelligenza artificiale applicate alla composizione automatica[3] permette di associare la fortuna scientifica delle principali tecniche a epoche specifiche. Sistemi a regole, modelli stocastici e grammatiche aprono la parata, perdurando nel tempo: queste tecniche permettono di catturare le regolarità del linguaggio musicale, anche stratificate su più livelli di complessità. A questa famiglia di tecniche appartengono alcuni sistemi la cui fama è giunta al grande pubblico: oltre alla già citata Illiac Suite[4], basata sull’uso di regole e catene Markoviane, vale la pena di citare il lavoro del 1992 di Cope[5], nota come EMI — acronimo di Experiments in Musical Intelligence — in grado di codificare in una grammatica uno specifico stile musicale, estraendone gli schemi tipici attraverso un algoritmo di pattern matching. Più avanti, Ponsford e colleghi (1999[6]) utilizzano modelli Markoviani per creare composizioni di uno specifico genere (la sarabanda) a partire da un corpus di composizioni annotate.

Mentre EMI attingeva la conoscenza relativa allo stile da un insieme di composizioni (di Bach, o Bartók, nella fattispecie), altri approcci estraevano le nozioni necessarie a istruire la composizione dalla trattatistica e dalla manualistica. Per esempio, il sistema creato da Gill nel 1963[7] si ispirava alla metodologia di composizione dodecafonica descritta da Schoenberg; lo stesso sistema di Hillier e Isaacson implementava in forma di regole la pratica del contrappunto. Con l’avanzare dei decenni, la codifica manuale delle regole viene affiancata da metodi di apprendimento delle stesse, dalla loro ibridazione con algoritmi evoluzionistici (ad esempio, il lavoro di Horner e Ayers, del 1995[8], che utilizza algoritmi genetici per l’armonizzazione), oppure ancora dall’adozione del paradigma di case-based reasoning.

Le tecniche di logic programming applicate ai processi compositivi

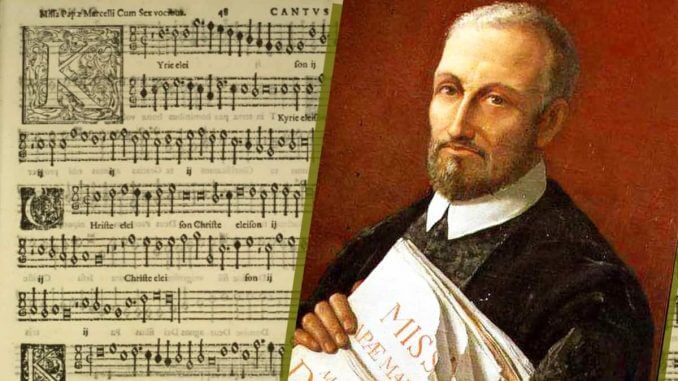

Il periodo a cavallo tra gli anni ‘80 e ‘90 è caratterizzato dall’adozione di tecniche di logic programming applicate alla formalizzazione dei processi compositivi in termini di soddisfazione di vincoli, con esempi quali Choral (Ebcioğlu, 1988[9]), sistema esperto per l’armonizzazione e generazione della melodia e Carla (Courtot 1990[10]), per la generazione polifonie, ma non mancano approcci alternativi: tra i più originali, il sistema Camus di Miranda (1993[11]), basato su automi cellulari — e più precisamente sul Gioco della Vita di Conway. Approcci basati su Modelli Markoviani si affermano a cavallo del nuovo millennio: ad esempio, il lavoro di Farbood e Schoner (2001[12]) utilizza catene Markoviane probabilistiche per generare il contrappunto nello stile di Palestrina, tenendo conto anche di fattori estetici complementari come il concetto di climax. All’inizio del nuovo Millennio, tuttavia, l’intelligenza artificiale “tradizionale” segna il passo, lasciando spazio all’avvento del paradigma in ascesa delle reti neurali.

Pierluigi da Palestrina

La nuova frontiera: tecniche di apprendimento automatico e reti neurali

Oggi, la nuova frontiera della composizione automatica di brani musicali è rappresentata dalle tecniche di apprendimento automatico e dalle reti neurali, sia come area attiva di ricerca a livello accademico, sia come moduli software integrati in framework per la produzione musicale (ad es. Magenta Studio per la suite Ableton). In particolare, parlando di AI e musica sono le reti neurali ricorrenti a fare la parte del leone in questo campo di applicazione. È interessante notare come queste tecnologie siano impiegate anche per l’analisi e la generazione automatica del linguaggio naturale. Questo non è un caso, ma una conseguenza del funzionamento interno di questi algoritmi e della struttura latente dei rispettivi materiali di apprendimento. Una rete neurale ricorrente, infatti, è in grado di apprendere la struttura di un input di natura sequenziale, come appunto la musica o la lingua scritta o parlata. Sono tecniche di deep learning, dove il termine “deep” (profondo) si riferisce all’architettura a più strati della rete neurale. È proprio la presenza di più strati della rete che le consente di apprendere strutture via via più complesse e astratte a partire dalla sequenza di input iniziale: una sequenza di segnali audio produce una nota, una sequenza di note produce una melodia, e così via.

Video: Magenta Studio

La svolta: le reti neurali end-to-end

In ambito AI e musica, la svolta neurale in ambito di composizione musicale arriva in anni recenti, con lo sviluppo di reti neurali end-to-end (Mehri et al., 2017[13]), capaci cioè di processare interi brani musicali, apprenderne caratteristiche di “alto livello” quali stile, ritmo, armonia, e produrne di nuovi, il tutto senza intervento umano al di là dell’impostazione iniziale degli iperparametri della rete neurale. Iniziative a cavallo tra la ricerca scientifica e la produzione artistica[14], come il collettivo Dadabots, stanno mostrando le potenzialità di queste tecniche nel replicare e ricombinare generi musicali, con risultati ancora chiaramente distinguibili come prodotti da macchine, ma sorprendentemente interessanti dal punto di vista del supporto alla creatività musicale. Il rovescio della medaglia delle tecnologie neurali di nuova generazione, in confronto con gli approcci algoritmici “classici”, è dato dalla loro scarsa (o nulla) interpretabilità, un tratto che invece caratterizzava le rappresentazioni simboliche avvicendatesi fino agli anni Novanta — tra tutte, i sistemi a regole.

Mentre, infatti, un algoritmo deterministico è in grado di fornire una “spiegazione” di ogni suo passaggio decisionale, con le reti end-to-end ci troviamo davanti a un numero estremamente grande di parametri (anche nell’ordine dei milioni di parametri), ottimizzati automaticamente dall’algoritmo di apprendimento, ma da cui non è possibile estrarre una forma di conoscenza comprensibile all’operatore umano.

L’enorme creatività messa in campo dai ricercatori per molti decenni, testimoniata dalla grande varietà di approcci e specifici problemi trattati, non trova infatti corrispondenza nei processi di parametrizzazione delle reti neurali. Alcuni parametri di alto livello rimangono comunque sotto il controllo dell’operatore, come ad esempio il livello di entropia introdotto dalla rete neurale durante l’inferenza, collegato all’aderenza verso il dataset di apprendimento, e di conseguenza alla quantità di “novità” nelle idee musicali emergenti dal modello. In questo senso, queste tecnologie si configurano come nuovi strumenti musicali, su cui il musicista opera in tempo reale, anche in contesti dal vivo o di improvvisazione.

Infatti, se la composizione musicale può essere vista come il compito creativo per eccellenza, percepito come tale sin dall’antichità, molti tra i sistemi menzionati vanno in una direzione quasi opposta, dato che puntano dichiaratamente all’imitazione di un canone esistente, sia esso la musica barocca o il death metal.

Tecnologie di analisi e di generazione

Valutare la qualità di una melodia, un accompagnamento o un intero brano musicale è a sua volta un problema difficile. In questo senso può tornare di nuovo utile tracciare un parallelo con i sistemi che si occupano di linguaggio naturale. Tra questi, si può tracciare una distinzione netta tra le tecnologie di analisi e quelle per la generazione. La maggior parte delle difficoltà che si incontrano nell’affrontare le seconde deriva proprio dalla complessità di valutarne il risultato in termini oggettivi. Per la musica accade lo stesso e il problema si fa più rilevante in quanto il bilanciamento tra analisi e generazione è inverso rispetto al linguaggio: gli algoritmi musicali sono sviluppati per la maggior parte nella direzione della produzione di musica, anziché l’analisi. Inoltre, mentre per il linguaggio naturale è possibile identificare dei task di natura pratica che ne facilitano la valutazione (es. la generazione di incoraggiamento per smettere di fumare, o la sintesi di dati medico-sanitari), la musica agisce a un livello più astratto, toccando emozioni e aspetti soggettivi del destinatario. Da questo punto di vista, negli ultimi due decenni la ricerca sulla relazione tra linguaggio musicale e emozioni umane ha gettato luce sulla relazione tra i due termini, arrivando sperimentalmente a determinare la corrispondenza tra elementi del linguaggio musicale (la tonalità) ed emozioni indotte, contribuendo ad illuminare l’aspetto percettivo dell’esperienza estetica.

Valutare la qualità delle produzioni dell’intelligenza artificiale

Se la valutazione di una produzione musicale di genere, nata da una strategia di natura combinatoria, può essere affidata senza remore alla comunità degli esperti all’interno della quale nasce quella produzione, lo stesso non può dirsi dei più ambiziosi tra i sistemi di composizione musicale, che puntano alla creazione di opere innovative, magari in rottura con il passato. In questo caso, il compito generativo si può definire come la forma più alta e più ardua di creatività, ovvero la creatività trasformazionale, nei termini proposti da Margaret Boden[15], storica autorità nello studio della creatività umana.

Come valutare la qualità, e l’originalità, di queste produzioni? Una lezione dal passato viene dalla figura di Iannis Xenakis, pioniere nell’utilizzo delle prime tecniche di composizione assistita: è evidente che, in questo caso, possiamo valutare il loro apporto solo all’interno del progetto artistico, ambizioso e visionario di Xenakis stesso, riconosciuto come genio che credeva fermamente nell’alleanza tra Arte e Scienza. Dichiaratamente meno ambiziosi, i già citati DadaBots affermano: “We publish research on eliminating humans from

Conclusioni

Nel futuro, probabilmente, nessuno avrà quindici minuti di musica di qualità composti per sé (per parafrasare Andy Wharol, ndr), ma forse ognuno di noi avrà, per un tempo ben più lungo, una colonna sonora di film e videogiochi personalizzata in tempo reale, e una produzione musicale in armonia con le proprie emozioni.

Note

- Lopes, P., Liapis, A., & Yannakakis, G. (2015, September). Targeting horror via level and soundscape generation. In Proceedings of the AAAI Conference on Artificial Intelligence and Interactive Digital Entertainment (Vol. 11, No. 1). ↑

- Camurri, A. (2000). Artificial Intelligence Architectures for Composition and Performance Environment, in Miranda, E. R. (Ed.). (2013). Readings in music and artificial intelligence. Routledge. ↑

- Fernández, J. D., & Vico, F. (2013). AI methods in algorithmic composition: A comprehensive survey. Journal of Artificial Intelligence Research, 48, 513-582. ↑

- Hiller, L. A., & Isaacson, L. M. (1958). Musical composition with a High-Speed digital computer. Journal of the Audio Engineering Society, 6(3), 154–160. ↑

- Cope, D. (1992). Computer modeling of musical intelligence in EMI. Computer Music

Journal, 16(2), 69–83. ↑

- Ponsford, D., Wiggins, G., & Mellish, C. (1999). Statistical learning of harmonic movement. Journal of New Music Research, 28(2), 150–177. ↑

- Gill, S. (1963). A technique for the composition of music in a computer. The Computer Journal, 6(2), 129–133. ↑

- Horner, A., & Ayers, L. (1995). Harmonization of musical progressions with genetic algo- rithms. In Proceedings of the International Computer Music Conference. ↑

- Ebcioğlu, K. (1988). An expert system for harmonizing four-part chorales. Computer Music Journal, 12(3), 43–51. ↑

- Courtot, F. (1990). A constraint-based logic program for generating polyphonies. In Pro- ceedings of the International Computer Music Conference, pp. 292–294. ↑

- Miranda, E. R. (1993). Cellular automata music: An interdisciplinary project. Journal of New Music Research, 22(1), 3–21. ↑

- Farbood, M., & Schoner, B. (2001). Analysis and synthesis of Palestrina-style counterpoint using Markov chains. In Proceedings of the International Computer Music Conference ↑

- Mehri, Soroush, et al. “SampleRNN: An unconditional end-to-end neural audio generation model.” arXiv preprint arXiv:1612.07837 (2016). ↑

- Carr, C. J., & Zukowski, Z. (2018). Generating albums with SampleRNN to imitate metal, rock, and punk bands. arXiv preprint arXiv:1811.06633. ↑

- Boden, M. A. (2009). Computer models of creativity. AI Magazine, 30(3), 23-23. ↑