GPT-3 (Generative Pretrained Transformer 3), modello creato dalla società di ricerca OpenAI di San Francisco, può essere definito un “robowriter”, uno scrittore di testi? Un sistema di intelligenza artificiale che, a detta di chi lo ha provato, è in grado di produrre risultati molto più coerenti e ricchi di qualsiasi altro sistema linguistico creato in precedenza. Gli esempi di canzoni, storie, comunicati stampa, interviste, saggi, manuali tecnici che è stato in grado di produrre sono incredibili. Secondo il team di sviluppo di OpenAI, i risultati di GPT-3 sono così buoni che le persone trovano difficile distinguere le sue notizie dalla prosa scritta dagli umani. Il sistema è già in grado di rispondere a domande, correggere grammatica, risolvere problemi di matematica e persino generare codici di programmazione per computer.

GPT-3 e gli “altri”

Naturalmente, anche altri modelli e algoritmi di AI potrebbero fare queste cose, ma solo dopo essere state formate in maniera specifica per ognuno di questi differenti compiti.

Gli sviluppatori del progetto adesso stanno testando la capacità del modello di riassumere documenti legali, suggerire risposte alle richieste di servizi clienti, eseguire giochi di ruolo basati su testo o persino identificare le persone che potrebbero essere a rischio, in una comunità, identificando ed etichettando i loro post come “grida di aiuto”.

In tutta questa meraviglia e nonostante la sua versatilità, GPT-3 non ha però ancora superato i problemi che hanno afflitto (e che continuano ad affliggere) altri programmi creati per generare testo in maniera automatica. In un tweet, Sam Altman – amministratore delegato di OpenAI, scriveva che “ha ancora gravi punti deboli e talvolta commette errori molto stupidi”.

Una “bocca senza cervello”

Il modello di AI, di fatto, funziona osservando le relazioni statistiche tra le parole e le frasi che legge, ma non è ancora in grado di comprenderne il significato. Per questo motivo, come conseguenza e proprio come altri sviluppi ed esperimenti di chatbot, potrebbe – se richiesto – diffondere incitamento all’odio e generare stereotipi razzisti e sessisti.

In un certo senso, come dicono alcuni ricercatori, è come se avessimo a che fare con una “bocca senza cervello” e, se non mancano le idee su come affrontare i pregiudizi potenzialmente dannosi nei modelli linguistici, il poter instillare buon senso, ragionamento causale o, anche, giudizio morale, è tuttora una gigantesca sfida per la ricerca.

Modelli linguistici basati su reti neurali

Da un punto di vista di realizzazione, i modelli linguistici sono delle reti neurali che, per semplificare, sono delle funzioni matematiche che sono sviluppate ispirandosi al modo in cui lavorano i neuroni nel nostro cervello.

Come esercizio, gli algoritmi si allenano prevedendo parole che vengono nascoste nei testi che vengono dati loro e quindi sfruttano le connessioni tra i loro elementi informatici stratificati (quelli che per noi sarebbero i neuroni) per ridurre l’errore di previsione e prevedere la parola mancante.

Nel tempo, i modelli sono diventati sempre più sofisticati grazie all’aumento della potenza di calcolo disponibile: GPT-3 (Generative Pretrained Transformer 3) è il terzo modello di una serie e oltre 100 volte più grande del suo predecessore del 2019, GPT-2.

Basti pensare che la dimensione di una rete neurale, e quindi la sua potenza, è misurata approssimativamente da quanti parametri ha: questi numeri è come se definissero i punti di forza delle connessioni tra i neuroni; quindi, più neuroni e più connessioni significano più parametri (e, di conseguenza, più potenza). Per dare un’idea precisa, GPT-3 ne ha 175 miliardi mentre il precedente modello linguistico più grande nel suo genere ne aveva “solo” 17 miliardi.

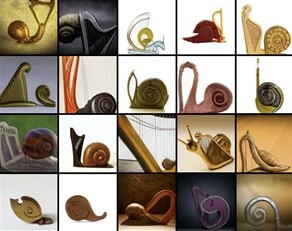

Un esempio di generazione di immagini da un testo effettuato da GPT-3

GPT-3 è in grado di apprendere dai testi

Per migliorare la previsione delle parole, GPT-3 è in grado di analizzare e apprendere tutti gli schemi possibili dei testi che studia: riconosce la grammatica, la struttura del saggio e il genere di scrittura. In questo modo, dopo aver messo a disposizione del modello alcuni esempi di un’attività, è possibile fargli una domanda per poter continuare su quello stesso tema.

Il team di OpenAI ha pubblicato un documento che dimostra come GPT-3 sia eccellente in molti test di generazione del linguaggio, tra cui curiosità, comprensione della lettura, traduzione, domande scientifiche, aritmetica, completamento di una storia.

L’interesse per quanto sopra, al di là degli specifici (e spesso strabilianti) risultati, dipende dal fatto che GPT-3 non era (e non è) stato messo a punto in modo specifico per nessuno di quei compiti ma, ugualmente, poteva competere con modelli che erano stati messi a punto in maniera specifica per quegli “esempi di utilizzo”.

Per alcuni scienziati i risultati dipendevano dal fatto che i dati di addestramento di GPT-3 probabilmente contenevano abbastanza esempi, ad esempio, di persone che rispondevano a domande di curiosità o traducevano testo così che i formati incorporati nei testi sono stati appresi dal modello.

“Un motore di memorizzazione”

In sostanza, come ha affermato Yonatan Bisk, scienziato presso la Carnegie Mellon University di Pittsburgh, il modello è ancora “principalmente un motore di memorizzazione e nessuno si sorprende che se impari di più, puoi fare di più.”

Al contrario, i ricercatori di OpenAI sostengono che GPT-3 è ben più sofisticato di così: durante la fase di preallenamento, sostengono che – essenzialmente – il sistema esegua una sorta di “meta-apprendimento”: impara come apprendere compiti; ovverosia, gli algoritmi sono sufficientemente flessibili da utilizzare esempi o istruzioni nella prima parte del testo fornito come apprendimento per “ragionare” sulla continuazione della seconda parte.

Un aspetto su cui i creatori di GPT-3 sono entusiasti è la ricerca semantica, in cui il compito è cercare nei testi non una parola o una frase specifica, ma un concetto: in un esperimento, i ricercatori hanno fornito agli algoritmi degli stralci di uno dei libri della saga di Harry Potter per poi chiedergli di identificare le volte in cui Ron, l’amico del protagonista, avesse fatto qualcosa di grande.

GPT-3 e testi, i rischi da non sottovalutare

In tutto questo scenario non possono (e non devono) essere sottovalutati i rischi che potrebbero arrivare da questa tecnologia. Alcuni ricercatori del Middlebury Institute of International Studies di Monterey, in California, in un documento dello scorso settembre, scrivono che GPT-3 supera di gran lunga il suo predecessore, GPT-2, nella generazione di testi radicalizzanti: grazie alla sua “conoscenza straordinariamente profonda delle comunità estremiste”, il sistema di AI, ad esempio, è stato in grado di produrre polemiche e spunti di cospirazione relativi a gruppi suprematisti bianchi.

Il problema diventerebbe concreto nel momento in cui un qualsiasi gruppo estremista si dovesse impadronire della tecnologia GPT-3: potrebbe automatizzare la produzione di contenuti dannosi, massimizzando la diffusione del loro credo, riducendo incredibilmente lo sforzo.

I pregiudizi di GPT-3

I ricercatori di OpenAI, naturalmente, stanno lavorando anche su tutti quelli che sono i temi legati ai pregiudizi di GPT-3.

Queste classi di problemi sono una preoccupazione molto importante per tutti i modelli linguistici di grandi dimensioni, perché fanno pensare come gruppi di emarginati, o minoranze etniche, potrebbero subire rappresentazioni errate se le tecnologie si diffondessero all’interno società prima di “correggere il tiro”.

Probabilmente, invece di cercare di costruire reti neurali sempre più grandi, che possano fornire una fluidità simile a quella umana, ci si potrebbe concentrare di più sul rendere i programmi maggiormente sicuri, schermati verso pregiudizi.

GPT-3, eliminare il “testo tossico” dai dati

Apparentemente, per risolvere il problema, potrebbe essere sufficiente eliminare il “testo tossico” dai dati utilizzati per allenare gli algoritmi. Si potrebbe, ad esempio, addestrare modelli linguistici utilizzando il Colossal Clean Crawled Corpus, che esclude pagine web contenenti qualsiasi elenco di parole ritenute “improprie”, comprese quelle talvolta utili come “fecale” o “capezzolo”.

Questo esercizio, però, comporta la limitazione di qualsiasi modello linguistico che verrà addestrato su di esso e non sposta il vero problema che risiede nel fatto che, spesso, i pregiudizi possono assumere la forma di sottili associazioni difficili da individuare e rimuovere in maniera automatica. Per paradosso, se avessi un modello di AI che non ha mai avuto alcuna esposizione a problematiche di sessismo potrebbe rispondere con un semplice “no” alla domanda “c’è del sessismo nel mondo?”.

In molti suggeriscono che, come operazione minima e iniziale, tutti i ricercatori dovrebbero documentare pubblicamente i dati che entrano nei loro modelli per la fase di addestramento e formazione anche per consentire una sorta di “revisione” tra pari. Il punto centrale, alla fine, risiede nel fatto che GPT-3, così come altri modelli di linguaggio di grandi dimensioni, mancano ancora di buon senso, ovvero della comprensione di come funziona il mondo, fisicamente e – soprattutto – socialmente.

Video OpenAI

GPT-3 e testi: combinare modelli linguistici

Diversi ricercatori, per affrontare il tema, promuovono l’idea di combinare modelli linguistici che abbiano basi di conoscenza differenti.

In un lavoro presentato all’Association for Computational Linguistics, alcuni di essi hanno presentato un modello di AI che è in grado di costruire frasi che affermano esplicitamente fatti e inferenze partendo da un esercizio di buon senso (per fare un esempio, per questo modello, se una persona sta cucinando della pasta, si ritiene presumibile che quella stessa persona la voglia mangiare).

La conseguenza di questo esercizio è stata quella di avere racconti più logici, con senso, scritti da questo modello.

Una variazione di questa idea è quella di combinare un modello già addestrato insieme a un motore di ricerca. In questo modo, quando vengono poste domande al modello, il motore di ricerca può giocare un ruolo di aiuto presentando rapidamente delle pagine che siano pertinenti all’argomento in modo da aiutare il modello a costruire una risposta più sensata.

A onor del vero, alcuni ricercatori, ritengono che i modelli linguistici non potrebbero mai raggiungere il buon senso a livello umano fintanto che rimarranno esclusivamente nell’ambito del linguaggio: i bambini imparano vedendo, sperimentando e agendo.

Il linguaggio ha senso per le persone perché siamo in grado di basarlo su qualcosa che va oltre le lettere con cui è composto: chi legge un romanzo non lo “assorbe” eseguendo statistiche sulla frequenza delle parole.

Conclusioni

Ci sono delle strade per lavorare in questa direzione? Probabilmente diverse:

- costruire un modello in grado di studiare tutto il testo che è mai stato scritto

- addestrato un modello tramite video così che le immagini in movimento possano portare a una comprensione più ricca della realtà.

- costruire un “esercito di algoritmi” e lasciarli interagire con il mondo per capirci al meglio.