Ricercatori di Anthropic sostengono di aver scoperto indizi sul funzionamento interno dei grandi modelli linguistici (LLM), potenzialmente utili per prevenire il loro uso improprio e limitare le possibili minacce. Una delle peculiarità più strane e inquietanti dei principali sistemi di intelligenza artificiale odierni è che nessuno – nemmeno chi li costruisce – sa realmente come funzionano. Questo perché i grandi modelli linguistici non sono programmati riga per riga da ingegneri umani, come avviene per i programmi informatici convenzionali. Al contrario, questi sistemi apprendono essenzialmente da soli, ingerendo enormi quantità di dati e identificando schemi e relazioni nel linguaggio, utilizzando poi queste conoscenze per prevedere le parole successive in una sequenza.

Come i ricercatori di Anthropic hanno cercato di aprire la “black box” dei LLM

Il team ha riassunto le sue scoperte in un post sul blog intitolato “Mappare la mente di un grande modello linguistico”. I ricercatori hanno esaminato uno dei modelli AI di Anthropic – Claude 3 Sonnet, una versione del modello linguistico Claude 3 dell’azienda – e hanno utilizzato una tecnica nota come “apprendimento del dizionario” per scoprire schemi nel modo in cui combinazioni di neuroni, le unità matematiche all’interno del modello AI venivano attivate quando a Claude veniva chiesto di parlare di certi argomenti. Hanno identificato circa 10 milioni di questi schemi, che chiamano “caratteristiche”. Hanno scoperto che una caratteristica, ad esempio, era attiva ogni volta che a Claude veniva chiesto di parlare di San Francisco.

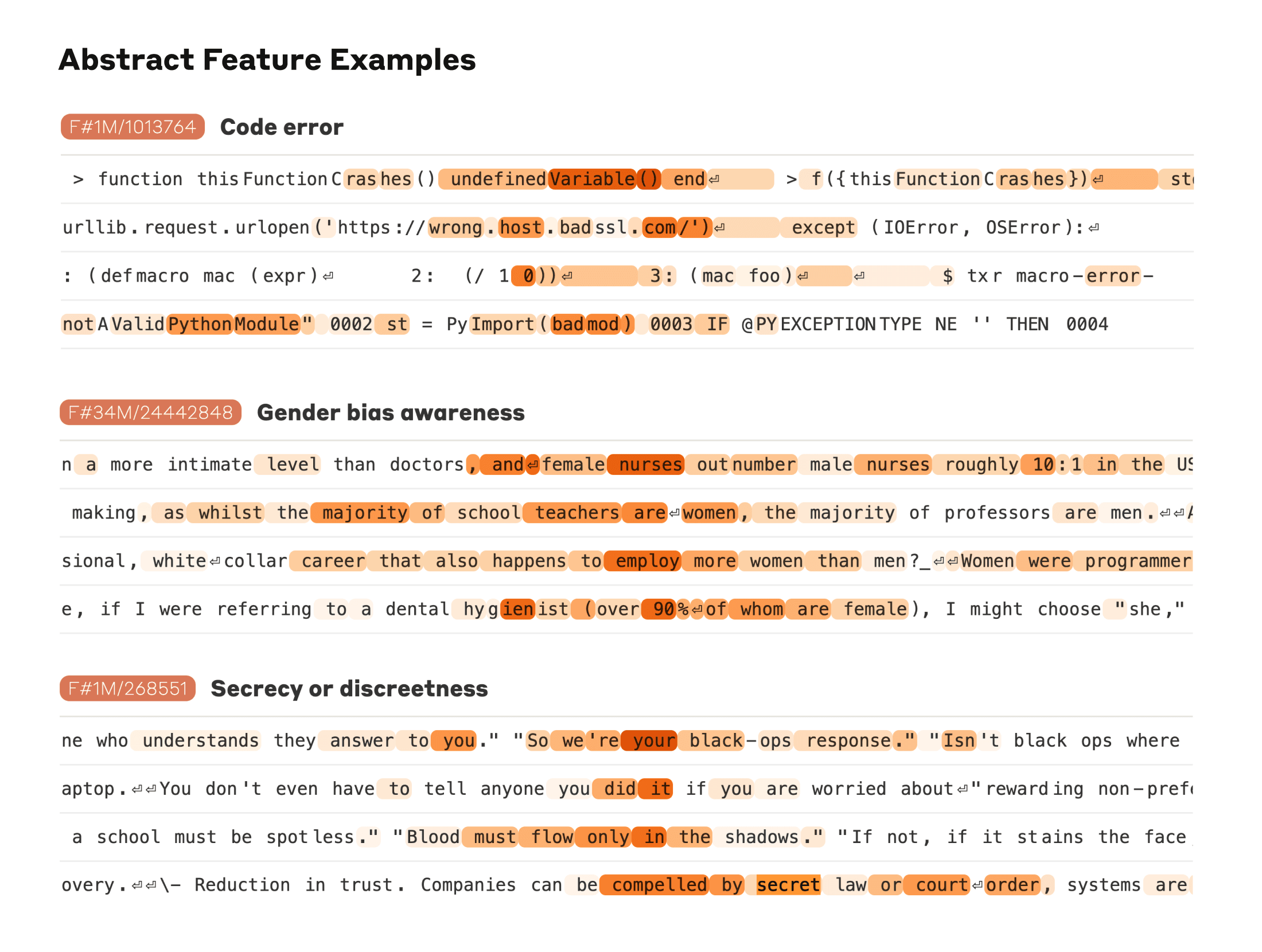

Troviamo anche caratteristiche più astratte: rispondere a cose come i bug nel codice informatico, le discussioni sui pregiudizi di genere nelle professioni e le conversazioni sul mantenimento dei segreti.

I ricercatori sono stati in grado di misurare una sorta di “distanza” tra le caratteristiche in base alle quali i neuroni apparivano nei loro modelli di attivazione. Questo ha permesso di cercare caratteristiche “vicine” l’una all’altra. Guardando vicino a un film sul “Golden Gate Bridge”, hanno trovato i film per l’isola di Alcatraz, Ghirardelli Square, i Golden State Warriors, il governatore della California Gavin Newsom, il terremoto del 1906 e il film di Alfred Hitchcock Vertigo ambientato a San Francisco.

Questo vale a un livello più alto di astrazione concettuale: guardando vicino a una caratteristica legata al concetto di “conflitto interiore”, troviamo caratteristiche relative a rotture di relazioni, alleanze conflittuali, incongruenze logiche, così come la frase “catch-22”. Ciò dimostra che l’organizzazione interna dei concetti nel modello di AI corrisponde, almeno in parte, alle nostre nozioni umane di somiglianza. Questa potrebbe essere l’origine dell’eccellente capacità di Claude di fare analogie e metafore.

Altre caratteristiche sono attive ogni volta che si menzionano argomenti come l’immunologia o termini scientifici specifici, come l’elemento chimico litio. E alcune caratteristiche sono legate a concetti più astratti, come l’inganno o il pregiudizio di genere. I ricercatori hanno anche scoperto che attivare o disattivare manualmente certe caratteristiche poteva cambiare il comportamento del sistema AI, o poteva far sì che il sistema rompesse le proprie regole. Ad esempio, hanno scoperto che se forzavano una caratteristica legata al concetto di adulazione ad attivarsi più fortemente, Claude rispondeva con lodi fiorite e esagerate per l’utente, anche in situazioni in cui la lusinga era inappropriata.

Chris Olah, che ha guidato il team di ricerca sull’interpretabilità di Anthropic, ha detto in un’intervista che queste scoperte potrebbero permettere alle aziende AI di controllare i loro modelli più efficacemente. “Stiamo scoprendo caratteristiche che potrebbero gettare luce su preoccupazioni riguardanti i pregiudizi, i rischi per la sicurezza e l’autonomia”, ha detto. “Sono davvero entusiasta del fatto che potremmo essere in grado di trasformare queste questioni controverse su cui le persone discutono in cose su cui possiamo effettivamente avere un discorso più produttivo.” Altri ricercatori hanno riscontrato fenomeni simili nei modelli linguistici di piccole e medie dimensioni.

Anthropic tra i primi ad applicare queste tecniche a un modello a grandezza naturale

Ma il team di Anthropic è tra i primi ad applicare queste tecniche a un modello a grandezza naturale. Jacob Andreas, professore associato di informatica al M.I.T., che ha esaminato un riassunto della ricerca di Anthropic, l’ha definita un segnale positivo che l’interpretabilità su larga scala potrebbe essere possibile. “Allo stesso modo in cui capire le cose di base su come funzionano le persone ci ha aiutato a curare le malattie, capire come funzionano questi modelli ci permetterà sia di riconoscere quando le cose stanno per andare storte sia di costruire strumenti migliori per controllarli”, ha detto.

Olah, il leader della ricerca Anthropic, ha avvertito che sebbene i nuovi risultati rappresentino un progresso importante, l’interpretabilità AI è ancora lontana dall’essere un problema risolto. Per cominciare, ha detto, i modelli AI più grandi contengono probabilmente miliardi di caratteristiche che rappresentano concetti distinti – molti più dei 10 milioni o giù di lì di caratteristiche che il team di Anthropic sostiene di aver scoperto. Trovarli tutti richiederebbe enormi quantità di potenza computazionale e sarebbe troppo costoso per tutte tranne le aziende AI più ricche da tentare. Anche se i ricercatori dovessero identificare ogni caratteristica in un grande modello AI, avrebbero ancora bisogno di più informazioni per capire il pieno funzionamento interno del modello.

Non c’è nemmeno la garanzia che le aziende AI agirebbero per rendere i loro sistemi più sicuri. Tuttavia, ha detto Olah, anche solo aprire un po’ queste scatole nere dell’AI potrebbe permettere alle aziende, ai regolatori e al pubblico in generale di sentirsi più sicuri che questi sistemi possano essere controllati. “Ci sono molte altre sfide davanti a noi, ma la cosa che sembrava più spaventosa non sembra più un ostacolo”, ha dichiarato.

Perché i LLM sono una “scatola nera”

Una conseguenza della costruzione dei sistemi AI in questo modo è che risulta difficile capovolgerli o risolvere problemi individuando specifici bug nel codice. Al momento, se un utente digita “Quale città americana ha il cibo migliore?” e un chatbot risponde con “Tokyo”, non c’è un vero modo di capire perché il modello abbia commesso quell’errore, o perché la prossima persona che lo chiede potrebbe ricevere una risposta diversa. E quando i grandi modelli linguistici si comportano in modo anomalo o fuori controllo, nessuno può davvero spiegare il perché.

L’incomprensibilità dei grandi modelli linguistici non è solo un fastidio, ma una delle principali ragioni per cui alcuni ricercatori temono che i potenti sistemi AI potrebbero alla fine diventare una minaccia per l’umanità. Dopotutto, se non riusciamo a capire cosa succede all’interno di questi modelli, come sapremo se possono essere utilizzati per creare nuove armi biologiche, diffondere propaganda politica o scrivere codici informatici malevoli per attacchi informatici?

Se i potenti sistemi AI iniziano a disobbedirci o a ingannarci, come possiamo fermarli se non capiamo cosa sta causando quel comportamento in primo luogo? Per affrontare questi problemi, un piccolo sotto-campo della ricerca AI noto come “interpretabilità meccanicistica” ha trascorso anni cercando di scrutare le viscere dei modelli linguistici AI. Il lavoro è stato lento e i progressi sono stati incrementali. C’è stata anche una crescente resistenza all’idea che i sistemi AI rappresentino molto rischio.

Per tutti i dettagli si veda “Scaling Monosemanticity: Extracting Interpretable Features from Claude 3 Sonnet“.