L’intelligenza artificiale ci ha abituati a grandi prestazioni e rapidi sviluppi, ma certamente ha portato alla luce anche una serie di problematiche che meritano di essere ben comprese e analizzate, di modo da mettere al riparo gli utenti persone fisiche da esiti nefasti derivanti dall’utilizzo indiscriminato di tali sistemi. Ciò detto, e con particolare riferimento ai processi di valutazione della rispondenza dei sistemi algoritmici ai requisiti necessari richiesti dalla normativa applicabile, merita di essere analizzato quello specificamente previsto dal Governo canadese, definito con l’acronimo AIA (Algorithmic Impact Assessment).

Cos’è AIA (Algorithmic Impact Assessment)

Premesso doverosamente che la valutazione in oggetto[1] non è, rebus sic stantibus, applicabile tout court alla regolamentazione europea – essendo strutturata ad hoc sulla base e con riferimento alla politica di governo e alle considerazioni etiche e di diritto amministrativo specifiche del Canada[2], la stessa si presenta comunque come valido esempio pratico di DPIA per sistemi decisionali automatizzati, da cui, appunto, l’acronimo AIA.

Il dichiarato obiettivo del Governo del Canada è quello di sdoganare l’utilizzo della tecnologia e dei sistemi automatizzati per prendere – o aiutare a prendere – decisioni amministrative che migliorino la fornitura di servizi sotto vari aspetti.

Per permettere che ciò avvenga in maniera compatibile con i principi fondamentali del diritto amministrativo – quali la trasparenza, la responsabilità, la legalità e l’equità procedurale – il tool proposto è stato sviluppato per fornire ai dipartimenti e alle agenzie federali una guida su come impiegare in modo responsabile i sistemi decisionali automatizzati, fungendo da espresso supporto alla cd. Treasury Board’s Directive on Automated Decision-Making.

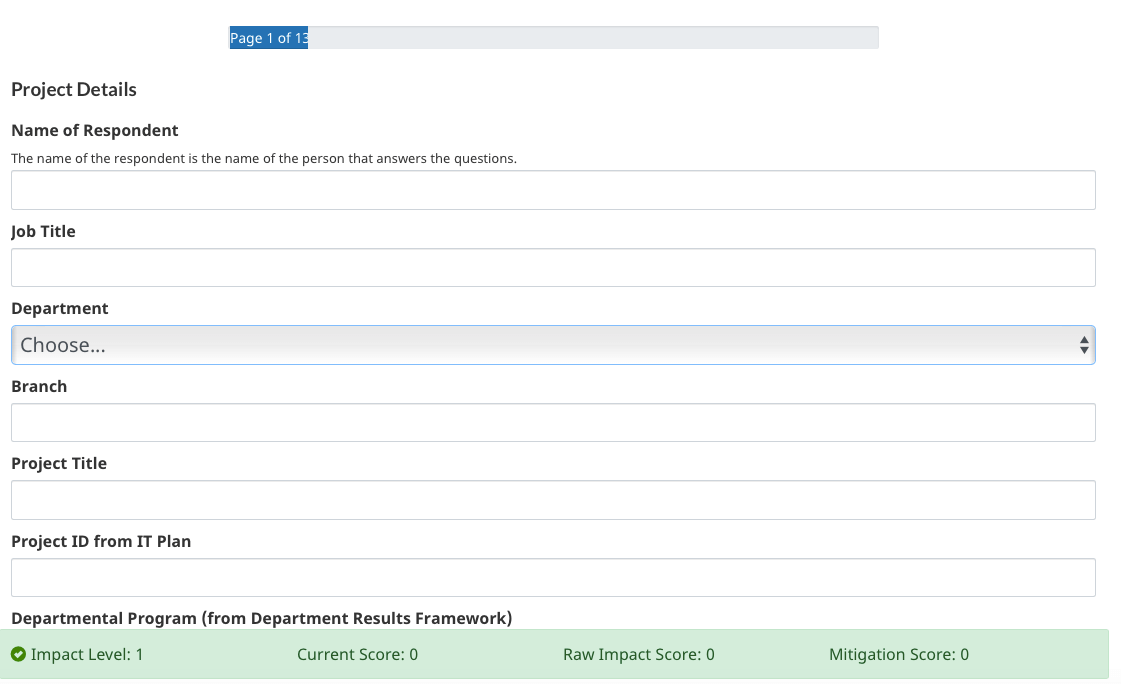

Per maggiore chiarezza si riporta a seguire la schermata della pagina iniziale di accesso alla valutazione.

Nello specifico, i sistemi di AI vengono classificati in virtù di quattro livelli di impatto algoritmico, sulla base di un questionario interattivo composto da 48 domande sul rischio e 33 sulla mitigazione, al termine del quale verrà visualizzata una pagina di risultati dettagliata che potrà essere stampata o salvata in .pdf.

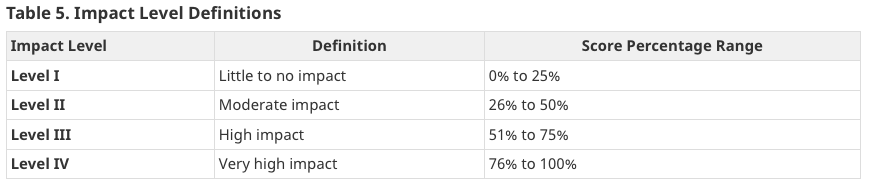

I citati livelli spaziano da ‘nessun impatto o basso impatto’, a ‘impatto moderato’, ad ‘alto impatto’ fino a ‘altissimo impatto’. Si noti che il livello di impatto è determinato dalla percentuale del punteggio di ‘compliance reale’ rispetto al massimo punteggio di impatto grezzo raggiungibile.

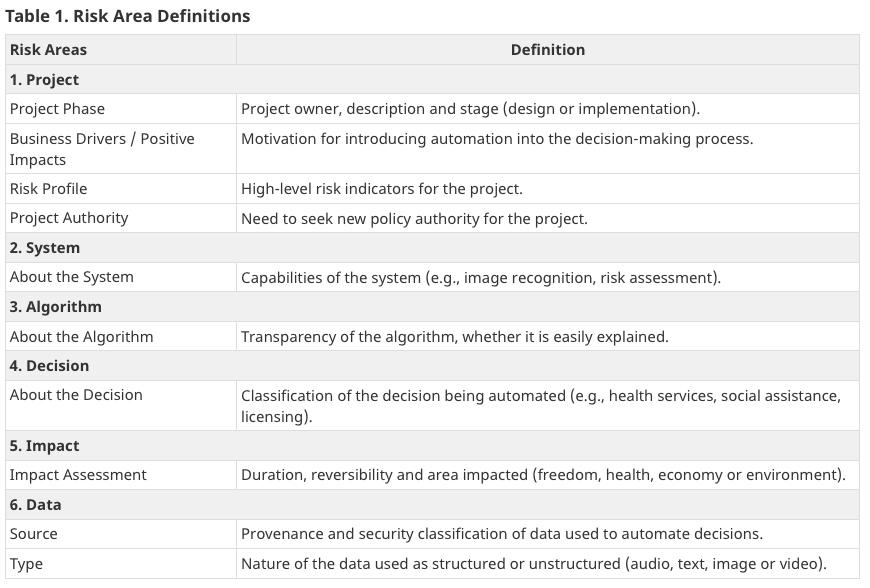

AIA, inoltre, è composta da differenti domande finalizzate a valutare le aree di rischio, suddivise in progettazione, algoritmo, tipo di decisione, impatto e dati e definite specificamente nella tabella 1.

Il tool valuta anche le misure di mitigazione in essere per la gestione dei rischi, organizzate nelle categorie definite da una seconda tabella che include la consultazione (con stakeholder interni ed esterni, quali esperti di privacy e legali) e le misure di mitigazione e de-risking (processi di qualità dei dati, procedure di equità procedurale, privacy).

Lo skyline di Toronto, Canada

Un sistema a domande e risposte

Ogni area contiene 1 o più domande e le risposte determinano l’applicazione di un punteggio massimo per area.

Le domande sono progettate per misurare l’impatto che le decisioni avranno su una vasta gamma di fattori, tra cui: i diritti degli individui o delle comunità; la salute o il benessere degli individui o delle comunità; gli interessi economici di individui, entità o comunità; la sostenibilità nel tempo di un ecosistema, e la durata e la reversibilità degli impatti.

Il valore di ogni domanda è dato dalla ponderazione tra impatto grezzo (raw) e mitigazione, laddove il primo misurerà i rischi dell’automazione, mentre il secondo la gestione di tali rischi[3].

Se il punteggio di mitigazione risulterà inferiore all’80% del punteggio massimo raggiungibile, il punteggio ‘compliance reale’ sarà uguale al punteggio di impatto grezzo; altrimenti, se uguale o superiore, si procederà a dedurre il 15% dal punteggio di impatto grezzo.

Il completamento della valutazione AIA porterà, come anticipato, all’individuazione del livello di impatto specifico – come descritto nella tabella che segue –, unitamente ad un link ai requisiti della Direttiva e alla pagina dettagliata dei risultati con la spiegazione del perché il sistema è stato valutato ad un dato livello.

Infine, oltre alla raccomandazione di provvedere alla compilazione del questionario mediante un team multidisciplinare strutturato, viene suggerito di sottoporre a valutazione AIA ciascun sistema di AI tanto nella fase inziale di progettazione, quanto, successivamente, prima della messa in produzione.

Cosa si sta facendo in Europa

Se da una parte il Parlamento e la Commissione europei hanno evidenziato la necessità di rispondenza a requisiti etici[4], dall’altra uno dei profili maggiormente sotto esame al momento è certamente quello connesso alla trasparenza e alla conseguente affidabilità delle intelligenze artificiali.

Infatti, “A causa del crescente uso dell’Intelligenza Artificiale (AI) in molti campi diversi, problemi come la discriminazione causata da algoritmi decisionali automatizzati stanno diventando più pressanti. Il problema di fondo è l’esistenza sconosciuta di pregiudizi, dovuta all’opacità dei sistemi. La risposta logica per ridurre i problemi causati dall’opacità è una maggiore richiesta di trasparenza. La trasparenza consiste in uno scambio di informazioni tra un soggetto e un oggetto, in cui il soggetto riceve informazioni sulle prestazioni di un sistema o organizzazione di cui l’oggetto è responsabile”[5].

L’associazione danese DataEthics, in tal senso, ha pubblicato un “Framework for transparent AI” nel quale ha riassunto 18 linee guida etiche organizzandole in nove argomenti principali in grado di coprire l’intero processo di sviluppo, uso e revisione di un sistema di Intelligenza Artificiale.

In materia, inoltre, si sono già espressi tanto la ICO (Garante inglese), quanto l’EDPS, rispettivamente con la Guidance on the AI auditing framework e l’Opinion on the European Commission’s White Paper on Artificial Intelligence – A European approach to excellence and trust.

È giusto il caso di ricordare, per completezza, che, sempre in tema di AI, il lavoro della Commissione Europea è incessante, come dimostra la presentazione – pochi giorni fa – di una proposta di Regolamento sull’AI – attualmente in consultazione – che sembra mirare al mantenimento della leadership tecnologia (evitando barrage), affiancato alla necessità di bloccare effetti nefasti connessi all’uso non regolamentato dell’AI.

Note

- Progetto open source rilasciato sotto la licenza MIT. ↑

- Di cui anche al Treasury Board’s Directive on Automated Decision-Making. ↑

- “The questions in risk areas 1 to 6 increase the raw impact score, and the questions in mitigation areas 7 and 8 increase the mitigation score”. Si vedano le tabelle 3 (Raw impact score from the Risk Areas) e 4 (Mitigation score from the Mitigation Areas) di cui al link . ↑

- Che ricordiamo essere: supervisione umana; robustezza tecnica e sicurezza; privacy, controllo e gestione dei dati; trasparenza; diversità, correttezza, assenza di discriminazione; benessere sociale e ambientale; responsabilità. ↑

- Ossia costi ambientali, occupazione, modello di business, diritti dell’utente, dati, algoritmi, verificabilità, affidabilità e apertura. ↑