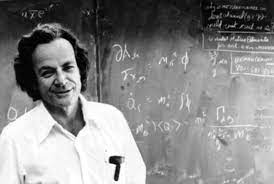

Sebbene la storia del computer quantistico si faccia risalire al 1982, anno in cui il fisico statunitense Richard Feynman ne espone la teoria ipotizzandone la realizzazione grazie al principio di sovrapposizione di stati delle particelle elementari, con ripresa poi nel 1985 da parte di David Deutsch che riuscì a dimostrare la validità della teoria di Feynman, la primissima idea di una simile possibilità venne allo scienziato Murray Gell-Mann che nei primi anni ‘80 intravide nel comportamento delle particelle elementari la possibilità di sviluppo di una nuova tipologia di scienza informatica (il fisico statunitense ricevette il Premio Nobel per la Fisica nel 1969 per gli studi sulle particelle elementari, in particolare sulla teoria dei quark).

1982 (Feynman)

Nel 1982, Richard Feynman teorizzò quelli che oggi vengono classificati come “simulatori quantistici” ossia macchine di elaborazione che permettono lo studio di sistemi quantistici difficili da studiare in laboratorio e impossibili da modellare con un supercomputer. I simulatori quantistici, nell’idea di Feynman, sono dunque dispositivi per scopi speciali progettati per fornire informazioni su problemi fisici specifici (quindi potremmo dire che sono dei quantum annealer).

Attraverso i suoi studi Feynman cercò di andare oltre e mostrò che una macchina di Turing classica (basata sul test di turing classico) avrebbe sperimentato un rallentamento esponenziale nella simulazione dei fenomeni quantistici, mentre il suo ipotetico simulatore quantistico universale non lo avrebbe fatto. Feynman nel suo lavoro dell’ ‘82 disse in sostanza che la Macchina di Turing può simulare un sistema quantistico solo con un rallentamento esponenziale (nel senso che la complessità algoritmica richiesta rallenterebbe la capacità computazionale) mentre un computer basato su qubit (che Feynman identificò come simulatore quantistico universale) non è “affetto” da tali limiti.

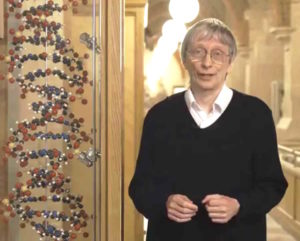

1985 (Deutsch)

È partendo da queste teorie che nel 1985 il fisico britannico David Deutsch, in un articolo intitolato “Quantum theory, the Church-Turing principle and the universal quantum computer”, poté descrivere le caratteristiche del computer quantistico:

- – possibilità di elaborazione generalista (quindi non basata su calcoli specifici e soprattutto senza obbligo di predeterminare le interazioni tramite interruttori/funzioni “OR”, “AND” e “NOT”);

- – sfruttamento del parallelismo quantico (per il calcolo in parallelo e non più in sequenza).

Oltre alle prime ipotesi di Feynman, Deutsch prese spunto anche dalla teoria di Church-Turing (dal nome dei due matematici dai matematici Alonzo Church e Alan Turing, che la introdussero tra gli anni trenta e gli anni quaranta), secondo la quale “se un problema è umanamente calcolabile, allora esisterà una macchina di Turing (o un dispositivo equivalente, come il computer) in grado di risolverlo (cioè di calcolarlo)”.

In particolare, David Deutsch andò oltre la tesi Church-Turing affermando che “ciascun sistema fisico finitamente realizzabile può essere perfettamente simulato da un modello universale di macchina computazionale operante con risorse finite”, principio secondo il quale un computer quantistico dovrebbe quindi in grado di simulare qualsiasi esperimento fisico.

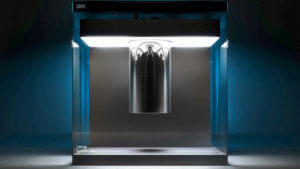

1997 (IBM)

Il primo prototipo di computer quantistico è stato realizzato nel 1997 da IBM nel suo Centro di Ricerca di Almaden (San Jose, California) misurando lo spin dei nuclei atomici (ossia la grandezza, o numero quantico, associata alle particelle, che concorre a definirne lo stato quantico) di particolari molecole tramite la risonanza magnetica nucleare (misurando cioè lo spin e determinando quindi lo stato quantistico di una particella quando è sottoposta ad un campo magnetico).

Solo un anno dopo, Bruce Kane, fisico australiano della University of New South Wales propone la costruzione di un elaboratore quantistico su atomi di fosforo disposti su uno strato di silicio spesso solo 25 nanometri; nell’ipotesi di Kane, i vecchi chip di silicio non vanno in cantina ma vengono utilizzati inserendovi all’interno degli atomi di fosforo; lo spin dei nuclei di fosforo rappresenterebbe quindi i qubit che potrebbero ospitare operazioni logiche grazie alla loro “manipolazione” attraverso capi elettrici esterni (fermo restando che il sistema dovrebbe avvicinarsi allo zero assoluto per poter operare).

2001 (IBM – elaboratore quantistico a 7 qubit)

È comunque nel 2001 che l’Almaden Research Center di IBM presenta il primo elaboratore quantistico a 7 qubit (composto da una sola molecola con 7 spin nucleari).

Da lì in poi – come riportato nell’ultimo aggiornamento di Wikipedia alla voce “computer quantistico” alla quale abbiamo aggiunto alcune voci più recenti – una serie di tappe ed innovazioni importanti ci portano ai giorni nostri:

- il 13 febbraio 2007 la D-Wave Systems mostra pubblicamente l’Orion, quello che si ritiene il primo computer quantistico adiabatico (cioè isolato, impenetrabile al calore) a 16 qubit;

- nel 2009 viene costruito il primo processore che sfrutta 2 qubit;

- l’11 maggio 2011 la D-Wave Systems annuncia il D-Wave One, elaboratore a 128 qubit, che risulta essere il primo computer quantistico ad essere commercializzato;

- nell’aprile del 2012 gli scienziati del Max Planck Institute, istituto di ottica quantistica, riescono a creare la prima rete quantica funzionante;

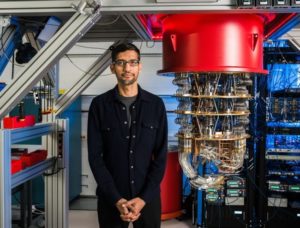

- nel maggio 2013 Google e Nasa presentano il D-Wave Two, nel Quantum Artificial Intelligence Lab, in California;

- nel febbraio 2016 IBM mette a disposizione pubblicamente l’elaboratore IBM Quantum Experience, il primo computer quantistico in modalità cloud con un processore a 5 qubit;

- a maggio 2017 IBM annuncia di aver realizzato un processore a 17 qubit più strettamente ingegnerizzato che potrebbe essere la base per sistemi commerciali;

- a giugno 2017 Google rilancia con un processore da 20 qubit e dice di voler raggiungere i 49 qubit entro la fine dell’anno;

- a ottobre 2017 IBM rilancia dicendo che attraverso la simulazione del funzionamento del computer quantistico (attraverso sistemi convenzionali) ci si può già spingere verso la “barriera” dei 56 qubit – simulazioni che per oggi sono confermate dal lavoro dello Swiss Federal Institute of Technology di Zurigo (che fino ad oggi ha simulato 45 qubit su un processore con 500 terabyte di memoria);

- a febbraio 2018 Google annuncia un nuovo traguardo: un nuovo processore per computer quantistici da 72 qubit chiamato “Bristlecone”

- a marzo 2018 l’Istituto di Fisica e Tecnologia di Mosca presenta un articolo sugli sviluppi di una Internet quantistica ad alta velocità;

- sempre nel 2018 Intel conferma lo sviluppo di un chip di test superconduttore da 49 qubit, chiamato “Tangle Lake”

- il 21 dicembre 2018, il National Quantum Initiative Act è stato firmato dalla legge dal presidente Donald Trump , stabilendo gli obiettivi e le priorità di un piano decennale per accelerare lo sviluppo delle applicazioni di scienza e tecnologia dell’informazione quantistica negli Stati Uniti;

- a gennaio 2019 IBM presenta il suo primo computer quantistico commerciale, IBM Q System One;

- sempre nel 2019 Nike Dattani e i suoi colleghi decodificano l’architettura Pegasus di D-Wave e rendono la sua descrizione aperta al pubblico.

Il futuro del computer quantistico: 2020-2021 e oltre

A descrivere il futuro – non troppo lontano – del computer quantistico è Christopher Monroe, fisico dell’Università del Maryland e fondatore di IonQ, una start-up che lavora alla realizzazione di un computer quantistico utilizzando il metodo degli ioni intrappolati. Lo fa attraverso le pagine di Scientific America in un articolo pubblicato lo scorso luglio (luglio 2018) dove compara i due metodi ad oggi prevalenti nello sviluppo dei computer quantistici: circuiti superconduttori (come quello alla cui base ci sono i sistemi di IBM Q o quelli di Google) o ioni intrappolati (su cui sta per esempio lavorando Harvard).

Facendo delle comparazioni eseguendo alcuni algoritmi identici su un sistema a ioni intrappolati da 5 qubit ed un processore superconduttore da 5 qubit, Monroe è giunto alla conclusione che le prestazioni siano simili. Lo scienziato vede però tra i due sistemi una differenza nel collegamento dei qubit: gli ioni intrappolati sono tutti collegati tra loro tramite forze elettromagnetiche mentre in un circuito superconduttore solo alcuni qubit sono connessi, condizione che potrebbe rallentare il passaggio di informazioni (e quindi qualche errore) tra un qubit e l’altro in processori che contano centinaia o migliaia di qubit.

L’aumento del numero di qubit, in realtà, rappresenta un problema per qualsiasi computer quantistico, indipendentemente dal modello architetturale adottato, perché la criticità maggiore sta nel riuscire a mantenere lo stato quantico per il tempo sufficiente all’operazione di calcolo (tenete presente che parliamo di millisecondi). «Quanto più un sistema quantistico viene estesa (espanso), quanto meno rimane nello stato quantistico», dice Monroe; significa che quanti più atomi o elettroni vengono raggruppati tanto perdono “potenza” le proprietà quantistiche delle singole particelle lasciando spazio alle regole della fisica classica.

Ad ogni modo, la visione futuristica di Monroe è positiva: secondo lo scienziato potremmo vedere sistemi contenenti alcune migliaia di qubit entro un decennio o poco più. I ricercatori capiranno cosa si potrà essere in grado di fare con computer quantistici di questa portata mano a mano che verranno costruiti.

Quantum computing: attenzione all’hype

Che il quantum computing (o computer quantistico) sia ormai realtà è innegabile, tuttavia, mettono in guardia alcuni ricercatori ed analisti, “come per qualsiasi nuova innovazione tecnologica, esiste il rischio che l’hype superi lo sviluppo del prodotto, cosa che potrebbe avere un impatto negativo su percezioni e investimenti” (fonte: Gartner). “L’hype nei media – avvertono gli analisti – sta creando consapevolezza e avanzamento, ma anche ponendo aspettative non realistiche rispetto alle tempistiche e alle capacità dei computer quantistici. Questo livello di clamore porta inevitabilmente alla disillusione, il che è pericoloso, poiché il quantum computing richiede investimenti mirati, sostenuti (e sostanziosi) nel lungo termine”.

Verso il quantum computing as a service (QCaaS)

Da un punto di vista logistico, i computer quantistici sono difficili da mantenere e richiedono ambienti specializzati raffreddati a 0,015 Kelvin. Il processore quantistico deve essere collocato in un frigorifero di diluizione schermato a 50.000 volte in meno del campo magnetico terrestre e posto in un vuoto elevato a 10 miliardi di volte inferiore alla pressione atmosferica. E’ inoltre necessario eseguire la calibrazione più volte al giorno.

Per la maggior parte delle organizzazioni, un ambiente di questo tipo non solo non è gestibile ma è praticamente impossibile da sviluppare.

Alcuni vendor, come abbiamo visto nei paragrafi precedenti, permettono già oggi di sfruttare il quantum computing come servizio (QCaaS – quantum computing as a service) per ridurre al minimo i rischi e contenere i costi.

Secondo gli analisti di Gartner, entro il 2023, il 95% delle organizzazioni che intendono utilizzare un computer quantistico o ricercano strategie di quantum computing lo farà attraverso il cloud computing e utilizzerà il QCaaS.