Fiducia e trasparenza. Sono questi i due pilastri su cui si basano normalmente i processi decisionali aziendali, due “must” che le aziende chiedono anche alle tecnologie a supporto di tali processi. Esigenze ed obiettivi non facili da raggiungere quando si parla di sistemi di intelligenza artificiale: una delle preoccupazioni maggiori delle aziende risiede infatti nel non poter sapere e controllare cosa avviene nella Black Box, nella scatola nera all’interno del quale l’intelligenza artificiale lavora arrivando ad un output (informazione, azione, conoscenza, ecc.) di cui i decisori di business non è detto che possano fidarsi, non tanto per l’output in sé quanto per la mancanza di trasparenza sulle fasi ed i processi che hanno portato il sistema a tale output.

Una criticità che oggi IBM risolve con il lancio di una nuova soluzione software, disponibile in cloud, che agisce su due livelli: rivela gli errori (eventuali errori nei dati o nelle varie fasi del processi decisionale dell’AI – Artificial Intelligence) e spiega qual è stato il processo decisionale attraverso il quale l’AI ha prodotto un determinato risultato, rendendolo così trasparente e “trusted” ai decision maker di business.

«IBM ha assunto una posizione leader nella definizione di principi di fiducia e trasparenza per lo sviluppo di nuove tecnologie basate sull’intelligenza artificiale», riporta David Kenny, SVP di Cognitive Solutions di IBM nel comunicato dell’azienda. «È tempo di mettere in pratica questi principi. Garantiamo ulteriore trasparenza e controllo alle imprese che utilizzano l’intelligenza artificiale e si trovano ad affrontare i potenziali rischi associati a un processo decisionale scorretto».

A testimonianza dell’urgenza di avere sul mercato soluzioni tecnologiche che potessero andare in questa direzione (quella del Trust and Transaprency) il fatto che, secondo quanto emerso da una recente indagine condotta dall’Institute for Business Value di IBM, mentre l’82% delle imprese stanno prendendo in considerazione la possibilità di utilizzare soluzioni di intelligenza artificiale, ben il 60% frena l’adozione per via dei timori e delle problematiche legate alla responsabilità (della decisione finale) e il 63% non dispone di competenze interne in grado di gestire in modo sicuro l’AI.

FIDUCIA E TRASPARENZA VIA CLOUD

Il nuovo servizio di IBM sfrutta modelli derivanti da una vasta gamma di strutture di apprendimento automatico e ambienti realizzati grazie a soluzioni di intelligenza artificiale come Watson, Tensorflow, SparkML, AWS SageMaker e AzureML.

Il software in cloud può essere programmato per fare in modo che le aziende possano monitorare i fattori decisionali unici di ogni flusso di lavoro; la soluzione è infatti adattabile e personalizzabile a qualsiasi ambito applicativo, è completamente automatizzata e consente alle aziende di avere una descrizione del processo decisionale (e il rilevamento di eventuali errori) in tutti i modelli di intelligenza artificiale in fase di esecuzione – cioè durante il processo decisionale stesso – catturando risultati potenzialmente inattesi nel momento stesso in cui si verificano. Durante queste verifiche, il sistema è anche in grado di raccomandare i dati da integrare al modello (sempre al fine di mitigare tutti gli eventuali errori rilevati e rendere l’output ancora più efficace).

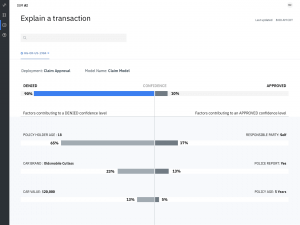

La descrizione del processo decisionale viene fornita agli utenti con termini di facile comprensione – fa sapere in una nota IBM – mostrando quali sono i fattori che hanno portato la decisione in una direzione rispetto ad un’altra, la fiducia e le variabili in una raccomandazione e i fattori che sottendono tale fiducia.

Queste descrizioni sono racchiuse poi in report e documenti che testimoniano precisione, prestazione e correttezza del modello e l’origine dei sistemi di intelligenza artificiale, tutte informazioni tracciate e richiamabili in modo semplice sia per esigenze di business sia per questioni di conformità normativa (anche in chiave GDPR).

Tutte queste funzionalità sono accessibili in cloud attraverso dashboard grafici intuitivi che non solo permettono agli utenti aziendali di comprendere, spiegare e gestire con più fiducia le decisioni basate sull’intelligenza artificiale ma anche di poter sfruttare al meglio le potenzialità dell’AI anche con competenze tecniche minori o non specialistiche. Ad ogni modo, nella proposta di IBM ci sono anche servizi di consulenza finalizzati a supportare le aziende a progettare i propri processi aziendali e interfacce uomo-intelligenza artificiale.

L’annuncio di oggi si arricchisce anche di un ulteriore passo in avanti di IBM all’interno della comunità Open Source: IBM Research metterà a disposizione della community il kit di strumenti AI Fairness 360, una libreria di nuovi algoritmi, codici e tutorial che forniranno ad accademici, ricercatori e data scientist strumenti ed informazioni per integrare la rilevazione di bias in fase di realizzazione e applicazione di modelli di apprendimento automatico. L’obiettivo è fare in modo che si lavori su “fiducia e trasparenza” fin dalle primissime fasi di sviluppo dell’AI, non solo quindi quando viene utilizzata.

INTELLIGENZA ARTIFICIALE: PRIORITA’ ED OSTACOLI

L’Intelligenza artificiale è indubbiamente oggetti di “studio” da parte delle aziende di tutto il mondo che stanno cercando di capirne il potenziale all’interno delle proprie organizzazioni in termini di valore, efficienza, crescita del business, ecc.

In base all’AI 2018 Report, uno studio condotto dall’IBM Institute for Business Value su oltre 5mila C-Suite executive, l’82% delle imprese e il 93% delle imprese ad alto rendimento stanno attualmente prendendo in considerazione (o già portando avanti) l’idea di adottare l’intelligenza artificiale quale elemento di innovazione per generare fatturato, come strumenti quindi in grado di incidere sulla redittività aziendale.

I timori, come accennato, sono legati alle questioni associate alla responsabilità e all’inadeguatezza delle competenze. Freni che dovranno presto essere superati dato che i CEO interpellati intendono catturare il valore dell’AI in differenti aree, dall’IT alla sicurezza informatica, passando per l’innovazione, l’assistenza clienti e anche la gestione dei rischi. Un percorso che, se “rassicurato” da processi decisionali più trasparenti, contribuirà a far crescere e maturare ulteriormente l’AI stessa.