Nell’adozione di strumenti di intelligenza artificiale, è importante definire e adottare un modello di percorso di maturazione o più semplicemente “maturity model” chiaramente delineato. L’adozione di un modello di maturità ha lo scopo dichiarato di creare un percorso pratico, logico, armonioso ed efficace per l’azienda che a partire dalla fase esplorativa porti all’adozione a scala degli strumenti di intelligenza artificiale, per arrivare in ultimo ad un passo “trasformativo” dei processi e dell’organizzazione che vengono quindi ridisegnati al fine di sfruttare al meglio le opportunità offerte da queste nuove tecnologie. Ecco come ciò può avvenire nel settore insurance.

Adottare l’AI significa nuovi modelli di controllo e qualità?

Alcune domande nascono spontanee: seguire un percorso delineato di maturazione impone implicitamente un’esigenza di trasformazione, oltre chiaramente quelle organizzative, in settori prima consolidati come ad esempio i sistemi informativi aziendali? L’adozione dell’intelligenza artificiale implica l’adozione di modelli di controllo e qualità nuovi o comunque diversi da quelli fin ora adottati?

La risposta, secondo noi, è che in effetti sussistono ulteriori esigenze o, detto in altro modo, ulteriori requisiti devono essere soddisfatti affinché gli strumenti di artificial intelligence possano essere utilizzati appieno.

Questi requisiti si articolano in due pilastri principali:

- un’architettura del sistema informativo che sia disegnato per e in virtù dell’adozione di strumenti di AI

- un opportuno framework di controllo della qualità dell’artificial intelligence utilizzata che si espande dalla fase di “inception” fino alla fase operativa della qualità dei sistemi di intelligenza artificiale che intendiamo illustrare più diffusamente di seguito.

L’evoluzione dei sistemi informativi nel settore insurance

Operazionalizzare l’AI non è semplice. In questa fase di sviluppo del mercato insurance, la velocità di implementazione è una variabile critica per la competitività. Una volta iniziato il percorso, si deve lavorare intensamente, così come sta facendo Helvetia, per mantenere l’equilibrio nei passaggi tra le fasi e nella copertura delle dimensioni operative.

Helvetia ha deciso di adottare l’AI per riportare, ad alto livello, i principali settori operativi aziendali e i benefici attesi nel breve e medio termine. Helvetia ha scelto il modello di maturity da perseguire e gli strumenti di IA da integrare nei processi aziendali in base a specifici principi guida e requisiti che insieme contribuiranno alla trasformazione dei sistemi informativi aziendali.

Sfruttare inoltre le applicazioni alimentate dall’AI ha un impatto multiforme e richiede sia un ambiente operativamente favorevole sia un sistema informativo “best of breed”, di concezione moderna ed allineato, in ultima analisi, alle sfide tecnologiche imposte dall’adozione dell’intelligenza artificiale.

In questo contesto è chiaro che il primo step per una corretta implementazione di processi “AI fueled” è, per l’appunto, il controllo dei processi. Quindi un primo passo nella revisione del sistema informativo è chiaramente poter assicurare che i processi aziendali core siano correttamente mappati e controllati dal backbone IT.

In particolare, a mano a mano che l’azienda ha progredito nelle milestones del maturity model, ci si è resi conto della necessità di passare a un sistema informativo che cambi totalmente paradigma, implementando un paradigma “proattivo” invece di un paradigma “reattivo”.

AI e insurance: un esempio nella gestione dei sinistri

A titolo di esempio per ciò che riguarda il sottosistema di gestione dei sinistri, è diventato chiaro che per sfruttare al meglio le potenzialità date dall’intelligenza artificiale è necessario passare da un modello di tipo “pull”, dove gli attori del processo provvedono alla promozione del processo, a un modello di tipo “push”, dove il sistema stesso promuove il processo e gli attori, come il sistema stesso, reagiscono.

I concetti cardine, ad alto livello di astrazione, sono esplicitabili quindi in un sistema che:

- catturi gli eventi (e.g. sui processi di customer inbound, durante la trattazione del sinistro)

- arricchisca gli eventi nel modo più indipendente possibile dagli utenti mediante strumenti di artificial intelligence dove possibile

- prenda decisioni in parziale o totale autonomia rispetto agli operatori umani soprattutto in relazione alla “next-best-action” da attuare in reazione all’evento ricevuto. Questo sempre basandosi il più possibile su strumenti di artificial intelligence che alla fine abbia una serie di “attuatori” che lavorano in base alle informazioni ricevute, siano questi strumenti automatici od operatori del sistema.

In questo contesto diventa chiaro che gli ambiti più importanti in cui l’artificial intelligence viene utilizzata siano strumenti per la comprensione dell’input, tra cui spiccano sicuramente strumenti in grado di comprendere in senso “ampio” l’input legato all’evento, riescano ad estrarre e validare in autonomia il contenuto dello stesso ed arricchirlo di ulteriori informazioni e abbiano l’abilità di presentare in modo preciso ma succinto le informazioni agli operatori umani.

Un secondo ambito più specifico sono le iniziative legate all’automazione della “next best action”. In questo caso l’obiettivo è di ottenere parti del sistema che possano lavorare in autonomia rispetto alle decisioni dell’utente umano su tutta una serie di questioni relative al processo.

È chiaro che in questo contesto l’utilizzo dell’intelligenza artificiale diventa sistemico ed è quindi necessario dotarsi innanzitutto di concetti chiari di qualità, controllo e assessment delle soluzioni di intelligenza artificiale utilizzate

Nell’insurance è importante la qualità dell’AI

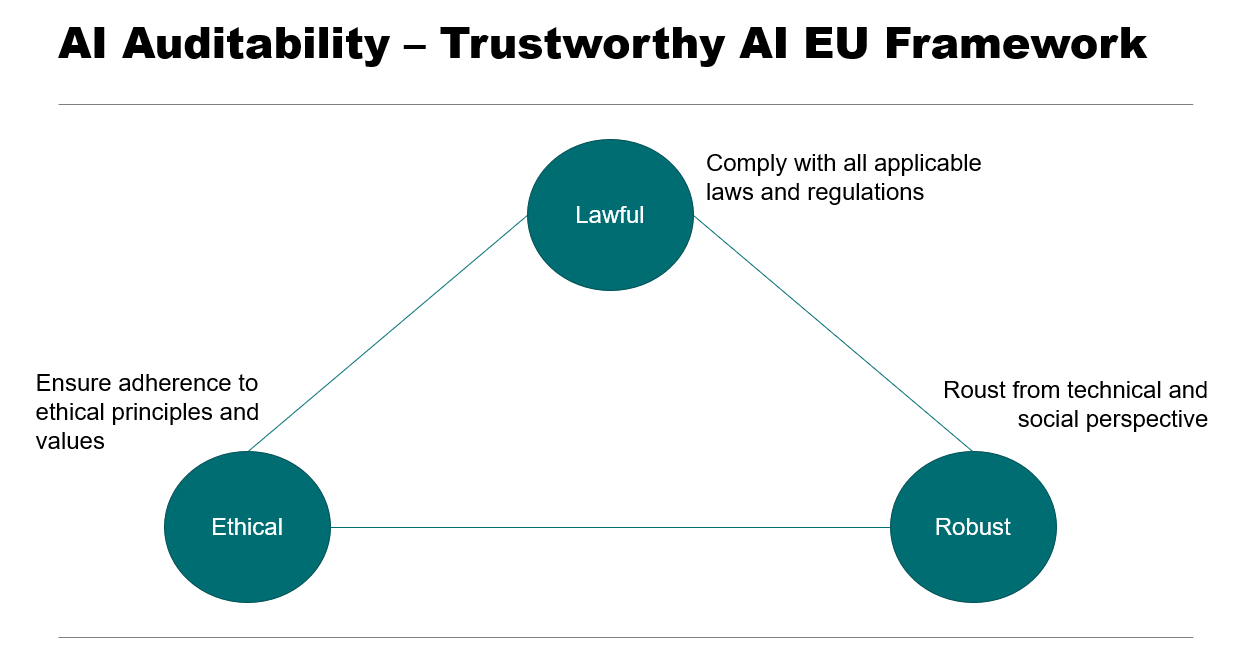

Il secondo punto qualificante è sicuramente la qualità dell’intelligenza artificiale utilizzata. In questo contesto l’importanza principale, diciamo proprio il “prerequisito”, è l’utilizzo di strumenti, practice e governance, che soddisfino primariamente i cosiddetti principi di “AI auditability” o, con altre parole, l’utilizzo di strumenti, practice e governance a lungo termine, che soddisfino le guidelines emesse primariamente dalla commissione europea (cfr. Ethics Guidelines for Trustworthy AI – High-Level Expert Group on Artificial Intelligence by the EU Commission – 2019) e le successive linee guida emesse da IVASS (cfr IVASS Governance dell’artificial intelligence nel settore assicurativo tra principi etici, responsabilità del board e cultura aziendale).

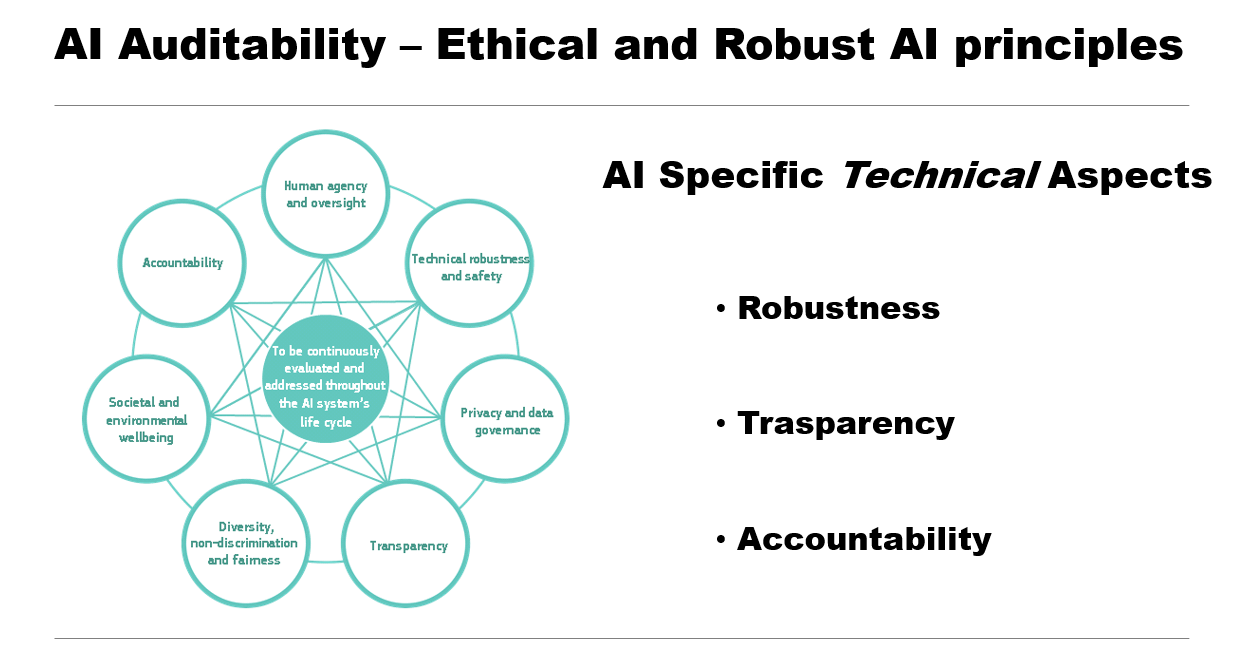

Concentrandosi sugli aspetti tecnici ciò implica che gli strumenti, la practice e la governance dell’AI devono rispondere a principi di “etica e robustezza”. Lungi dall’essere una generica fraseologia, i principi di etica e robustezza si declinano invece in specifiche azioni e pratiche di adozione e governo.

Queste pratiche si estendono sia nella parte più pura di inception dei modelli di artificial intelligence (qualsiasi tecnologia essi utilizzino, dai semplici modelli di machine learning alle tecniche più sofisticate di deep learning) quali ad esempio:

- stabilità

- robustezza

- manutenibilità

Che a loro volta si declinano in precise practice di data science che devono obbligatoriamente essere utilizzate in questi contesti.

Inoltre, deve essere necessariamente coperta la fase di assessment, come parte dell’outcome e manutenibilità a lungo termine dei modelli utilizzati, quale:

- analisi dell’errore

- replicabilità

Per finire con due concetti, se vogliamo, ancora più importanti quali il monitoraggio in produzione (analisi del drifting e analisi di robustezza in produzione) e “explainability”.

Quest’ ultimo concetto, è particolarmente importante, anzi è un concetto chiave. È necessario ricordare che l’utilizzo dell’AI in ogni contesto dove vi sia un impatto diretto sul cliente (ad esempio dinamica del prezzo piuttosto che rifiuto di sottoscrivere una polizza), implica fornire un livello di spiegazione al cliente stesso comprensibile senza essere autoreferenziali (e.g. l’AI ha suggerito che). Ciò che è particolarmente sfidante in questo contesto è il concetto di “livello di spiegazione comprensibile al cliente” che implica normalmente un doppio step: il primo tecnico legato all’utilizzo di modelli di technical explainability che possono o meno essere legati al tipo di modello usato e un secondo step in cui queste informazioni, ancora a livello tecnico, vengono convertite in uno o più informazioni chiaramente comprensibili al cliente. In questo contesto l’utilizzo di scoreboard semplificative ove possibile, piuttosto che strumenti più tecnici di AI explainability (come SHAP, Anchor) opportunamente tradotti in termini elementari, sono strumenti più che benvenuti.

Conclusioni

Un ultimo punto importante, che ha meno a che fare direttamente con l’utilizzo specifico dell’artificial intelligence, è la raccomandazione di sviluppare, ogni qualvolta le decisioni siano prese da un agente non umano, un model risk scoreboard direttamente collegato con le performance attese e i di “produzione”, al fine di garantire che l’automazione intrapresa continui a portare i benefici (di tempo e o monetari) e che questi siano sempre congruenti con l’eventuale rischio assunto. Lo sviluppo dei modelli di rischio al momento trascende direttamente la practice dell’AI ma è invece ben compreso da chi, oltre le practice di artificial intelligence, ha esperienza nella modellazione matematica di alto livello.