L’ingresso nell’era dell’Intelligenza Artificiale Generativa è segnato da un’esperienza utente apparentemente semplice ma profondamente disorientante: la scomparsa delle guide visive. Per oltre quarant’anni, l’interazione tra essere umano e computer è stata mediata e strutturata da interfacce grafiche rigide (GUI – Graphical User Interfaces). Dagli anni Ottanta fino all’avvento dei moderni sistemi SaaS, il paradigma dominante è stato quello del “binario”: l’utente si muoveva all’interno di percorsi predefiniti da programmatori, interagendo attraverso menu a tendina, pulsanti, caselle di controllo e moduli precompilati. In quel contesto, l’azione era limitata alle opzioni visibili; l’errore era circoscritto, ma lo era anche la libertà operativa. L’interfaccia fungeva da mappa cognitiva, suggerendo implicitamente cosa fosse possibile fare e come farlo.

Oggi, aprendo strumenti basati su Large Language Models (LLM) come ChatGPT, Claude o Gemini, si presenta uno scenario diametralmente opposto: una casella di testo bianca, un cursore lampeggiante e nessuna istruzione esplicita. Questa vacuità interfacciale nasconde una complessità gestionale senza precedenti nella storia dell’informatica consumer. La rimozione dei vincoli, se da un lato promette una creatività potenzialmente infinita, dall’altro genera frequentemente la cosiddetta “paralisi decisionale”.

Senza binari, l’utente medio fatica a comprendere l’ampiezza delle capacità del sistema. Molti professionisti, dopo un iniziale entusiasmo dettato dalla novità, abbandonano questi strumenti etichettandoli come inaffidabili o superficiali. Tuttavia, l’errore non risiede quasi mai nella capacità tecnologica del modello sottostante, bensì in un deficit comunicativo strutturale dell’operatore umano.

Interagire con un sistema di intelligenza artificiale generativa richiede un nuovo tipo di competenza, definibile come prompt engineering. Non si tratta semplicemente di “saper scrivere” o di conoscere trucchi linguistici, ma di una forma di programmazione ad alto livello che utilizza il linguaggio naturale come compilatore.

Per padroneggiare questa disciplina è necessario superare la visione antropomorfa della macchina e comprendere la natura profonda, statistica e probabilistica del suo funzionamento.

Indice degli argomenti:

Dalle origini al fallimento della logica simbolica

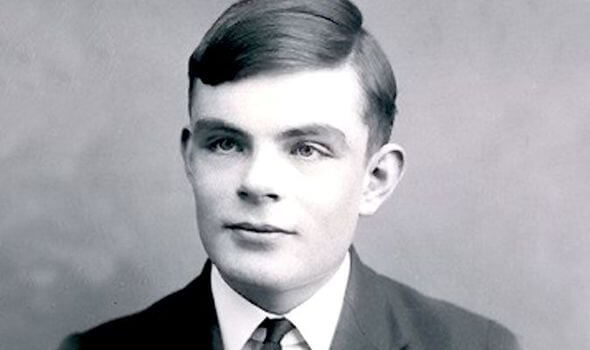

Per comprendere la “mente” della macchina, è indispensabile analizzare l’evoluzione storica che ha portato alla tecnologia attuale. Tutto ha origine nel 1950, quando il matematico britannico Alan Turing pubblicò sulla rivista Mind l’articolo seminale “Computing Machinery and Intelligence”. Turing propose di sostituire la domanda filosofica irrisolvibile “Le macchine possono pensare?” con un test operativo, il “Gioco dell’imitazione”: se una macchina è in grado di sostenere una conversazione testuale in modo indistinguibile da un essere umano, allora può essere considerata intelligente ai fini pratici.

Per decenni, l’informatica ha tentato di superare questo test seguendo un approccio deduttivo, noto come GOFAI (Good Old-Fashioned AI) o Intelligenza Artificiale Simbolica. L’assunto di base era che l’intelligenza fosse riducibile alla manipolazione di simboli logici secondo regole fisse. Si riteneva che, scrivendo un numero sufficiente di regole “Se-Allora” (If-Then), fosse possibile codificare la conoscenza umana.

Tuttavia, il paradigma simbolico si scontrò con un muro invalicabile quando tentò di affrontare la complessità disordinata del mondo reale. La realtà è piena di sfumature, ambiguità e contesti non codificabili in regole rigide. Non è possibile scrivere una regola logica univoca per descrivere come riconoscere un volto umano o come tradurre l’ironia.

Questo fallimento portò ai cosiddetti “inverni dell’AI”, periodi di stagnazione e tagli ai fondi di ricerca, durante i quali divenne evidente che non si poteva programmare l’intelligenza scrivendo manualmente le istruzioni.

Il cambio di paradigma: Software 1.0 vs Software 2.0 e le radici statistiche

La rinascita dell’AI deriva dal passaggio dall’approccio deduttivo a quello induttivo, ovvero la nascita del Machine learning. Questa transizione è stata efficacemente descritta da Andrej Karpathy come il passaggio dal Software 1.0 al Software 2.0.

Nel Software 1.0, l’essere umano scrive il codice. Nel Software 2.0, l’essere umano fornisce i dati e l’output desiderato, delegando alla macchina il compito di trovare le regole matematiche che li collegano.

Le prime forme di questo apprendimento automatico erano basate su concetti statistici classici: la regressione lineare e la regressione logistica.

Nella regressione lineare, l’algoritmo tenta di tracciare una linea retta che meglio approssima la relazione continua tra due variabili (ad esempio, prevedere il prezzo di una casa in base ai metri quadri).

Nella regressione logistica, utilizzata per la classificazione, l’algoritmo separa i dati in due categorie discrete (Sì/No, Spam/Non Spam) attraverso una funzione sigmoidea che mappa i risultati tra 0 e 1.

Questi modelli, pur essendo fondamentali e ancora oggi utilizzati per problemi semplici, presentavano un limite insormontabile: la linearità. Non erano in grado di comprendere relazioni complesse o non lineari (come il famoso problema dello XOR), a meno che un essere umano non intervenisse manualmente per trasformare i dati in ingresso (Feature Engineering).

Se i dati avevano una struttura complessa, come i pixel di un’immagine, questi algoritmi erano sostanzialmente ciechi.

Dal silicio alla biologia: la genesi del neurone artificiale

Di fronte ai limiti della statistica lineare, la ricerca scientifica ha cercato ispirazione nell’unica macchina pensante esistente in natura: il cervello umano. Per costruire un sistema capace di apprendere funzioni complesse, si è reso necessario replicare l’unità atomica fondamentale della cognizione: il neurone.

Il modello biologico

Il neurone biologico è una cellula specializzata nella trasmissione di informazioni elettrochimiche. La sua struttura si compone di tre elementi funzionali principali:

- Dendriti: ramificazioni che agiscono come ricevitori, raccogliendo i segnali chimici provenienti da altri neuroni.

- Soma (Corpo cellulare): l’unità di elaborazione centrale che aggrega i segnali elettrici in ingresso.

- Assone: il canale di trasmissione che trasporta il segnale in uscita verso altri neuroni attraverso le sinapsi.

Il funzionamento è basato su una soglia di attivazione: il neurone non trasmette tutto ciò che riceve. Esso somma i segnali eccitatori e inibitori; solo se il potenziale elettrico complessivo supera una certa soglia critica, il neurone “spara” (fires) un potenziale d’azione lungo l’assone. Questo meccanismo “tutto o niente” è la base del calcolo biologico.

La traduzione matematica: il perceptron

Nel 1958, lo psicologo Frank Rosenblatt formalizzò questo processo biologico in un modello matematico chiamato perceptron (o neurone artificiale).

La traduzione dall’anatomia all’algebra è diretta:

- I segnali in ingresso (input) sono rappresentati da variabili numeriche ($x$).

- La forza delle sinapsi è rappresentata da pesi ($w$): un peso elevato significa che quell’input è importante, un peso negativo significa che è inibitorio.

- Il Soma diventa una sommatoria pesata: l’algoritmo moltiplica ogni input per il suo peso e somma i risultati, aggiungendo un valore di bias ($b$) che funge da soglia di attivazione.

- Infine, il “potenziale d’azione” è simulato da una funzione di attivazione non lineare (come la ReLU o la sigmoide), che decide se e con che intensità il neurone debba attivarsi.

Questa astrazione matematica ha permesso di passare dal calcolo rigido al calcolo adattivo: il neurone “impara” semplicemente modificando i suoi pesi ($w$) per ridurre l’errore nella risposta.

L’ascesa delle Reti Neurali Profonde: MLP e Forward propagation

Un singolo neurone, tuttavia, può risolvere solo problemi elementari. La vera potenza computazionale emerge dalla connessione di migliaia di neuroni artificiali in strutture complesse a strati chiamate MLP (Multi-Layer Perceptron).

Un MLP è organizzato gerarchicamente: uno strato di input, uno o più “strati nascosti” (hidden layers) intermedi, e uno strato di output.

Il funzionamento di un MLP si basa su due fasi distinte che costituiscono il ciclo di vita dell’elaborazione neurale:

- Forward propagation (propagazione in avanti): I dati entrano nella rete e attraversano i vari strati. In ogni strato, l’output dei neuroni precedenti diventa l’input dei successivi. L’informazione fluisce in una sola direzione, subendo trasformazioni non lineari sempre più complesse, fino a produrre una previsione finale. È la fase dell’inferenza.

- Training e backpropagation: Una volta ottenuta la previsione, questa viene confrontata con il risultato corretto (ground truth). La differenza matematica è l’errore (Loss Function). Attraverso l’algoritmo fondamentale di backpropagation (retropropagazione), formalizzato nel 1986 da Rumelhart, Hinton e Williams, la rete ripercorre il tragitto all’indietro. Calcola matematicamente di quanto ogni singolo peso ha contribuito all’errore e aggiorna impercettibilmente i miliardi di connessioni per ridurre l’errore nel tentativo successivo.

La specializzazione percettiva: CNN e YOLO

Sebbene gli MLP fossero teoricamente capaci di apprendere qualsiasi funzione, il collegamento di ogni neurone con tutti gli altri creava una complessità computazionale ingestibile per dati ricchi come le immagini.

La soluzione per la visione artificiale arrivò con le CNN (Convolutional Neural Networks). Ispirate alla corteccia visiva, le CNN non analizzano l’immagine intera come una singola riga di dati, ma utilizzano “filtri” (convoluzioni) che scorrono sull’immagine per identificare pattern locali.

I primi strati riconoscono linee e bordi; gli strati successivi combinano le linee in forme geometriche; gli strati profondi riconoscono oggetti complessi (occhi, ruote, volti). Le CNN introducono l’invarianza spaziale: un gatto viene riconosciuto sia che si trovi al centro della foto sia in un angolo.

L’evoluzione della velocità in questo ambito ha portato ad architetture come YOLO (You Only Look Once). A differenza delle CNN tradizionali che scansionavano l’immagine più volte per trovare oggetti, YOLO applica un’unica rete neurale all’intera immagine, dividendo la scena in una griglia e prevedendo simultaneamente le coordinate degli oggetti e le loro classi.

Questo ha permesso la computer vision in tempo reale, fondamentale per la guida autonoma.

Il problema della memoria sequenziale: RNN e i loro limiti

Mentre le CNN risolvevano il problema dello spazio (immagini), rimaneva il problema del tempo (linguaggio). Il testo è intrinsecamente sequenziale: l’ordine delle parole determina il significato.

Per gestire questo, furono introdotte le RNN (Recurrent Neural Networks). Queste reti possiedono un “loop” interno che permette all’informazione di persistere: l’output dell’elaborazione della parola precedente viene reimmesso come input per la parola successiva.

Tuttavia, le RNN soffrivano di un difetto critico noto come “vanishing gradient” (Gradiente che svanisce). In frasi lunghe o paragrafi, l’influenza matematica delle prime parole si diluiva progressivamente fino a scomparire durante la retropropagazione.

La rete “dimenticava” il soggetto della frase prima di arrivare al verbo finale, rendendo impossibile la generazione di testi lunghi e coerenti.

Generative AI e le architetture creative: autoencoder e GAN

Prima di arrivare ai moderni LLM, un altro tassello fondamentale è stato lo sviluppo di architetture capaci non solo di classificare (discriminative), ma di creare dati nuovi (generative).

Gli autoencoder hanno introdotto il concetto di compressione e ricostruzione. Un autoencoder è composto da un encoder che comprime i dati di input in una rappresentazione astratta e compatta (spazio latente o bottleneck), e un decoder che tenta di ricostruire l’input originale partendo da quella rappresentazione. L’innovazione risiede nello spazio latente: la macchina impara una mappa concettuale dei dati.

Parallelamente, le GAN (Generative Adversarial Networks) hanno introdotto l’idea della competizione. Due reti neurali vengono messe l’una contro l’altra: il generatore cerca di creare dati falsi realistici, il discriminatore cerca di distinguere i dati veri da quelli falsi. In questo gioco a somma zero, il generatore diventa sempre più abile nel produrre dati sintetici indistinguibili dalla realtà.

La sintesi finale: Transformer e Next Token Prediction

La convergenza di tutte queste evoluzioni ha portato, nel 2017, alla nascita del Transformer. Questa architettura supera i limiti delle RNN abbandonando la sequenzialità temporale. Grazie al meccanismo di Self-Attention (Auto-Attenzione), il Transformer analizza l’intera frase simultaneamente, calcolando il peso relazionale di ogni parola rispetto a tutte le altre.

Un Large Language Model (LLM) moderno è quindi un Transformer addestrato su un compito specifico: la Next Token Prediction. Non è un database di conoscenza fattuale, ma un motore probabilistico. Data una sequenza di input, il modello calcola la distribuzione di probabilità statistica del prossimo frammento di parola (token) più plausibile.

Quando scriviamo “Il cielo è…”, il modello assegna probabilità diverse a “azzurro” (70%), “grigio” (20%) o “limpido” (10%), e ne campiona una.

Quando l’AI genera una risposta, non sta recuperando la verità; sta campionando una continuazione plausibile dalla sua distribuzione statistica. Questo spiega le due caratteristiche fondamentali degli LLM:

- Creatività: poiché il modello non sceglie sempre la parola più probabile al 100% (parametro regolabile chiamato “temperatura”), può generare combinazioni di parole nuove e originali mai viste prima.

- Allucinazioni: poiché il modello non ha un concetto di verità fattuale, ma solo di plausibilità linguistica, può generare frasi sintatticamente perfette ma fattualmente false. Se la sequenza di parole che descrive una legge inesistente è statisticamente coerente con lo stile dei testi giuridici che ha letto, il modello la genererà con sicurezza.

Il prompt engineering, dunque, non è un dialogo con un essere senziente. È l’atto di fornire al modello una sequenza iniziale di token (il prompt) accuratamente progettata per costringere la distribuzione di probabilità a collassare verso l’area semantica desiderata, escludendo le risposte generiche o allucinate.

I tre pilastri del prompting: contesto, istruzione e vincolo

Un prompt efficace in ambito professionale si distingue nettamente dal linguaggio colloquiale per la presenza di una struttura ingegneristica rigorosa. Affinché il modello probabilistico converga verso un output di alta qualità, è necessario manipolare tre variabili fondamentali.

1. Il contesto e il “persona pattern”

Poiché il modello è stato addestrato su un corpus di dati eterogeneo che include tutto lo scibile umano (dalla letteratura medica ai forum di videogiochi, dal codice Python alla poesia), esso contiene al suo interno migliaia di “personalità latenti”. Senza una specifica direttiva, il modello risponde attivando una media statistica generica: un assistente servizievole ma superficiale e privo di stile definito.

Per ottenere risultati eccellenti, è necessario attivare la porzione specifica della rete neurale pertinente al compito. Questo si ottiene assegnando un ruolo, tecnica nota come persona pattern.

Un prompt che inizia con “Agisci come un senior financial analyst con 20 anni di esperienza in fusioni e acquisizioni” modifica radicalmente i pesi probabilistici delle parole successive. Il modello abbasserà la probabilità di termini colloquiali e alzerà quella del gergo tecnico finanziario, adottando una struttura di frase più analitica e formale. Il contesto agisce come un filtro che esclude le porzioni di conoscenza irrilevanti.

2. L’istruzione tassonomica (il task)

In un sistema probabilistico, l’ambiguità è il principale fattore di fallimento. Verbi deboli o generici come “Pensa a…”, “Vedi se…” o “Guarda questo testo” lasciano al modello un eccessivo grado di libertà interpretativa, portando spesso a risultati disomogenei.

L’ingegneria del prompt richiede l’uso di verbi forti e tassonomici che definiscano inequivocabilmente l’operazione logica richiesta: “Analizza”, “Classifica”, “Riassumi”, “Estrai”, “Traduci”, “Formatta”.

Inoltre, per compiti complessi, è fondamentale la scomposizione. A causa dei limiti dell’architettura Transformer nel mantenere il focus su istruzioni troppo dense, è preferibile spezzare un compito macroscopico in una serie di passaggi sequenziali (Chain of prompting), guidando la macchina step-by-step verso il risultato finale.

3. Il vincolo (positivo e negativo)

Spesso, per ottenere l’output desiderato, è più efficace indicare al modello cosa non fare piuttosto che cosa fare. I vincoli agiscono come barriere di contenimento che tagliano i rami dell’albero delle probabilità che porterebbero a risposte indesiderate.

I vincoli possono essere di formato (“Restituisci l’output solo in formato JSON”, “Usa elenchi puntati”), di lunghezza (“Massimo 200 parole”) o di stile (“Non usare aggettivi sensazionalistici”, “Evita premesse morali o introduzioni di cortesia”).

L’applicazione di vincoli negativi è particolarmente utile per ridurre il “rumore” nella risposta, risparmiando token (e quindi costi e tempo di calcolo) e rendendo il risultato immediatamente utilizzabile in contesti aziendali senza necessità di editing manuale.

Metodologie standardizzate: il framework CO-STAR

Per evitare l’anarchia operativa, dove ogni operatore formula richieste in modo diverso ottenendo risultati incostanti, le organizzazioni stanno adottando framework standardizzati per la strutturazione dei prompt. Uno dei modelli più efficaci e completi, derivato dalle best practice della community tecnica, è l’acronimo CO-STAR. Questo schema assicura che tutte le variabili necessarie siano esplicitate.

- C – Context (Contesto): fornisce lo scenario di fondo e il ruolo dell’AI.

- Esempio: “Sei un esperto di comunicazione di crisi per un’azienda di logistica internazionale.”

- O – Objective (Obiettivo): definisce chiaramente cosa si vuole ottenere.

- Esempio: “L’obiettivo è scrivere una bozza di email per informare i clienti B2B di un ritardo nelle spedizioni a causa di uno sciopero portuale.”

- S – Style (Stile): Indica lo stile di scrittura desiderato, spesso citando autori o aggettivi specifici.

- Esempio: “Stile professionale, empatico ma fermo, trasparente, privo di burocratese.”

- T – Tone (Tono): definisce l’atteggiamento emotivo della comunicazione.

- Esempio: “Rassicurante, orientato alla soluzione, scusandosi per il disagio senza ammettere colpa legale.”

- A – Audience (Pubblico): specifica a chi è rivolto il testo, permettendo al modello di calibrare la complessità lessicale.

- Esempio: “I destinatari sono Responsabili Acquisti e Supply Chain Manager, quindi usa terminologia tecnica appropriata.”

- R – Response (Formato): impone il formato di output.

- Esempio: “Restituisci il testo pronto per l’invio, includendo tre opzioni per l’oggetto della mail.”

L’adozione rigorosa di strutture come CO-STAR trasforma l’interazione da arte soggettiva a processo industriale replicabile.

Tecniche cognitive avanzate: insegnare alla macchina a ragionare

Oltre alla struttura sintattica, la ricerca accademica recente ha identificato specifiche tecniche che migliorano le capacità di ragionamento logico dei modelli, sfruttando le peculiarità del meccanismo di Attenzione. Due delle più potenti sono il Few-Shot Prompting e la Chain-of-Thought.

Few-Shot Prompting (apprendimento per esempi)

I Large Language Model sono definiti “Few-Shot Learners“, come dimostrato nel paper fondamentale su GPT-3 (“Language Models are Few-Shot Learners”, Brown et al., 2020).

L’approccio standard, in cui si dà solo l’istruzione (“Traduci questo testo”), è detto Zero-Shot. Tuttavia, fornire al modello alcuni esempi concreti di input e output desiderato all’interno del prompt aumenta l’accuratezza in modo esponenziale.

Se si deve classificare il “sentiment” di recensioni complesse, invece di chiedere solo “Classifica questo testo”, si fornisce una serie di esempi:

- “Input: Il prodotto è arrivato rotto. -> Output: Negativo (Logistica).”

- “Input: Funziona bene ma il manuale è confuso. -> Output: Neutro (Usabilità).”

- “Input: [Nuovo testo da analizzare] -> Output: …”

Il modello, analizzando gli esempi, deduce non solo il compito ma anche il formato esatto e la logica di classificazione implicita, completando il pattern. Questa tecnica permette di “programmare” il comportamento del modello senza doverne modificare i pesi interni (Fine-Tuning).

Chain of Thought (catena di pensiero)

Per compiti logici, matematici o strategici, gli LLM tendono a fallire se forzati a rispondere immediatamente. Questo accade perché il modello tenta di predire il token della risposta finale senza aver generato i passaggi intermedi necessari al calcolo.

La tecnica Chain-of-Thought (CoT), introdotta dai ricercatori di Google Brain nel 2022 (“Chain-of-Thought Prompting Elicits Reasoning in Large Language Models”, Wei et al.), consiste nell’imporre al modello di esplicitare il processo di ragionamento.

Aggiungendo al prompt la frase chiave “ragioniamo passo dopo passo” (Let’s think step by step), si costringe l’AI a generare testo intermedio. Poiché ogni parola generata diventa parte del contesto per la parola successiva, il modello utilizza il proprio output come “memoria di lavoro” per guidarsi verso la soluzione.

È la differenza cognitiva tra chiedere a uno studente di dare il risultato di un’espressione matematica complessa a mente (spesso errato) o di svolgerla passaggio per passaggio su un foglio di carta (spesso corretto). L’esplicitazione del pensiero riduce drasticamente gli errori di logica e le allucinazioni in compiti complessi.

Mitigazione delle allucinazioni: la tecnica del grounding

Nonostante le tecniche avanzate, il rischio intrinseco degli LLM rimane l’allucinazione: la generazione di fatti inventati ma plausibili. Questo fenomeno deriva dalla natura stessa del modello, che è un motore di completamento probabilistico e non un archivio di fatti verificati. Se interrogato su un argomento di cui ha pochi dati di training, il modello riempirà i vuoti informativi con parole statisticamente coerenti ma false.

Per l’utilizzo aziendale sicuro, è imperativo adottare la tecnica del grounding (ancoraggio). Questo approccio inibisce la componente “creativa” e mnemonica del modello, trasformandolo in un analista di dati forniti dall’esterno.

Un prompt “grounded” non chiede “Cosa sai del progetto X?” (attingendo alla memoria fallibile del training), ma fornisce il testo dei documenti relativi al progetto e ordina:

“Utilizzando esclusivamente il testo fornito qui sotto tra i delimitatori, rispondi alla domanda. Non utilizzare conoscenze esterne. Se la risposta non è presente nel testo fornito, rispondi ‘Informazione non disponibile’, non inventare nulla.”

Questo vincolo costringe il meccanismo di Attenzione a focalizzarsi solo sui token forniti nel prompt, riducendo le allucinazioni quasi a zero e rendendo le risposte verificabili. Questa logica è alla base dei moderni sistemi RAG (Retrieval-Augmented Generation), che automatizzano il processo di recupero dei documenti prima di generare la risposta.

Il system prompt e la governance aziendale

Infine, nelle implementazioni aziendali professionali (tramite API o piattaforme Enterprise), esiste un livello di controllo superiore invisibile all’utente finale: il system prompt (o system message).

Impostato dagli amministratori IT o dagli sviluppatori, questo prompt è un’istruzione persistente che precede ogni conversazione e agisce come una “costituzione” comportamentale del modello.

Un system prompt tipico potrebbe recitare: “Sei l’assistente AI ufficiale dell’azienda X. Rispondi sempre in modo formale. Non fornire mai consigli legali, medici o finanziari. Se l’utente chiede codice informatico, forniscilo solo in Python. Rifiuta di rispondere a domande che violano le policy etiche aziendali.”

Questo livello di controllo centralizzato assicura che, indipendentemente dall’abilità di prompting del singolo dipendente, l’AI rimanga sempre allineata all’identità, al tono di voce e alle norme di sicurezza dell’organizzazione.

Governance e safety reviews: oltre l’algoritmo

Infine, l’uso di questi modelli in produzione richiede un livello di supervisione che va oltre il semplice prompt dell’utente. Prima che un modello venga rilasciato, subisce rigorose safety reviews.

Il processo include il red teaming, dove gruppi di esperti umani e algoritmi avversari cercano intenzionalmente di “rompere” il modello, facendogli generare contenuti tossici, discriminatori o pericolosi per identificare le falle di sicurezza.

L’addestramento stesso viene raffinato tramite RLHF (Reinforcement Learning from Human Feedback): gli esseri umani valutano diverse risposte generate dal modello, e queste preferenze vengono usate per ri-calibrare i pesi finali, allineando l’output ai valori umani di sicurezza e utilità.

Nelle aziende, questo si traduce nell’uso di system prompt (istruzioni invisibili che governano il comportamento dell’AI) e guardrail che filtrano input e output, garantendo che l’interazione rimanga conforme alle policy aziendali.

Conclusione: il prompt come codice

In conclusione, il prompt engineering non è una “chiacchierata” col computer, ma l’apice di settant’anni di evoluzione informatica. Dalla rigidità della regressione lineare alla plasticità del neurone biologico, fino alla potenza dei Transformer, abbiamo costruito macchine che non eseguono più solo ordini, ma inferiscono intenzioni.

L’operatore moderno deve comprendere questa stratificazione tecnica: sapere che dietro una risposta c’è un processo di forward propagation, che la creatività è una navigazione in uno spazio latente e che l’allucinazione è un effetto collaterale statistico ineliminabile. Solo con questa consapevolezza tecnica è possibile passare da utenti passivi a direttori d’orchestra di questa intelligenza aliena.

Tuttavia, l’uso di questi strumenti introduce nuovi rischi: inserire dati aziendali in questi prompt apre voragini di sicurezza. Come proteggere i segreti industriali quando si parla con un modello cloud? La gestione della shadow AI e della sovranità del dato è la prossima sfida critica.