I Large Language Model (LLM) stanno dimostrando delle capacità sorprendenti ma non brillano laddove sono necessarie logica profonda e capacità di “pensiero” articolata. Questi limiti possono essere superati grazie ai Hierarchical Reasoning Model il cui obiettivo è quello di insegnare alle macchine a “pensare come l’uomo”.

Un’idea suggestiva che risponde a una delle sfide più onerose con cui sono confrontati i ricercatori. Tuttavia, come vedremo, più di una voce competente esprime dubbi sull’efficacia dei HRM. Le capacità di ragionamento complesso, secondo i detrattori, rimane un tema aperto e nel dibattito gli HRM non troverebbero posto in platea.

Indice degli argomenti:

Cosa è un Hierarchical Reasoning Model

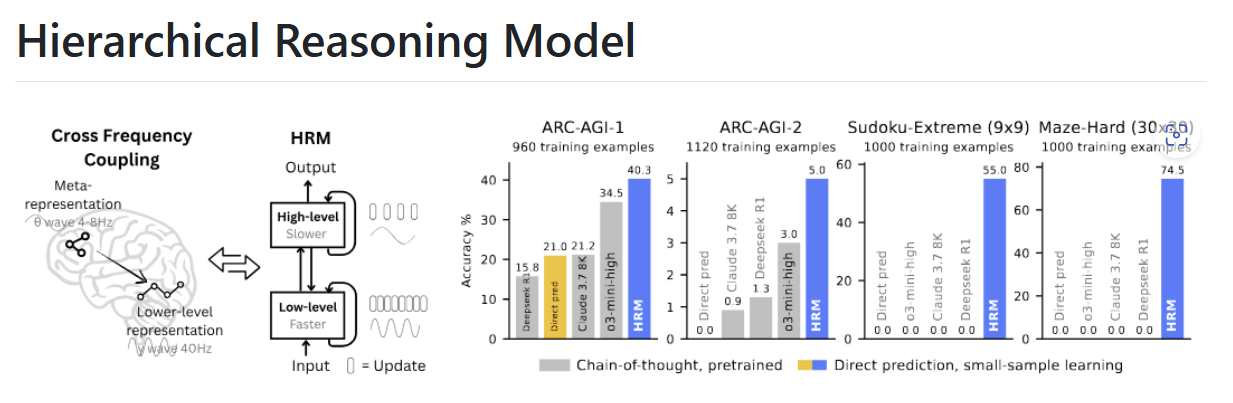

Un Hierarchical Reasoning Model (HRM) è una nuova architettura ricorrente ispirata ai processi gerarchici e multiscala osservati nel cervello umano.

L’obiettivo principale di HRM è raggiungere una significativa profondità computazionale mantenendo nel medesimo tempo stabilità ed efficienza nell’addestramento, ciò grazie anche al fatto che, per essere addestrato, un HRM non ha bisogno di una quantità enorme di dati.

Un HRM si ispira al funzionamento della mente umana e si compone di due moduli ricorrenti e interconnessi che operano in modo asincrono, ovvero:

- Un modulo di alto livello deputato alla pianificazione astratta e lenta tipica delle decisioni strategiche. È capace di esaminare un contesto sul lungo termine

- Un modulo di basso livello a cui spetta il compito di effettuare computazioni rapide e dettagliate. Computazioni che si situano all’interno del contesto fornito dal modulo di alto livello.

Ogni qualvolta il modulo di basso livello esegue il compito che gli è stato assegnato, il modulo di alto livello si aggiorna fornendogli un nuovo obiettivo di raggiungere. Meccanismo questo che si propaga fino al completamento del task affidato a un HRM.

Di fatto, la progettazione di un HRM rispecchia il modo in cui il cervello umano organizza il ragionamento mediante le regioni corticali. Nello specifico, il modulo di basso livello converge verso soluzioni locali per poi essere aggiornato dal modulo di alto livello che ha fatto tesoro delle informazioni acquisite.

Chi ha inventato l’HRM

Il modello di ragionamento gerarchico (Hierarchical Reasoning Model, HRM) non ha un unico inventore. Un postulato recente è riconducibile alla startup Sapient Intelligence (Singapore) ma stabilire un genitore certo è compito arduo, tant’è che l’idea stessa di ragionamento gerarchico prende corpo grazie all’intervento di più discipline che spaziano dalla psicologia cognitiva all’Intelligenza artificiale.

Uno dei padri putativi della teoria del ragionamento gerarchico è lo psicologo americano John Bissell Carroll che nel 1993 ha proposto il modello gerarchico a tre strati per spiegare le differenze individuali nei test cognitivi. Questo modello è alla base del CHC Model (Cattell – Horn – Carroll), una tra le teorie comunemente accettate nella psicologia dell’intelligenza.

La Chain-of-Thought e il Hierarchical Reasoning Model

Si può obiettare, peraltro ragionevolmente, che la Chain-of-Thought (CoT) in qualche modo è di supporto al superamento dei limiti dei LLM.

Tuttavia, tra CoT e HRM ci sono differenze di un certo calibro.

La CoT impone al modello di scrivere passo dopo passo il ragionamento fatto per arrivare a una risposta. È trasparente e migliora la precisione di LLM confrontati con problemi complessi.

Il rovescio della medaglia è la fragilità: un errore in un passaggio può compromettere l’intero “ragionamento”, procede con lentezza proprio perché produce molto testo intermedio tra i diversi passaggi e, per funzionare bene, necessità di molti dati.

Un HRM opera su livelli e su tempi diversi. Il “ragionamento” è silenzioso e si consuma negli stati del modello stesso, eseguendo ragionamenti complessi in un solo passaggio e avendo bisogno di pochi dati.

È meno trasparente di una CoT e, essendo in fase di sviluppo e sperimentazione, è poco rodato.

HRM, un passo avanti nell’evoluzione delle AI?

In sintesi, HRM potrebbe rappresentare (condizionale d’obbligo, come vedremo) un deciso passo in avanti nell’evoluzione delle AI, mentre la Chain-of-Thought rimane un ingegnoso escamotage per tentare di superare i limiti dei Large Language Model.

In termini più tecnici, gli attuali sistemi AI e in particolar modo gli LLM, fondano su architetture dominati come i Transformer che hanno una profondità fissa, ossia un numero relativamente contenuto di strati sequenziali. Ciò rappresenta un limite per le capacità di computazione.

Per aggirare questi limiti è stata introdotta la Chain-of-Thought, un approccio che scompone i compiti complessi in passaggi più semplici: di norma si legge che la CoT esternalizza il ragionamento in un linguaggio a livello di token.

Tuttavia, la Chain-of-Thought si è rivelata fragile, con alti tempi di latenza e bulimica di dati. Non cambia l’architettura di un modello ma ne guida il comportamento mediante esempi. Non di meno, funziona con modelli pre-addestrati, è sufficiente fornire prompt con ragionamenti passo a passo per coadiuvare il modello nella risoluzione di problemi di elevata complessità.

Si può quindi obiettare che la Chain-of-Thought è una strategia e non un’architettura e queste ultime avvantaggiano il processo grazie al quale un’AI “ricorda” informazioni derivanti da input precedenti, aiutando così i LLM a svolgere meglio i rispettivi compiti.

Le architetture ricorrenti e i Hierarchical Reasoning Model

Un’architettura ricorrente come le reti neurali ricorrenti o le reti neurali ricorrenti a lungo termine sono reti neurali con connessioni temporali. Possono “ricordare” informazioni da input precedenti e questo facilita l’uso di dati sequenziali.

Le reti neurali tradizionali sono algoritmi di Deep learning e soffrono di problemi che ne limitano la capacità di apprendimento. Inoltre, si basano sulla Backpropagation Through Time (BPTT) per l’addestramento, ovvero un processo ad alta intensità di memoria, molto costoso in termini computazionali e poco realistico dal punto di vista biologico, quindi poco aderente al funzionamento del cerebro.

HRM si propone di superare queste limitazioni introducendo una profondità computazionale efficace più che sensibilmente maggiore, basandosi su principi neuroscientifici per evitare i problemi delle reti neurali e l’uso intensivo della memoria BPTT.

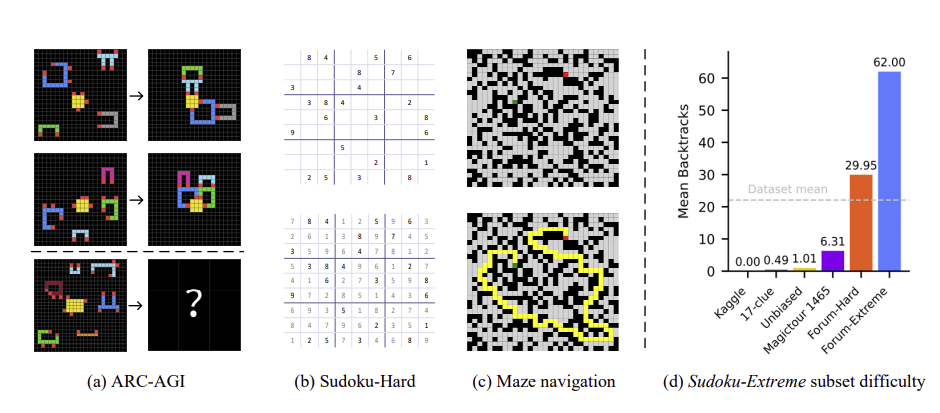

L’esempio del labirinto

Uno degli esempi più sfruttati per spiegare le novità introdotte dai HRM vuole che, chiamato a trovare la strada per uscire da un labirinto, i LLM attualmente hanno a disposizione pochi secondi per osservarlo, indipendentemente da quanto l’intreccio di strade sia complesso.

Il modulo di alto livello di un HRM osserva il labirinto dall’alto e spiega al livello basso quale direzione prendere per avvicinarsi all’uscita. Ogni volta che compie il percorso assegnatogli, il livello alto fornisce a quello basso ulteriori istruzioni fino a quanto il labirinto viene risolto.

A cosa serve un Hierarchical Reasoning Model

Un HRM è progettato per superare il “collo di bottiglia” del ragionamento computazionale che affligge gli attuali sistemi di Intelligenza artificiale.

L’obiettivo ultimo è quello di risolvere problemi di ragionamento complessi che oggi sono al di fuori delle possibilità dei modelli AI, anche di quelli più avanzati.

Nelle fasi di sperimentazione, i HRM hanno mostrato delle capacità specifiche:

- Soluzione di puzzle complessi: hanno raggiunto elevati livelli di precisione nel gioco del Sudoku

- Navigazione in ambienti complessi: hanno ottenuto una precisione del 74,5% nel trovare soluzioni per uscire da labirinti intricati (come descritto nelle pagine 11 e seguenti del documento prodotto dai ricercatori di Sapient Intelligence)

- Ragionamento astratto: raggiungono il 40,3% di accuratezza su ARC-AGI-1, un benchmark di riferimento per misurare le capacità di Intelligenza artificiale generale (AGI), introdotto nel 2019 da François Chollet (creatore di Keras) e ancora oggi tra i più adottati.

Queste capacità sono propedeutiche a utilizzi più ampi in diversi comparti dell’economia. I ricercatori di Sapient Intelligence invitano all’uso del HRM anche al fine di sperimentarne l’applicazione in differenti contesti.

Tra gli utilizzi già visibili vanno annoverati:

- La generazione e il debug di codice

- La risoluzione automatizzata di problemi, tra i quali la pianificazione di processi complessi quali la logistica, la gestione delle risorse umane ma anche negli ambiti del ragionamento scientifico

- Distribuzione Edge AI. Il numero contenuto di parametri (27 milioni) rende i HRM adatti ai ruoli edge e all’uso su dispositivi mobili. Il basso costo computazionale non richiede elaborazioni su server esterni

- Impiego nel gaming

- Sistemi decisionali strategici in favore di aziende private, pubbliche e forze armate.

A questo elenco si aggiungono le voci più disparate tant’è che Sapient Intelligence mette a disposizione su GitHub il codice per l’implementazione, auspicandone l’uso, la sperimentazione e l’individuazione di applicazioni specifiche.

Tra le raccomandazioni degli sviluppatori spiccano la necessità di considerare approcci ibridi (combinando quindi le capacità di ragionamento di HRM con i LLM tradizionali) e di concentrarsi sull’efficienza dei dati sfruttandone la capacità di apprendere da piccoli set di dati di addestramento.

Va considerato come i ricercatori auspicano che terzi svolgano test su ampia scala e questo fa di HRM uno strumento esistente e attuale. L’intento è quello di usare i Hierachical Reasoning Model come pilastro su cui erigere la prossima generazione di sistemi AI.

I vantaggi offerti da Hierarchical Reasoning Model

Come scritto, i HRM offrono vantaggi rispetto agli attuali modelli AI, con particolare riferimento ai Large Language Model basati su Chain-of-Thought.

Oltre alle prestazioni di ragionamento che nei test ARC-AGI-1 si sono dimostrate superiori, sul piatto ci sono altri atout che vanno considerati:

- Efficienza dei parametri: raggiunge risultati di livello con solo 27 milioni di parametri, gocce in un oceano nel quale i modelli AI più evoluti ne contano decine di miliardi

- Efficienza dei dati: è addestrato con 1.000 esempi per compito, senza pre-training

- Finestra di contesto: usa una finestra di contesto ridotta. 900 token, ovvero una frazione rispetto ad altri modelli.

Una finestra di contesto indica quanti token può “ricordare” un modello AI mentre elabora un input.

Un paradigma ormai sdoganato vuole che a maggiore ampiezza di una finestra corrispondano maggiori capacità di un LLM. Questo è parzialmente vero, fermo restando che una finestra di contesto contenuta porta con sé vantaggi quali la velocità di elaborazione, il minore consumo di risorse e la capacità del modello di restituire risposte meno dispersive.

L’architettura ispirata al cervello umano è un altro vantaggio che gioca un ruolo nei principi organizzativi basilari. Questo può rappresentare un cambiamento radicale, rendendo le AI capaci di un ragionamento più elevato e, nel caso specifico, accessibili a un pubblico ampio grazie alla natura Open.

La finestra di ragionamento è strutturata e un HRM ha dimostrato di potere adottare strategie diverse a seconda del compito assegnatogli: così, oltre a capacità di ricerca approfondita per giocare a Sudoku, ha dato sfoggio anche di doti analitiche per esplorare percorsi quando cimentato con i labirinti.

Gli svantaggi di Hierarchical Reasoning Model

Un articolo pubblicato su Rivista AI solleva interrogativi capaci di smorzare l’entusiasmo. Rivista AI mette l’accento sulla necessità di miglioramenti.

Innanzitutto, l’architettura gerarchica e i meccanismi di calcolo adattivo rendono i processi di addestramento di HRM più complessi rispetto agli altri modelli.

Inoltre, continua l’articolo, gli ambiti in cui HRM è stato messo alla prova sono limitati e coinvolgono sempre puzzle a griglia strutturati. A tale proposito sarebbe interessante valutare un HRM alle prese con problemi reali e realistici, magari partendo da informazioni incomplete.

Non di meno sorgono dubbi sulle prestazioni di un’architettura HRM con un numero di parametri ben maggiore. Entra quindi in gioco una certa diffidenza sulla scalabilità del modello.

HRM non risolve il limite dei modelli AI

Tra le critiche mosse ne emerge una particolarmente elevata sul piano concettuale. Infatti, spacciare la razionalità dell’uomo come un algoritmo rischia di indurre la produzione di sistemi sofisticati ma sostanzialmente “vuoti”, poiché lungi dalle effettive capacità di comprensione del cervello umano.

HRM non sana il grosso limite dei modelli AI, tutt’oggi incapaci di realizzare i concetti di consapevolezza, esperienza ed emozione che caratterizzano l’essere umano.

In conclusione, mentre i HRM danno risultati apprezzabili se confrontati con compiti specifici, non risolvono i dubbi relativi alla loro capacità di distinguersi nei compiti tipici del mondo reale e relativi alla loro effettiva scalabilità. In coda, ma non per ultima, è ancora da dimostrare la validità dell’idea secondo cui un HRM replica il funzionamento del cerebro e, sul piano potenziale, si avvicina alla complessità delle doti intellettuali dell’uomo.