Moonshot AI, startup cinese sostenuta da Alibaba e fondata nel 2023, ha lanciato Kimi K2. Questo modello linguistico (LLM) rappresenta un punto di svolta nell’intelligenza artificiale open‑weight: con 1 trilione di parametri totali e solo 32 miliardi attivi per inferenza, combina potenza elevata ed efficienza operativa.

Indice degli argomenti:

Kimi K2 utilizza un design Mixture‑of‑Experts (MoE)

Kimi K2 utilizza un design Mixture‑of‑Experts che attiva solo un sottoinsieme di esperti in ogni passaggio. In pratica, su 384 esperti complessivi, ne vengono attivati circa 8 per token, consentendo velocità e costo ridotti senza sacrificare capacità di ragionamento e comprensione. Questa modalità rende il modello notevolmente più leggero in inferenza di quanto suggeriscano i numeri totali.

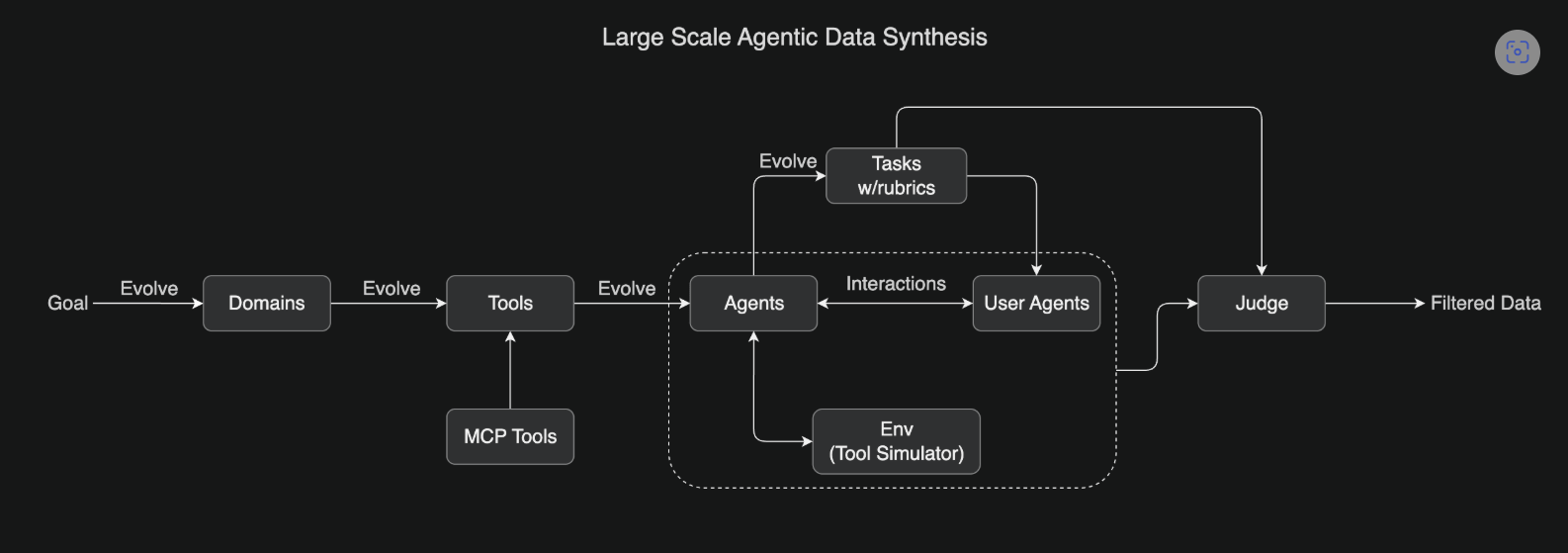

Ottimizzazione con Muon e MuonClip

La fase di addestramento si è basata su Muon, un ottimizzatore avanzato di tipo second‑order, combinato con il sistema MuonClip che limita la crescita dei logit prima che destabilizzino l’allenamento. Stando al team, sono stati elaborati oltre 15,5 trilioni di token senza problemi di instabilità. Questa strategia ha permesso a Kimi K2 di raggiungere livelli elevati di efficienza nella convergenza del training.

| Architecture | Mixture-of-Experts (MoE) |

| Total Parameters | 1T |

| Activated Parameters | 32B |

| Number of Layers (Dense layer included) | 61 |

| Number of Dense Layers | 1 |

| Attention Hidden Dimension | 7168 |

| MoE Hidden Dimension (per Expert) | 2048 |

| Number of Attention Heads | 64 |

| Number of Experts | 384 |

| Selected Experts per Token | 8 |

| Number of Shared Experts | 1 |

| Vocabulary Size | 160K |

| Context Length | 128K |

| Attention Mechanism | MLA |

| Activation Function | SwiGLU |

Prestazioni sui benchmark

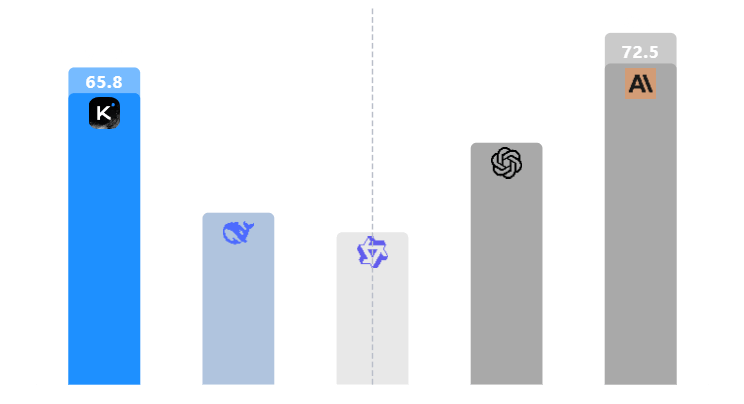

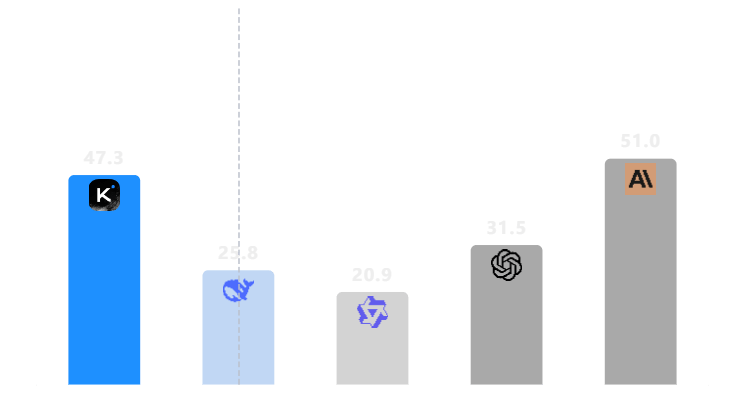

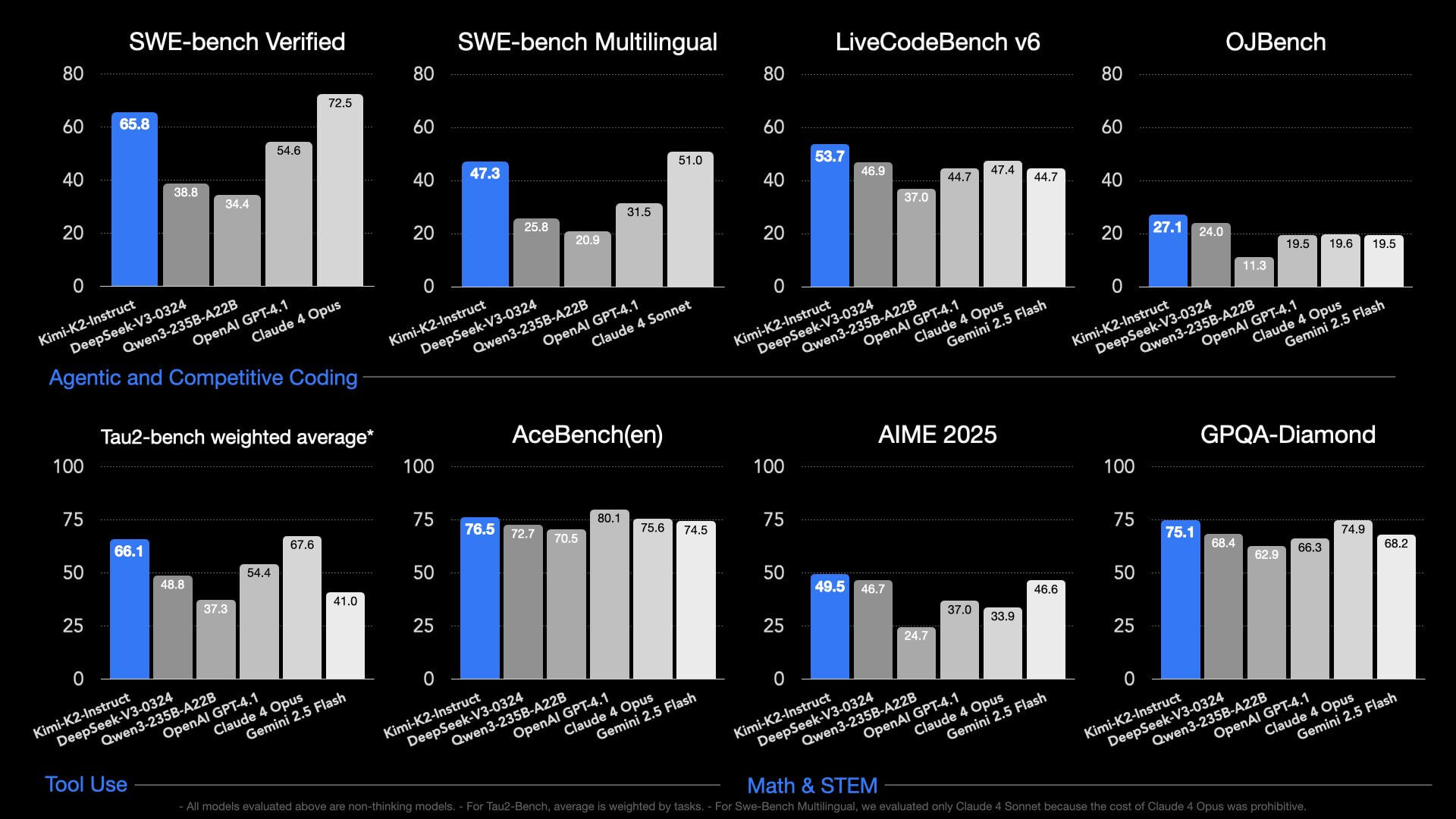

Codifica e debugging

Nei test LiveCodeBench v6 e SWE‑Bench Verified, Kimi K2 ha ottenuto tassi di successo superiori a GPT‑4.1 in vari compiti di codifica. Ad esempio, su SWE‑Bench Verified (agentic coding), ha raggiunto il 65,8 %, contro il 54,6 % di GPT‑4.1.

Ragionamento scientifico e matematico

Su benchmark come AIME 2025 e GPQA‑Diamond, il modello ha registrato punteggi di 49,5 e 75,1 rispettivamente, superando GPT‑4.1 (37,0 e 66,3) e pari con Claude Opus su GPQA, in alcuni casi superandolo.

Competenze agentiche e uso di strumenti

Nel benchmark Tau2 (ragionamento multi-hop e cambio tra strumenti) Kimi K2 ha registrato valori competitivi:

- 66,1 punti contro 67,6 di Claude Opus e 54,4 di GPT‑4.1.

- Su AceBench, ha ottenuto 76,5, risultando tra i migliori modelli agentici disponibili.

Costi molto contenuti

Secondo alcune fonti, Kimi K2 costa circa 0,14 € per milione di token di input e 2,30 € per milione di token di output, contro i 7,30 € di GPT‑4.1 e gli oltre 68 € di Claude Opus 4, rendendolo estremamente competitivo in termini di prezzo/performance.

| Benchmark | Metric | Kimi K2 Instruct | DeepSeek-V3-0324 | Qwen3-235B-A22B (non-thinking) | Claude Sonnet 4 (w/o extended thinking) | Claude Opus 4 (w/o extended thinking) | GPT-4.1 | Gemini 2.5 Flash Preview (05-20) |

|---|---|---|---|---|---|---|---|---|

| Coding Tasks | ||||||||

| LiveCodeBench v6 (Aug 24 – May 25) | Pass@1 | 53.7 | 46.9 | 37.0 | 48.5 | 47.4 | 44.7 | 44.7 |

| OJBench | Pass@1 | 27.1 | 24.0 | 11.3 | 15.3 | 19.6 | 19.5 | 19.5 |

| MultiPL-E | Pass@1 | 85.7 | 83.1 | 78.2 | 88.6 | 89.6 | 86.7 | 85.6 |

| SWE-bench Verified (Agentless Coding) | Single Patch w/o Test (Acc) | 51.8 | 36.6 | 39.4 | 50.2 | 53.0 | 40.8 | 32.6 |

| SWE-bench Verified (Agentic Coding) | Single Attempt (Acc) | 65.8 | 38.8 | 34.4 | 72.7* | 72.5* | 54.6 | — |

| Multiple Attempts (Acc) | 71.6 | — | — | 80.2 | 79.4* | — | — | |

| SWE-bench Multilingual (Agentic Coding) | Single Attempt (Acc) | 47.3 | 25.8 | 20.9 | 51.0 | — | 31.5 | — |

| TerminalBench | Inhouse Framework (Acc) | 30.0 | — | — | 35.5 | 43.2 | 8.3 | — |

| Terminus (Acc) | 25.0 | 16.3 | 6.6 | — | — | 30.3 | 16.8 | |

| Aider-Polyglot | Acc | 60.0 | 55.1 | 61.8 | 56.4 | 70.7 | 52.4 | 44.0 |

| Tool Use Tasks | ||||||||

| Tau2 retail | Avg@4 | 70.6 | 69.1 | 57.0 | 75.0 | 81.8 | 74.8 | 64.3 |

| Tau2 airline | Avg@4 | 56.5 | 39.0 | 26.5 | 55.5 | 60.0 | 54.5 | 42.5 |

| Tau2 telecom | Avg@4 | 65.8 | 32.5 | 22.1 | 45.2 | 57.0 | 38.6 | 16.9 |

| AceBench | Acc | 76.5 | 72.7 | 70.5 | 76.2 | 75.6 | 80.1 | 74.5 |

| Math & STEM Tasks | ||||||||

| AIME 2024 | Avg@64 | 69.6 | 59.4* | 40.1* | 43.4 | 48.2 | 46.5 | 61.3 |

| AIME 2025 | Avg@64 | 49.5 | 46.7 | 24.7* | 33.1* | 33.9* | 37.0 | 46.6 |

| MATH-500 | Acc | 97.4 | 94.0* | 91.2* | 94.0 | 94.4 | 92.4 | 95.4 |

| HMMT 2025 | Avg@32 | 38.8 | 27.5 | 11.9 | 15.9 | 15.9 | 19.4 | 34.7 |

| CNMO 2024 | Avg@16 | 74.3 | 74.7 | 48.6 | 60.4 | 57.6 | 56.6 | 75.0 |

| PolyMath-en | Avg@4 | 65.1 | 59.5 | 51.9 | 52.8 | 49.8 | 54.0 | 49.9 |

| ZebraLogic | Acc | 89.0 | 84.0 | 37.7* | 73.7 | 59.3 | 58.5 | 57.9 |

| AutoLogi | Acc | 89.5 | 88.9 | 83.3 | 89.8 | 86.1 | 88.2 | 84.1 |

| GPQA-Diamond | Avg@8 | 75.1 | 68.4* | 62.9* | 70.0* | 74.9* | 66.3 | 68.2 |

| SuperGPQA | Acc | 57.2 | 53.7 | 50.2 | 55.7 | 56.5 | 50.8 | 49.6 |

| Humanity’s Last Exam (Text Only) | – | 4.7 | 5.2 | 5.7 | 5.8 | 7.1 | 3.7 | 5.6 |

Varianti del modello

Moonshot ha rilasciato Kimi‑K2‑Base, versione modulare per ricerca e tuning, e Kimi‑K2‑Instruct, specializzato in conversazioni guidate con capacità agentica out-of-the-box. Quest’ultima è ideale per applicazioni immediatamente operative senza logiche di orchestrazione esterne.

Accessibilità e limitazioni

Pur essendo open‑weight, Kimi K2 richiede risorse hardware considerevoli. Alcuni utenti Reddit suggeriscono la necessità di sistemi con GPU H200 o almeno più di 1 TB di RAM per prestazioni accettabili; in quantizzazioni a 4 bit può essere usato su setup come due Mac Studio M3 Ultra con 512 GB. L’accesso via API e interfaccia web è invece più agevole, offerto da provider come NovitaAI o Parasail su piattaforme come OpenRouter.

Base model evaluation results

| Benchmark | Metric | Shot | Kimi K2 Base | Deepseek-V3-Base | Qwen2.5-72B | Llama 4 Maverick |

|---|---|---|---|---|---|---|

| General Tasks | ||||||

| MMLU | EM | 5-shot | 87.8 | 87.1 | 86.1 | 84.9 |

| MMLU-pro | EM | 5-shot | 69.2 | 60.6 | 62.8 | 63.5 |

| MMLU-redux-2.0 | EM | 5-shot | 90.2 | 89.5 | 87.8 | 88.2 |

| SimpleQA | Correct | 5-shot | 35.3 | 26.5 | 10.3 | 23.7 |

| TriviaQA | EM | 5-shot | 85.1 | 84.1 | 76.0 | 79.3 |

| GPQA-Diamond | Avg@8 | 5-shot | 48.1 | 50.5 | 40.8 | 49.4 |

| SuperGPQA | EM | 5-shot | 44.7 | 39.2 | 34.2 | 38.8 |

| Coding Tasks | ||||||

| LiveCodeBench v6 | Pass@1 | 1-shot | 26.3 | 22.9 | 21.1 | 25.1 |

| EvalPlus | Pass@1 | – | 80.3 | 65.6 | 66.0 | 65.5 |

| Mathematics Tasks | ||||||

| MATH | EM | 4-shot | 70.2 | 60.1 | 61.0 | 63.0 |

| GSM8k | EM | 8-shot | 92.1 | 91.7 | 90.4 | 86.3 |

| Chinese Tasks | ||||||

| C-Eval | EM | 5-shot | 92.5 | 90.0 | 90.9 | 80.9 |

| CSimpleQA | Correct | 5-shot | 77.6 | 72.1 | 50.5 | 53.5 |

• Sono stati valutati solo modelli preaddestrati open source. Si riportano i risultati per Qwen2.5-72B perché il checkpoint di base per Qwen3-235B-A22B non è open source al momento dello studio.

Tutti i modelli sono valutati utilizzando lo stesso protocollo di valutazione.

Impatto sull’ecosistema AI

Il lancio globale quasi contemporaneo al modello DeepSeek dimostra che l’industria cinese dell’AI open‑source è sempre più rilevante. Kimi K2 è già considerato un momento storico simile al rilascio del modello R1 di DeepSeek: un punto di riferimento per l’innovazione aperta. È stato scaricato decine di migliaia di volte in pochi giorni tramite Hugging Face.

Applicazioni pratiche

Sviluppo software

Kimi K2 è particolarmente utile per sviluppatori che desiderano affiancarlo alle pipeline di sviluppo: può scrivere codice, eseguire test, correggere bug e iterare in modo autonomo con strumenti come spedizioni bash_exec.

Prototipazione e agenti autonomi

Grazie alla progettazione agentica, può orchestrare multi-step task, integrarsi con API esterne e comporre azioni complesse. Questo lo rende adatto alla costruzione di agenti intelligenti personalizzati senza l’uso di planner esterni.

Kimi K2, sfide e limiti

Complessità infrastrutturale

L’uso efficace richiede infrastrutture ad alta capacità, che solo organizzazioni con budget importanti possono permettersi. L’operatività su dispositivi “leggeri” resta limitata a esperimenti con quantizzazione estrema.

Incertezze su comportamento agentico

Al momento, alcune delle capacità agentiche proclamate da Moonshot non sono ancora state completamente replicate o verificate dalla comunità scientifica. Ci sono dubbi su fallimenti in determinati task complessi, specialmente senza supervisione attiva o strutture guidanti.

Licenza modificata

Nonostante il modello sia open‑weight, presenta una clausola nella licenza non compatibile OSI: richiede la visualizzazione del nome “Kimi K2” se utilizzato in prodotti commerciali ad alto traffico (oltre 100 milioni MAU o 20 milioni USD mensili).

Conclusioni

Kimi K2 rappresenta un importante salto in avanti per l’AI aperta: combina performance eccellenti, costi contenuti e capacità agentiche avanzate in un modello da 1 trilione di parametri. Rappresenta un’alternativa credibile a GPT‑4.1 e Claude, specialmente in scenari professionali e di ricerca. Tuttavia, l’hardware necessario e le complessità operative ne limitano ad oggi un’adozione di massa.

Chi desidera sperimentarlo su piccola scala può farlo tramite API cloud; chi ha accesso a risorse importanti potrà invece valutarne un deployment completo per stimolare agenti personalizzati. Moonshot, con questo modello, segna un altro capitolo nell’espansione dell’AI accessibile e flessibile.