I modelli generativi oggi scrivono mail, producono immagini, scrivono e testano codice. Ma tutte queste capacità restano confinate nel digitale: quando si tratta di capire davvero la fisica del mondo — far guidare un’auto, muovere un robot in cucina, navigare una città — i grandi modelli linguistici mostrano limiti evidenti.

È il “punto cieco”: per superarlo, i grandi laboratori stanno puntando sempre più sui world model, modelli che cercano di costruire una vera mappa cognitiva del mondo e delle sue regole.

L’ultima mossa è di Google DeepMind, con Project Genie: un esperimento che porta al pubblico americano, nei giorni scorsi, Genie 3, world model capace di generare mondi 3D interattivi in tempo reale, e allo stesso tempo fornisce il motore del nuovo Waymo World Model, il simulatore “iper-realistico” usato da Waymo per addestrare i robotaxi in scenari estremi, dai tornado agli elefanti che attraversano l’autostrada.

Per capire perché queste tecnologie contano, e in che direzione si stanno muovendo Google, Meta, Runway e altri player, bisogna partire dai limiti degli LLM e dai diversi modi di intendere la parola “world model”.

Indice degli argomenti:

LLM potentissimi, ma senza una vera mappa cognitivo del mondo

Gli LLM hanno una sorta di “world model implicito”: dal solo testo riescono a inferire concetti come gravità, continuità degli oggetti, relazioni spaziali di base. Se chiediamo che cosa succede a una tazza sospesa nel vuoto, il modello “sa” che cade: lo deduce dalle descrizioni lette in fase di training.

Ma questo tipo di conoscenza ha almeno tre problemi pratici:

- È incompleto. Il testo online non descrive ogni via, ogni dettaglio topografico, ogni combinazione di condizioni meteo e traffico. In un recente podcast dell’Economist (Babbage, a pagamento), c’è un esempio frutto di un test reale: un chatbot genera indicazioni a piedi tra due uffici dell’Economist, ma sbaglia il punto di partenza (l’azienda ha cambiato sede da anni) e propone un percorso che evita il parco, semplicemente perché nei suoi dati i vicoli secondari e i sentieri non compaiono con la stessa frequenza delle grandi strade.

- Non è aggiornato in tempo reale. Un LLM standard non mantiene uno stato dinamico del mondo: non “segue” ciò che accade minuto per minuto, non aggiorna le sue mappe quando cambia un senso unico o si apre un nuovo cantiere. Per molte applicazioni, il modello farà comunque una tool call a servizi esterni (per esempio, le mappe).

- Non è pensato per agire 60 volte al secondo. Un LLM generico produce token di testo, non stati fisici. Non nasce per aggiornare in modo continuo una rappresentazione del mondo e decidere che cosa fare ogni frame, come serve a un’auto autonoma o a un robot.

Da qui l’idea di separare il problema: da un lato modelli linguistici e multimodali per ragionare ad alto livello, dall’altro world model espliciti, pensati per simulare e prevedere l’evoluzione di ambienti complessi.

Che cos’è (e che cosa non è) un world model

A conferma di quanto siamo agli inizi di un percorso, non c’è ancora chiarezza su cosa sia un world model.

Nella definizione di DeepMind, “un world model simula la dinamica di un ambiente, prevedendo come evolve e come le azioni ne cambiano lo stato”. (Fonte: blog.google)

In pratica:

- osserva lo stato corrente (frame video, nuvola di punti lidar, dati dei sensori, testo di contesto);

- riceve una azione (“sterza a destra”, “salta”, “accelera”);

- produce il prossimo stato plausibile e aggiorna una memoria interna di “come è fatto il mondo”.

È importante distinguere due livelli:

- un world model implicito, come quello che vive dentro un LLM: utile per rispondere a domande, ma non direttamente utilizzabile per controllare un robot;

- un world model esplicito, che produce simulazioni verificabili: video, stati 3D, input per sensori virtuali, su cui possiamo far “giocare” agenti di AI e che possiamo stressare con scenari rari.

L’arrivo di Project Genie, con dietro la forza di Google, è una notizia importante per lo sviluppo di questo approccio.

Project Genie e Waymo World Model: la nuova coppia di Alphabet

Genie 3: un motore di mondi neurale

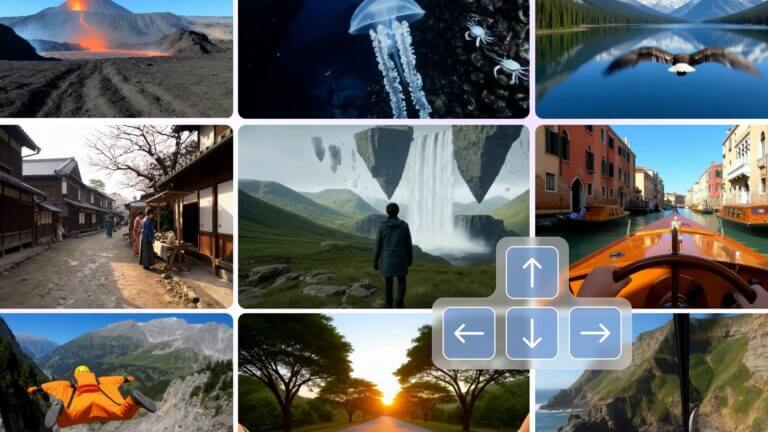

Genie 3 è il nuovo world model generalista di DeepMind. Prende un prompt testuale (“strada di montagna in inverno con molta neve”), genera un ambiente 3D interattivo fotorealistico e permette al sistema di muoversi in tempo reale, mantenendo coerenza di oggetti, illuminazione e fisica di base. (Fonte: Google DeepMind)

Due dettagli interessanti che emergono anche dalle interviste ai ricercatori:

- il modello non usa una geometria 3D esplicita (mesh, point cloud). Tutto vive in uno spazio latente, e la coerenza emerge dall’addestramento;

- c’è una vera memoria di lungo periodo: se dipingo un muro, esco dalla stanza, giro un po’ e torno indietro, il muro rimane dipinto.

Project Genie è il prodotto sperimentale che espone queste capacità a sviluppatori e creatori: negli Stati Uniti è accessibile agli abbonati di fascia alta di Google AI, che possono generare “mondi infiniti e interattivi” per fare prototipi di giochi, esperimenti di simulazione, contenuti immersivi.

Waymo World Model: simulare l’impossibile per addestrare i robotaxi

Su questa base, Waymo ha costruito il Waymo World Model, un simulatore verticale per la guida autonoma. Il modello genera ambienti 3D controllabili, sincronizzati con sensori virtuali (camera, lidar, radar), e permette di simulare miliardi di chilometri virtuali in scenari che nella realtà non si vedrebbero mai: tornado in autostrada, ponti coperti di neve, quartieri allagati con mobili che galleggiano, persino elefanti in corsia di sorpasso.

Waymo dichiara che il driver ha già percorso quasi 200 milioni di miglia autonome su strada, ma nel simulatore può correre molti ordini di grandezza in più, con un ciclo rapido:

- il world model genera uno scenario (anche partendo da video reali di dashcam);

- il sistema di guida agisce;

- si misurano gli errori, si aggiorna il modello, si ripete.

Per Alphabet il messaggio è strategico: lo stesso world model alimenta un prodotto creativo (Project Genie) e un’infrastruttura di sicurezza per un business ad altissimo rischio regolatorio come i robotaxi.

Come detto, nel dibattito tra ricercatori non c’è ancora una definizione unica: tutti dicono di voler costruire world model, ma non sempre parlano della stessa cosa. Qui ci concentreremo su due grandi famiglie che oggi stanno emergendo.

Due famiglie di world model: generativi e “decoder-free”

Dietro la stessa etichetta convivono approcci tecnici anche opposti. Una distinzione utile, rilanciata anche da Yann LeCun (uno dei massimi guru di AI, ex Meta), è tra world model generativi e world model “decoder-free” in spazio latente.

World model generativi: il mondo come video interattivo

Genie 3, il Waymo World Model o GAIA-1 di Wayve sono world model che:

- ricevono stato + azione;

- generano direttamente i nuovi fotogrammi video o stati sensoriali;

- permettono a un agente (umano o IA) di “camminare” o guidare dentro il mondo.

I vantaggi:

- l’output è ispezionabile visivamente: ingegneri, designer e regolatori possono “vedere” gli scenari simulati;

- si possono ordinare al modello scenari estremi con prompt naturali (“temporale, poca visibilità, camion in contromano”) e usarli per validare sistemi complessi.

- Lo svantaggio è il costo: generare video ad alta risoluzione in tempo reale richiede molta potenza di calcolo, con impatti su cloud, latenza e costi unitari per simulazione.

JEPA e i world model “minimalisti”: il mondo come spazio astratto

Il filone JEPA (Joint Embedding Predictive Architecture) sostenuto da LeCunn ha un altro punto di vista. Per pianificare, non serve prevedere ogni pixel del futuro, basta una rappresentazione astratta che mantenga le proprietà rilevanti.

In questa famiglia di modelli:

- un encoder trasforma input sensoriali (per esempio video) in un embedding compatto;

- il modello impara a prevedere come questo embedding cambierà nel tempo o a seguito di un’azione;

- il sistema di controllo pianifica azioni facendo “girare” il world model in questo spazio latente, non sui pixel. (Fonte: arXiv)

Gli esempi che LeCun usa da tempo per spiegare il concetto:

- se una penna è sospesa nel vuoto e tolgo il supporto, so che cadrà; non posso predire esattamente ogni pixel, ma posso predire il cambiamento di stato “stabile → instabile → a terra”;

- per prevedere dove sarà Giove fra 100 anni non servono tutte le immagini mai scattate del pianeta: bastano poche grandezze fisiche (posizioni e velocità iniziali) e le equazioni del moto.

JEPA cerca proprio questo tipo di “astrazione condensata”: uno spazio dove la previsione è possibile e utile ai fini del controllo, anche se i dettagli visivi restano indefiniti.

La ricerca più recente mostra che JEPA world model, combinati con meccanismi di pianificazione (per esempio “value-guided action planning”), possono già risolvere in modo competitivo compiti di controllo continuo in ambienti simulati, e sono candidati naturali per la robotica.

È plausibile che nei sistemi industriali maturi le due linee convergano: world model generativi per verificare e generare dati, world model “alla JEPA” per ragionare e pianificare con meno calcolo.

Da YouTube ai robot domestici: dove nascono i dati per i world model

Ma come costruire un world model? Qui oggi vediamo tre grandi fonti di dati.

1. Robot nel mondo reale: il caso 1X

Una strada è raccogliere dati direttamente da robot fisici. È l’approccio di aziende come 1X Technologies, che sta lanciando il robot domestico Neo: un umanoide da circa 20.000 dollari, pensato per fare lavastoviglie, riordinare, spostare oggetti in casa.

Per superare i limiti dell’autonomia, molti compiti oggi sono ancora svolti via teleoperazione: un operatore controlla il robot in remoto e, al tempo stesso, genera preziosi dati di interazione in ambienti domestici reali. L’idea è usare queste traiettorie per addestrare world model più aderenti al caos delle case vere, diverse da quelle perfette dei simulatori.

Il limite è ovvio: il mondo fisico scorre in tempo reale. Anche con migliaia di robot, accumulare abbastanza esperienza richiede anni e capitali consistenti.

2. Video “in the wild”: il mondo visto su schermo

Per scalare più rapidamente, i laboratori stanno usando dataset video generici: dashcam di guida, vlog, riprese urbane, filmati di attività sportive, film, contenuti simili a quelli che troviamo su YouTube.

DeepMind ha addestrato Genie 2 e Genie 3 su grandi collezioni di video non etichettati, sfruttando il fatto che anche la scena più banale (due persone che parlano in ufficio) contiene un’enorme quantità di regolarità fisiche: gli oggetti non si teletrasportano, le persone non fluttuano, la luce cambia in modo continuo.

Nel campo della guida autonoma, lavori recenti combinano video di guida “nel mondo” e un piccolo numero di traiettorie reali o simulate per addestrare world model che poi vengono raffinati su scenari specifici.

I vantaggi:

- scala enorme (internet-scale);

- costo marginale relativamente basso rispetto a campagne robotiche dedicate;

- maggiore diversità di contesti (climi, culture, infrastrutture).

Le questioni aperte: copyright, privacy, consenso dei soggetti ripresi, trasparenza sulla composizione dei dataset.

3. Mondi 3D espliciti: dai laboratori di visione al CAD

Un terzo filone, spinto da ricercatrici come Fei-Fei Li (un’altra pioniera dell’AI) e aziende come World Labs, punta a usare i world model per generare scene 3D esplicite, non solo video: ambienti che possono essere esportati in software di architettura, stampati in 3D, condivisi tra molti agenti. L’obiettivo è ottenere il meglio dei due mondi: creatività generativa e controllo preciso della struttura geometrica.

Dal gioco alla scienza: gli usi emergenti dei world model

La cosa più ovvia è che assisteremo a un’accelerazione nell’ambito dell’AI incarnata, dei robot fisici dotati di AI, perché ciò che ha rallentato questi settori è l’accesso ai dati di addestramento e la capacità di addestrare le cose alla velocità del computer piuttosto che alla velocità del mondo reale. Se disponiamo di buoni modelli del mondo, possiamo iniziare ad addestrare le cose che devono interagire con il mondo reale in spazi virtuali.

Ciò significa che almeno dal punto di vista del software l’AI incarnata subirà un’accelerazione enorme.

Guida autonoma e logistica

Per la guida autonoma, i world model sono già un componente di prodotto. Waymo vede il suo World Model come un simulatore generativo multi-sensore, in grado di coprire sistematicamente la “coda lunga” di eventi rarissimi ma ad alto rischio.

Altri player — dalle startup come Wayve alle case auto tradizionali — sperimentano world model per:

- generare dati sintetici di guida in condizioni poco rappresentate;

- testare politiche di controllo in scenari estremi prima di portarle su strada;

- fare debugging più trasparente, potendo “riavvolgere” il mondo.

La stessa logica vale per magazzini, impianti industriali, centri di distribuzione: far sbagliare un robot in un magazzino virtuale costa molto meno che farlo sbagliare in uno reale.

Videogiochi, media e nuove esperienze interattive

Per il settore media, Project Genie e i world model di Runway aprono terreni nuovi. Runway sta lavorando a world model come estensione naturale dei suoi modelli video: ambienti navigabili e modificabili in tempo reale, più simili a “nuove cineprese” che a semplici generatori di clip.

Nel breve periodo, è plausibile un uso come motore di prototipazione:

- generare al volo layout di livelli;

- testare meccaniche di gioco senza costruire a mano ogni asset;

- creare storyboard animati “giocabili” per film e serie.

Più avanti, potrebbero nascere esperienze che non assomigliano a nessun videogioco attuale: mondi che cambiano a ogni partita, spazi narrativi che reagiscono in modo profondo alle azioni del giocatore e alle istruzioni in linguaggio naturale.

Alcuni game designer sono però scettici sull’idea che la generazione automatica possa sostituire la cura autoriale dei giochi “scolpiti a mano”. Più che rimpiazzare gli studi di sviluppo, i world model potrebbero diventare un nuovo strumento nella loro cassetta, spostando risorse da modeling e lighting a design, narrativa, bilanciamento.

I modelli del mondo possono aiutarci anche ad accelerare notevolmente il progresso della scienza e di molte discipline umane.

Simulazione scientifica e educazione

La simulazione è costosa nel mondo reale e l’accesso limitato frena l’innovazione. Un world model abbastanza accurato potrebbe permettere a laboratori e aziende di:

- testare rapidamente ipotesi in fisica, ingegneria, biologia, prima di passare agli esperimenti fisici;

- progettare robot, droni, infrastrutture in ambienti virtuali ad alta fedeltà;

- costruire tutori virtuali che mostrano fenomeni complessi dentro mondi generati (per esempio, un corso di fisica in cui si “entra” negli esperimenti).

L’idea è ancora più visionaria nel campo educativo: un insegnante virtuale, incarnato in un avatar dentro un world model, che personalizza lezioni ed esperimenti per ogni studente, con costi marginali vicini allo zero per studente aggiuntivo.

Infine, i modelli del mondo possono migliorare anche gli attuali chatbot e altre AI che già usiamo dando loro una migliore comprensione del mondo reale. Ne hanno bisogno anche se non guidano un robot, per capire meglio cosa vuole l’utente, il contesto reale di queste richieste.

Limiti strutturali: cosa i world model non fanno (ancora)

Vediamo i problemi da superare nei prossimi anni.

1. La copertura del mondo reale è parziale.

Un world model “a base video” vede solo ciò che la camera vede. Il vento che sento sulle braccia, l’attrito sotto le scarpe, gli odori di un laboratorio non compaiono nei pixel. Gli stessi ricercatori di DeepMind riconoscono che, per robot davvero utili, servirà integrare canali sensoriali aggiuntivi (tatto, forza, audio).

2. Il problema sim-to-real non è risolto.

Anche simulazioni iper-realistiche restano simulazioni. Studi recenti sottolineano che è difficile garantire che la distribuzione di scenari generati rifletta davvero quella del rischio nel mondo fisico, soprattutto per eventi estremi.

Poi ci sono rovesci della medaglia da governare.

1. Costi e concentrazione del potere.

Addestrare world model generativi come Genie 3 richiede infrastrutture computazionali enormi. A oggi solo pochi attori globali possono farlo, con il rischio di concentrare in poche mani i “motori del mondo” usati in settori critici (mobilità, logistica, difesa). )

2. Governance dei dati e della sicurezza.

L’uso massiccio di video pubblici (e privati, nel caso di robot domestici) apre domande su privacy, proprietà intellettuale, uso secondario dei dati. Allo stesso tempo, world model sempre più realistici possono essere utilizzati per scopi offensivi (addestrare sistemi di attacco, creare scenari ingannevoli per training). Qui le policy aziendali e le regole pubbliche sono in ritardo rispetto alle capacità tecniche.

Che cosa significa, in pratica, per chi lavora con l’AI in azienda

Per chi si occupa di AI applicata, i world model oggi sono soprattutto un trend da monitorare con attenzione, più che un componente pronto da integrare ovunque.

Le applicazioni sono però interessanti.

- Mobilità e robotica. Se l’azienda si occupa di logistica, robotica di magazzino o di ispezione, è probabile che i suoii fornitori inizino a offrire simulazione “world-model-powered”. Vale la pena chiedere: quali dati usano, come validano la transizione sim-to-real, che strumenti hanno per ispezionare e fare audit sulle simulazioni?

- Industria dei contenuti. Per gaming, intrattenimento, pubblicità, formazione, strumenti come Project Genie o i futuri world model di Runway saranno utili per prototipare rapidamente, testare concept, generare varianti. Non sostituiscono il lavoro creativo, ma cambiano dove si concentra il valore.

I world model richiedono una specifica strategia sui dati. Se pensiamo a world model interni (per esempio per simulare la vostra supply chain o un impianto produttivo), ci si può chiedere: quali flussi di dati abbiamo già (sensori, logistica, IoT) e quali servirebbero per costruire una simulazione utile? Non tutti hanno bisogno di un “Genie 3”, ma molti potrebbero avere bisogno di piccoli world model settoriali.

Serve un world model per arrivare all’AGI?

Infine, una nota teoretica. Sul rapporto tra world model e AGI (intelligenza artificiale “generale”) le opinioni sono divise.

- i modelli di frontiera di oggi, collegati a strumenti esterni, mostrano già capacità di pianificazione e azione autonoma in molti contesti digitali (scrivere codice, orchestrare workflow, usare API);

- per sostituire o affiancare l’uomo in compiti fisici complessi, dal magazzino alla casa, servirà però una conoscenza del mondo molto più densa di quella che il solo testo può offrire.

Alcuni ricercatori sostengono che, per una forma di AGI puramente “digitale”, un world model esplicito non sia strettamente necessario: bastano LLM e tool. Per un’AGI capace di agire nel mondo, invece, world model ricchi e aggiornabili sembrano difficili da evitare.

Per le imprese, forse la domanda è meno filosofica e più operativa: quanto velocemente i world model ridurranno il costo di sviluppo di sistemi robotici, di simulazioni industriali, di ambienti di training? E quanto sarà conveniente acquistare queste capacità “as a service” dai big rispetto a sviluppare soluzioni proprietarie più piccole ma specializzate?