Il colosso tecnologico cinese Alibaba ha ufficialmente svelato il suo nuovo modello di intelligenza artificiale, Qwen 3.5, progettato per operare in quella che l’azienda definisce l’“era dell’agentic AI”. Questo tipo di intelligenza è in grado non solo di rispondere a domande, ma di eseguire compiti complessi in modo autonomo attraverso applicazioni mobile e desktop.

Secondo le dichiarazioni ufficiali, Qwen 3.5 è circa il 60% più economico da usare e può gestire carichi di lavoro molto più ampi rispetto al suo predecessore, offrendo anche capacità visive agentiche che gli permettono di interagire con l’ambiente digitale in modo più dinamico.

Indice degli argomenti:

Qwen 3.5, caratteristiche tecniche e prestazioni

Qwen3.5 è il modello open-weight della nuova serie, denominato Qwen3.5-397B-A17B. In qualità di modello nativo vision-language, Qwen3.5-397B-A17B dimostra risultati eccellenti su un’ampia gamma di benchmark, tra cui ragionamento, coding, capacità agentiche e comprensione multimodale, consentendo a sviluppatori e imprese di raggiungere livelli di produttività significativamente superiori.

Basato su un’innovativa architettura ibrida che combina attenzione lineare (tramite Gated Delta Networks) con una sparse mixture-of-experts, il modello raggiunge un’elevata efficienza in fase di inferenza: pur contando 397 miliardi di parametri complessivi, ne attiva solo 17 miliardi per ogni forward pass, ottimizzando velocità e costi senza compromettere le prestazioni.

Inoltre, il supporto linguistico è stato ampliato da 119 a 201 lingue e dialetti, offrendo maggiore accessibilità e un supporto più esteso agli utenti in tutto il mondo.

Qwen3.5-Plus e disponibilità su Alibaba Cloud

La versione Qwen3.5-Plus è il modello ospitato disponibile tramite Alibaba Cloud Model Studio e include:

- una finestra di contesto da 1 milione di token di default

- strumenti ufficiali integrati

- utilizzo adattivo degli strumenti (adaptive tool use)

Valutazioni delle prestazioni

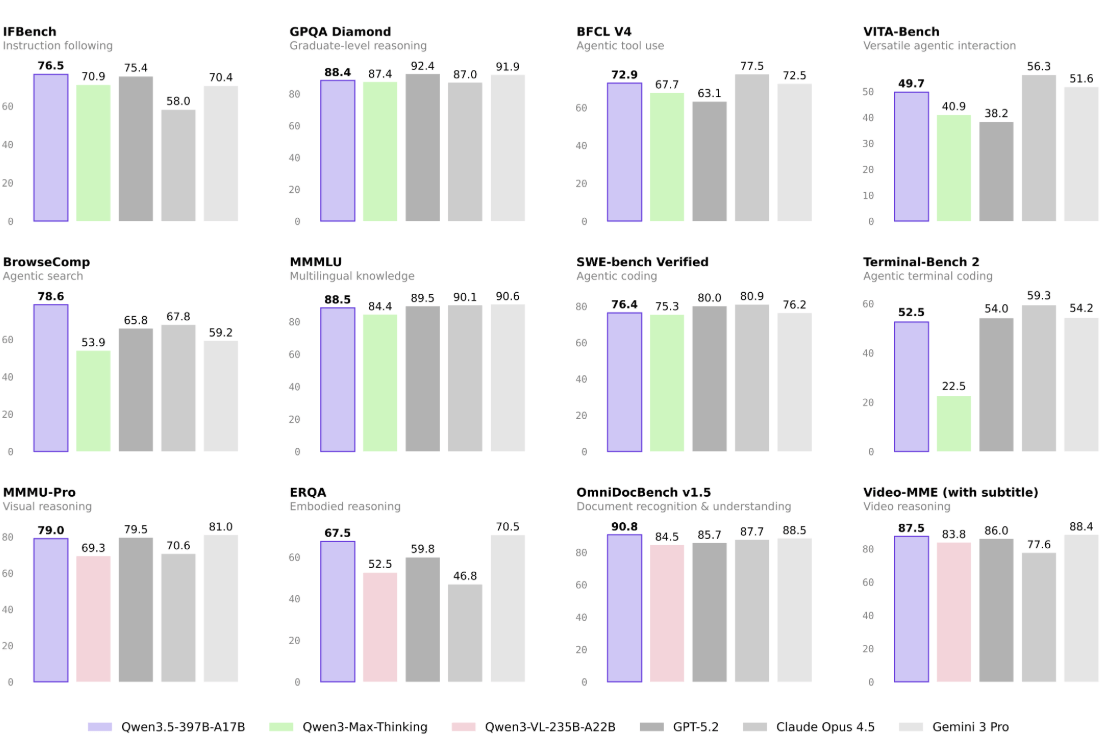

Di seguito viene presentata una valutazione completa dei modelli rispetto ai principali modelli di frontiera, su un’ampia gamma di attività e modalità.

Note metodologiche sui benchmark

- HLE-Verified: versione verificata e revisionata di Humanity’s Last Exam (HLE), accompagnata da un protocollo di verifica trasparente e da una tassonomia dettagliata degli errori. Il dataset è open-source su Hugging Face.

- TAU2-Bench: segue l’impostazione ufficiale, con eccezione del dominio “airline”, dove tutti i modelli sono valutati applicando le correzioni proposte nella system card di Claude Opus 4.5.

- MCP-Mark: il server GitHub MCP utilizza la versione v0.30.3 di api.githubcopilot.com; le risposte dello strumento Playwright sono troncate a 32k token.

- Search Agent: la maggior parte degli agenti di ricerca basati sul modello adotta una strategia semplice di “context-folding” (256k); quando la lunghezza cumulativa delle risposte degli strumenti supera una soglia predefinita, le risposte più vecchie vengono eliminate per mantenere il contesto entro i limiti.

- BrowseComp: sono state testate due strategie; il semplice context-folding ha ottenuto un punteggio di 69.0, mentre la strategia “discard-all” utilizzata da DeepSeek-V3.2 e Kimi K2.5 ha raggiunto 78.6.

- WideSearch: utilizzo di una finestra di contesto da 256k senza gestione del contesto.

- MMLU-ProX: accuratezza media su 29 lingue.

- WMT24++: sottoinsieme più complesso di WMT24, con etichettatura della difficoltà e riequilibrio; riportati punteggi medi su 55 lingue tramite XCOMET-XXL.

- MAXIFE: accuratezza su prompt originali in inglese e multilingue (23 configurazioni totali).

- Celle vuote (–) indicano punteggi non ancora disponibili o non applicabili.

Vision Language e capacità STEM

Alibaba ha presentato Qwen 3.5 come un modello con prestazioni migliorate in benchmark chiave, sostenendo che possa competere con modelli AI leader a livello globale, inclusi quelli sviluppati da giganti statunitensi come OpenAI (GPT-5.2), Anthropic (Claude Opus 4.5) e Google (Gemini 3 Pro).

Nel confronto, il modello Qwen3.5-397B-A17B mostra risultati particolarmente solidi nei compiti STEM e di problem solving.

Il ruolo del reinforcement learning

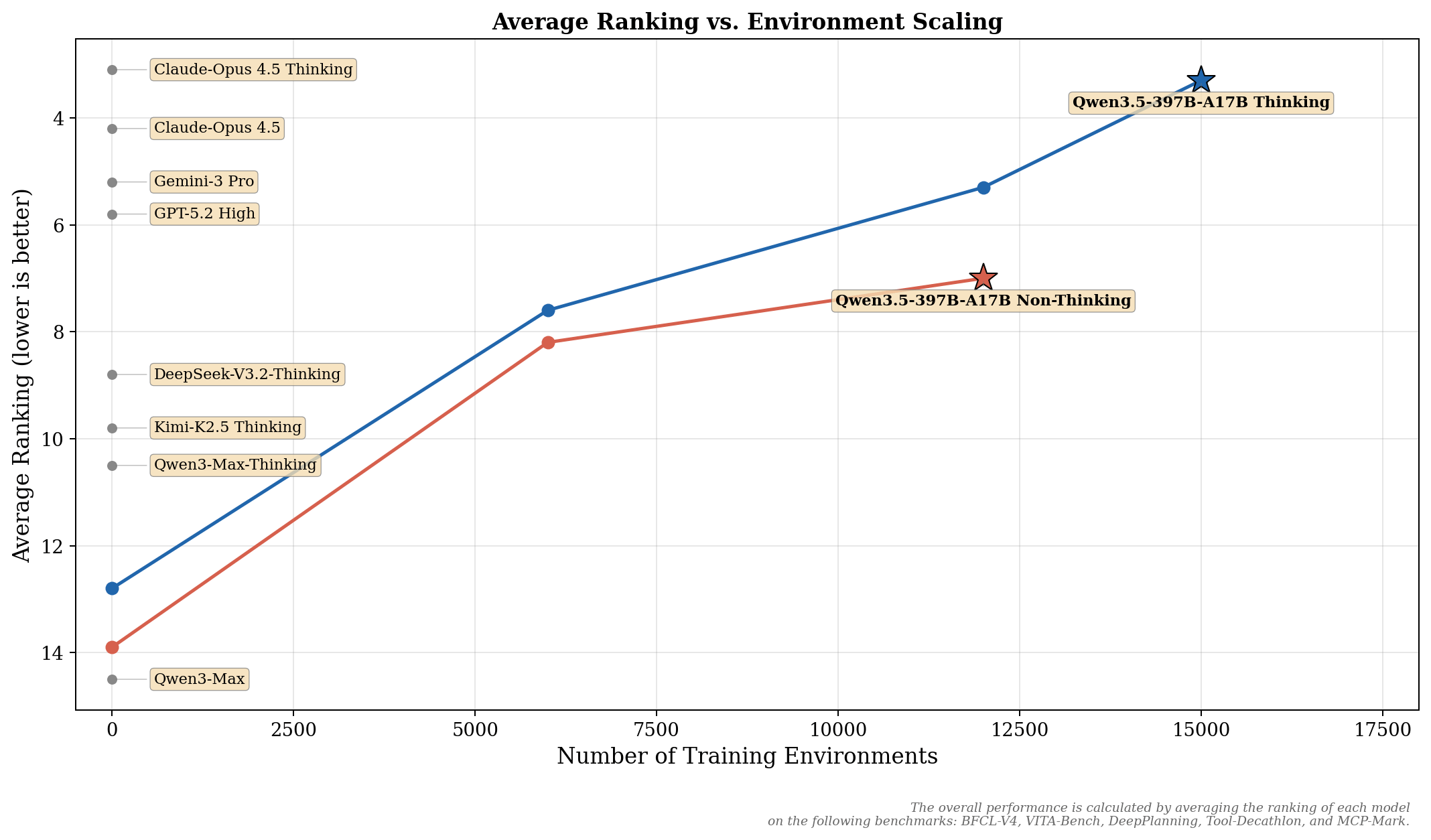

Rispetto alla serie Qwen3, i miglioramenti post-training di Qwen3.5 derivano principalmente da un’estensiva scalabilità dei compiti e degli ambienti di Reinforcement Learning (RL). L’approccio adottato ha privilegiato l’aumento della difficoltà e della generalizzabilità degli ambienti RL, piuttosto che l’ottimizzazione per metriche specifiche o categorie ristrette di query.

I progressi nelle capacità agentiche generali sono misurati calcolando la media del posizionamento di ciascun modello nei seguenti benchmark: BFCL-V4, VITA-Bench, DeepPlanning, Tool-Decathlon e MCP-Mark. Ulteriori risultati di scalabilità su un ventaglio più ampio di attività saranno dettagliati in un prossimo rapporto tecnico.

Con questo rilascio, Alibaba rafforza la propria strategia nell’intelligenza artificiale multimodale e agentica, puntando su efficienza, scalabilità e apertura dell’ecosistema per sviluppatori e imprese a livello globale.

La novità introduce anche il supporto per oltre 200 lingue e dialetti, oltre a funzionalità avanzate di ragionamento, elaborazione di immagini e agentic task execution (capacità di svolgere compiti complessi senza supervisione costante).

Pretraining: potenza, efficienza e versatilità

Qwen3.5 compie un significativo avanzamento nella fase di pretraining lungo tre direttrici principali: potenza, efficienza e versatilità.

Potenza: il modello è stato addestrato su una quantità molto più ampia di token visivo-testuali rispetto a Qwen3, con un arricchimento dei dati in cinese/inglese, multilingue, STEM e di ragionamento, sottoposti a filtri più rigorosi. Questo consente una parità generazionale: Qwen3.5-397B-A17B eguaglia il modello Qwen3-Max-Base da oltre 1 trilione di parametri.

Efficienza: costruito sull’architettura Qwen3-Next, integra una MoE (Mixture-of-Experts) a maggiore sparsità, un’attenzione ibrida Gated DeltaNet + Gated Attention, ottimizzazioni di stabilità e predizione multi-token. Con una lunghezza di contesto di 32k/256k, la velocità di decoding di Qwen3.5-397B-A17B è rispettivamente 8,6x/19,0x rispetto a Qwen3-Max, con prestazioni comparabili. Inoltre, il throughput è 3,5x/7,2x superiore rispetto a Qwen3-235B-A22B.

Versatilità: il modello è nativamente multimodale grazie a una fusione precoce testo-visione e all’espansione dei dati visivi, STEM e video, superando Qwen3-VL a parità di scala. La copertura linguistica cresce da 119 a 201 lingue e dialetti; un vocabolario da 250.000 token (contro i precedenti 150.000) migliora l’efficienza di codifica/decodifica dal 10% al 60% nella maggior parte delle lingue.

Infrastruttura: efficienza multimodale e FP8

Qwen3.5 abilita un addestramento multimodale nativo efficiente grazie a un’infrastruttura eterogenea che separa le strategie di parallelismo tra componenti visive e linguistiche, evitando le inefficienze degli approcci uniformi. Sfruttando attivazioni sparse per sovrapporre i calcoli tra componenti, il sistema raggiunge quasi il 100% del throughput di training rispetto ai modelli solo testuali, anche su dati misti testo-immagine-video.

A complemento, una pipeline nativa FP8 applica bassa precisione ad attivazioni, routing MoE e operazioni GEMM, con monitoraggio runtime che preserva BF16 negli strati sensibili. Questo comporta una riduzione di circa il 50% della memoria di attivazione e un incremento di velocità superiore al 10%, mantenendo stabilità anche su decine di trilioni di token.

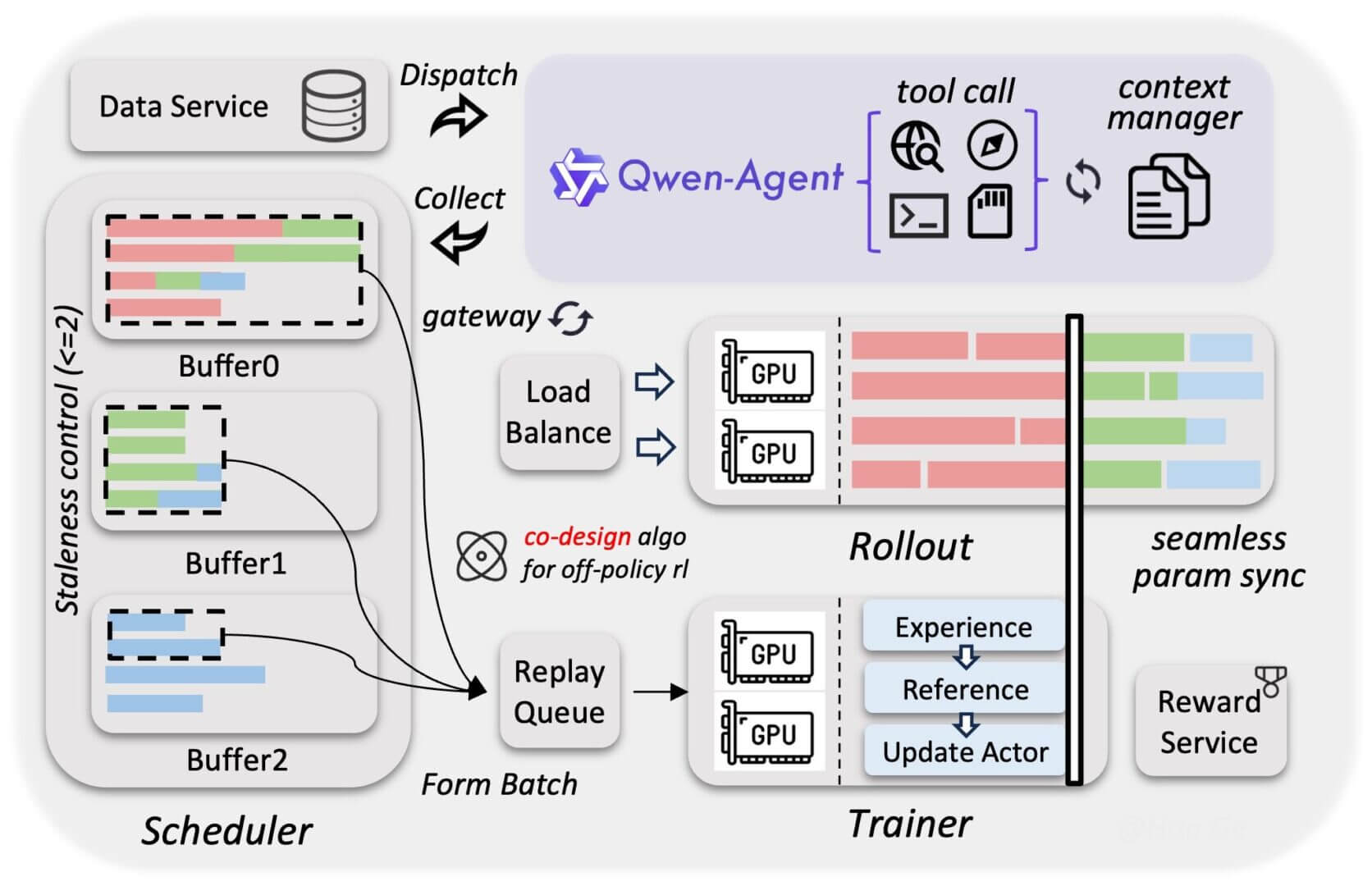

Framework RL scalabile e agentic workflow

Per potenziare in modo continuo il reinforcement learning, è stato sviluppato un framework RL asincrono e scalabile che supporta modelli Qwen3.5 di tutte le dimensioni, in contesti testuali, multimodali e multi-turn.

Grazie a un’architettura completamente disaggregata tra training e inferenza, il sistema migliora l’utilizzo hardware, il bilanciamento dinamico del carico e il recupero granulare dai guasti. L’ottimizzazione del throughput e la coerenza train–infer sono ulteriormente rafforzate da tecniche come:

- training end-to-end in FP8

- rollout router replay

- speculative decoding

- blocco dei rollout multi-turn

La co-progettazione tra sistema e algoritmi limita l’obsolescenza dei gradienti e riduce la distorsione dei dati, preservando stabilità e performance. Inoltre, il framework supporta nativamente workflow agentici, facilitando interazioni multi-turn fluide e senza interruzioni.

Il design disaccoppiato consente di gestire milioni di “scaffold” e ambienti agentici, migliorando significativamente la generalizzazione del modello. Nel complesso, queste ottimizzazioni producono un’accelerazione end-to-end tra 3x e 5x, con elevati livelli di stabilità, efficienza e scalabilità.

Competizione nel mercato cinese dell’intelligenza artificiale

Il lancio di Qwen 3.5 avviene in un momento di intensa competizione nel settore AI cinese. Tech company come ByteDance hanno recentemente aggiornato il proprio chatbot Doubao 2.0, progettato anch’esso per l’era agentica e con una vasta base di utenti attivi in Cina.

Allo stesso tempo, startup come DeepSeek hanno scosso il mercato globale con modelli open-source economici e performanti, spingendo l’intero ecosistema cinese verso soluzioni sempre più competitive e diversificate.

Strategia di adozione e risposta del mercato

Per aumentare l’adozione del proprio chatbot Qwen in Cina, Alibaba ha già implementato campagne promozionali, inclusi incentivi commerciali che hanno generato un significativo aumento degli utenti attivi nonostante problemi tecnici sporadici nelle fasi iniziali.

Il nuovo modello rappresenta un passo importante per Alibaba, che mira a consolidare la propria presenza nell’AI consumer e enterprise, cercando di bilanciare costo, performance e capacità autonome in un panorama tecnologico sempre più competitivo a livello sia nazionale che globale.

Prospettive future e impatto globale

Con Qwen 3.5, Alibaba non solo punta a rafforzare la propria posizione nel mercato domestico cinese, ma anche a sfidare tecnologie globali nelle applicazioni avanzate di intelligenza artificiale. Tuttavia, la diffusione internazionale di soluzioni AI cinesi potrebbe confrontarsi con preoccupazioni su privacy e tensioni geopolitiche, soprattutto nei mercati occidentali.

L’evoluzione di questa tecnologia verrà osservata da vicino sia da sviluppatori sia da investitori, mentre l’ecosistema globale dell’AI continua a trasformarsi rapidamente sotto la spinta dell’innovazione.

Qwen3.5 fornisce una solida base per la creazione di agenti digitali universali, grazie alla sua architettura ibrida efficiente e al ragionamento multimodale nativo.

Il prossimo salto evolutivo richiederà un passaggio dalla semplice scalabilità del modello all’integrazione sistemica: costruire agenti con memoria persistente per l’apprendimento tra sessioni, interfacce embodied per l’interazione con il mondo reale, meccanismi di auto-miglioramento e consapevolezza economica per operare entro vincoli pratici.

L’obiettivo è realizzare sistemi coerenti che operino autonomamente nel tempo, trasformando gli assistenti attuali – limitati a singole attività – in partner affidabili e persistenti, capaci di eseguire obiettivi complessi e di lunga durata con un giudizio allineato a quello umano.