Dal lancio di GPT-4, passando per i vari Gemini Ultra e Claude Opus, c’è stato un momento in cui l’opinione dominante sull’intelligenza artificiale Generativa è stata ostaggio di una singola metrica: la dimensione. Migliorare le performance di un LLM sembrava essere soltanto questione di parametri e quindi di potenza di calcolo. Tuttavia, questa non è l’unica strada da percorrere per ottenere prestazioni di tutto rispetto. Phi-4 di Microsoft rappresenta una delle dimostrazioni più mature e convincenti delle possibilitá offerte dagli Small Language Model.

Questo modello non nasce come una versione depotenziata di sistemi più grandi, è una creatura diversa, progettata per ottenere costi ridotti, latenze accettabili e la capacitá di essere eseguito su macchine con risorse limitate.

Questo nuovo paradigma puó fare la differenza quando si tratta di implementare automazioni AI-Powered in un processo industriale. I modelli di frontiera non sono più l’unica strada percorribile, ma é possibile lavorare con costi ridotti e potenzialmente senza problemi di compliance nella gestione dei dati sensibili.

Un modello da trilioni di parametri é decisamente eccessivo per portare a termine task banali, come riassumere un’email o estrarre dati da una fattura. Il consumo di risorse risulta del tutto sproporzionato rispetto al valore del task.

Risorse a parte, i modelli di frontiera espongono anche rischi operativi. La dipendenza totale da API esterne introduce latenza (il tempo di risposta dipende dal traffico sui server del provider) e pone seri interrogativi sulla sovranità del dato e sull’uso che se ne fará.

La tesi alla base di Phi-4 è semplice: la qualità dei dati di addestramento batte la quantità dei parametri. Non serve ingerire enormi quantità di dati generalisti per creare un modello efficace; serve piuttosto il training set giusto, verticalizzato sulle esigenze che il modello dovrà coprire.

Indice degli argomenti:

Come funziona Microsoft Phi-4

Uno dei punti cardine dell’architettura di Phi-4 é il suo dataset di addestramento. Microsoft ha utilizzato modelli più grandi per generare dati sintetici, una sorta di libro di testo artificiale scritto appositamente per insegnare al modello come ragionare, come programmare e come dedurre conclusioni logiche.

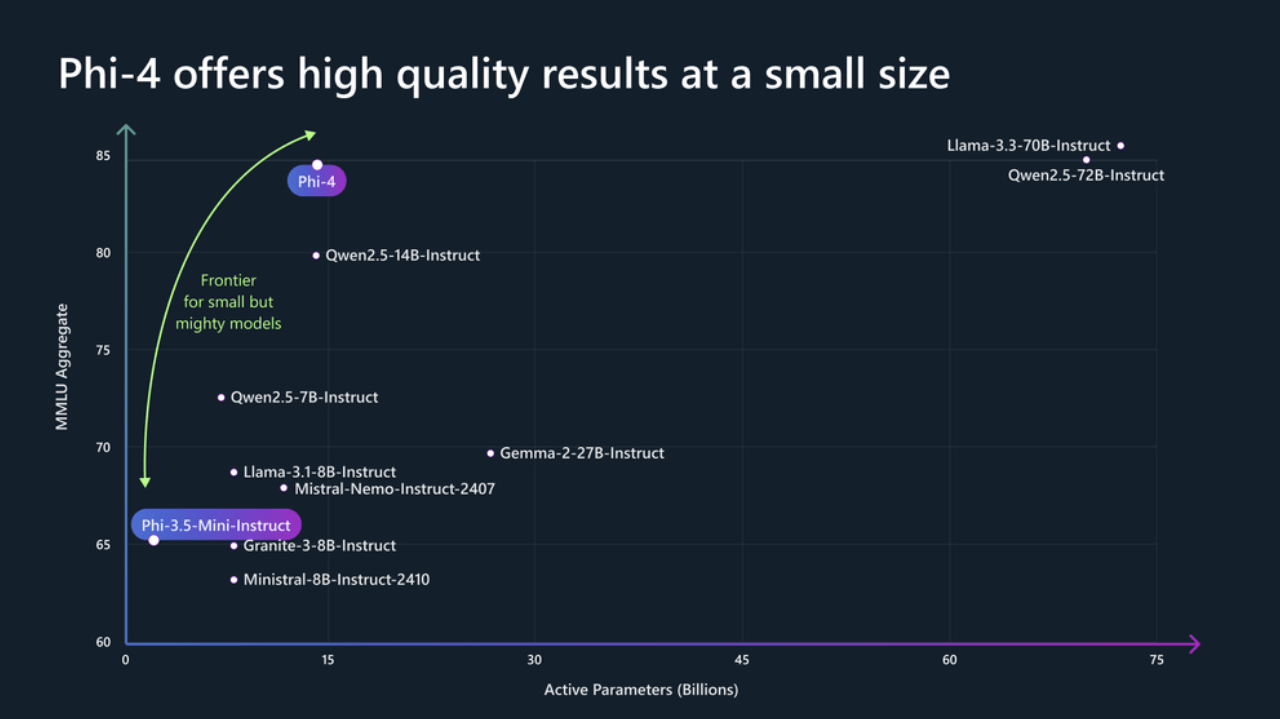

E questa strategia ha dato risultati interessanti. I benchmark tecnici (come MATH e MMLU) mostrano che Phi-4 possiede capacità di reasoning paragonabili a modelli molto più corposi come Llama-3 o addirittura avvicinandosi alle iterazioni più recenti di GPT in task specifici di matematica e coding.

Il modello è stato addestrato a scomporre i problemi complessi in passaggi più semplici (Chain of Thought), un processo che fino a poco tempo fa era appannaggio esclusivo dei modelli enormi.

Grazie a questo training su dati di alta qualità, l’architettura di Phi-4 richiede meno “neuroni” (parametri) per funzionare. Questo si traduce in un modello che può essere eseguito localmente, anche con una singola GPU di fascia consumer.

I vantaggi operativi di Phi-4

Una delle voci di costo principali nei processi AI-Powered é legata alle risorse utilizzate per l‘inferenza, ovvero l’atto di usare il modello per generare contenuti.

Ogni volta che si interroga un LLM in cloud, si paga per ogni token inviato e per ogni token generato dal modello. La tariffa varia a seconda di quanta capacitá di calcolo é necessaria per far girare il modello scelto.

Potenza ridotta

Phi-4, grazie alle sue dimensioni ridotte, riduce drasticamente la potenza necessaria. Se distribuito su cloud, richiede istanze GPU molto economiche. Se eseguito in locale (on-premise o on-device), il costo marginale per singola richiesta crolla quasi a zero, ammortizzato l’hardware iniziale.

Per aziende con milioni di transazioni o richieste al giorno, la differenza nella spesa operativa tra un LLM e un SLM può valere centinaia di migliaia di euro l’anno.

I grandi LLM sono energivori, e il loro uso può impattare in modo sensibile i report ESG, rendendo rilevante la questione della sostenibilità. Un’unica sessione di training di un LLM di frontiera consuma enormi quantitá di energia, e i datacenter l’inferenza continua brucia megawatt.

Adottare SLM come Phi-4 rientra in una strategia di Green AI, si ottiene il risultato desiderato con una frazione dell’impronta carbonica, un argomento di vendita potente e una necessità etica.

Latenza e velocitá

Latenza e velocitá sono altri due vantaggi evidenti dei modelli più piccoli. Attendere 10, 20 secondi per ogni risposta da un LLM sovraccarico può distruggere la user experience. Phi-4, essendo leggero, può rispondere in tempo quasi reale, offrendo quella fluidità conversazionale che l’utente si aspetta, specialmente in applicazioni vocali o interattive.

Compliance

Molti settori critici, come quello bancario, quello sanitario o quello legale, non possono permettersi per compliance (GDPR, normative interne) di inviare dati sensibili ai grandi player dell’Intelligenza artificiale. Phi-4 è Open Source ed é abbastanza piccolo da poter essere scaricato e fatto girare interamente all’interno del perimetro aziendale, su server privati o addirittura air-gapped, ovvero scollegati da internet.

Il dato non esce dall’azienda, e questo livello di segregazione dei dati è l’unico modo per abilitare processi AI-Powered in settori sensibili senza esporre l’organizzazione a rischi incalcolabili.

Come usare Phi-4 in azienda

Dove si colloca Phi-4 nell’operatività quotidiana? Questo piccolo modello sposta l’intelligenza artificiale dal cloud ai dispositivi locali, risolvendo scenari operativi dove i grandi modelli falliscono. Diventa indispensabile per il tecnico sul campo, come su una piattaforma petrolifera senza rete, che può diagnosticare guasti interrogando manuali direttamente dal tablet, ma è altrettanto cruciale in azienda per creare assistenti verticali specifici, capaci di guidare l’HR su buste paga o i legali sui contratti a costi ridotti.

La sua natura locale garantisce la totale riservatezza nell’analisi documentale, permettendo di riassumere report finanziari sensibili sfruttando solo la CPU del computer, e protegge la proprietà intellettuale delle software house, offrendo agli sviluppatori un copilota per la scrittura di codice sicuro che lavora nell’IDE senza mai esporre i dati proprietari all’esterno.

Democratizzazione dell’hardware

La democratizzazione dell’hardware semplifica l’adozione di Phi-4. Microsoft e i partner hardware (Intel, AMD, Qualcomm, Nvidia) stanno spingendo il concetto di AI PC. I nuovi laptop aziendali sono dotati di NPU (Neural Processing Units), chip dedicati proprio a far girare modelli come Phi.

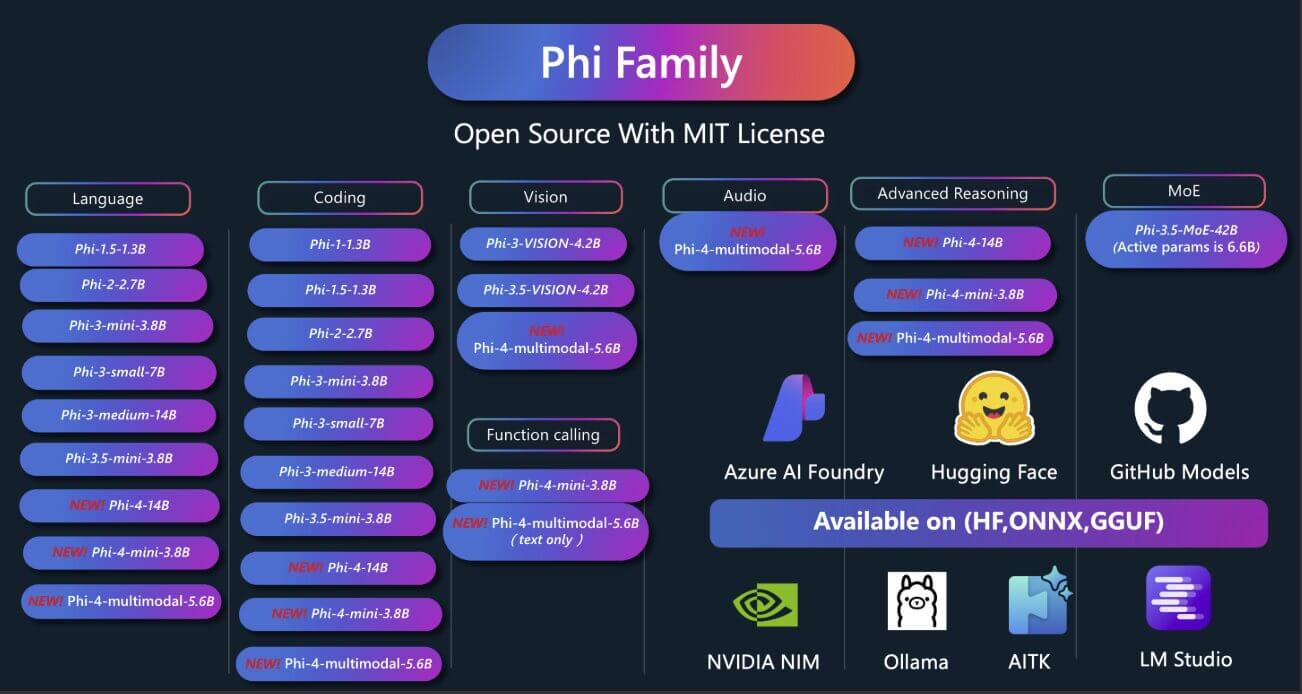

L’ecosistema software intorno agli SLM è maturato velocemente. Strumenti open-source come Ollama, LM Studio o il runtime ONNX di Microsoft permettono di scaricare Phi-4 e renderlo operativo in azienda con poche righe di comando.

Esistono container Docker pronti all’uso che trasformano qualsiasi server aziendale in un endpoint API compatibile con gli standard attuali. Un reparto IT tradizionale, con un minimo di upskilling, può gestire il deployment.

Il salto di qualitá definitivo nei risultati generati si sblocca con il fine-tuning. Poiché Phi-4 è piccolo, raffinare il modello sui dati specifici dell’azienda (il gergo tecnico, i prodotti, lo storico clienti) è un processo che richiede ore invece di settimane, e può essere fatto su una singola workstation potente.

Adottare una strategia ibrida

Lo scenario che si prefigura per i prossimi anni nelle PMI è quello di una orchestrazione intelligente. Il ruolo del manager IT del futuro sarà quello di concepire architetture ibride, che sfruttano i modelli di frontiera per i task di una complessità tale da giustificarne il costo e modelli specializzati, magari sotto forma di sistemi multi-agentici, per i task ad alto volume.

Phi-4 dimostra che la barriera tecnologica per l’ingresso dell’intelligenza artificiale diventa sempre più sottile. I costi sono crollati e la compliance è gestibile. Il consiglio per le aziende è quello di identificare da subito processi che possono fungere da proof of concept con un’implementazione locale di Phi-4, per capire come trasformare queste potenzialità in un vantaggio di business.

Risorse

- Microsoft Phi Cookbook https://aka.ms/Phicookbook

- Microsoft Phi-4-multimodal Tech Report https://aka.ms/phi-4-multimodal/techreport

- Microsoft Phi-4 Paper https://arxiv.org/abs/2412.08905