ChatGPT va in tilt. Cosa è successo? Martedì 18 novembre 2025, la società Cloudflare ha registrato una interruzione globale della propria rete che ha causato errori diffusi: codici HTTP 500, malfunzionamenti delle dashboard e delle API, rallentamenti o non raggiungibilità di piattaforme e siti web uno dei cui dati principali è l’intervento imprevisto sulle infrastrutture di rete.

Tra i servizi colpiti figurano ChatGPT e X (ex Twitter) ma anche molte altre piattaforme digitali e strumenti AI-centrici. L’outage non ha risparmiato strumenti come Claude e Sora, segnalati dagli utenti come indisponibili o degradati, il che suggerisce che la propagazione del guasto è arrivata fino alle applicazioni più “in alto” nella catena digitale.

Cloudflare ha attribuito la causa del malfunzionamento a uno “spike di traffico insolito” verso uno dei suoi servizi, registrato intorno alle 11:20 UTC, che ha generato errori nel traffico transitante sulla sua rete. L’azienda ha dichiarato che, mentre il traffico veniva riportato a regime, gli utenti potevano ancora osservare tassi di errore più elevati rispetto al normale.

Indice degli argomenti:

Le conseguenze per le aziende

Per il mondo delle tecnologie AI e per le aziende che ne fanno uso, questo episodio contiene una serie di implicazioni strategiche. Innanzitutto, evidenzia che non basta affidarsi a soluzioni “di front-end” o modelli generativi all’avanguardia se la catena infrastrutturale sottostante – routing, CDN, protezione DDoS, edge-network – può rappresentare un punto di rottura.

In secondo luogo, il fatto che servizi AI noti abbiano subito disservizi anche se non direttamente responsabili dell’infrastruttura dimostra la fragilità delle dipendenze in cascata: un operatore “dietro le quinte” può far saltare tutto.

Il messaggio per le imprese italiane

Per le imprese italiane e le startup AI in particolare, il messaggio è chiaro: occorre mappare la propria esposizione infrastrutturale, quali provider CDN/security si utilizzano, in che modo i fallback sono configurati, quali sono i punti di debolezza della catena. Un piano di resilienza digitale passa non solo dalla protezione contro attacchi esterni ma anche dalla diversificazione dei fornitori critici e dalla simulazione di scenari di outage infrastrutturale.

Infine, dal punto di vista politico-economico, l’interruzione serve a ricordare che l’ecosistema internet è servito da pochi grandi operatori che gestiscono funzioni centrali: quando uno di questi va offline, l’effetto domino è evidente. Questa concentrazione implica rischi che vanno considerati nelle strategie aziendali e dagli stakeholder pubblici che regolano l’ecosistema digitale.

Perché i servizi AI risentono dell’interruzione di Cloudflare

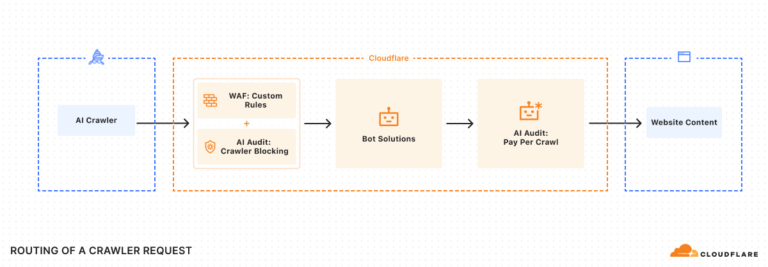

L’interruzione è significativa anche per il segmento AI-as-a-service: molte piattaforme di intelligenza artificiale si appoggiano a infrastrutture di rete, routing, CDN (Content Delivery Network) e servizi di protezione come quelli offerti da Cloudflare. Quando tale livello infrastrutturale è compromesso, i layer applicativi (chatbot, modelli generativi, API) diventano vulnerabili.

Nel caso specifico, sia ChatGPT, sia Claude e Sora hanno fatto registrare malfunzionamenti o errori legati più al “terzo livello” (la rete/intermediazione) che a un difetto interno del loro stack applicativo. Ad esempio TechRadar specifica che per ChatGPT “i servizi rispondono in modo intermittente… il problema è dovuto a un partner terzo piuttosto che ai server di ChatGPT”.

Implicazioni per il settore AI e per le imprese

Il blackout del 18 novembre rivela alcune evidenze fondamentali: la dipendenza da operatori infrastrutturali critici (come Cloudflare) rappresenta un rischio operativo per le piattaforme AI; l’interruzione dell’infrastruttura si propaga a cascata verso applicazioni e servizi business-critical.

Per le aziende che utilizzano servizi AI, in particolare per workflow, automazione, assistenza clienti o generazione di contenuti, l’evento sottolinea l’importanza di considerare la resilienza della catena digitale end-to-end: dal modello AI fino alla rete che lo supporta.

In ambito editoriale, servizi digitali o vendor AI che servono clienti aziendali, il messaggio è che non basta sviluppare o erogare modelli all’avanguardia: occorre assicurarsi che l’infrastruttura sottostante sia robusta, alternativa e monitorata.

Quali sono le cause e lo stato attuale

Cloudflare ha attribuito l’origine del guasto alla “spike di traffico insolito” che ha generato errori nell’elaborazione del traffico sulla sua rete. L’azienda ha avviato procedure di mitigazione e ha annunciato che i servizi stavano riconnettendosi.

Non è tuttavia ancora completamente disponibile un report pubblico che indichi in modo definitivo se l’origine sia un errore interno di routing, un problema di configurazione, o una combinazione di eventi. Alcuni esperti escludono che si tratti di un attacco esterno, vista la resilienza del sistema.

Analisi tecnica dettagliata per le aziende italiane che utilizzano servizi di intelligenza artificiale o infrastrutture digitali critiche

Indicatori da monitorare

Le aziende dovrebbero attivare il monitoraggio sui seguenti parametri:

- Tassi di errore HTTP 5xx: nel caso Cloudflare hanno registrato “widespread 500 errors” su dashboard e API.

- Latenza di rete e tempi di risposta dei servizi CDN/API, specie quelli che transitano da provider esterni.

- Variabilità del traffico in ingresso: un “spike di traffico insolito” è stato indicato come causa primaria dell’evento.

- Uptime e reachable-status dei fornitori infrastrutturali (CDN, WAF, Access, WARP). Cloudflare segnalava che “alcuni clienti possono ancora osservare errori più elevati del normale” durante il ripristino.

- Dipendenza degli endpoint applicativi da provider esterni: verificare quali API/servizi esterni si appoggiano all’infrastruttura potenzialmente impattata.

Moduli di fallback infrastrutturale

Per contenere il rischio operativo derivante da un outage infrastrutturale, si suggeriscono questi moduli operativi:

- Avere un provider alternativo per CDN/routing/security: se il principale è degradato, poter swit-off tempestivamente.

- Configurare fail-over automatico per risorse critiche: ad esempio, replica dei servizi AI su endpoint geografici e infrastrutturali distinti.

- Test periodici di regime degradato: simulare la perdita di un provider (ad es., Cloudflare) e verificare che l’applicazione continui a operare con latenza/errore accettabili.

- Segmentazione della catena tecnologica: rendere visibili internamente le dipendenze (infrastruttura → API → modello AI → frontend), identificando i “punti unici di rottura”.

- Monitoraggio continuo e alerting: non solo per applicazioni finali, ma anche per i servizi infrastrutturali sottostanti (CDN, WAF, rete) e i loro indicatori (latency, error-rates, traffic-anomaly).

Casi comparativi e contestualizzazione

L’evento Cloudflare non è isolato; fornisce spunti utili di contesto. Il precedente recente di Amazon Web Services (AWS) che ha avuto un outage importante nel mese precedente evidenzia che anche provider “di prima fascia” non sono immuni.

Il fatto che il guasto si manifesti dall’infrastruttura (routing, CDN, throttling) e non solo dall’applicativo richiede alle aziende di rivedere il proprio “raggio di dipendenza tecnico” più ampio rispetto al solo livello applicazione.

Dal punto di vista di governance e rischio, la consapevolezza che un’unica anomalia di traffico o routing possa propagarsi a numerose piattaforme (come è accaduto con ChatGPT, Claude, Sora) rafforza l’importanza della resilienza sistemica e della diversificazione.

Raccomandazioni operative per le imprese italiane

Per un’azienda italiana che offre servizi AI (o che li integra) e che dipende da infrastrutture digitali, le raccomandazioni operative sono:

- Mappatura immediata: identificare tutti i provider infrastrutturali utilizzati (CDN, WAF, API gateway, modello hosting) e valutarne la “criticità” in caso di outage.

- Verifica del contratto SLA e obblighi: controllare se il provider fornisce report sugli incidenti, quali metriche di servizio sono garantite, e se sono previsti piani di comunicazione tempestiva.

- Diversificazione tecnica: implementare una soluzione secondaria che possa subentrare in caso di fallimento del provider principale, con test periodici che ne verifichino il funzionamento.

- Piano di comunicazione interna ed esterna: definire come comunicare all’interno dell’organizzazione e ai clienti/utenti in caso di degradazione o interruzione dei servizi AI, includendo responsabilità e tempi stimati.

- Monitoraggio e alerting dedicati: non limitarsi a controllare l’applicativo AI, ma vigilare sulla “catena infrastrutturale” – traffico, latenza, error-rate del provider esterno.

- Simulazione di scenario: realizzare esercitazioni (table-top o test reali) su scenari di outage infrastrutturale, per verificare tempi di risposta, processi decisionali e fallback tecnici.