Nella corsa globale all’intelligenza artificiale, le domande sull’impatto ambientale sono diventate centrali. Quanta energia serve davvero per chiedere a un modello di generare testo, immagini o codice? Fino a oggi, nessuna big tech aveva mai offerto numeri precisi. Google ha deciso di rompere il silenzio.

In un report tecnico, l’azienda stima che un prompt testuale “medio” di Gemini consumi 0,24 wattora, emetta 0,03 grammi di CO₂ e utilizzi 0,26 millilitri di acqua per il raffreddamento dei data center. “L’impatto energetico per prompt è equivalente a guardare la TV per meno di 9 secondi,” scrive il colosso di Mountain View.

Indice degli argomenti:

La narrativa di Google: “Non c’è da preoccuparsi”

Google insiste sull’entità ridotta del fenomeno: un impatto minimo paragonato ad azioni quotidiane quasi impercettibili.

Jeff Dean, chief scientist dell’azienda, spiega: “Le persone non dovrebbero avere grandi preoccupazioni sull’uso energetico o idrico dei modelli Gemini, perché equivale a cose che si fanno senza pensarci, come guardare pochi secondi di TV o consumare cinque gocce d’acqua.”

Ma non si tratta solo di numeri. L’azienda sottolinea i progressi straordinari nell’efficienza: “In un recente periodo di 12 mesi, l’energia e l’impronta di carbonio totale del prompt di testo mediano di Gemini Apps sono diminuite rispettivamente di 33 e 44 volte, il tutto fornendo risposte di qualità superiore.”

Il merito sarebbe di innovazioni software e hardware: tecniche di quantizzazione, architetture Mixture-of-Experts che attivano solo parti del modello necessarie a rispondere, e le nuove TPU “Ironwood”, 30 volte più efficienti rispetto alle prime generazioni.

Google rivendica anche una politica energetica pionieristica: “Non utilizziamo la media delle reti dove operiamo, ma un approccio market-based che riflette i nostri contratti di acquisto da progetti solari, eolici, geotermici e nucleari.” Ma l’Agenzia Internazionale per l’Energia prevede che la domanda globale di energia raddoppierà nei prossimi cinque anni, fino a raggiungere 945 terawattora l’anno, l’equivalente dell’intero consumo elettrico del Giappone.

Il contrappunto del MIT: “Un passo avanti, ma incompleto”

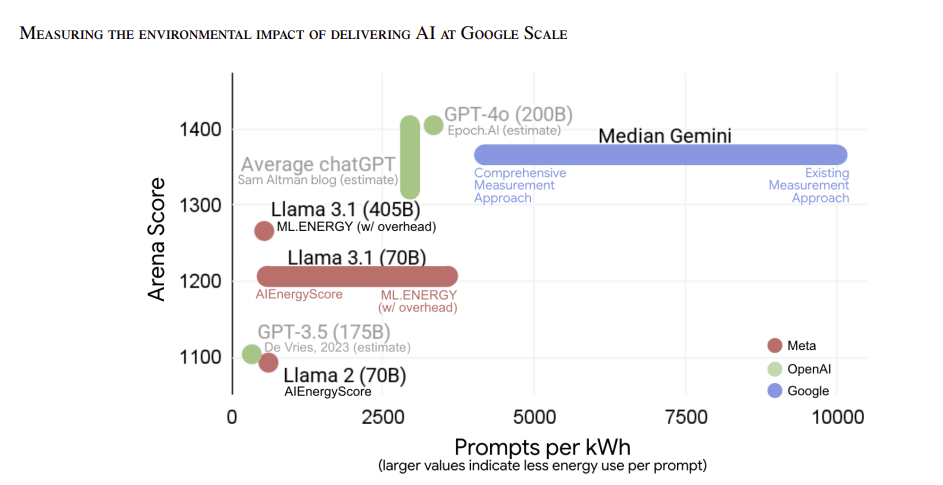

La pubblicazione ha suscitato grande attenzione. MIT Technology Review l’ha definita “la stima più trasparente finora da parte di una big tech con un prodotto AI popolare.”

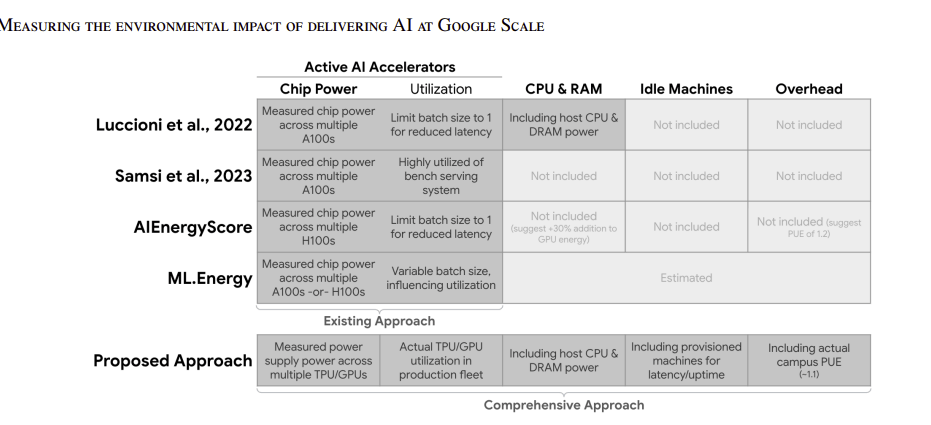

Il report è apprezzato soprattutto per la metodologia: “In questa misurazione, i chip AI di Google – le TPU – rappresentano solo il 58% della domanda totale di elettricità. Le CPU e la memoria degli host contano per un altro 25%, le macchine inattive per il 10% e l’overhead dei data center per l’8%.”

Questo approccio “full stack” è ciò che i ricercatori chiedevano da anni. Mosharaf Chowdhury, professore all’Università del Michigan, lo definisce un contributo che solo i giganti del settore possono offrire: “Sono stime che solo le aziende possono produrre, perché operano su dimensioni molto più grandi dei ricercatori indipendenti.”

Eppure, le zone d’ombra restano. “La cifra di Google non è rappresentativa di tutte le query inviate a Gemini,” scrive il MIT. Lo stesso Dean lo ammette: “Caricare decine di libri e chiedere un riassunto dettagliato probabilmente richiederà più energia del prompt mediano.”

Immagine: Google

Le domande ancora aperte

Il report riguarda solo i prompt testuali. Mancano i dati su immagini, audio e video, che secondo diversi studi richiedono molta più energia. E soprattutto, Google non ha rivelato il volume totale delle query giornaliere: un’informazione che permetterebbe di stimare l’impatto reale a scala globale.

Per questo, ricercatori come Sasha Luccioni di Hugging Face insistono: “Siamo contenti che abbiano pubblicato questi dati, ma restano ancora dettagli mancanti. Ad esempio, il numero totale di query giornaliere: senza questo dato, non possiamo stimare l’impatto complessivo.”

E aggiunge: “Spingiamo per un punteggio energetico standardizzato dell’AI, simile all’Energy Star per gli elettrodomestici. Questo non è ancora un sostituto per confronti indipendenti e coerenti.” Una sorta di “etichetta energetica per l’AI“, che fissi confini, ipotesi e fattori emissivi in modo uniforme.

Micro-storie rassicuranti, macro-dati assenti

Il gesto di Google resta comunque significativo. Per la prima volta, un colosso dell’AI apre il sipario e quantifica in modo trasparente il consumo di energia e acqua dei propri modelli. È un passo che può fare scuola.

Ma come spesso accade nella tecnologia, la storia è fatta di contrasti: da una parte l’ottimismo aziendale, che invita a pensare a poche gocce d’acqua e a secondi di televisione; dall’altra l’avvertimento degli analisti, che ricordano come il vero impatto non stia nel singolo prompt, ma nel totale delle interazioni di miliardi di utenti.

La domanda, dunque, resta inevasa: l’AI è davvero sostenibile? Oppure ci stiamo limitando a misurare solo ciò che conviene mostrare?