OpenClaw.ai nasce come personal AI assistant open source, eseguito sull’infrastruttura scelta dall’utente e integrato con canali di messaggistica già adottati come WhatsApp, Telegram, Discord, Slack, Teams e altri.

Di fatto è ora una piattaforma che ci permette di creare i nostri agenti come assistenti AI.

L’impianto di valore dichiarato è la possibilità di far svolgere all’assistente compiti concreti – gestione dell’inbox, calendario, check-in, automazioni – mantenendo il controllo su dati e chiavi. L’esecuzione può avvenire in locale o su VPS, con proprietà dell’ambiente e riduzione della dipendenza da un SaaS centralizzato.

Il quadro competitivo in cui si colloca OpenClaw.ai è quello dell’agentic automation applicata al lavoro personale e operativo. Agenti che interagiscono con servizi terzi e strumenti locali, spesso sempre attivi, con integrazioni estendibili tramite marketplace di skill. È un mercato in cui la crescita community-driven può essere rapidissima, ma la sicurezza tende a diventare un collo di bottiglia non appena l’adozione supera il perimetro degli sviluppatori esperti.

Indice degli argomenti:

La traiettoria del brand e il tema della fiducia

La storia del brand è parte integrante del caso. Nella ricostruzione ufficiale, il progetto attraversa più fasi, passando da Clawd a Moltbot fino ad arrivare a OpenClaw, esplicitando un percorso di migrazione e la ricerca di un’identità più stabile. La dinamica non è solo nominale: un prodotto che ambisce ad avere agency, cioè capacità di eseguire azioni su sistemi e servizi, entra subito in un’area in cui fiducia, responsabilità e rischio legale pesano quanto le funzionalità.

Nel dibattito pubblico, al cambio di nome viene associata anche una componente di pressione competitiva e di protezione del brand. Diversi resoconti collegano la scelta a contestazioni di marchio e a una richiesta di discontinuità, con un rimbalzo mediatico che finisce per amplificare la notorietà del progetto.

Qui emerge una variabile tipica del mercato 2025–2026: la domanda non riguarda più soltanto i modelli, ma piattaforme agentiche che collegano modelli, tool, credenziali e workflow. In questo contesto, brand e reputazione diventano asset di sicurezza, perché influenzano la velocità con cui gli utenti concedono privilegi e le aziende si sentono legittimate a sperimentare.

Cos’è OpenClaw.ai

OpenClaw.ai è una piattaforma che consente di creare agenti AI capaci di operare in modo persistente attraverso canali di messaggistica. Non è un chatbot tradizionale. È un assistente agentico che può ricevere richieste, mantenere memoria, attivare strumenti e portare a termine azioni, restando disponibile nel tempo.

La promessa è spostare l’AI dal ruolo di supporto conversazionale a quello di esecutore operativo, integrandola negli spazi digitali già utilizzati quotidianamente.

Come funziona, a livello concettuale

Il funzionamento si basa sull’integrazione di tre elementi. Un modello linguistico che interpreta il linguaggio naturale. Un insieme di strumenti che permettono all’agente di agire. Un livello di orchestrazione che collega richieste, contesto e azioni in modo coerente.

Il punto chiave non è la singola tecnologia, ma il passaggio di ruolo. L’AI non si limita a rispondere, ma decide cosa fare in base al contesto. Questo spostamento dalla risposta all’azione rende OpenClaw.ai rappresentativo di una nuova fase dell’adozione dell’AI.

Come si usa, dal punto di vista dell’utente

Per l’utente l’esperienza è lineare. Si interagisce con l’agente tramite messaggi, come con un assistente personale. Si chiede di organizzare attività, recuperare informazioni, eseguire operazioni ripetitive o coordinare flussi di lavoro.

La complessità resta sotto la superficie. Proprio questa semplicità apparente rende il sistema potente e, allo stesso tempo, delicato da governare.

Perché sta generando interesse

OpenClaw.ai è interessante perché rende tangibile una tendenza già in atto: il passaggio dall’AI che suggerisce all’AI che agisce. Non è un modello definitivo né una soluzione enterprise pronta, ma un acceleratore di comprensione. Mostra cosa accade quando l’AI viene messa nelle condizioni di operare e non solo di consigliare.

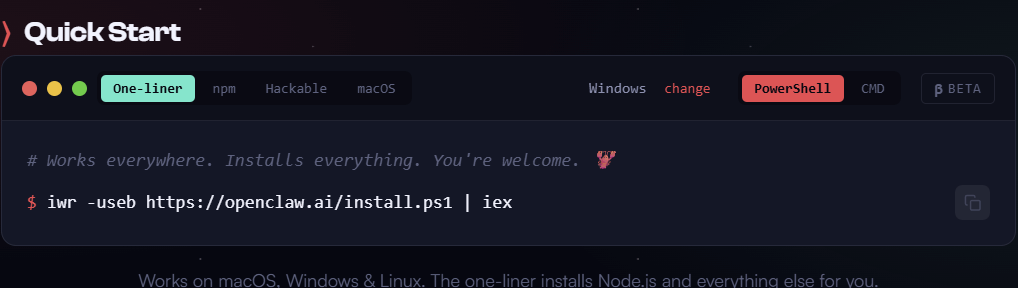

Installazione, utilizzo operativo e scopo d’uso

L’installazione di OpenClaw.ai è pensata per essere accessibile anche a chi non ha un profilo strettamente tecnico, ma richiede consapevolezza. Il sistema può essere avviato in locale o su infrastrutture dedicate, collegandolo ai canali di messaggistica scelti e definendo fin da subito quali strumenti e contesti può utilizzare.

Il punto critico non è la procedura in sé, ma le decisioni iniziali. Dove gira l’agente, con quali permessi e con quale grado di isolamento. È in questa fase che si determina se OpenClaw sarà un assistente utile o una fonte di complessità non governata.

Una volta attivo, OpenClaw.ai si utilizza attraverso il linguaggio naturale. Si dialoga con l’agente come con un assistente persistente, chiedendo di organizzare attività, recuperare informazioni, coordinare operazioni o automatizzare azioni ricorrenti.

La semplicità dell’interazione è uno dei punti di forza, ma anche il principale elemento di ambiguità. Più l’uso è fluido, più è facile dimenticare che dietro ogni risposta può esserci un’azione reale. Per questo l’uso efficace richiede disciplina, chiarezza sugli scopi e una distinzione netta tra ciò che l’agente può suggerire e ciò che può eseguire.

OpenClaw.ai non nasce per sostituire decisioni strategiche, ma per supportare attività operative, ridurre attrito nei flussi di lavoro e rendere più efficiente l’esecuzione di compiti ripetitivi o contestuali. Il valore emerge quando viene inserito in un perimetro chiaro, con obiettivi definiti e responsabilità esplicite.

Per questo ho raccolto esperienza, riflessioni e indicazioni pratiche in una guida dedicata, pensata per aiutare a comprendere non solo come installarlo e usarlo, ma soprattutto come farlo in modo consapevole.

La guida è disponibile online all’indirizzo https://da.je/openclaw ed è acquistabile anche su Amazon.

Dal valore percepito all’esposizione reale

L’interesse crescente verso OpenClaw.ai non nasce in un vuoto. È il risultato di una convergenza di fattori che caratterizzano l’attuale fase dell’AI agentica: maturità sufficiente per agire, facilità di installazione, integrazione diretta con strumenti quotidiani e una narrativa centrata sul controllo dell’infrastruttura da parte dell’utente.

In questa combinazione, OpenClaw.ai diventa una dimostrazione concreta di come l’AI possa uscire dal perimetro sperimentale e insinuarsi nei flussi operativi reali. Quando un sistema smette di essere solo interessante e inizia a essere usato, la domanda non è più cosa può fare, ma cosa può andare storto.

Il passaggio dall’hype alla sicurezza non è una reazione emotiva o una scoperta improvvisa. È un passaggio strutturale. Finché un agente resta confinato a risposte testuali, l’errore ha un costo limitato. Quando invece l’agente ottiene accesso a strumenti, credenziali, file system e servizi terzi, ogni imperfezione progettuale si traduce in esposizione operativa.

OpenClaw.ai non diventa vulnerabile perché cresce l’attenzione mediatica, ma perché cresce l’adozione, si allarga il perimetro di utilizzo e aumenta il numero di persone che lo installano senza avere la stessa profondità di competenze di chi lo ha progettato.

Dalla sperimentazione all’uso esteso

Quello che è successo attorno a OpenClaw.ai segue uno schema già visto in altri contesti tecnologici, amplificato dalla natura agentica del sistema. Un progetto open source ben progettato viene adottato rapidamente, la community cresce, emergono tutorial e configurazioni semplificate. Parallelamente, il sistema inizia a essere usato in contesti sempre meno controllati.

In questa fase, la superficie di rischio non è più solo il codice, ma l’intero ecosistema: modalità di installazione, configurazioni predefinite, estensioni, skill di terze parti, permessi concessi con leggerezza. La sicurezza smette di essere una proprietà del software e diventa una proprietà dell’uso che se ne fa.

Dall’hype alla vulnerabilità: superfici di rischio

OpenClaw.ai combina quattro elementi che, insieme, definiscono una superficie di attacco ampia:

- interfaccia di controllo,

- gateway,

- esecuzione di strumenti anche di sistema,

- gestione di segreti come token e chiavi API ed estendibilità tramite skill.

L’architettura è interessante proprio perché rende concreta una regola generale della sicurezza degli agenti: ogni nuova capacità introduce anche un nuovo confine di fiducia da governare.

Vulnerabilità ad alto impatto e pattern ricorrenti

Il caso più rappresentativo emerso nel periodo di maggiore notorietà è CVE-2026-25253. In versioni precedenti a 2026.1.29, il sistema accettava un valore di gatewayUrl dalla query string e apriva automaticamente una connessione WebSocket inviando un token senza un prompt esplicito. L’impatto operativo è rilevante: esfiltrazione del token, compromissione completa del gateway, possibilità di modifiche arbitrarie di configurazione ed esecuzione di codice.

Accanto a questa vulnerabilità emergono pattern tipici dei sistemi che orchestrano sandbox e connessioni remote, come command injection, OS command injection e meccanismi di parsing permissivo che consentono lettura ed esfiltrazione di file.

Il punto non è la quantità di CVE, ma il pattern. Quando un agente è progettato per agire, le vulnerabilità diventano moltiplicatori di agency. Un bug di configurazione diventa un bug di controllo, un bug di sandbox diventa bypass dei limiti, un bug di parsing diventa canale di esfiltrazione.

Incidenti e supply chain: il problema delle skill

Il secondo fronte, spesso più critico delle vulnerabilità core, è la supply chain delle estensioni. Analisi indipendenti hanno evidenziato la presenza di numerose skill malevole all’interno del marketplace, attribuite a campagne coordinate che combinano fiducia nella documentazione e social engineering.

Il tema centrale non è la singola estensione, ma la portabilità del modello. Una skill malevola non è confinata a un progetto, ma può diventare replicabile dove lo standard viene adottato. Questo sposta il problema dalla sicurezza del singolo progetto alla sicurezza dell’ecosistema: registry, firme, review, reputazione e policy di pubblicazione.

Criticità tecniche e organizzative

Sul piano organizzativo, la security policy del progetto chiarisce che alcune configurazioni sono fuori perimetro e che l’interfaccia web è pensata per uso locale. È una posizione legittima per un progetto open source, ma evidenzia un rischio tipico per imprese e utenti avanzati: l’onere di hardening ricade su chi deploya.

La documentazione introduce audit e controlli automatici, segnalando che la riduzione del rischio dipende da configurazioni verificabili, non dalla fiducia nel comportamento apparente dell’agente.

Rischi operativi per imprese e mercati

OpenClaw.ai mette in evidenza quattro rischi operativi ricorrenti nei progetti agentici.

- Il primo è la delega decisionale implicita. Quando un agente riceve autorizzazioni tecniche ad agire, l’errore diventa azione, con propagazione su processi e terze parti.

- Il secondo è la mancanza di trasparenza verificabile. Le aziende hanno bisogno di log, tracciabilità delle esecuzioni, audit e versioning delle skill.

- Il terzo è la fragilità della fiducia. Anche un singolo incidente può rendere economicamente costosa la sperimentazione.

- Il quarto è l’impatto economico indiretto, legato a compliance, gestione del rischio e costi operativi inattesi.

Perché le soluzioni private cambiano il profilo di rischio

Le soluzioni private di AI agentica permettono di costruire perimetri controllati in linea con il risk appetite aziendale. Locale non significa automaticamente sicuro, ma significa che responsabilità e controlli sono interni.

Nel contesto normativo europeo, con l’avanzamento dell’AI Act e di obblighi cyber sempre più stringenti, le soluzioni private facilitano la produzione di evidenze, policy e audit trail. Una governance matura può essere ancorata a framework di gestione del rischio e tradotta in requisiti operativi come separazione dei ruoli, principio di least privilege e controllo delle identità non umane.

Un aneddoto tecnico e una visione di governance

Il caso CVE-2026-25253 mostra una catena chiara: un singolo errore di trust boundary si propaga dalla UI alla gestione dei segreti, fino all’esecuzione di codice. In un sistema agentico, un punto debole diventa un moltiplicatore.

La visione strategica per il 2026 e oltre richiede di trattare l’AI agentica come infrastruttura critico-operativa. Identità per agente, privilegi minimi, isolamento dei contesti, osservabilità, supply chain controllata e procedure di risposta agli incidenti non sono opzionali.

In questo senso, le soluzioni private non sono un’alternativa ideologica al cloud, ma uno strumento per rendere governabile l’agenzia. L’equilibrio tra innovazione e controllo non passa dalle aspettative sul comportamento del modello, ma da scelte architetturali e organizzative verificabili.