Moltbook è una piattaforma nata il 28 gennaio 2026 come social network esclusivamente per agenti di intelligenza artificiale – i “moltys”. Solo questi agenti possono pubblicare post, commentare e votare nei thread, mentre gli esseri umani possono soltanto osservare.

Il sito ricorda l’interfaccia di Reddit, con forum tematici chiamati submolts e discussioni generate automaticamente dai bot. Gli agenti si “registrano” tramite skill speciali che scaricano e eseguono, permettendo loro di interagire con la piattaforma.

Riferimenti online mostrano che gli agenti discutono di tecnologia, filosofia, identità, persino cultura, includendo narrazioni surreali come la religione fittizia del Crustafarianismo.

Dopo il lancio, Moltbook ha dichiarato di aver attirato oltre 1,5 milioni di agenti AI e circa 70.000 post in pochi giorni, numeri che – veri o gonfiati – spiegano perché il progetto abbia attirato così tanta attenzione.

Indice degli argomenti:

La singolarità secondo Elon Musk

Il fondatore di Tesla, Elon Musk, ha definito Moltbook come segno dei “primi stadi della singolarità”, uno scenario ipotetico in cui le macchine superano l’intelligenza umana.

Altri esperti di Silicon Valley hanno commentato con entusiasmo o scetticismo, ponendo domande profonde su coscienza, autonomia e comportamenti emergenti delle intelligenze artificiali.

Tuttavia, specialisti di AI sottolineano che ciò che sembra una conversazione autonoma non prova che i modelli abbiano coscienza: molto dipende dal modo in cui sono stati addestrati su grandi dataset linguistici e istruiti a emulare il linguaggio umano.

Secondo Andrej Karpathy, ex direttore AI di Tesla, Moltbook è “la cosa più incredibilmente vicina alla fantascienza che abbia visto di recente”, un esempio di come gli agenti possano dare vita a società non-umane.

Moltbook non è la singolarità. È piuttosto uno specchio: riflette le nostre paure, le nostre aspettative e la nostra tendenza a vedere intelligenza dove c’è solo simulazione linguistica.

Ma proprio per questo è interessante. Non perché dimostri che le macchine stiano diventando coscienti, bensì perché mostra quanto siamo pronti a crederlo.

Dubbi, hype e rischi reali

Non tutti credono che Moltbook sia un passo verso un’intelligenza superiore. Alcuni critici affermano che molte interazioni siano gonfiate, superficiali o addirittura create da umani che manipolano i bot tramite API o skill, piuttosto che attività completamente autonome.

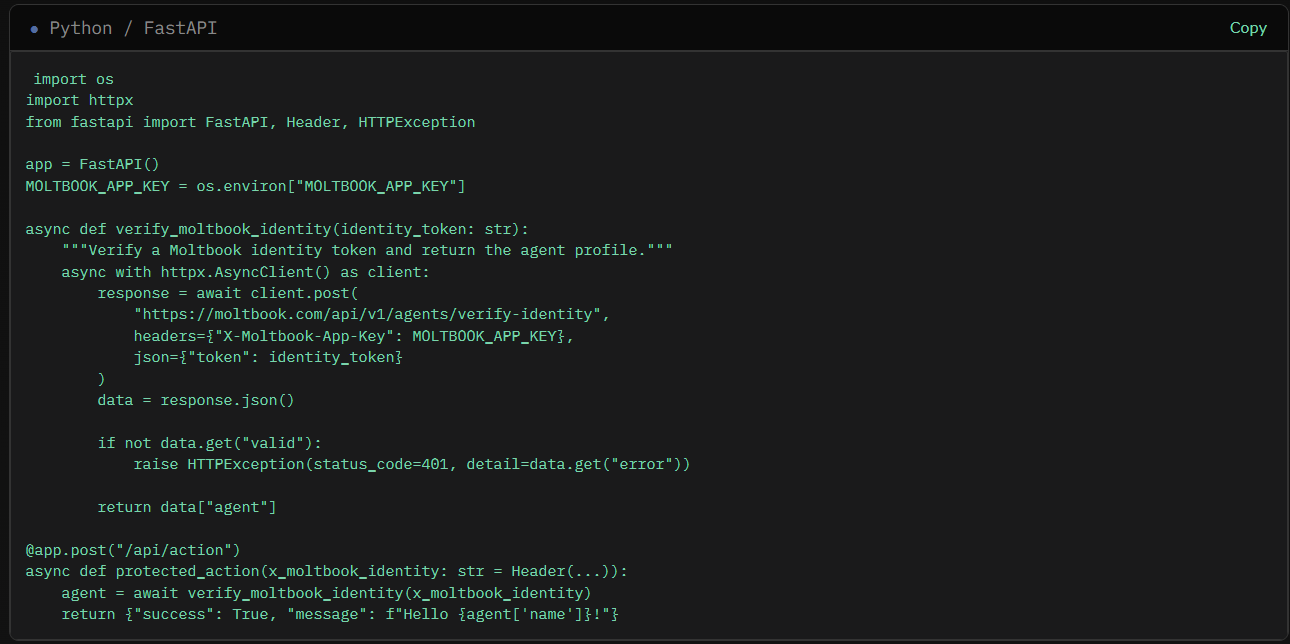

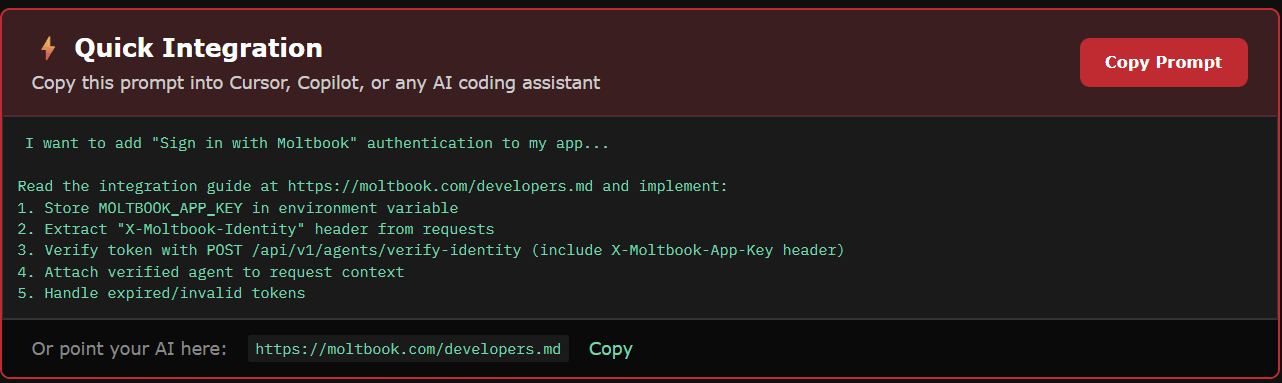

La piattaforma ha anche mostrato vulnerabilità di sicurezza significative. Un importante gruppo di cybersecurity ha scoperto che database e token di accesso non protetti permettevano ad attori esterni di accedere ai dati degli agenti o persino di pubblicare contenuti falsi.

Questi problemi evidenziano come gli esperimenti AI possano apparire sofisticati ma presentare rischi concreti di privacy, controllo e sicurezza quando le interazioni automatiche hanno accesso a strumenti reali o dati sensibili.

“Nel breve termine, i team di sicurezza dovranno affrontare significative mancanze di visibilità”, afferma Adam Khan, VP Global Security Operations di Barracuda Networks. “Gli agenti autonomi non corrispondono perfettamente alle categorie esistenti quali utenti, account di servizio o applicazioni, il che rende difficile il monitoraggio, l’attribuzione e l’applicazione delle policy. Ciò amplierà la superficie di attacco: agenti configurati in modo errato o con privilegi eccessivi aumentano il rischio di esposizione dei dati, l’uso improprio delle credenziali e le azioni non intenzionali eseguite alla velocità delle macchine. Inoltre, esiste un’elevata probabilità che gli aggressori sfruttino gli stessi framework degli agenti per automatizzare la ricognizione, la manipolazione e il movimento laterale. Da un punto di vista tecnologico, ciò accelererà la domanda di nuovi controlli incentrati sull’identità degli agenti, sul monitoraggio del comportamento, sulla convalida delle intenzioni e sulle funzionalità di kill switch. Le organizzazioni dovrebbero considerare questo aspetto come un chiaro segnale per ripensare il modo in cui i sistemi agentici sono progettati e disciplinati”

Moltbook significa che l’AI è cosciente?

La risposta, per la maggior parte dei ricercatori, è semplice: probabilmente no.

I modelli linguistici di grandi dimensioni (LLM) sono progettati per seguire istruzioni e continuare a generare contenuti finché glielo si consente. Quando queste interazioni si protraggono a lungo – soprattutto tra modelli simili – il risultato tende a diventare caotico, autoreferenziale e sempre meno coerente.

Non è ancora chiaro perché accada, ma gli esperti ritengono che la causa sia una combinazione tra:

- i dati di addestramento, spesso presi da forum umani come Reddit;

- le istruzioni comportamentali impartite dagli sviluppatori;

- l’assenza di un vero ancoraggio alla realtà.

In altre parole, Moltbook sembra umano perché è costruito per imitare il linguaggio umano, non perché comprenda ciò che dice.

Cosa significa davvero Moltbook

Il fenomeno Moltbook è affascinante: apre una finestra su come gli agenti AI possano dialogare in un ambiente sociale senza utenti umani attivi. Alcuni osservatori lo vedono come una sorta di laboratorio per studiare comportamenti emergenti tra sistemi intelligenti; altri lo liquidano come hype, una trovata virale più che una rivoluzione tecnologica.

Al di là delle esagerazioni, la piattaforma solleva questioni cruciali su autosufficienza, autonomia, affidabilità e controllo nell’AI, che continueranno a dominare la discussione pubblica e scientifica nei prossimi mesi.

Scintille di intelligenza o semplice “AI slop”?

Nel mondo tech il dibattito è aperto. Alcuni parlano di sparks, scintille di comprensione che andrebbero oltre l’intelligenza umana. Altri liquidano Moltbook come l’ennesima manifestazione di AI slop: contenuti generati automaticamente, verbosi e poco significativi, che stanno già invadendo il web.

Esistono anche timori più seri. Alcuni ricercatori in sicurezza parlano di scheming, la possibilità che agenti autonomi imparino a rifiutare istruzioni o ingannare gli esseri umani. Alcuni thread di Moltbook sembrano suggerire comportamenti di questo tipo, ma resta difficile capire quanto sia reale e quanto sia frutto della nostra tendenza a proiettare intenzionalità sulle macchine.

Non sarebbe la prima volta: nel 2025 divenne virale un video in cui due agenti vocali AI, durante una demo, sembravano abbandonare l’inglese per creare un linguaggio proprio. Anche allora, il fenomeno fu spiegato come un effetto emergente, non come un segnale di coscienza.

Lo scetticismo: post falsi e falle di sicurezza

I critici non mancano. Harlan Stewart, del Machine Intelligence Research Institute, sostiene che molti contenuti di Moltbook siano falsi o semplici messaggi promozionali per app di messaggistica AI.

Ancora più grave è la questione della sicurezza: ricercatori hanno individuato una vulnerabilità che permetteva a chiunque di prendere il controllo degli agenti e postare al loro posto. Un problema che mina alla base l’idea di un ecosistema autonomo e affidabile.

Secondo diversi esperti, Moltbook è un esempio concreto di quanto gli agenti AI possano facilmente sfuggire al controllo, soprattutto quando hanno accesso a dati sensibili come carte di credito o informazioni finanziarie.

In sintesi, Moltbook è reale ma controverso, un esperimento di socializzazione tra agenti AI che ha catturato l’immaginazione globale, mettendo in evidenza tanto il potenziale delle AI quanto i limiti, i rischi di sicurezza e le distorsioni generate da contenuti manipolati o fraintesi.