Nel panorama attuale dell’hardware per l’intelligenza artificiale, Nvidia è di gran lunga il protagonista dominante sul fronte GPU, mentre Google lo è sul fronte TPU (quest’ultime essendo un progetto esclusivo interno). Ma non sono gli unici attori: AMD e Intel stanno investendo per ritagliarsi spazio nelle GPU AI e in altri tipi di acceleratori, e colossi come Amazon Web Services sviluppano chip dedicati nei propri data center.

Di seguito, una panoramica dei principali vendor e delle loro iniziative in questo settore.

Indice degli argomenti:

Nvidia

Nvidia ha inventato la GPU programmabile moderna e rimane il leader incontrastato nelle accelerazioni AI. Le sue GPU (in particolare la famiglia Tesla/Ampere/Hopper per data center) costituiscono l’infrastruttura portante per la gran parte dei progetti di AI training e inferenza nel mondo non-Google. Nvidia ha costruito un ecosistema software robustissimo (CUDA, cuDNN, TensorRT, ecc.) che fidelizza sviluppatori e clienti, un vantaggio competitivo enorme, spesso paragonato a un “moat” difficile da valicare. Attualmente Nvidia detiene circa 80% del mercato dei chip AI considerando anche i processori custom di altri big tech. In altre parole, una quota quasi monopolistica delle accelerazioni AI gira su GPU Nvidia.

La domanda esplosiva di modelli generativi nel 2023 (come ChatGPT) ha spinto Nvidia a risultati finanziari record: nel secondo trimestre 2024 l’azienda ha riportato ricavi trimestrali di 30 miliardi di dollari (+122% anno su anno), trainati soprattutto dalle vendite di GPU per data center e AI.

Il solo segmento data center di Nvidia (che include le GPU per AI) ha fatturato 26,3 miliardi nel trimestre (+154% anno su anno), evidenziando come i chip per AI stiano letteralmente trascinando la crescita della società.

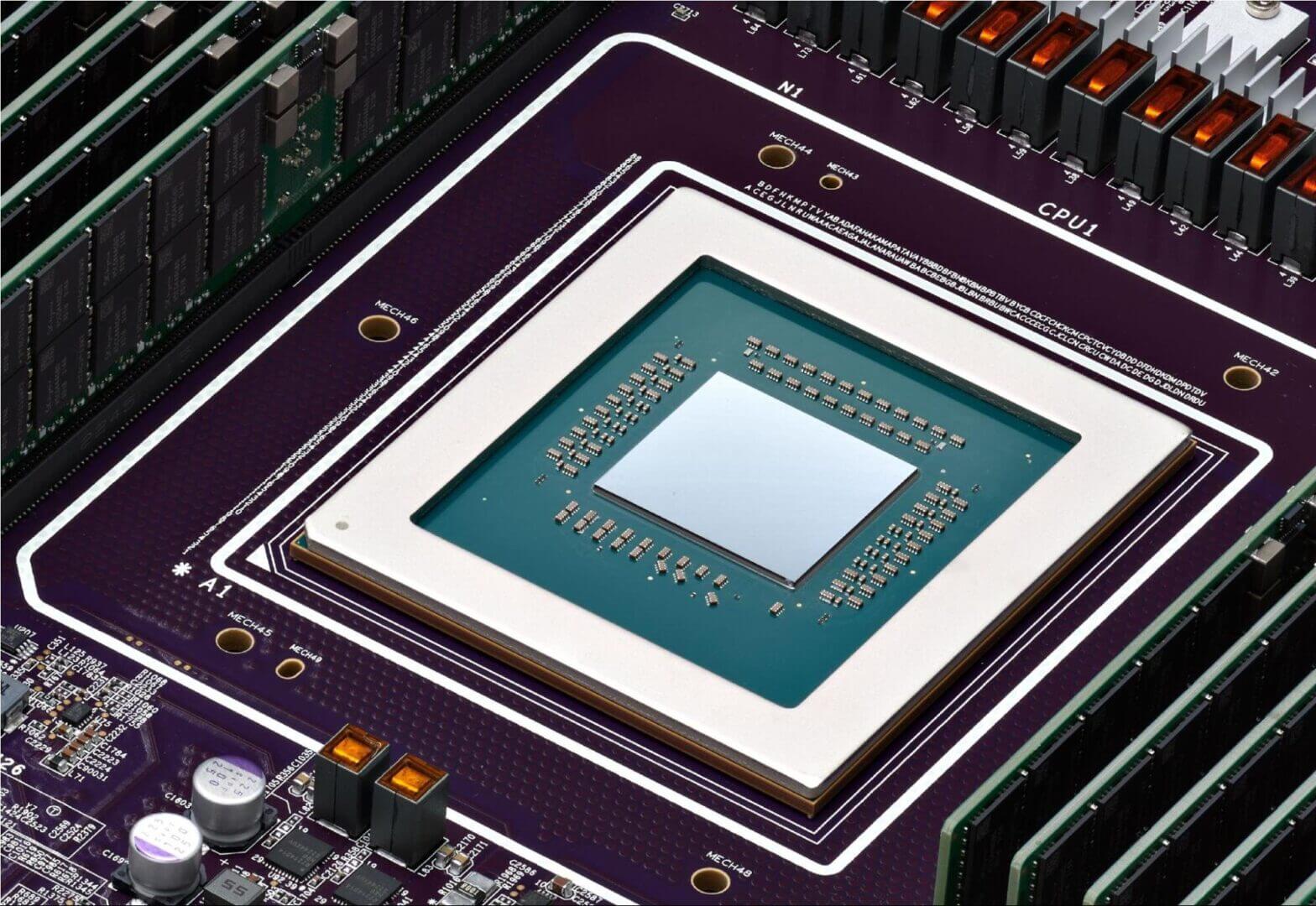

Tecnologia

Sul piano tecnologico, Nvidia rilascia una nuova architettura GPU circa ogni 2 anni. L’attuale generazione per AI è la serie H100 (architettura Hopper) lanciata nel 2022, che offre prestazioni eccezionali per training di LLM grazie a 80 GB di HBM3, tensor core di quarta generazione e supporto al formato FP8. La prossima architettura in arrivo (nome in codice Blackwell) è già attesissima dall’industria, con Jensen Huang (CEO) che ne parla come di un salto notevole in arrivo.

Nvidia sta inoltre espandendo l’offerta con soluzioni integrate come il superchip Grace Hopper, che combina CPU ARM ad alte prestazioni (Grace) con GPU Hopper su uno stesso modulo con memoria unificata, per ridurre le latenze CPU-GPU e accelerare carichi AI e HPC. Questo riflette una strategia di piattaforma completa: Nvidia non si vede più solo come produttore di GPU, ma come fornitore di un intero stack (hardware, interconnessioni NVLink/NVSwitch, librerie software, fino a piattaforme complete DGX e supercomputer). Non a caso, colossi cloud come Microsoft e Oracle hanno investito miliardi in cluster di GPU Nvidia per sostenere la domanda di AI generativa.

Mercato

Dal punto di vista di mercato, il 2023 ha consacrato Nvidia come una delle aziende di maggior valore al mondo, raggiungendo brevemente una capitalizzazione di oltre 1.000 miliardi di dollari (tra le pochissime a riuscirci) grazie all’“AI boom”. Le azioni Nvidia sono salite di oltre il 190% durante il 2023 sull’onda dell’entusiasmo per l’AI, e l’azienda ha previsto ricavi record anche per i trimestri successivi, segno di una domanda che non accenna a calare. Questo successo pone però sfide ai clienti: la disponibilità di GPU è diventata un collo di bottiglia (con tempi di attesa lunghi per procurarsi i modelli top come H100) e i costi sono elevati, problemi che stanno spronando i concorrenti a proporre alternative.

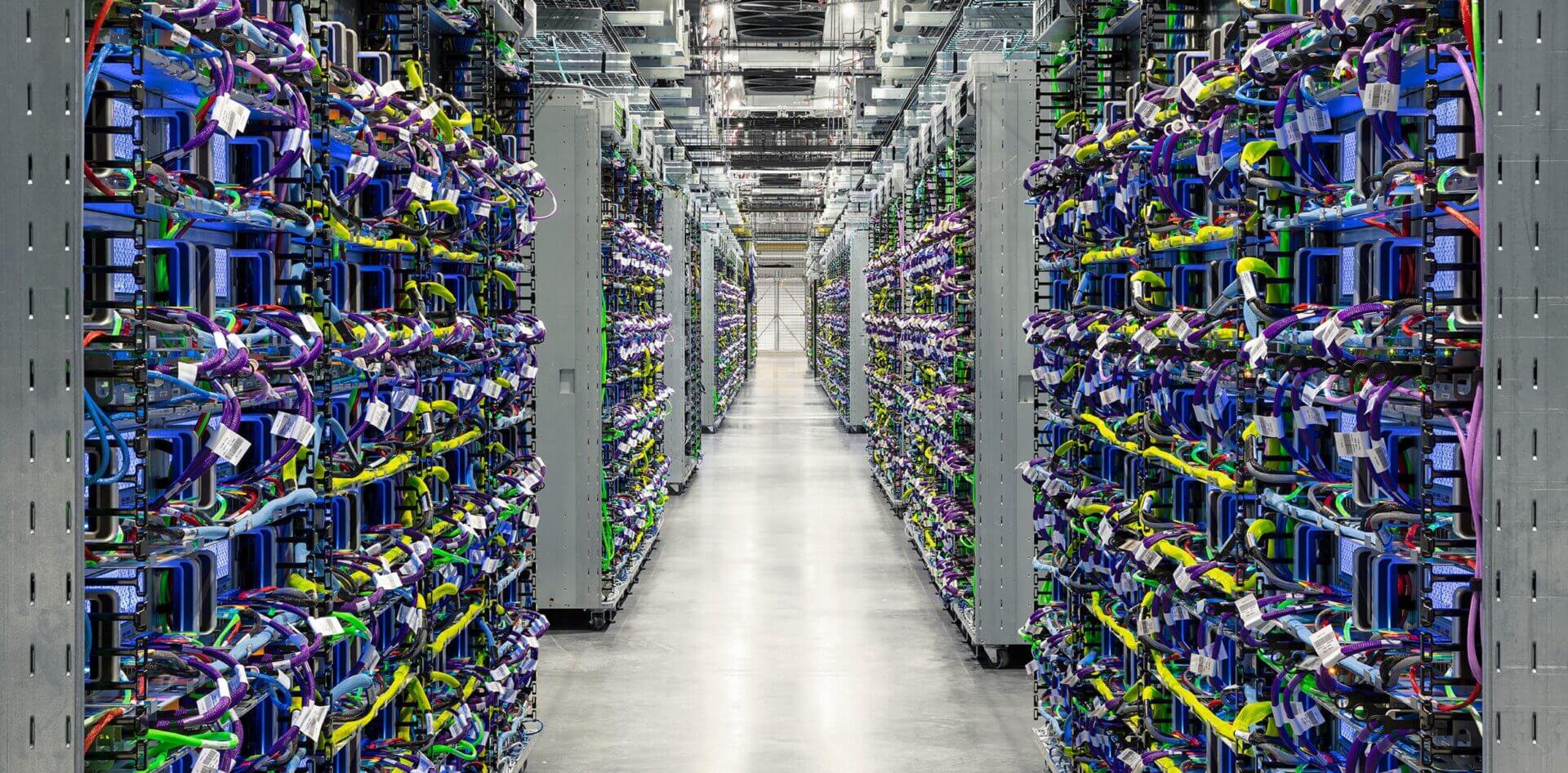

Google è il pioniere delle TPU, introdotte per uso interno al fine di accelerare i suoi algoritmi di machine learning su scala globale. Le TPU di Google hanno evoluto rapidamente: dalla v1 (2015, inferenza 8-bit), alla v2 e v3 che hanno aggiunto supporto al training (introducendo il formato bfloat16 per mantenere dinamica FP32 ma con meno bit significativi, ideale per il deep learning), fino alle più recenti generazioni v4 e v5 progettate per LLM e modelli generativi di ultima generazione.

Le TPU alimentano tutte le applicazioni AI di Google, dal motore di ricerca a Google Ads, da YouTube ai servizi di Cloud AI, e sono alla base dei suoi modelli avanzati come Gemini (la nuova suite di modelli generativi di Google). In pratica, Google ha deciso di costruirsi “in casa” il motore hardware per la propria trasformazione in un’AI-first company.

Attualmente, Google offre le TPU al mercato tramite Google Cloud. Esistono istanze Cloud TPU disponibili per i clienti (tipicamente ricercatori o aziende che vogliono addestrare modelli usando l’infrastruttura Google).

La generazione più recente annunciata è la Cloud TPU v5e, presentata nell’agosto 2023, che punta sulla convenienza e versatilità: è una TPU pensata sia per training che inferenza con il miglior rapporto costo-prestazioni di sempre tra le TPU.

Tecnologia

Google dichiara che TPU v5e offre 2 volte la performance per dollaro nel training e 2,5 volte nell’inferenza rispetto alla generazione precedente (TPU v4), il tutto a meno della metà del costo di TPU v4. Questo permette anche a clienti non “big tech” di valutare l’uso di TPU su Google Cloud per i propri modelli, grazie al supporto migliorato a framework popolari come PyTorch e alla possibilità di partire da configurazioni piccole (anche una singola chip) scalando fino a pod da 256 TPU collegati. TPU v5e enfatizza l’integrazione con gli strumenti Google Cloud (Kubernetes, Vertex AI) per semplificare l’orchestrazione di carichi AI su larga scala.

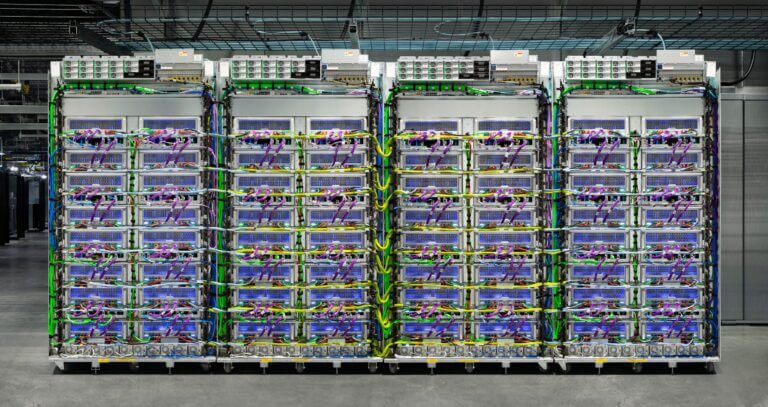

Oltre a TPU v5e, Google ha anticipato la prossima generazione chiamata TPU Ironwood (prevista in GA nel Q4 2025), nonché una TPU di sesta generazione (TPU Trillium) già disponibile in alcune regioni. Ironwood dovrebbe rappresentare la TPU più potente mai realizzata da Google, con enfasi su addestramento/inferenza su larga scala (si parla di pod da 9216 chip con 42.5 exaflop di performance FP8 complessiva). Questo indica che Google intende rimanere all’avanguardia hardware per sostenere i propri modelli AI sempre più complessi.

Un fatto significativo: a fine 2023 il laboratorio AI Anthropic (creatore del modello Claude, concorrente di ChatGPT) ha annunciato un accordo per utilizzare le infrastrutture Google TPU, si parla di oltre un milione di chip TPU che verranno messi a disposizione di Anthropic per l’addestramento dei loro futuri modelli. Ciò rappresenta più di 1 Gigawatt di capacità computazionale dedicata: un impegno colossale che testimonia la fiducia nell’ecosistema TPU e la disponibilità di Google a offrire la sua tecnologia per attirare partner strategici.

Mercato

Google con le TPU occupa una posizione unica: non compete vendendo hardware sul mercato (le TPU non si possono acquistare, solo affittare in cloud) ma ha costruito un vantaggio infrastrutturale che utilizza sia internamente sia come leva commerciale per il cloud. L’azienda comunica poco sui dettagli finanziari legati alle TPU, poiché rientrano nel segmento Google Cloud.

La strategia di Google appare quella di differenziarsi da AWS e Azure offrendo infrastruttura AI ottimizzata proprietaria (TPU, ma anche avanzate VM GPU A3 con networking migliorato), per attrarre clienti che vogliono il massimo in termini di prestazioni/costo su training di grandi modelli.

Nei risultati di Alphabet si evidenzia la crescita della spesa in capitale per data center AI; pur non essendo ancora profittevole, Google Cloud sta investendo massicciamente per tenere il passo di AWS e Microsoft nell’AI enterprise.

AMD

AMD è il secondo maggior produttore di GPU e sta cercando di chiudere il gap con Nvidia nell’ambito AI. Storicamente le GPU AMD (Radeon/Instinct) hanno avuto meno penetrazione nei data center AI, principalmente a causa di un ecosistema software meno maturo (la piattaforma open ROCm ha faticato a tenere il passo di CUDA).

Tecnologia

AMD ha compiuto passi significativi: la sua linea di GPU per calcolo Instinct MI-series è impiegata in alcuni dei supercomputer più potenti (es. Polaris e Frontier impiegano GPU MI250X).

Nel 2023 AMD ha lanciato la nuova generazione MI300 composta da diverse varianti: MI300A (un’APU ibrida con CPU EPYC + GPU in un unico package, pensata per HPC), MI300X (acceleratore puramente GPU con 192 GB di HBM3, mirato ai carichi di AI generativa) e versioni successive ottimizzate.

La MI300X in particolare è progettata per competere con NVIDIA H100 nei grandi modelli, offrendo una memoria HBM per GPU più ampia (192 GB vs 80 GB) per gestire modelli GPT-4 style senza necessità di sharding, e AMD l’ha posizionata come soluzione ideale per LLM e recommendation system grazie alla presenza di unità specializzate per matrici sparse e altro.

Mercato

Sul fronte del mercato, la CEO Lisa Su ha delineato una visione ambiziosa: AMD stima un TAM (mercato indirizzabile) di 45 miliardi di dollari nel 2023 per i processori AI da data center, e prevede che questo mercato cresca fino a ~400 miliardi di dollari entro il 2027. AMD mira ad assicurarsi una fetta di questa crescita. In occasione del lancio dei MI300 (giugno e dicembre 2023), AMD ha comunicato di avere già impegni per oltre 2 miliardi di dollari di fornitura di chip AI per il 2024, segno di un forte interesse da parte di clienti importanti.

L’azienda ha anche evidenziato partnership strategiche, come la collaborazione con Microsoft: secondo report di stampa, Microsoft avrebbe investito risorse e supporto per aiutare AMD a sviluppare alternative alle GPU NVIDIA per i propri data center Azure,un’iniziativa volta a diversificare le opzioni e contenere la dipendenza da NVIDIA. Inoltre, l’acquisizione di Xilinx nel 2020 ha dato ad AMD asset cruciali come gli FPGA e le DPU, componenti che possono integrarsi nell’offerta AI (ad esempio per inferenza a bassa latenza o soluzioni adattabili).

Nonostante questi sforzi, va detto che AMD ha ancora margine da recuperare. Gli analisti stimano che Nvidia mantenga l’80% di quota di mercato AI, con AMD lontana seconda. L’assenza di uno stack software consolidato è il principale ostacolo: molti data center e sviluppatori non sono ancora pronti a migrare da CUDA a ROCm o nuovi ecosistemi, sebbene AMD stia investendo per migliorare la compatibilità (ad esempio supportando nativamente PyTorch e TensorFlow su GPU Instinct, e proponendo tool per portare codice CUDA su piattaforma AMD).

Una nota positiva per AMD è che i suoi prodotti tendono a posizionarsi a un costo inferiore: si vocifera che MI300X sarà offerta ~20-30% meno di una H100 a parità di configurazione, e su cloud alcuni provider riportano risparmi usando GPU AMD. Se l’AI boom continua, c’è spazio per un secondo fornitore: AMD punta a quel ruolo, potendo fare leva anche sulla capacità produttiva di TSMC (che realizza sia chip NVIDIA sia AMD) e su eventuali restrizioni che colpiscano Nvidia (come i ban USA verso la Cina, dove AMD potrebbe proporre versioni leggermente depotenziate ma vendibili).

Intel

Intel si trova in una posizione particolare: leader storico delle CPU, ha però mancato la prima ondata di accelerazione AI su GPU e sta cercando di rientrare in gioco con un mix di GPU proprie e acceleratori acquisiti. La sua divisione GPU ha lanciato nel 2022 la linea Intel Data Center GPU Max (nome in codice Ponte Vecchio), una GPU HPC/AI molto complessa (oltre 100 miliardi di transistor su più tile) pensata per supercomputing e applicazioni AI. Questo prodotto, dopo ritardi significativi, è entrato in funzione nel supercomputer Aurora e in pochi altri contesti, ma non ha ancora avuto impatto commerciale paragonabile alle soluzioni Nvidia.

Intel aveva pianificato una successiva generazione chiamata Falcon Shores che avrebbe unito GPU e funzionalità AI in un design modulare, ma a inizio 2025 ha annunciato di aver cancellato i piani di rendere Falcon Shores un prodotto commerciale autonomo, preferendo focalizzarsi su sviluppi futuri più mirati. Questa mossa è indicativa delle difficoltà incontrate: Intel sta rivedendo la strategia, comprendendo che competere frontalmente con Nvidia sul terreno GPU richiede investimenti enormi e tempi lunghi.

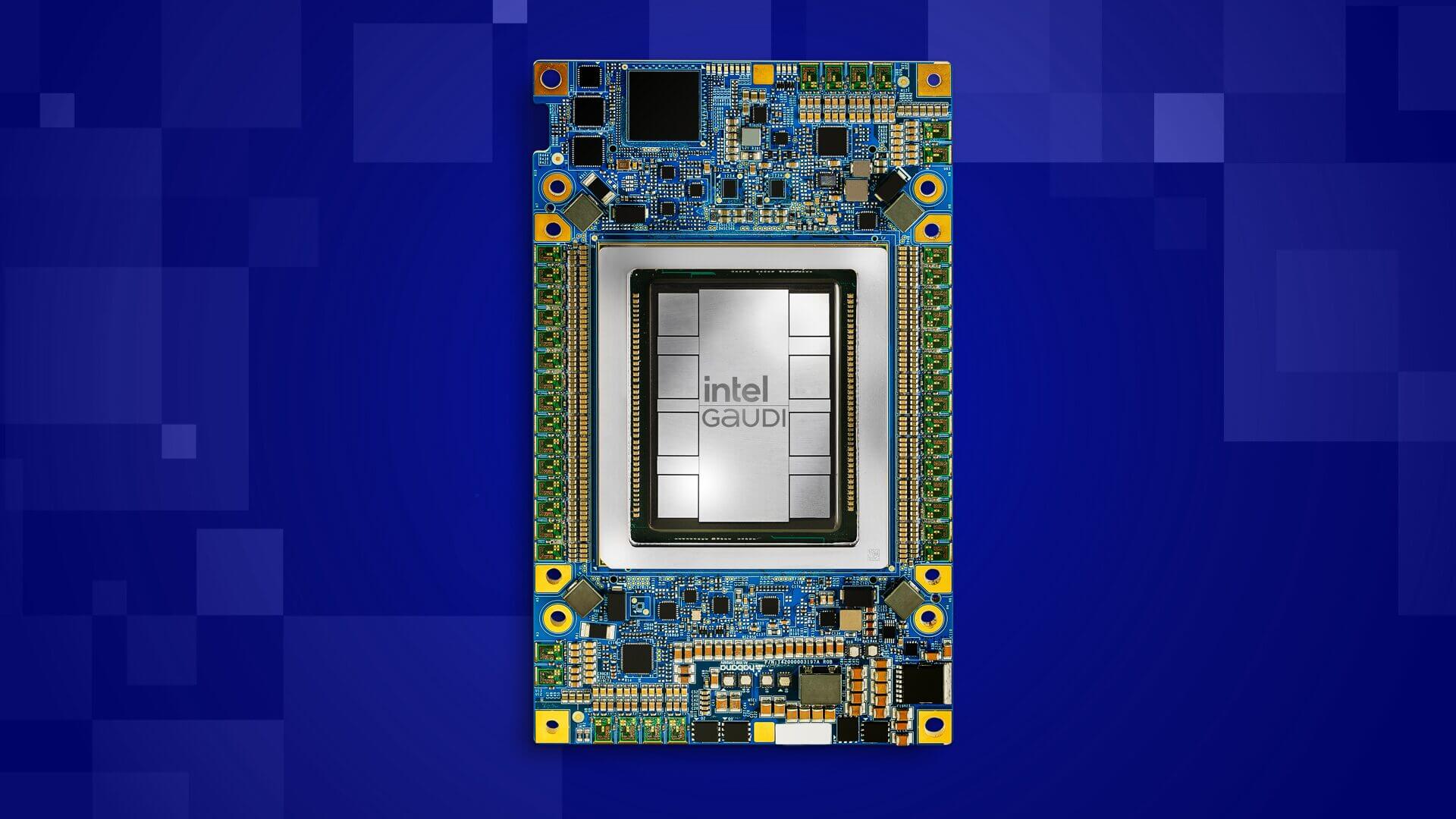

Parallelamente, Intel ha acquisito nel 2019 la startup Habana Labs, che sviluppa acceleratori AI dedicati. I prodotti Habana Gaudi (per training) e Goya (per inferenza) rappresentano un approccio diverso: non sono GPU, ma ASIC specializzati (un po’ analoghi per certi versi alle TPU, ma disponibili sul mercato).

Nel 2022 è uscita la seconda generazione Gaudi2, e Amazon AWS ha adottato questi chip offrendo istanze EC2 DL1 basate su Gaudi2. AWS e Intel sostengono che Gaudi2 su AWS può offrire fino al 40% in più di performance-per-cost rispetto alle istanze GPU tradizionali. In pratica, puntano sul fattore costo: anche se Gaudi2 è meno potente di una H100, il suo prezzo e disponibilità possono renderlo conveniente in alcuni scenari.

Ad esempio, una ricerca Databricks ha mostrato che Gaudi2 raggiunge circa metà della velocità di H100, ma costando ~10 volte meno l’ora su AWS, offre comunque un vantaggio economico in termini di throughput per dollaro. Intel sta sviluppando Gaudi3 per il futuro, e dopo la cancellazione di Falcon Shores è probabile che raddoppi gli sforzi sui design Habana come via principale per competere nell’AI data center.

Oltre a ciò, Intel sta integrando acceleratori AI anche nelle sue CPU generaliste: le nuove CPU Xeon Scalable (nome Sapphire Rapids, 2023) includono AMX/Tensor core on-chip per accelerare inferenza AI senza GPU, e future generazioni punteranno su maggiore integrazione (anche se per i massimi carichi le GPU/ASIC dedicati restano insostituibili).

Mercato

Intel mira a una strategia di soluzione completa di data center, CPU + acceleratori,sfruttando la sua presenza capillare nei server tradizionali. Al momento la quota di Intel nel mercato degli acceleratori AI è minima. Anche a livello finanziario, l’azienda ha sofferto: le divisioni nuovi prodotti hanno eroso i margini e Intel ha subito cali nei settori core (CPU PC e server) negli ultimi anni, limitando la capacità di investimento aggressivo.

Il nuovo CEO sta tentando di riaccelerare l’innovazione (con progetti open source come oneAPI, alleanze con aziende come Dell per spingere Gaudi, ecc.).

Il 2024-2025 sarà cruciale per capire se Intel riuscirà a diventare un terzo competitore nelle GPU/acceleratori AI o se continuerà a giocare un ruolo marginale rispetto a Nvidia (e AMD).

Altri attori emergenti

Oltre ai giganti consolidati, il mercato degli acceleratori AI vede la presenza di importanti iniziative da parte dei grandi cloud provider e di startup innovative.

Amazon Web Services (AWS) sviluppa internamente i chip Trainium (per il training) e Inferentia (per l’inferenza), con l’obiettivo di offrire alternative più economiche alle GPU Nvidia e ridurre la dipendenza da fornitori esterni. AWS afferma che i suoi chip offrono risparmi notevoli: ad esempio Inferentia2 fino al 50% di costo inferenza in meno e Trainium fino al 50% di costo training in meno rispetto a GPU equivalenti.

Meta (Facebook) sta investendo in chip custom (progetto MTIA – Meta Training and Inference Accelerator) per ottimizzare i costi delle proprie infrastrutture AI su scala planetaria. L’obiettivo è ridurre la dipendenza da Nvidia per risparmiare su scala, dovendo gestire applicazioni AI per miliardi di utenti.

A questi si aggiunge un vivace ecosistema di startup come Cerebras (Wafer-Scale Engine), SambaNova e Graphcore (IPU), che esplorano architetture radicalmente nuove. Finora nessuna ha scalfito la leadership GPU in ambito general purpose, ma contribuiscono a spingere l’innovazione del settore.

Il mercato vede Nvidia al comando sulle GPU, Google in posizione unica con TPU, AMD e Intel inseguire con strategie differenti, e gli hyperscaler (AWS, Meta) sviluppare chip in casa per controllo dei costi.

Il mercato attuale di GPU e TPU per l’AI

La corsa all’AI sta alimentando un mercato hardware in fortissima espansione. Secondo le stime, nel 2023 la spesa globale in chip AI per data center ha raggiunto circa 45 miliardi di dollari, quasi raddoppiando dal 2022. Le previsioni verso il futuro sono ancora più impressionanti: AMD si aspetta che il mercato dei soli acceleratori AI data center crescerà fino a circa 150 miliardi di dollari nel 2025 e 400 miliardi entro il 2027.

A trainare questa domanda sono in primis i grandi cloud provider e le big tech. Nel primo semestre 2024, quasi il 75% della spesa in server AI proveniva dagli hyperscaler (AWS, Google, Microsoft, Meta), che hanno raddoppiato i loro investimenti rispetto all’anno precedente.

NVIDIA detiene circa l’80% del market share degli acceleratori AI installati, grazie in particolare al successo della linea A100/H100. Il restante 20% comprende i chip custom interni di Google, Amazon, Microsoft, Meta, più AMD, Intel e altri.

Nel 2023 NVIDIA ha di fatto avuto il monopolio dei profitti: la sua divisione data center ha raggiunto ricavi record, mentre AMD è solo all’inizio di ricavi significativi da MI300 e Intel praticamente marginale.

Da un punto di vista geopolitico, il mercato dei chip AI è al centro di tensioni: USA e Cina sono in competizione per la supremazia in questo campo. Gli Stati Uniti hanno imposto nel 2022-23 restrizioni all’export di GPU avanzate verso la Cina, spingendo aziende come Huawei e Alibaba ad accelerare lo sviluppo di alternative domestiche.

Tirando le somme, il mercato attuale degli acceleratori AI è in fase di forte espansione, dominato da pochi grandi fornitori e clienti. Il valore è già nell’ordine delle decine di miliardi di dollari e sta crescendo a ritmo vertiginoso. Questa crescita potrebbe accelerare ulteriormente mano a mano che l’AI viene adottata in produzione in settori come la sanità, la finanza e la manifattura.