Nel giro di tre mesi dal lancio di GPT‑5, OpenAI ha introdotto GPT‑5.1, un aggiornamento che punta meno all’effetto “wow” e più alla solidità d’uso quotidiano. In ChatGPT si traduce in un assistente più colloquiale e personalizzabile; nell’API, in un modello più efficiente nel ragionamento e più adatto a flussi agentici che scrivono codice, eseguono comandi, mantengono stato e rispettano vincoli di costo e latenza.

Rispetto al quadro già delineato, qui cerchiamo di illustrarne l’uso, spiegando come funziona davvero GPT‑5.1, quali strumenti introduce, che cosa cambia per i team IT e perché questo aggiornamento ha implicazioni concrete per governance, sicurezza e adozione enterprise.

Indice degli argomenti:

Che cos’è GPT‑5.1 e perché non è “solo” un modello

GPT‑5.1 non è un singolo artefatto ma una piccola famiglia con ruoli distinti. In ChatGPT l’utente incontra due varianti, Instant e Thinking, orchestrate da un router automatico che instrada i prompt in base alla difficoltà.

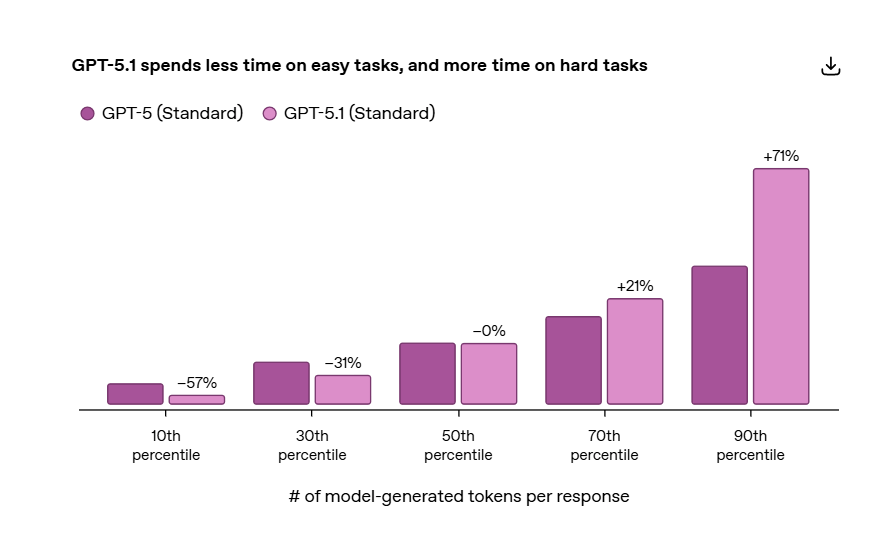

Instant privilegia la reattività e un tono più caldo, Thinking estende il “tempo di pensiero” interno quando un compito lo richiede. Questa architettura non è nuova, ma la novità è il comportamento adattivo anche sul modello più veloce: se un problema è facile, il sistema risponde quasi senza “pensare”; se è complesso, decide di prendersi qualche passaggio in più. È la differenza fra un riassunto di una mail e il refactoring di un modulo software con test falliti. Per l’utente significa coerenza: le richieste semplici restano snelle, quelle impegnative diventano più affidabili, senza dover cambiare manualmente impostazioni o modello.

Sul piano dell’API, GPT‑5.1 viene esposto come modello principale della serie, affiancato da varianti per il coding prolungato. È rilevante la possibilità di modulare lo sforzo di ragionamento con un parametro che consente anche un vero “non‑reasoning mode”. In pratica, quando l’introspezione profonda non serve, il modello riduce i token di pensiero, migliora la latenza e abbassa la spesa. Quando serve pianificare, verificare, confrontare soluzioni, allarga invece il respiro cognitivo, con una maggiore tendenza all’auto‑controllo dei passaggi.

Adaptive reasoning, router e personalità: come cambia l’esperienza ChatGPT

Con GPT‑5 erano emerse critiche sulla “voce” del modello, spesso percepita come impersonale. GPT‑5.1 interviene su due fronti.

- 1 – Il comportamento conversazionale viene reso più naturale. L’assistente abbandona un registro troppo neutro, segue meglio istruzioni di stile e formato e mantiene il tono selezionato in modo più coerente lungo sessioni prolungate.

- 2 – Arrivano preset di personalità che possono essere scelti dall’utente o dal brand: stili professionali, amichevoli, efficaci o più diretti, con l’obiettivo di allineare l’esperienza al contesto d’uso. Non si tratta di un trucco cosmetico, ma di un controllo editoriale utile per customer care, formazione, knowledge management e assistenza interna.

L’elemento tecnico che sostiene questi cambiamenti è l’adaptive reasoning. Semplificando, GPT‑5.1 stima la complessità del compito e calibra il proprio “sforzo cognitivo”. Nelle interazioni quotidiane riduce la verbosità non necessaria, nei task a più step aumenta il controllo intermedio e la tendenza a verificare output e vincoli. Questo si nota, per esempio, quando si chiede di trasformare un documento in un formato specifico, di generare codice aderente a uno stile di progetto, di pianificare uno sprint con dipendenze tra issue o di comporre un’analisi che citi ipotesi, limiti e fonti richieste.

Le novità per sviluppatori: applicazioni agentiche che editano file ed eseguono comandi

La parte più sostanziale dell’aggiornamento è nelle capacità da “agente”. GPT‑5.1 introduce due strumenti nativi.

Il primo è apply_patch, un tool di editing strutturato che consente al modello di proporre e applicare patch a file e repository in modo affidabile, con una rappresentazione diff dichiarativa e controllabile dall’applicazione host. È la risposta al limite storico dei suggerimenti di codice in linguaggio naturale, spesso ambigui o difficili da applicare. Con apply_patch, l’LLM emette operazioni esplicite di creazione, modifica e cancellazione su file o blocchi, che possono essere convalidate, testate e versionate in pipeline CI reali.

Il secondo è shell, un tool che permette al modello di proporre comandi di shell ed eseguirli in un ambiente limitato dall’implementazione. La responsabilità dell’isolamento resta al chiamante, ma l’effetto pratico è poderoso: l’agente può lanciare test, installare dipendenze in sandbox, eseguire script di migrazione o generare asset, quindi leggere l’output e iterare. Un ciclo percepito come “autonomo”, ma di fatto governato da policy applicative e guardrail.

Questi strumenti si inseriscono in una cornice più matura di tool calling parallelo, ragionamento modulabile e caching del contesto. Per la prima volta diventa realistico costruire agenti che non solo “scrivono” codice, ma mantengono un ramo di lavoro, aggiornano file, riparano test, aprono PR, commentano le difformità e iterano fino alla riuscita, con rollback controllati. Non è magia, è integrazione stretta con infrastrutture di sviluppo e DevEx attuale.

Prompt caching esteso a 24 ore e controllo del costo

Una seconda novità pratica è l’estensione della prompt cache fino a 24 ore. Le applicazioni possono mantenere in cache lunghi contesti condivisi tra più richieste, come corpora aziendali indicizzati, specifiche tecniche, briefing di progetto, checklist di sicurezza o lo stato di un ticket complesso.

I token di input riutilizzati dalla cache hanno costo significativamente ridotto e, soprattutto, riducono la latenza percepita nelle sessioni multi‑turn. È un tassello cruciale per agenti persistenti che accompagnano processi che durano giorni, dal debugging alla preparazione di una gara, dall’analisi di una policy alla generazione di asset editoriali.

Coding: qualità, stile e benchmark, ma con occhio al “come”

Nel coding, GPT‑5.1 non promette soltanto punteggi migliori, ma un comportamento più “ingegnerizzabile”. La personalità di coding è meno prolissa, più rispettosa dei vincoli dello stile del progetto e più diligente nell’applicare refactoring e test.

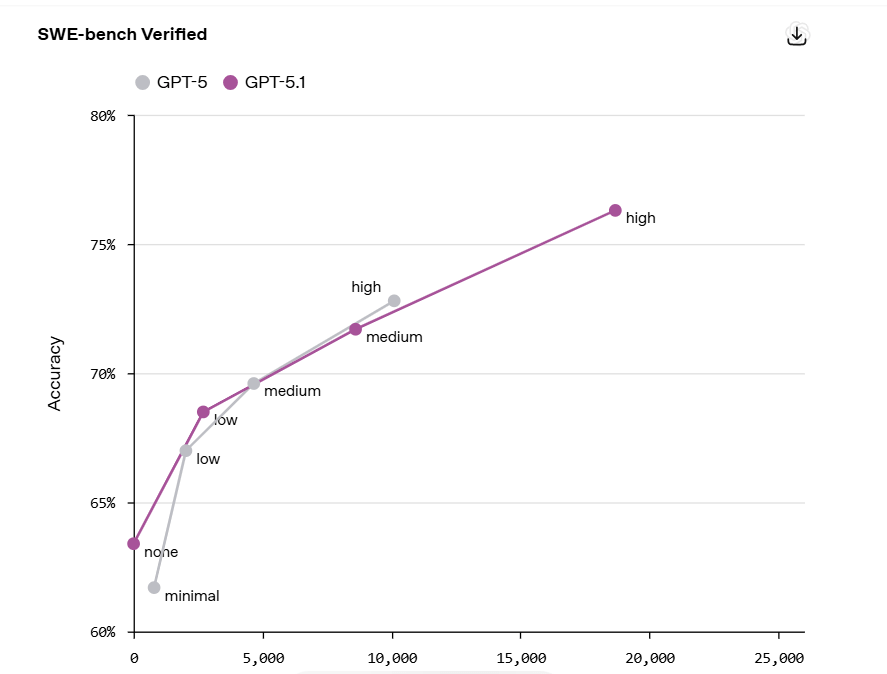

I benchmark di settore fotografano un salto ulteriore nella risoluzione automatica di issue reali, ma ciò che conta per i team è l’affidabilità del ciclo end‑to‑end. Un agente che propone una patch, esegue i test, legge l’output, corregge e ripete con parsimonia di token, offre valore anche quando il benchmark non è perfetto. La vittoria non è il singolo submit accettato, ma la velocità con cui si converge a una PR pulita e spiegata.

Per orchestrare al meglio questi comportamenti, GPT‑5.1 aggiunge leve API chiare. La regolazione del reasoning_effort, inclusa l’opzione “none”, consente di distinguere fra richieste meramente meccaniche e compiti di analisi o pianificazione.

Nei primi si preferisce parallelizzare chiamate a strumenti e operazioni I/O con basso overhead; nei secondi ha senso autorizzare più passaggi interni e maggiore auto‑verifica. Il risultato è un controllo più fine sul rapporto costi/benefici, che diventa misurabile su dashboard di progetto.

Dalla demo alla produzione: pattern di adozione enterprise

Molte organizzazioni si sono fermate a “assistenti che scrivono testo”. GPT‑5.1, grazie a caching esteso e tool nativi, incentiva pattern più robusti. Alcuni esempi concreti.

- Revisione documentale e compliance. Un agente può caricare policy e norme interne in cache per tutta la giornata, ricevere documenti in arrivo, eseguire controlli di conformità, applicare template di revisione e mantenere un registro auditabile delle decisioni. Il reasoning adattivo consente di accelerare sulle checklist standard e dedicare più passaggi alle eccezioni, con spiegazioni strutturate.

- Back‑office e operation. In un help desk IT, un agente può triagiare ticket, ispezionare log, proporre fix e, previa approvazione umana, applicare patch su file di configurazione. Con shell tool in sandbox e policy di sicurezza, si chiude il ciclo tra diagnosi e azione, mantenendo tracciabilità.

- Sviluppo guidato da obiettivi. In un flusso di continuous delivery, l’agente riceve uno “scopo” (per esempio, ridurre il tempo di avvio di un servizio), profila l’applicazione, propone cambiamenti con apply_patch, lancia benchmark, compara i risultati e itera finché non raggiunge un target definito. I team misurano l’impatto non in numero di suggerimenti, ma in tempo di ciclo e regressioni evitate.

- Customer care multicanale. Con preset di personalità e istruzioni editoriali coerenti, un assistente può scalare su canali differenti mantenendo voce e stile. Il router automatico delega a Thinking solo le conversazioni che necessitano di ragionamento profondo, contenendo latenza e costi sugli scambi più semplici.

- Sicurezza, trasparenza e rischi operativi

OpenAI accompagna GPT‑5.1 con un addendum alla system card focalizzato su comportamento conversazionale, mitigazioni e limiti. Per i responsabili della conformità questo materiale è utile per DPIA, registri dei rischi e valutazioni interne. Va chiarito però che l’adozione di tool come shell impone scelte architetturali precise: ambienti isolati, least privilege, policy di firma delle patch, gate di approvazione, logging inviolabile e piani di rollback. L’agente non è un essere umano “autonomo”, è una pipeline di automazione che richiede governance operativa.

Sul piano della sostenibilità rimane aperto il tema della trasparenza energetica. L’evoluzione del ragionamento adattivo promette efficienza, ma i modelli di frontiera mantengono costi computazionali elevati, soprattutto nei percorsi più lunghi.

Le organizzazioni che adottano GPT‑5.1 in modo esteso dovrebbero integrare metriche di consumo e intensità di calcolo nei KPI dei progetti AI, adottando caching e tuning del reasoning proprio per contenere l’impronta operativa.

Disponibilità, pricing e integrazioni

GPT‑5.1 è in distribuzione graduale in ChatGPT a partire dagli abbonamenti a pagamento e risulta disponibile nell’API nelle consuete varianti, incluse quelle ottimizzate per il coding prolungato. Il pricing resta allineato alla generazione precedente, mentre l’estensione della prompt cache, quando sfruttata con criterio, riduce il costo effettivo delle sessioni di lavoro lunghe. Sul fronte delle piattaforme, l’integrazione nei servizi cloud a marchio Microsoft e nei principali IDE conferma il posizionamento del modello come “motore” per applicazioni e agenti enterprise.

Come valutare l’aggiornamento: una guida pratica alla scelta

Per capire se e dove adottare GPT‑5.1 è utile porsi alcune domande operative.

- Il problema richiede davvero ragionamento profondo? Se la risposta è no, ha senso attivare il profilo senza ragionamento ed eventualmente delegare a strumenti esterni le parti deterministiche. Se sì, si autorizza un reasoning più esteso e si misura l’impatto su qualità e costi.

- Abbiamo asset condivisi e stabili per 24 ore? Se un contesto di progetto viene riusato per l’intera giornata lavorativa, la cache estesa diventa un acceleratore naturale. Se il contesto cambia continuamente, la cache aiuta meno.

- Le azioni dell’agente sono sempre verificabili? Apply_patch e shell sono potenti quanto i guardrail che li contengono. Prima di attivarli su sistemi critici serve definire test automatici, approvazioni umane e ambienti isolati.

- Il tono conta? Se l’assistente tocca utenti finali, il preset di personalità e la capacità di seguire uno stile editoriale costante diventano parte del design del servizio, non un dettaglio estetico.

Conclusioni: un aggiornamento di maturità che sblocca casi d’uso reali

GPT‑5.1 segna un cambio di passo pragmatico. In ChatGPT rende migliore ciò che gli utenti fanno ogni giorno, con risposte più naturali, meno prolisse quando non serve e più analitiche quando serve davvero. Nell’API mette nelle mani degli sviluppatori strumenti che trasformano gli LLM in agenti operativi inseriti nei processi, con patch applicabili, comandi eseguibili, contesti persistenti e costi più prevedibili. Non è la rivoluzione radicale che molti si aspettavano dal nome “GPT‑5”, ma è un rilascio che sposta la frontiera dell’adozione concreta.

Per PA e imprese, il messaggio è chiaro: la scelta non è inseguire ogni nuovo modello, ma costruire architetture e governance capaci di sfruttare in sicurezza questi progressi incrementali. GPT‑5.1 offre leve tecniche e narrative per farlo oggi.

Bibliografia

The Guardian, “OpenAI will not disclose GPT‑5’s energy use…”. [https://www.theguardian.com/technology/2025/aug/09/open-ai-chat-gpt5-energy-use]

OpenAI, “GPT‑5.1: A smarter, more conversational ChatGPT”. [https://openai.com/index/gpt-5-1/]

OpenAI, “Introducing GPT‑5.1 for developers”. [https://openai.com/index/gpt-5-1-for-developers/]

OpenAI, “Model: GPT‑5.1”. [https://platform.openai.com/docs/models/gpt-5.1]

OpenAI Help Center, “GPT‑5.1 in ChatGPT”. [https://help.openai.com/en/articles/11909943-gpt-5-in-chatgpt]

OpenAI, “GPT‑5.1 Instant and GPT‑5.1 Thinking – System Card Addendum”. [https://cdn.openai.com/pdf/4173ec8d-1229-47db-96de-06d87147e07e/5_1_system_card.pdf]

OpenAI Cookbook, “GPT‑5.1 Prompting Guide”. [https://cookbook.openai.com/examples/gpt-5/gpt-5-1_prompting_guide]

OpenAI API Docs, “Prompt caching”. [https://platform.openai.com/docs/guides/prompt-caching]

Agenda Digitale, “Ecco GPT‑5.1, un update utile: che c’è da sapere”. [https://www.agendadigitale.eu/industry-4-0/ecco-gpt-5-1-quanto-e-utile-la-novita/]

Ars Technica, “OpenAI walks a tricky tightrope with GPT‑5.1’s new personalities”. [https://arstechnica.com/ai/2025/11/openai-walks-a-tricky-tightrope-with-gpt-5-1s-eight-new-personalities/]

Business Insider, “I tried ChatGPT‑5.1’s personality presets…”. [https://www.businessinsider.com/how-chatgpt51-new-personalities-answered-the-same-prompts-2025-11]

Microsoft Tech Community, “GPT‑5.1 in Foundry: A workhorse for reasoning, coding, and chat”. [https://techcommunity.microsoft.com/blog/partnernews/gpt%E2%80%915-1-in-foundry-a-workhorse-for-reasoning-coding-and-chat/4469803]