L’adozione dell’intelligenza artificiale è in continua espansione, ma le aziende che non possiedono l’infrastruttura giusta — che spazia dai chip al raffreddamento — potrebbero trovarsi a competere in una corsa persa in partenza. L’infrastruttura necessaria per supportare i modelli AI include capacità di calcolo e di archiviazione nei data center, potenza di elaborazione dei chip e considerazioni sull’energia necessaria per far funzionare e raffreddare i sistemi. Man mano che cresce la domanda di soluzioni AI, cresce anche la competizione per le risorse infrastrutturali.

Le decisioni in merito all’adozione di AI non sono affatto semplici. Implementare una strategia AI in azienda richiede la valutazione di molti fattori, tra cui la compatibilità dell’hardware, la scalabilità e la sicurezza.

Indice degli argomenti:

Adozione dell’AI: l’importanza di un coinvolgimento trasversale nelle decisioni tecnologiche

Molti dirigenti aziendali, abituati a essere informati su quale tecnologia adottare senza dover entrare nel dettaglio tecnico, si troveranno a dover apprendere nuovi concetti. Questo perché l’adozione dell’AI richiede una comprensione approfondita del problema che si intende risolvere. Quasi tre quarti dei progetti AI non restituiscono ritorni sugli investimenti a causa della mancanza di un coinvolgimento strategico nella scelta dell’infrastruttura.

Il cambiamento riguarda anche i reparti: mentre la strategia complessiva è spesso formulata centralmente, la scelta delle applicazioni AI dovrebbe essere decisa in modo decentralizzato, poiché ogni dipartimento ha necessità e priorità diverse. Ad esempio, il dipartimento legale potrebbe concentrarsi sulla sicurezza e la conformità, mentre il marketing avrà altre priorità.

L’infrastruttura fondamentale per l’AI: “AI compute”

Il termine “AI compute” si riferisce a tutte le risorse computazionali necessarie affinché un sistema AI svolga le proprie funzioni. La potenza di calcolo necessaria dipende dalla complessità del sistema e dalla quantità di dati gestiti.

Secondo Matt Dietz, leader dell’AI e della sicurezza di Cisco, prima di implementare l’AI, le aziende devono identificare chiaramente il problema che vogliono risolvere. “Non bisogna implementare l’AI solo perché è disponibile”, afferma Dietz, sottolineando che l’adozione di AI deve essere mirata a migliorare efficienza o a risolvere problematiche operative specifiche, come il miglioramento delle interazioni con i clienti o l’assicurarsi che i dipendenti possano usufruire di strumenti di AI per semplificare il loro lavoro.

Il dilemma dei server e le opzioni per l’infrastruttura

Per quanto riguarda i data center, le aziende hanno due opzioni principali: possedere l’infrastruttura internamente o affittarla. Ogni soluzione presenta vantaggi e svantaggi legati alla scalabilità, alla sicurezza e ai costi. I data center on-premises sono più sicuri, ma costosi sia nella costruzione che nella gestione, e non tutti sono ottimizzati per l’AI. Le soluzioni modulari, come quelle utilizzate dai cloud hyperscalers come Microsoft, Google e Amazon, sono sempre più ricercate per la loro scalabilità e rapidità di distribuzione.

Secondo le previsioni, il mercato dei data center modulari dovrebbe crescere notevolmente nei prossimi anni, con una crescita stimata da 30 miliardi di dollari nel 2024 a 81 miliardi di dollari entro il 2031. Questo è un chiaro indicatore del fatto che la domanda di capacità computazionale per l’AI è in continua espansione, e i data center modulari sono una delle soluzioni più adatte per soddisfare questa crescente domanda.

Cloud o soluzioni ibride: cosa scegliere?

Un’opzione interessante per le aziende che non possono permettersi un’infrastruttura proprietaria è quella di utilizzare servizi cloud, che offrono flessibilità e scalabilità. I grandi operatori del cloud, come Amazon Web Services (AWS), Microsoft Azure e Google Cloud, dominano il mercato, ma esistono anche provider di nicchia specializzati in soluzioni AI, come CoreWeave e Lambda.

Un’altra opzione è la soluzione ibrida, che combina infrastruttura proprietaria con servizi cloud. Questa scelta permette di ottimizzare le performance e la sicurezza, e di gestire la crescente richiesta di capacità computazionale senza compromettere la qualità.

Adozione dell’AI: l’importanza della sostenibilità e delle risorse energetiche

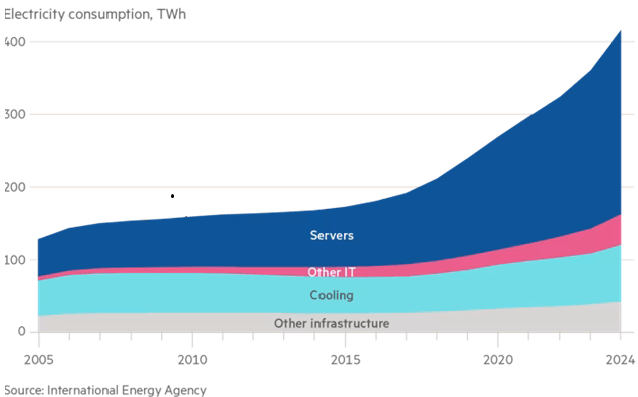

La sostenibilità è un altro fattore cruciale nell’infrastruttura AI. I data center AI richiedono quantità enormi di energia non solo per eseguire i calcoli ma anche per il raffreddamento delle apparecchiature. Le soluzioni innovative come il raffreddamento liquido stanno cercando di affrontare queste sfide, sebbene i data center continuino a concorrere per l’accesso a risorse energetiche.

La questione della sostenibilità è ancora più rilevante visto che il consumo energetico dei data center AI è dieci volte maggiore rispetto a un rack tecnologico standard. In risposta, alcune aziende stanno investendo in soluzioni come i “power skids” per aumentare la capacità elettrica disponibile nelle loro strutture.

L’evoluzione dei chip: dalla CPU alla TPU

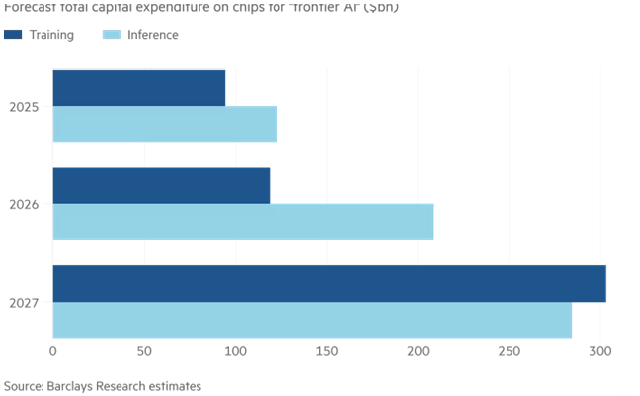

Per garantire il massimo delle performance, le aziende devono considerare quale tipo di chip utilizzare. I GPU (Graphics Processing Unit) sono molto utilizzati per il training dei modelli AI, ma esistono anche altre soluzioni come le TPU (Tensor Processing Unit) sviluppate da Google. Questi chip sono ottimizzati per l’esecuzione di calcoli paralleli, necessari per l’AI di deep learning. I progressi nell’efficienza e nella velocità dei chip sono costanti, con un numero crescente di produttori che investono in soluzioni specifiche per l’AI, come Nvidia, Intel, e AWS.

Adozione dell’AI: resilienza e latenza

Con la crescente dipendenza dall’AI, la resilienza diventa un fattore cruciale. Tecniche come il computing edge stanno guadagnando popolarità perché consentono di elaborare i dati vicino alla fonte, riducendo la latenza e migliorando la velocità di risposta in tempo reale. Questo approccio è particolarmente utile per applicazioni critiche come i veicoli autonomi e l‘automazione industriale.

L’edge computing, tuttavia, non può sostituire completamente l’AI basata su cloud, che rimane la scelta preferita per carichi di lavoro ad alta intensità computazionale, come il training dei modelli AI o l’analisi di grandi quantità di dati. L’approccio ibrido risulta essere la soluzione ideale per molte aziende.

Conclusioni: l’infrastruttura giusta per l’AI

L’infrastruttura giusta è fondamentale per l’adozione e il successo dell’AI in azienda. Scegliere il giusto mix di hardware, cloud, e soluzioni ibride, insieme a considerazioni sulla sicurezza e la sostenibilità, permetterà alle aziende di rimanere competitive. Tuttavia, l’approccio migliore dipende dalla specificità delle esigenze aziendali, dall’industria e dal problema che si cerca di risolvere.