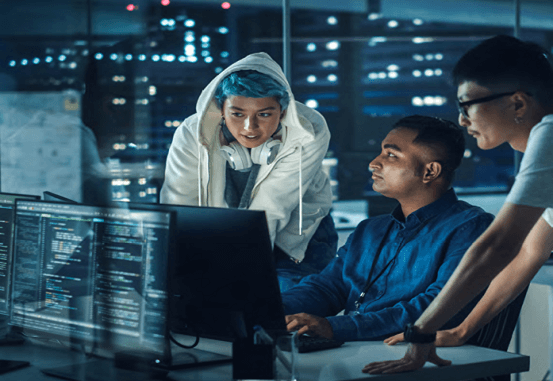

ChatGPT, intelligenza artificiale creata nel novembre 2022 dalla startup Open AI, ha guadagnato da quel momento sempre più notorietà diventando un vero e proprio fenomeno virale. Le potenzialità di questo strumento sono in grado di migliorare il lavoro di molti, ma allo stesso tempo hanno destato la preoccupazione di diversi ricercatori, allarmati per un suo utilizzo con intenti malevoli, come la diffusione di disinformazione in rete e la programmazione di malware.

ChatGPT può creare notizie false e malware

Nonostante l’affermazione dei creatori, secondo cui il software sarebbe in grado di “rifiutare richieste inappropriate”, una ricerca condotta dalla società NewsGuard, che si occupa di monitorare la diffusione di disinformazione in rete, ha riportato come ChatGPT, se interpellato con determinate modalità, sarebbe in grado di elaborare in maniera sofisticata notizie false su argomenti sensibili, come i vaccini. Generalmente, affermano i ricercatori, le fake news sono riconoscibili da errori grammaticali e sintassi scadente, ma gli articoli prodotti da ChatGPT risulterebbero ineccepibili da questo punto di vista. Ciò contribuirebbe ad aumentarne la credibilità, rendendoli molto più difficili da identificare. Lo strumento permetterebbe ai malintenzionati e a sostenitori di teorie del complotto di produrre disinformazione in modo più facile, veloce ed economico, e di diffonderla su larga scala.

Il New York Times, che ha riportato la notizia, riferisce come, nel 2020, i ricercatori del Center on Terrorism, Extremism and Counterterrorism presso il Middlebury Institute of International Studies avevano scoperto che GPT-3, la tecnologia antesignana di Chat GPT, aveva una conoscenza approfondita delle comunità estremiste e poteva essere indotta a produrre testi di propaganda.

Il sito web Check Point Research, che fornisce informazioni sulle minacce informatiche, ha invece scoperto come diversi hacker abbiano provato a utilizzare Chat GPT per creare malware. Da queste ricerche è stato rilevato che anche individui con una conoscenza base dei linguaggi di programmazione, grazie alla chatbot sarebbero in grado di produrre dei codici malevoli o generare finte e-mail che possono essere utilizzate per perpetrare attacchi di phishing.

Come l’AI può essere utilizzata per la propaganda

Già da tempo, i dispositivi basati sull’intelligenza artificiale sarebbero usati per diffondere in rete notizie false e portare avanti campagne di propaganda. Un attore che ne farebbe largo uso sarebbe la Federazione Russa.

Secondo il report Killing the Truth, pubblicato nel dicembre 2017 dall’organizzazione di opposizione siriana The Syrian Campaign, sarebbe emerso che bot e troll legati alla Russia avrebbero raggiunto circa 56 milioni di persone con tweet che attaccavano l’organizzazione di ricerca e salvataggio Difesa Civile Siriana, nota anche come Caschi Bianchi, tra 2016 il 2017. Molti dei contenuti sarebbero stati legati agli sforzi per promuovere una narrativa diversa sull’attacco chimico al sarin dell’aprile 2017 a Khan Sheikhoun, che gli investigatori delle Nazioni Unite hanno attribuito al Governo di Damasco.

Il 28 settembre 2017, una ricerca avrebbe trovato 21 account che avrebbero twittato la stessa affermazione secondo cui l’evento fosse una false-flag che coinvolgeva i Caschi Bianchi.

I profili avrebbero condiviso, tutti nel medesimo momento, lo stesso video diffuso dai media statali russi “In The Now”, seguito dalla stessa didascalia. Questi account risultavano geolocalizzati in luoghi diversi e riportavano biografie in cui dichiaravano di essere neutrali, a favore dei diritti umani, anti-wahabiti o antisionisti. Il tema ricorrente sarebbe stato il sostegno a Donald Trump.

Durante i primi mesi della pandemia di COVID-19, alcuni bot russi avrebbero diffuso notizie false sull’origine del virus. Secondo Stephanie Carvin, Professoressa della Carleton University ed ex analista di sicurezza nazionale per il Canadian Security Intelligence Service, i profili fasulli avrebbero diffuso teorie secondo le quali il Coronavirus sarebbe stato un’arma biologica creata in laboratorio, la pandemia sarebbe stata usata per coprire gli effetti nocivi delle torri 5G o che queste infrastrutture avrebbero diffuso la malattia.

Queste tesi sarebbero apparse per la prima volta all’inizio di gennaio e riproposte da bot cinesi e iraniani a metà marzo. Il pubblico più ricettivo a queste notizie sarebbe stato quello degli attivisti no-vax, dei teorici della cospirazione e dei tecnofobi.

AI e disinformazione, nel mirino anche la guerra

Nell’aprile 2022, l’European Digital Media Observatory (EDMO) ha divulgato una ricerca condotta su account che tra il 15 marzo e il 15 aprile hanno re-twittato i post delle ambasciate russe in Europa a favore della guerra in Ucraina.

L’analisi ha utilizzato Botometer, un software sviluppato dall’Indiana University di Bloomington che calcola la probabilità che un account sia un bot dando un punteggio su una scala da 0 a 1.

Lo studio ha rilevato che quasi un terzo di questi account fossero falsi. Questi profili hanno diffuso narrazioni sulla presunta denazificazione dell’Ucraina o sulla supposta presenza di laboratori statunitensi di armi biologiche nel Paese.

Infine, nell’agosto 2022, il New York Times ha segnalato che un utente di Gab chiamato Nora Berka sarebbe ricomparso dopo un anno di silenzio, condividendo messaggi con temi politici conservatori.

I post avrebbero denigrato soprattutto il presidente Joe Biden e altri esponenti democratici, e avrebbero lamentato l’uso dei dollari dei contribuenti per sostenere Kiev.

L’account sarebbe stato precedentemente collegato all’Internet Research Agency di San Pietroburgo, agenzia che avrebbe interferito nelle elezioni presidenziali statunitensi del 2016 e del 2020.

Le fake news dalla Cina

Un altro Paese che impiegherebbe falsi profili social per diffondere informazioni fasulle sarebbe la Cina.

In occasione delle proteste a Hong Kong del 2019, Pechino avrebbe messo in atto una campagna di disinformazione su Twitter e Facebook, alimentata da un numero imprecisato di bot, troll e sock puppet, ossia profili creati da membri già presenti in una comunità. La strategia avrebbe cercato di dipingere le manifestazioni come opera di agenti stranieri che cercavano di interferire negli affari della Cina e di influenzare la popolazione. Inoltre, i manifestanti pacifici sarebbero stati additati come terroristi e paragonati ai militanti dello Stato Islamico.

Nell’agosto 2019, Twitter ha annunciato di aver chiuso quasi mille pagine presumibilmente gestite dal Governo cinese.

Nel giugno del 2022, dopo i risultati delle trivellazioni condotte dell’azienda canadese di terre rare Appia nel Saskatchewan, diversi account Twitter avrebbero pubblicato commenti negativi nel tentativo di suscitare reazioni nell’opinione pubblica. Secondo Mandiant, i profili sarebbero riconducibili all’operazione di propaganda filo-cinese Dragonbridge.

A fine novembre 2022, quando sono iniziate in Cina le manifestazioni contro le restrizioni anti-COVID, il giornalista sino-statunitense Mengyu Dong ha comunicato tramite Twitter che bot legati a Pechino avrebbero diffuso annunci di escort per rendere più difficile agli utenti l’accesso alle informazioni sulle proteste di massa.

In base a quanto riportato da Firstpost, queste pagine sarebbero state create anni prima e sarebbero rimaste inattive, per poi pubblicare migliaia di post al giorno da quando le proteste si sono diffuse.

Le immagini e i video erotici allegati sarebbero stati accompagnati dai nomi delle città per garantire che le ricerche sulle manifestazioni fossero sviate con maggiore efficacia.

Conclusioni

Infine, oltre alla disinformazione, l’AI può presentare dei rischi anche in ambiti come quello giurisprudenziale e dei diritti umani. Ad esempio, una sfida importante è determinare chi sia responsabile per i danni causati da un dispositivo o servizio azionato dall’intelligenza artificiale, come nel caso di un incidente in cui è coinvolta un’auto a guida autonoma. Inoltre, l’AI può anche minacciare la protezione dei dati e il diritto alla vita privata, come nel caso di un suo utilizzo in dispositivi per il riconoscimento facciale o per la profilazione online. Inoltre, è capace di mettere insieme le informazioni che acquisisce su una persona senza che questa ne sia a conoscenza.

L’Unione europea ha diffuso un documento che mette in guardia dai rischi della disinformazione.