Cos’è un parametro? Non è un dettaglio tecnico per addetti ai lavori, ma la chiave per capire come funzionano i grandi modelli linguistici (LLM), come quelli dietro ChatGPT o Gemini. I parametri sono i numeri misteriosi che determinano il comportamento di un’AI: miliardi, anzi trilioni di valori che regolano come il modello legge, interpreta e genera il linguaggio.

Indice degli argomenti:

Dalle equazioni ai modelli planetari

In matematica, un parametro è una variabile che influenza un risultato: come la a e la b in un’equazione. Nei modelli di linguaggio il principio è lo stesso, ma su scala astronomica. GPT-3, ad esempio, aveva 175 miliardi di parametri. I modelli più recenti superano abbondantemente i mille miliardi. Sono come le leve e le manopole di un gigantesco flipper matematico: basta regolarle e il comportamento del sistema cambia.

Come nascono i parametri: addestramento e calcolo estremo

All’inizio dell’addestramento, ogni parametro viene impostato in modo casuale. Poi entra in gioco l’algoritmo: il modello fa previsioni, sbaglia, misura l’errore e corregge leggermente ogni parametro. Questo processo si ripete milioni di volte, fino a ridurre gli errori. Il risultato? Quadrilioni di calcoli e mesi di lavoro per migliaia di computer specializzati, con un enorme consumo energetico.

Tre tipi di parametri: embedding, pesi e bias

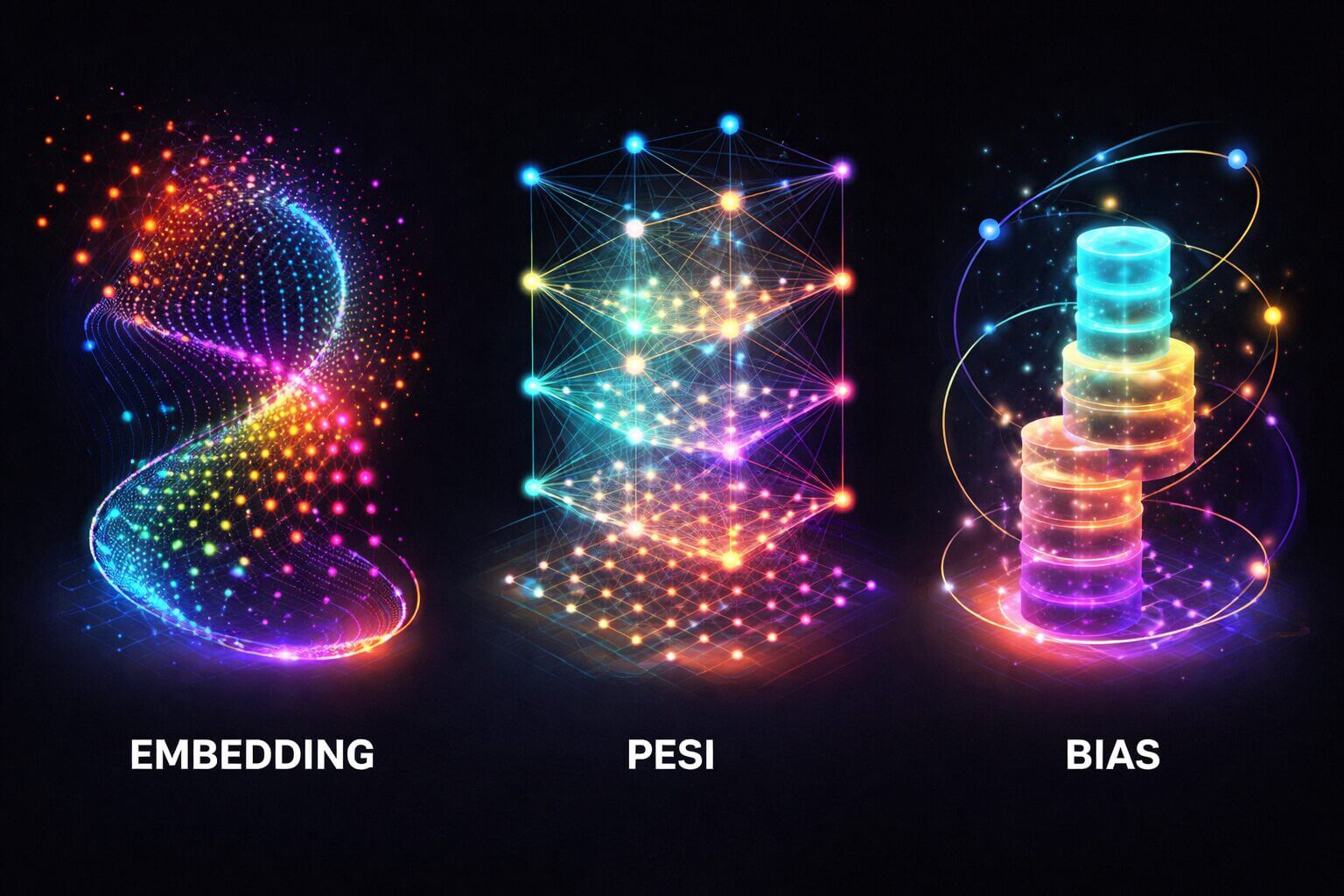

I parametri non sono tutti uguali. Nei LLM se ne distinguono tre tipi principali:

- Embedding: rappresentano matematicamente il significato delle parole.

- Pesi (weights): determinano quanto conta una parola rispetto alle altre in un contesto.

- Bias: regolano le soglie di attivazione, permettendo al modello di cogliere segnali più deboli.

Insieme, permettono all’AI di estrarre il massimo significato possibile dal testo.

Embedding: quando le parole diventano numeri

Ogni parola (o parte di parola) viene trasformata in una lunga lista di numeri, spesso 4.096. Ogni numero cattura una sfumatura di significato. Parole simili finiscono “vicine” in uno spazio matematico a migliaia di dimensioni. È così che “tavolo” è più vicino a “sedia” che ad “astronauta”. Un’astrazione potentissima, ma quasi impossibile da visualizzare.

Pesi, bias e neuroni: l’architettura nascosta

I neuroni non sono parametri, ma contenitori che ospitano pesi e bias. Sono organizzati in decine o centinaia di strati, tutti interconnessi. Ogni neurone può gestire migliaia di operazioni contemporaneamente. Il risultato è una rete matematica immensa che trasforma un input testuale in una probabilità per ogni possibile parola successiva.

Come l’AI decide cosa dire dopo

Quando un LLM genera testo, calcola la probabilità di ogni parola del suo vocabolario e seleziona quella più adatta. Ma non sempre sceglie la più probabile. Qui entrano in gioco gli iperparametri come temperature, top-k e top-p: controlli che regolano creatività, varietà e prevedibilità delle risposte.

Piccoli modelli, grandi risultati

Negli ultimi anni è emerso un dato sorprendente: più parametri non significa sempre prestazioni migliori. Modelli più piccoli, addestrati con più dati o tramite tecniche come la distillazione, possono superare modelli enormi. È il caso dei Llama di Meta. Sempre più spesso, i grandi modelli sono in realtà insiemi di modelli più piccoli che collaborano, attivati solo quando serve.

Non è (più) solo una questione di dimensioni

La corsa ai parametri infiniti sta rallentando. Oggi la sfida non è accumularne sempre di più, ma usarli meglio. Perché, alla fine, nell’intelligenza artificiale come altrove, non conta solo quanti numeri hai a disposizione, ma cosa riesci a farci.