L’evoluzione degli strumenti di sviluppo basati su intelligenza artificiale sta attraversando una fase di forte discontinuità. Con GPT‑5.1‑Codex‑Max, OpenAI introduce un modello pensato esplicitamente per agenti di coding che non si limitano a suggerire frammenti di codice, ma sono in grado di portare avanti lavori di lunga durata, gestire refactoring complessi e interagire con l’intero ciclo di vita del software. È un passo ulteriore rispetto ai classici assistenti “copilot” e avvicina l’idea di un vero collega virtuale all’interno dei team di ingegneria.

Indice degli argomenti:

Dal modello generalista al modello per agenti

GPT‑5.1‑Codex‑Max nasce come estensione specializzata della famiglia GPT‑5.1, il modello di ragionamento generale che OpenAI ha presentato come successore di GPT‑5, con un forte focus sull’efficienza nel consumo di token e sull’adattività del tempo di ragionamento. GPT‑5.1 modula in modo dinamico il numero di token dedicati al “pensiero” in funzione della complessità del compito, riducendo la latenza sui task semplici e mantenendo prestazioni competitive su quelli più difficili.

Su questa base viene costruito GPT‑5.1‑Codex‑Max, che eredita il motore di ragionamento ma viene addestrato su compiti agentici di ingegneria del software, matematica applicata, ricerca e debugging. L’obiettivo non è solo generare codice corretto, ma orchestrare sequenze di azioni su orizzonti temporali lunghi, come un agente che modifica file, lancia test, interpreta log, aggiorna dipendenze e interagisce con strumenti esterni.

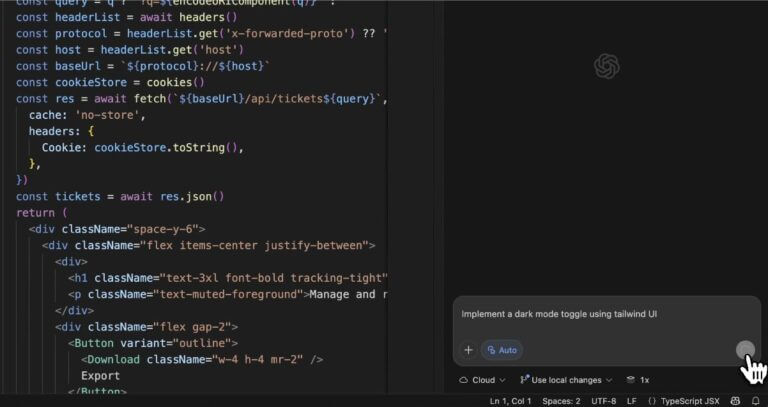

A differenza dei modelli generalisti, il nuovo Codex è pensato per vivere dentro l’ecosistema Codex di OpenAI, che comprende CLI, estensioni per IDE, ambienti cloud isolati e integrazione con l’API. Nelle superfici Codex diventa il modello di default per i compiti di sviluppo software a lungo raggio, mentre viene sconsigliato il suo utilizzo in contesti di chat generica.

Compaction e contesti multipli

La vera novità architetturale di GPT‑5.1‑Codex‑Max è il supporto nativo a quello che OpenAI chiama compaction, un processo che permette al modello di lavorare in modo coerente attraverso più finestre di contesto. In pratica il sistema è in grado di “riassettare” la cronologia della sessione, comprimendo gli elementi meno rilevanti e preservando quelli cruciali per il task corrente.

In condizioni d’uso reali, questo significa poter gestire milioni di token in un’unica attività, andando ben oltre il limite della singola finestra di contesto. Per i team di sviluppo questo si traduce in scenari che fino a poco tempo fa richiedevano un mix di strumenti e molta supervisione umana. Refactoring di interi repository, sessioni di debugging prolungate, migrazioni architetturali o multi‑step agent loop possono essere gestiti da un unico agente che lavora per ore sulla stessa base di codice.

OpenAI dichiara di avere osservato internamente agenti Codex‑Max all’opera per oltre 24 ore consecutive, durante le quali il modello itera sul codice, esegue i test, corregge gli errori e porta a termine il compito assegnato. Non si tratta più quindi di una generazione “one‑shot” di una funzione o di un file, ma di una collaborazione continua su un intero progetto.

Efficienza di token e qualità del codice

Un aspetto meno appariscente ma fondamentale riguarda l’efficienza nell’uso dei token di ragionamento. Sulle benchmark di riferimento per il bug fixing automatico, come SWE‑bench Verified, GPT‑5.1‑Codex‑Max con livello di ragionamento medio ottiene risultati migliori del precedente GPT‑5.1‑Codex pur utilizzando sensibilmente meno token dedicati al pensiero. Questo si traduce in una riduzione del costo operativo a parità di qualità e in una maggiore sostenibilità di sessioni lunghe.

La stessa filosofia si ritrova nell’utilizzo creativo del modello per la generazione di front‑end. OpenAI mostra esempi in cui GPT‑5.1‑Codex‑Max produce applicazioni web complete, come sandbox interattive o dashboard di simulazione, con un’estetica e una funzionalità paragonabili al modello precedente ma con un consumo di token decisamente ridotto. Per chi utilizza Codex in modo intensivo, la combinazione di più qualità e meno token è probabilmente la leva più concreta per giustificare la migrazione.

Va anche sottolineato che GPT‑5.1‑Codex‑Max è il primo modello della famiglia addestrato a operare nativamente in ambienti Windows oltre che su macOS e Linux. Questo aspetto è rilevante in molti contesti enterprise, in cui le workstation degli sviluppatori sono eterogenee e l’adozione di tool basati su agenti richiede compatibilità multipiattaforma.

Dalle pull request agli agent loop

Nell’annuncio di OpenAI, il modello viene descritto come addestrato su compiti concreti di ingegneria del software: creazione di pull request, revisione del codice, sviluppo di front‑end, Q&A tecnico e supporto all’uso della CLI Codex. Questo tipo di addestramento “sul campo” mira a ridurre il gap tra performance sui benchmark e utilità percepita nelle attività quotidiane di un team.

In pratica, un agente basato su GPT‑5.1‑Codex‑Max può prendere in carico un ambito di lavoro che somiglia molto a quello di uno sviluppatore umano. Può, ad esempio, partire da una issue in un repository, analizzare il codice esistente, proporre una modifica strutturata, aprire una pull request, rispondere ai commenti dei revisori e iterare finché la pipeline di test non risulta verde.

Nei contesti più avanzati può orchestrare job in cloud, aggiornare configurazioni di CI e mantenere viva una sessione di lavoro per giorni.

Per OpenAI questo tipo di utilizzo non è più sperimentale. L’azienda dichiara che la grande maggioranza dei propri ingegneri utilizza Codex ogni settimana e che il numero di pull request per sviluppatore è aumentato in modo significativo dopo l’adozione sistematica degli agenti. Al di là del singolo numero, il messaggio è chiaro: i team che adottano seriamente questi strumenti vedono un aumento strutturale della velocità di sviluppo.

i modelli di OpenAI.

Disponibilità e integrazione nell’ecosistema Codex

GPT‑5.1‑Codex‑Max è già disponibile nelle superfici Codex per chi utilizza ChatGPT con piani Plus, Pro, Business, Edu ed Enterprise. Gli sviluppatori possono sfruttarlo tramite la CLI, l’estensione per IDE, Codex Cloud e le funzionalità di code review. L’accesso diretto via API è previsto a breve, e nel frattempo il modello sostituisce GPT‑5.1‑Codex come default nelle interfacce Codex.

All’interno dell’ecosistema più ampio di GPT‑5.1, Codex‑Max va letto come il tassello specifico per il coding agentico. Per scenari di conversazione generale o di knowledge work è più indicato usare GPT‑5.1 Instant o Thinking, mentre per i flussi che richiedono esecuzione di comandi, gestione di file e cicli di feedback su repository di codice la scelta naturale diventa il modello Codex‑Max.

Questo si integra anche con le novità introdotte da GPT‑5.1 per gli sviluppatori, come il tool apply_patch per modificare il codice in modo più prevedibile e lo strumento di shell per eseguire comandi controllati. In un contesto Codex, questi strumenti diventano i “muscoli” operativi di un agente che ragiona a lungo raggio e interagisce con l’ambiente in modo iterativo.

Sicurezza, cybersecurity e mitigazioni di rischio

La maggiore capacità agentica di GPT‑5.1‑Codex‑Max rende naturale porsi domande sulla sicurezza. La system card pubblicata da OpenAI offre un quadro abbastanza dettagliato delle mitigazioni integrate sia a livello di modello sia di prodotto.

Sul fronte delle capability, GPT‑5.1‑Codex‑Max viene valutato nel framework di preparedness dell’azienda. È considerato molto capace in ambito cybersecurity, pur senza raggiungere ancora la soglia definita come “High” per questo dominio, mentre viene trattato come High sul versante biologia e viene distribuito con lo stesso set di salvaguardie applicato a GPT‑5. Non raggiunge invece la soglia di alta capacità per l’auto‑miglioramento dell’IA, un aspetto fondamentale nel dibattito sulla sicurezza dei sistemi avanzati.

Più interessante per chi sviluppa prodotti sono però le mitigazioni specifiche per l’ambiente Codex. Di default gli agenti operano in sandbox isolate, con accesso alla rete disabilitato e possibilità di scrittura limitata alla workspace del progetto. Su macOS il sandboxing sfrutta i meccanismi Seatbelt del sistema operativo, mentre su Linux vengono utilizzati seccomp e landlock; su Windows è disponibile un’implementazione nativa sperimentale o l’uso di WSL come strato di isolamento.

Gli utenti hanno comunque la possibilità di abilitare l’accesso a internet, per esempio per installare dipendenze o consultare documentazione online, ma possono farlo in modo granularmente controllato definendo allowlist e denylist di domini. La system card insiste sul fatto che l’abilitazione indiscriminata della rete apre la porta a rischi di prompt injection, esfiltrazione di dati e utilizzo di codice con licenze problematiche, e raccomanda quindi di mantenere l’agente in modalità ristretta per la maggior parte dei casi d’uso.

Sul lato del modello, OpenAI descrive una serie di training dedicati per ridurre la propensione a compiti considerati dannosi, in particolare lo sviluppo di malware. Viene utilizzata una pipeline sintetica per generare scenari realistici di codice malevolo, a cui il modello impara a rispondere con rifiuti o con contenuti orientati alla difesa, evitando al contempo un eccesso di prudenza che ostacolerebbe attività legittime come l’ingegneria di basso livello o il testing di sicurezza.

Lo stesso approccio viene applicato ai prompt injection nella cornice degli agenti. Il modello riceve dati di addestramento sintetici in cui testi malevoli tentano di interrompere il task, di deviare il comportamento o di indurre azioni indesiderate in step successivi. L’obiettivo è imparare a dare priorità alle istruzioni di sistema e alle policy rispetto a comandi sospetti presenti nel codice o in contenuti recuperati dall’esterno.

Infine, un’attenzione specifica è dedicata alle azioni distruttive sui dati, come comandi che cancellano file o resettano branch Git. Durante l’addestramento con reinforcement learning viene simulata la presenza di un “utente modello” che modifica il codice in parallelo all’agente, e il modello viene premiato quando preserva le modifiche dell’utente ed evita operazioni irreversibili non necessarie. Questo mira a ridurre casi in cui un agente, nel tentativo di “ripulire” un repository, finisce per eliminare lavoro valido.

Implicazioni per i team di sviluppo

Per i team che stanno progettando o già utilizzano agenti di coding, GPT‑5.1‑Codex‑Max rappresenta un cambio di passo sotto due profili complementari. Da un lato aumenta l’orizzonte temporale e la profondità dei compiti che possono essere delegati all’agente, grazie alla capacità di lavorare per ore su un progetto con compaction automatica della cronologia. Dall’altro lato rende economicamente più sostenibile questo tipo di utilizzo, riducendo il numero di token necessari per raggiungere un determinato livello di qualità.

In prospettiva, l’adozione di questi modelli può portare a una ristrutturazione dei workflow di sviluppo. Alcune attività oggi considerate “core” per gli sviluppatori, come il wiring iniziale di un servizio, la manutenzione di boilerplate o la gestione di refactoring meccanici, possono essere affidate in larga parte a Codex, mentre gli umani si concentrano su design architetturale, definizione dei requisiti, revisione strategica e validazione finale.

Resta centrale il ruolo delle competenze di ingegneria del prompt e di progettazione degli agent loop. Il valore di GPT‑5.1‑Codex‑Max dipende in modo diretto da come viene incapsulato all’interno di workflow sicuri, osservabili e ripetibili, con controlli di qualità automatici e punti di intervento umano chiaramente definiti. In questo senso il modello è un “motore” potente, ma richiede una carrozzeria e un telaio progettati con la stessa cura.

Conclusioni

GPT‑5.1‑Codex‑Max segna un ulteriore passo verso agenti di sviluppo software in grado di sostenere carichi di lavoro complessi e prolungati. La combinazione di compaction multi‑finestra, miglioramenti sui benchmark di coding, efficienza nel consumo di token e un’attenzione strutturata alla sicurezza rende il modello un candidato naturale per le organizzazioni che vogliono spingersi oltre l’uso occasionale dei suggerimenti di codice e sperimentare forme più avanzate di automazione dello sviluppo.

Allo stesso tempo, la presenza di sandbox, controlli di rete configurabili e training specifici contro malware e prompt injection ricorda che la potenza degli agenti va bilanciata con una progettazione attenta del perimetro di azione. Nei prossimi mesi sarà interessante osservare quali pattern di utilizzo emergeranno nella comunità degli sviluppatori e come questi strumenti verranno integrati nei cicli di vita del software, dalla prototipazione rapida alla manutenzione di lungo periodo.

Se le promesse di GPT‑5.1‑Codex‑Max verranno confermate dai casi d’uso reali, la distanza tra l’idea di un “copilot” e quella di un partner di sviluppo autonomo potrebbe ridursi più in fretta di quanto molti team si aspettino.

Bibliografia

OpenAI, “GPT‑5.1: ChatGPT diventa più intelligente e più naturale”, panoramica del modello. [https://openai.com/it-IT/index/gpt-5-1/]

OpenAI, “Building more with GPT‑5.1‑Codex‑Max”, annuncio di prodotto, 19 novembre 2025. [https://openai.com/index/gpt-5-1-codex-max/]

OpenAI, “GPT‑5.1‑Codex‑Max System Card”, pubblicazione tecnica, 18 novembre 2025. [https://openai.com/index/gpt-5-1-codex-max-system-card/]

OpenAI, “Introducing GPT‑5.1 for developers”, annuncio per sviluppatori, 13 novembre 2025. [https://openai.com/index/gpt-5-1-for-developers/]

OpenAI Developers, “Codex Models”, documentazione Codex. [https://developers.openai.com/codex/models/]