A dodici mesi dall’avvio della rivoluzione dell’agentic AI, una lezione è chiara: fare le cose per bene richiede lavoro duro. La trasformazione agentica promette livelli di produttività senza precedenti. Alcune aziende stanno già raccogliendo i frutti, ma molte altre faticano a generare valore e, in certi casi, sono persino tornate indietro, riassumendo personale dopo i fallimenti degli agenti.

Per capire le prime lezioni, McKinsey ha analizzato oltre 50 implementazioni dirette di agentic AI, più decine di altre nel mercato. Il risultato è stato distillato in sei insegnamenti fondamentali per i leader che vogliono trarre valore da questa tecnologia.

Indice degli argomenti:

Cos’è l’agentic AI

L’agentic AI si basa su modelli generativi di fondazione in grado di agire nel mondo reale ed eseguire processi multistep. Gli agenti AI possono automatizzare e portare a termine compiti complessi, spesso usando il linguaggio naturale, attività che normalmente richiederebbero l’intervento umano. Come già accaduto con altre tecnologie emergenti, inciampi e battute d’arresto fanno parte del percorso.

1. Non è l’agente, è il workflow

Creare valore non significa costruire l’agente “perfetto”, ma ridisegnare i flussi di lavoro. Concentrarsi troppo sull’agente porta spesso a strumenti dall’aspetto sofisticato ma incapaci di migliorare il processo complessivo.

Il punto di partenza è mappare i processi e individuare i pain point degli utenti. Questo consente di progettare sistemi che eliminano attività superflue, favoriscono la collaborazione uomo-agente e creano loop di apprendimento che rafforzano l’efficacia degli strumenti.

Un esempio arriva da un fornitore di servizi legali alternativi che ha modernizzato la revisione contrattuale: ogni modifica degli utenti veniva registrata e classificata, generando un flusso di feedback continuo per ingegneri e data scientist. Nel tempo, gli agenti hanno così potuto codificare nuove competenze.

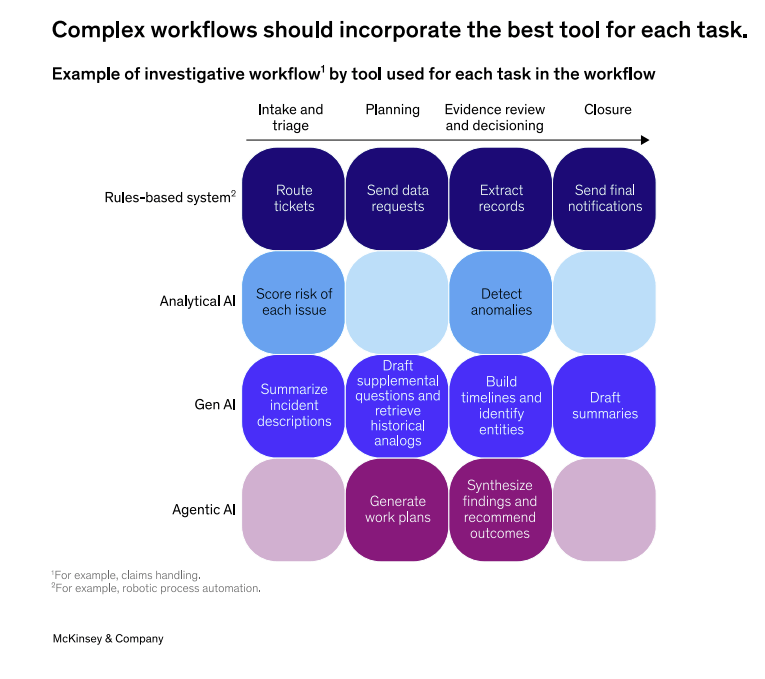

2. Gli agenti non sono sempre la risposta

Gli agenti possono fare molto, ma non sempre sono la soluzione migliore. Alcuni problemi aziendali si risolvono meglio con automazioni basate su regole, predictive analytics o prompt mirati per modelli linguistici.

La regola aurea: valutare prima la natura del compito. Se il processo è standardizzato e a bassa variabilità (come l’onboarding degli investitori), un agente basato su LLM può introdurre più incertezza che valore. Al contrario, in flussi complessi e variabili – come l’estrazione di informazioni finanziarie – gli agenti possono davvero fare la differenza.

3. Fermare l’“AI slop”: valutazioni e fiducia degli utenti

Uno dei rischi più comuni è l’“AI slop”: sistemi che sembrano brillanti nelle demo ma generano risultati scadenti nell’uso reale, minando la fiducia degli utenti. Per evitarlo, le aziende devono trattare gli agenti come nuovi dipendenti: fornire descrizioni di ruolo, onboarding e feedback costanti.

Le valutazioni (“evals”) sono centrali: dal tasso di successo dei task alla precisione dei recuperi documentali, dalla rilevazione di bias fino al tasso di allucinazioni. Senza monitoraggi costanti, gli agenti rischiano di fallire silenziosamente. Un esempio è quello di una banca globale che ha raffinato i criteri di analisi del rischio dopo aver confrontato sistematicamente i giudizi umani con quelli degli agenti.

Regole generali di alto livello da considerare nella scelta degli strumenti di AI da utilizzare

Quando si decide quale strumento di AI utilizzare per diversi compiti, possono essere utili le seguenti linee guida:

- Se il compito è basato su regole e ripetitivo, con input strutturato (ad esempio, immissione di dati), utilizzare l’automazione basata su regole.

- Se l’input è non strutturato (ad esempio, documenti lunghi), ma l’attività è comunque di tipo estrattivo o generativo, utilizzare l’AI generativa, l’elaborazione del linguaggio naturale o l’analisi predittiva.

- Se l’attività prevede la classificazione o la previsione sulla base di dati passati, utilizzare l’analisi predittiva o l’AI generativa.

- Se l’output richiede sintesi, giudizio o interpretazione creativa, utilizzare l’AI generativa.

- Se l’attività comporta un processo decisionale in più fasi e presenta una lunga serie di input e contesti altamente variabili, utilizzare agenti di intelligenza artificiale.

Tipi di valutazione

Queste sono alcune valutazioni tipiche utilizzate per valutare le prestazioni degli agenti:

- Tasso di successo delle attività (end-to-end). Il tasso di successo delle attività misura la percentuale di flussi di lavoro completati correttamente senza escalation o intervento umano, riflettendo l’utilità nel mondo reale.

- Punteggio F1/precisione e richiamo. Questa metrica bilancia i falsi positivi e i falsi negativi, rendendola utile per le attività di classificazione, estrazione e accuratezza decisionale in cui esiste un risultato chiaramente misurabile (cioè sì o no).

- Accuratezza del recupero. L’accuratezza del recupero è la percentuale di documenti, fatti o prove corretti recuperati rispetto al set di verità di base, che è fondamentale per i flussi di lavoro potenziati dal recupero.

- Somiglianza semantica. La somiglianza semantica viene misurata utilizzando la somiglianza coseno basata sull’incorporamento tra l’output generato e l’output di riferimento, catturando l’allineamento del significato al di là dell’esatta corrispondenza delle parole.

- LLM come giudice. L’utilizzo di un modello linguistico di grandi dimensioni (LLM) come giudice comporta la valutazione degli output rispetto a standard di riferimento o preferenze umane. Questa metrica si adatta bene a giudizi soggettivi come chiarezza, utilità e validità del ragionamento.

- Rilevamento dei pregiudizi (tramite matrici di confusione). Il rilevamento dei pregiudizi misura le differenze sistematiche nei risultati tra i gruppi di utenti utilizzando matrici di confusione, che evidenziano dove si manifestano i pregiudizi (ad esempio, falsi negativi che influenzano in modo sproporzionato un gruppo).

- Tasso di allucinazioni. Questa metrica tiene traccia della frequenza di affermazioni fattualmente errate o non supportate, garantendo l’affidabilità dei risultati dell’agente.

- Errore di calibrazione (fiducia contro accuratezza). L’errore di calibrazione misura se i punteggi di fiducia dell’agente sono in linea con l’effettiva correttezza, il che è importante per i flussi di lavoro sensibili al rischio.

4. Tracciare e verificare ogni passaggio

Con pochi agenti è semplice individuare errori, ma con centinaia o migliaia diventa quasi impossibile. Limitarsi a monitorare gli output finali non basta: serve osservabilità integrata in ogni step.

Un provider legale ha scoperto un calo di accuratezza grazie a strumenti di monitoraggio granulari: il problema derivava da dati scadenti inviati da un segmento di utenti. Raffinando le pratiche di raccolta dati e la logica di parsing, l’accuratezza è rapidamente risalita.

5. Il riuso come caso d’uso migliore

Creare un agente per ogni compito porta a sprechi e ridondanze. Spesso gli stessi agenti possono gestire attività diverse che condividono fasi comuni (estrazione, ricerca, analisi).

Investire in agenti riutilizzabili è come progettare architetture IT scalabili: richiede giudizio e analisi, ma può eliminare fino al 50% del lavoro non essenziale. La chiave è sviluppare servizi e asset centralizzati – da prompt approvati a componenti riutilizzabili – integrati in piattaforme unificate.

6. Gli esseri umani restano centrali

Nonostante i progressi, gli esseri umani restano essenziali. Gli agenti non sempre sono la risposta e il numero di persone coinvolte nei workflow potrà ridursi, ma serviranno supervisione, giudizio, compliance e gestione dei casi limite.

Il successo dipende da workflow progettati per la collaborazione uomo-agente. In ambito legale, ad esempio, gli avvocati devono rivedere e approvare i dati estratti dagli agenti, o modificare i piani di lavoro suggeriti. Interfacce visive intuitive, come quelle sviluppate da una compagnia assicurativa, hanno portato l’accettazione degli utenti al 95%.

Conclusione: imparare è l’unica strada

Il mondo dell’agentic AI si muove in fretta e altre lezioni emergeranno presto. Ma senza un approccio orientato all’apprendimento continuo, le aziende rischiano di ripetere gli stessi errori e rallentare i progressi.

Lo studio di McKinsey sull’agentic AI mette in evidenza sei lezioni cruciali, ma riflette anche un limite tipico delle analisi consulenziali: la prospettiva è fortemente centrata sulle grandi imprese già digitalmente mature. Si parla poco dei costi di implementazione, delle barriere culturali e delle implicazioni occupazionali concrete. Inoltre, la narrazione tende a minimizzare i fallimenti strutturali dietro la formula rassicurante dell’“evoluzione naturale della tecnologia”. In realtà, la distanza tra promesse e risultati rimane ampia: senza governance, standard aperti e strategie di lungo termine, il rischio è replicare i cicli di hype già visti con altre innovazioni digitali.