Meta sta considerando l’adozione delle TPU (Tensor Processing Unit) di Google nei propri data center dal 2027, con la possibilità di noleggiare capacità di calcolo già entro il prossimo anno. I mercati reagiscono subito: Alphabet sale, Nvidia scende, Broadcom cresce.

Dietro la cronaca quotidiana c’è però un fenomeno più rilevante. Per la prima volta uno dei maggiori investitori mondiali in infrastrutture AI, Meta – 70-72 miliardi di dollari di CapEx nel 2025 – dichiara apertamente che la dipendenza da un unico fornitore di GPU non è più sostenibile.

È l’avvio di una nuova fase: la guerra del calcolo, in cui non vince chi ha il modello più performante, ma chi controlla l’energia computazionale necessaria per generarlo, aggiornarlo e farlo funzionare su scala globale.

Indice degli argomenti:

Perché Meta guarda seriamente alle TPU

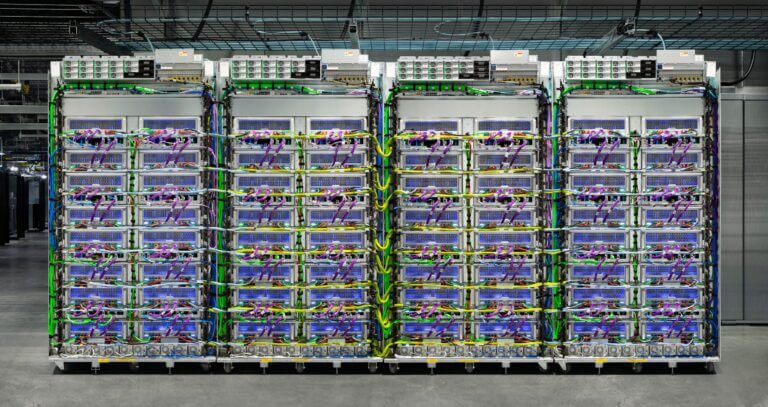

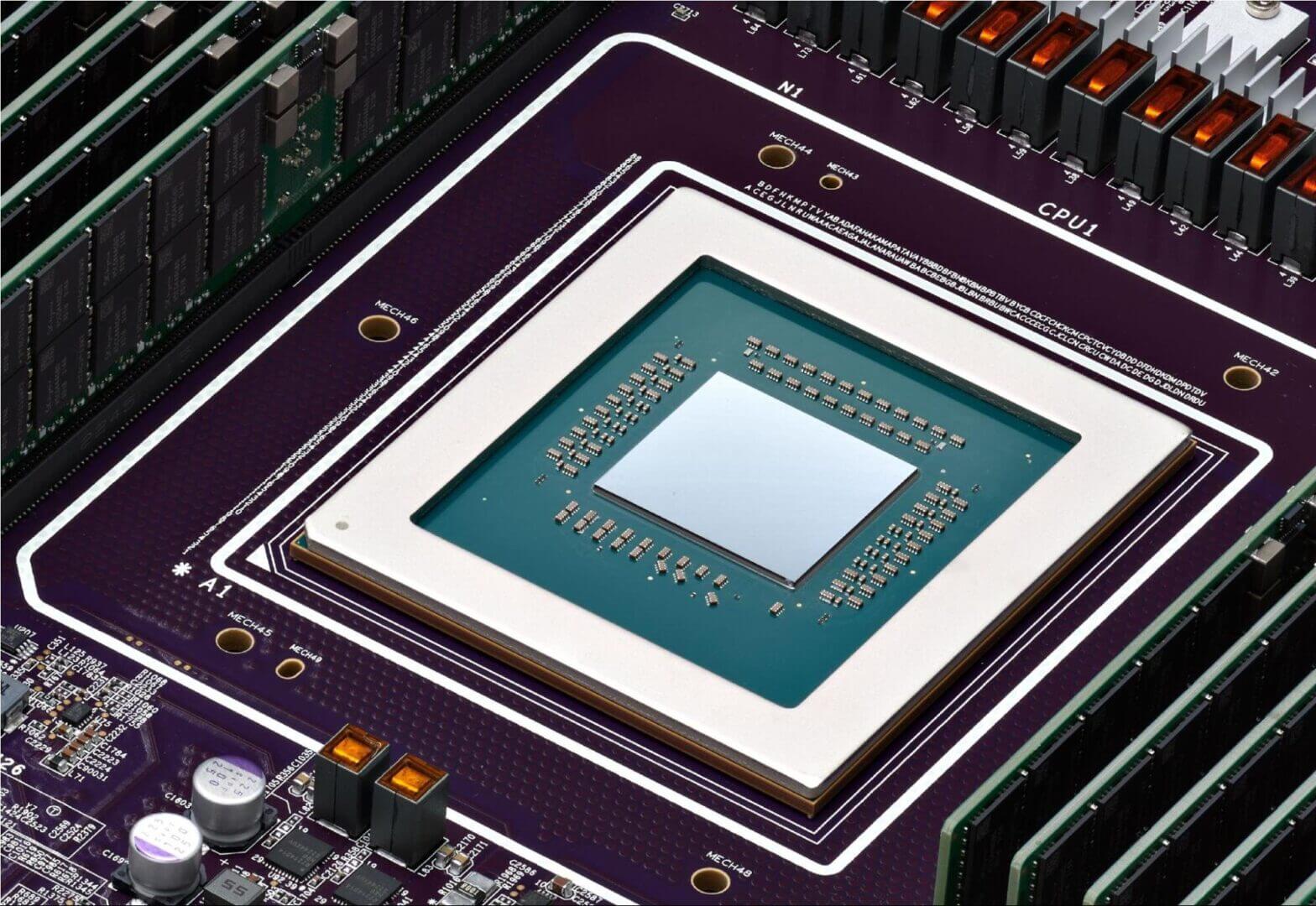

Le TPU sono chip specializzati per l’AI progettati da Google e prodotti in partnership con Broadcom. Sono nate nel 2018 come acceleratori per i servizi cloud interni, ma negli anni si sono trasformate in una piattaforma completa: architettura, software, rete, orchestrazione, integrazione verticale con il cloud Google.

Il motivo dell’interesse di Meta non è solo tecnologico. È economico.

Il costo del pre-training dei modelli è cresciuto in modo esponenziale. I modelli frontier della prossima generazione richiederanno investimenti nell’ordine dei miliardi di dollari per singola fase di training. Se la disponibilità di GPU diventa irregolare o se il prezzo continua ad aumentare, la scalabilità dell’intero settore è a rischio.

Le TPU offrono un’alternativa con un rapporto costo-prestazioni molto competitivo, soprattutto quando sono utilizzate all’interno della rete ad alta capacità di Google. Per Meta, anche un 10–15% di riduzione del costo per FLOP significa un risparmio di centinaia di milioni di dollari annui.

Il valore dell’integrazione verticalizzata

Rispetto alle GPU Nvidia, le TPU si inseriscono in uno stack integrato che comprende:

- architettura hardware ottimizzata per il training dei transformer;

- sistemi di interconnessione dedicati;

- compilatori specifici per ridurre le inefficienze computazionali;

- gestione del cluster e load balancing integrato nella piattaforma cloud.

Per un attore come Meta, che deve gestire modelli multimodali su larga scala, la possibilità di accedere a una pipeline già ottimizzata consente di lavorare con maggiore prevedibilità.

La concorrenza non si gioca più solo sui benchmark dei modelli, ma sulla maturità dell’infrastruttura.

I movimenti dei titoli come indicatori anticipatori

L’impatto immediato sui titoli racconta un’altra storia. Nvidia perde terreno, Alphabet aumenta la capitalizzazione e si avvicina alla soglia dei 4.000 miliardi di dollari (al momento in cui scriviamo). Broadcom continua una performance positiva già iniziata prima della notizia.

Questi segnali non derivano dalla semplice curiosità per la scelta di un cliente, ma dal riconoscimento che la domanda di chip AI non sarà più intrappolata in un unico fornitore.

Gli investitori stanno iniziando a distinguere tra:

- chi fornisce potenza computazionale;

- chi controlla la filiera produttiva;

- chi può offrire soluzioni integrate, più efficienti e più stabili.

La monocultura GPU non è ancora in crisi, ma sta perdendo la sua aura di inevitabilità.

Il memo di Altman e la consapevolezza di un nuovo ciclo industriale

Il memo interno di Sam Altman del 24 febbraio 2025 è una conferma della tensione crescente: i progressi di Google potrebbero creare “venti economici contrari temporanei” per OpenAI.

È una frase che mostra un cambio di prospettiva. La competizione tra OpenAI e Google non riguarda più soltanto la qualità dei modelli, ma la capacità di addestrarli rapidamente, senza colli di bottiglia e senza costi eccessivi.

Google ha un vantaggio raro: controlla quasi tutta la catena del calcolo.

Progetta i chip, li ottimizza nel proprio cloud, usa architetture proprietarie, ha un software di orchestrazione nativo e dispone di un’infrastruttura elettrica e di data center in grado di assorbire la crescita esponenziale della domanda.

Per OpenAI, senza un’infrastruttura completamente proprietaria, la concorrenza diventa anche una sfida di approvvigionamento.

Gli hyperscaler riscrivono la geografia del calcolo

Non c’è solo Google. Tutti gli attori principali stanno costruendo la propria strategia infrastrutturale:

- Amazon accelera su Trainium e Inferentia, integrati in AWS come alternativa scalabile alle GPU;

- Microsoft introduce i suoi chip “Athena”, per ridurre la dipendenza da Nvidia e migliorare prestazioni e margini;

- Tesla investe in Dojo, una piattaforma pensata per l’addestramento massivo di reti per la computer vision;

- Cerebras propone un’architettura completamente diversa, basata su wafer giganteschi pensati per training parallelo;

- Meta, già autore del chip MTIA per l’inferenza, studia ora un’alternativa esterna per il training.

Il risultato è un ecosistema molto più frammentato e competitivo, che rompe una dinamica consolidata: quella di Nvidia come unico standard industriale.

Perché la monocultura GPU non è più sostenibile

Le GPU hanno reso possibile la rivoluzione dell’AI generativa. Hanno permesso di scalare miliardi di parametri, di addestrare modelli multimodali, di accelerare la ricerca.

Ma la loro centralità ha creato due criticità:

- costo in continua crescita: i cluster H100 e H200 hanno prezzi elevati sia in CapEx sia in OpEx;

- dipendenza dal ritmo produttivo di un solo fornitore: ogni rallentamento o aumento di domanda produce shock di disponibilità e di prezzo.

La diversificazione oggi non è un’opzione, ma una necessità strategica.

Nessuna impresa, nemmeno le big tech, può basare i propri piani sull’ipotesi che un unico fornitore produca chip sempre più performanti, sempre disponibili e a prezzi stabili.

Nasce un nuovo oligopolio del compute

Il mercato sta entrando in una fase in cui il valore non si sposta solo sulle prestazioni dei modelli, ma sulla struttura industriale che li sostiene.

Sta emergendo un nuovo oligopolio del calcolo, composto dagli attori che possono controllare tre elementi simultaneamente:

- progettazione dei chip;

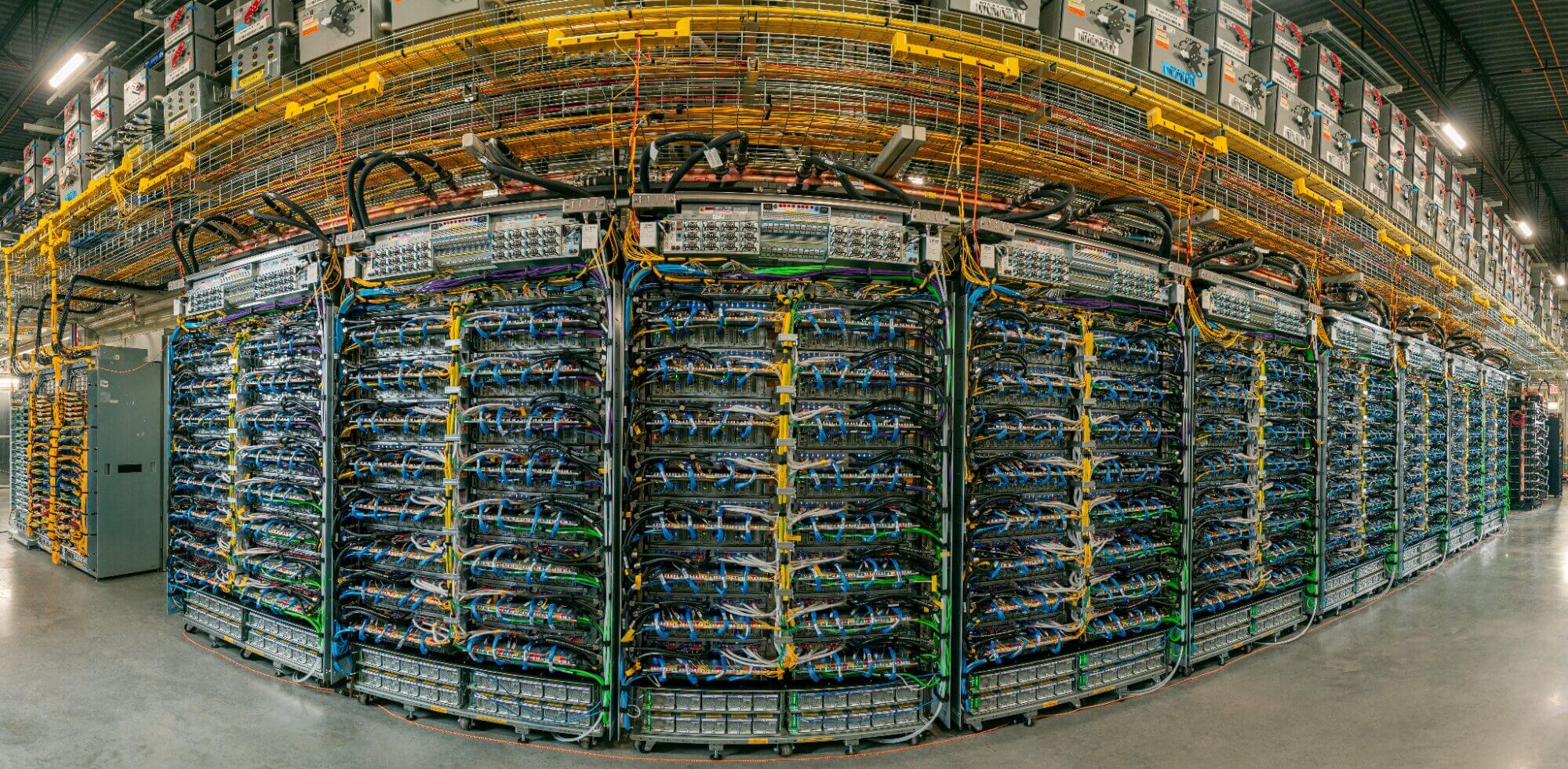

- infrastruttura cloud e data center;

- ecosistema software e modelli proprietari.

Chi possiede questi tre livelli non sta semplicemente vendendo servizi: sta definendo lo standard operativo su cui si costruiranno le future applicazioni AI.

Le implicazioni per le imprese

Per chi guida la trasformazione digitale, questa evoluzione cambia radicalmente l’approccio all’adozione dell’intelligenza artificiale:

- pianificazione dei costi di calcolo: non più reattiva, ma parte integrante della strategia di prodotto e di innovazione;

- analisi delle dipendenze: capire quanto l’azienda è esposta a un singolo vendor o a un singolo tipo di architettura;

- valutazione delle alternative: considerare chip specializzati, multi-cloud, modelli più efficienti;

- integrazione tra AI e cloud strategy: oggi sono due aspetti inseparabili.

Nella prossima fase dell’AI, la domanda non sarà “quale modello usare”, ma “qual è il costo marginale del mio calcolo e quanto dipendo da chi lo produce”.

Dalla corsa ai modelli alla corsa al calcolo

La fase 2022–2024 dell’AI è stata dominata dall’attenzione verso i modelli generativi.

La fase 2025–2027 sarà dominata dalla competizione per il calcolo.

Meta che guarda alle TPU di Google è un segnale di questa transizione: un passaggio che riguarda infrastruttura, economia, filiere produttive e governance tecnologica.

L’AI non è più solo un insieme di modelli intelligenti. È un ecosistema industriale che richiede energia, chip, data center e orchestrazione di scala globale.

Chi controllerà questi elementi definirà non solo la velocità dell’innovazione, ma la direzione stessa della competizione.