Le GPU (Graphics Processing Unit) e le TPU (Tensor Processing Unit) sono i motori hardware alla base della rivoluzione dell’intelligenza artificiale.

Le prime, nate per la grafica, sono diventate workhorse versatili per addestrare e far girare modelli AI; le seconde, progettate da Google, puntano tutto sull’efficienza nei calcoli tensoriali.

Approfondiamo cosa sono e come funzionano GPU e TPU, le loro differenze tecniche, i diversi impieghi (training vs inferenza), i principali produttori (Nvidia, AMD, Intel, Google ecc.), l’andamento del mercato e le prospettive future degli acceleratori AI.

Indice degli argomenti:

Cosa sono GPU e TPU

GPU

Le GPU (Graphics Processing Unit) sono processori specializzati originariamente progettati per l’elaborazione grafica. Sono dotate di un’architettura altamente parallela, con migliaia di core più piccoli capaci di eseguire molti calcoli simultaneamente. Questa struttura parallela si è rivelata ideale anche per gli algoritmi di intelligenza artificiale che richiedono di elaborare grandi blocchi di dati in parallelo.

Negli ultimi anni le GPU si sono evolute aggiungendo componenti specifici per l’AI, come i tensor core introdotti da Nvidia, che accelerano le operazioni a precisione mista su tensori (moltiplicazioni matrice-vettore). Grazie alla loro versatilità, le GPU oggi sono utilizzate ben oltre la grafica: dal training di reti neurali e LLM, fino a simulazioni scientifiche e analytics.

TPU

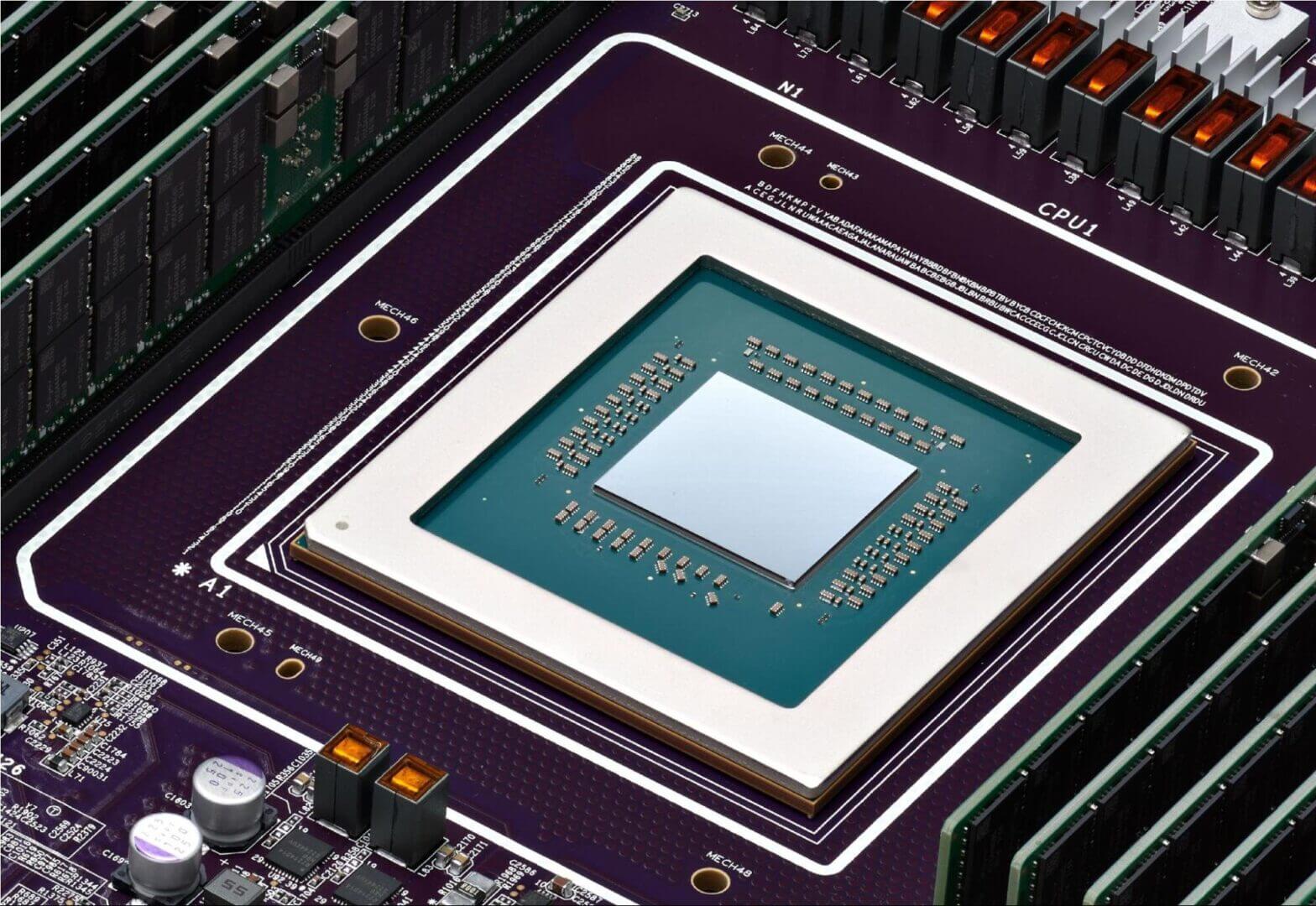

Le TPU (Tensor Processing Unit) sono invece chip specializzati (application-specific integrated circuit, ASIC) progettati da Google specificamente per accelerare i carichi di lavoro dell’AI. Hanno debuttato nel 2015, inizialmente per supportare le esigenze di Google Search e Google Translate; le TPU adottano un design radicalmente diverso dalle GPU generiche. All’interno di una TPU si trovano unità di moltiplicazione di matrici di grandi dimensioni (ad esempio array sistolici 128×128 nella terza generazione) invece di numerosi core general-purpose.

Questa architettura è hardwired per eseguire in modo estremamente efficiente le operazioni matriciali tipiche dell’AI (tensori, moltiplicazioni accumulate), sacrificando però la flessibilità su calcoli diversi. In pratica, le TPU eccellono nei calcoli tensoriali,il “cuore matematico” delle reti neurali,e spesso raggiungono una throughput (operazioni al secondo) e un’efficienza energetica superiori a quelle di una GPU di costo comparabile sugli stessi compiti.

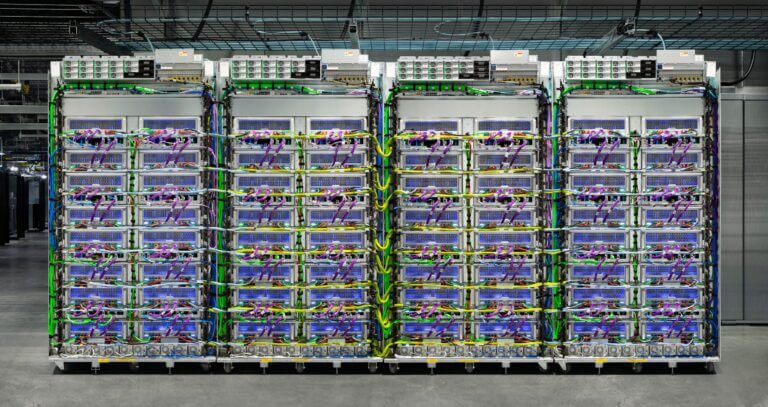

Essendo progettate ad hoc, includono componenti specializzati come le MXU (Matrix Multiply Unit) e interconnessioni ad altissima velocità proprietarie, pensate per collegare decine o centinaia di chip in cluster (TPU pod) e operare come un unico super-processore. Va notato che le TPU sono una innovazione made in Google: a differenza delle GPU che sono prodotte da varie aziende, le TPU sono sviluppate e utilizzate da Google nei propri data center e rese disponibili al pubblico tramite Google Cloud.

Una GPU può essere vista come un processore grafico “prestato” all’AI, potente e flessibile ma non progettato esclusivamente per essa, mentre una TPU è un acceleratore costruito su misura per le reti neurali, altamente ottimizzato per quel tipo di calcoli e meno adatto ad altro.

Entrambi giocano un ruolo chiave nell’AI moderna, ma con approcci differenti, come vedremo nel dettaglio.

Architettura e differenze tecnologiche

Le GPU contengono migliaia di core capaci di elaborare insiemi di dati in parallelo. Questa architettura deriva dalla grafica in tempo reale, dove occorre calcolare simultaneamente i pixel di un’immagine. Nel contesto AI, ciò si traduce in efficacia nel parallelizzare moltiplicazioni e somme su vettori e matrici di grandi dimensioni. Le moderne GPU Nvidia (come A100, H100) integrano anche tensor core per accelerare le operazioni di aritmetica a matrice in precisione ridotta (FP16/FP8/INT8), fondamentali per allenare reti neurali profonde. La forza delle GPU sta nella versatilità: pur avendo origini grafiche, oggi sono programmaticamente flessibili e supportano una vasta gamma di algoritmi e modelli, non solo reti neurali (possono eseguire praticamente qualsiasi codice parallelo, compresi modelli con logica condizionale complessa, algoritmi scientifici non neuronali, ecc.).

Le TPU adottano un paradigma diverso: specializzazione estrema. Invece di tantissimi core generici, una TPU v4/v5 per esempio contiene un numero limitato di “core” ognuno con un gigantesco circuito di moltiplicazione-accumulo (systolic array). Ad esempio, TPU v5 impiega matrici 256×256 che possono eseguire 65.536 operazioni multiply-accumulate per ciclo. Questo design altamente specializzato permette di ottenere un throughput elevatissimo sui calcoli matriciali tipici del deep learning.

Di contro, la TPU ha meno unità general-purpose e richiede di “riempire” queste grandi unità con batch di dati abbondanti per raggiungere l’efficienza massima. Ciò significa che eccelle in carichi ben strutturati e batchati, mentre risulta meno flessibile o efficiente su elaborazioni molto dinamiche o con poca parallelizzazione intrinseca.

In breve, le TPU offrono più prestazioni per dollaro sulle operazioni AI standard, ma fuori da quel perimetro non possono essere riprogrammate per compiti arbitrari come invece una GPU può fare.

L’efficienza energetica

Uno dei vantaggi principali delle TPU è l’efficienza. Eliminando tutta la circuiteria non necessaria ai calcoli neurali (ad esempio le parti dedicate a grafica, shader, ecc. presenti nelle GPU) e ottimizzando la circuiteria per le precise operazioni richieste dalle reti neurali, le TPU raggiungono prestazioni per watt impressionanti.

Google riportò che la TPU v1 (impiegata dal 2015 per l’inferenza) ottenne miglioramenti di 30× fino a 80× in operazioni per watt rispetto a CPU e GPU contemporanee nei workload di inferenza in produzione. In pratica, per lo stesso consumo energetico, una TPU poteva effettuare decine di volte le operazioni di una GPU su task come traduzione automatica o ranking di risultati di ricerca.

Le GPU, dal canto loro, hanno fatto passi avanti in efficienza (anche grazie a processi produttivi più fini e all’integrazione di unità AI dedicate), ma rimangono tendenzialmente più energivore: una GPU ad alte prestazioni spesso consuma 300-400 watt o più, mentre una TPU, progettata con logica custom, massimizza le operazioni utili per watt speso. Questo è cruciale nei data center AI su larga scala: minor consumo significa meno calore e costi operativi ridotti a parità di throughput computazionale.

Memoria e interconnessione

Le GPU high-end dispongono di memorie video (VRAM) molto capienti e veloci direttamente sul package. Ad esempio, Nvidia A100 ha 80 GB di memoria HBM2e a larghissima banda, e la nuova H100 arriva a 94 GB HBM3. Ciò consente a una singola GPU di gestire modelli abbastanza grandi interamente in loco.

Le TPU tendono a avere memoria locale per core più limitata (es. TPU v3 aveva ~8 GB per core, TPU v4/v5 qualche decina di GB per chip) e puntano piuttosto a una strategia distribuita: i modelli di grande dimensione sono suddivisi su più chip TPU che comunicano velocemente tra loro. Google ha implementato sulle TPU un’interconnessione ad hoc (a topologia a toro 2D nelle TPU v2/v3, evoluta in rete a maglia ottica nelle v4) che collega centinaia di chip con latenza bassissima.

Un TPU pod (es. pod TPU v4) può connettere oltre 1000 chip in parallelo con comunicazioni molto efficienti, tanto da scalare quasi linearmente all’aumentare dei chip su alcuni carichi.

Ad esempio, Google riferisce che le TPU v4 in pod hanno permesso di addestrare modelli giganteschi come PaLM (540 miliardi di parametri) in tempi e costi competitivi, dove una rete di GPU tradizionali avrebbe richiesto più sforzo di orchestrazione e consumi maggiori. In altre parole, l’architettura TPU privilegia lo scale-out (molti chip più semplici in parallelo) mentre le GPU combinano scale-up (molta potenza e memoria su singola scheda) con scale-out (collegare più GPU via NVLink, InfiniBand ecc., sebbene con più overhead rispetto alle TPU).

Ottimizzazione e software

Sul fronte software, la differenza è marcata. Le GPU godono di un ecosistema maturo e ampio: Nvidia ha sviluppato CUDA nel 2006, aprendo la programmazione generica sulle GPU, e oggi tutte le principali librerie e framework (TensorFlow, PyTorch, JAX, ecc.) supportano nativamente le GPU.

Esiste un’enorme community di sviluppatori GPU, innumerevoli ottimizzazioni (es. NVIDIA TensorRT per inferenza ottimizzata, librerie cuDNN per reti neurali, ecc.) e strumenti di debugging/profiling sofisticati.

Le TPU, essendo hardware proprietario Google, inizialmente erano accessibili solo tramite TensorFlow XLA (il compilatore accelerato di Google). Col tempo Google ha ampliato il supporto includendo JAX e persino PyTorch su TPU (soprattutto con la recente TPU v5e), ma rimane un ecosistema più chiuso. Il codice destinato a TPU deve essere compilato e ottimizzato specificamente (spesso con vincoli, ad esempio forme statiche delle matrici, e operazioni supportate dal compilatore XLA).

Modelli con logiche molto dinamiche, con operazioni personalizzate non standard, o che richiedono precisione numerica elevata potrebbero non trarre vantaggio o addirittura non girare sulle TPU senza modifiche.

Le GPU invece possono eseguire praticamente qualsiasi modello out-of-the-box; questa flessibilità le rende preferibili in fase di ricerca e sviluppo, prototipazione e per workload eterogenei. In breve, GPU significa compatibilità e facilità d’uso universale, TPU significa massime prestazioni ma in un giardino più recintato (l’ecosistema Google Cloud).

Latenza vs throughput

Un’altra differenza tecnica da notare è filosofica: le GPU, nate per grafica, sono progettate per bassa latenza,devono completare velocemente frame grafici per garantire fluidità. Gli acceleratori AI come le TPU puntano tutto sulla massima throughput e l’efficienza su grandi batch. Ad esempio, una GPU esegue bene anche un singolo input alla volta con latenza contenuta, mentre le TPU rendono al meglio se tenute occupate con batch di dati di dimensioni consistenti.

Per le applicazioni AI questo si traduce in scelte architetturali: se occorre servire pochissime richieste con risposta in millisecondi (ad es. inferenza per un utente in tempo reale), la GPU brilla; se serve macinare enormi dataset il più economicamente possibile (ad es. addestrare un modello su miliardi di esempi), la TPU può risultare superiore in costo/prestazioni.

Entrambi comunque evolvono: le GPU moderne hanno aumentato il focus sulla throughput (vedi es. modalità MIG di NVIDIA per partizionare GPU e massimizzare l’uso, supporto multi-stream, ecc.), mentre le ultime TPU come la v5e migliorano anche la latenza per inferenza.

Tabella comparativa GPU vs TPU

La tabella seguente riassume le differenze chiave tra GPU e TPU su alcune dimensioni tecniche e operative:

| Dimensione | GPU (Graphics Processing Unit) | TPU (Tensor Processing Unit) |

| Architettura base | Migliaia di core paralleli generici | ASIC specializzato per moltiplicazione matriciale |

| Flessibilità | Altissima: programmabile per molti scopi | Bassa: progettata per reti neurali |

| Prestazioni AI | Eccellenti, soprattutto con tensor core (es. FP16/INT8); standard de-facto per t… | Massime su workload ben strutturati (matrici di grandi dimensioni); throughput p… |

| Efficienza energetica | Elevato consumo per GPU high-end (300+ W); ops/watt buono ma non ottimale al 100… | Molto efficiente su calcoli AI (meno componenti “inutili”); più ops per watt su … |

| Memoria | Grande VRAM on-board (fino 80-100 GB su modelli top) + cache; buona per modelli … | Memoria distribuita per chip (HBM per core, decine di GB); pensata per scalare s… |

| Ecosistema SW | Maturo e ampio: supporto nativo in PyTorch, TensorFlow, CUDA libs, ecc. Disponib… | Più ristretto: accesso principalmente via Google Cloud. Supporto diretto in Tens… |

| Principali produttori | NVIDIA (dominante), AMD, Intel (in crescita), altri (es. acceleratori GPU-like v… | Google (unico sviluppatore delle TPU). Altri chip AI simili (AWS Trainium, etc.)… |

| Disponibilità | Ampia: schede GPU disponibili commercialmente e in tutti i maggiori cloud. Commu… | Limitata: TPUs disponibili solo su Google Cloud (non in vendita diretta). Ecosis… |

| Casi d’uso tipici | Gaming e grafica (originario); HPC scientifico; AI training e inferenza in azien… | Servizi AI su scala Google (Search, YouTube, Maps, ecc.); training di foundation… |

Differenze nell’uso: training vs inferenza

Training (addestramento) dei modelli AI

Le GPU sono state per anni il cavallo di battaglia per l’addestramento del deep learning in ambito sia accademico che industriale. Librerie e framework sono ottimizzati principalmente per GPU e la maggior parte della ricerca e dei modelli open-source è sviluppata e rilasciata con compatibilità GPU in mente. Un team di data science che vuole addestrare un modello, da una CNN per visione artificiale a un Transformer per NLP, generalmente dispone di tool pronti per usare GPU Nvidia su workstation o istanze cloud.

La flessibilità e ubiquità delle GPU le rende la scelta predefinita: se stai mettendo a punto un modello con PyTorch o TensorFlow, quasi sicuramente utilizzerai GPU (locali o su AWS/Azure/Google Cloud) a meno che tu non sia in un ambiente Google specializzato in TPU. Inoltre, le GPU offrono un’esperienza di sviluppo più semplice: è più facile eseguire il debug di un codice PyTorch su GPU, utilizzare breakpoint, stampare valori intermedi, rispetto a far girare tutto dentro il compilatore XLA di una TPU.

Le TPU brillano nel training quando entrano in gioco modelli o dataset estremamente grandi e si può sfruttare l’infrastruttura Google. Google stessa usa ampiamente le TPU per training e fine-tuning di modelli come il linguistico PaLM o il multimodale Gemini, sfruttando enormi pod di TPU in parallelo. In scenari come la classificazione di immagini su scala web o il training di un modello linguistico con centinaia di miliardi di parametri, un pod TPU può completare l’addestramento significativamente più velocemente,e spesso con minore consumo totale,di un cluster equivalente di GPU.

Ad esempio, in un confronto pubblicato, addestrare ResNet-50 per alcune epoche ha richiesto solo 15 minuti su un Cloud TPU v3, contro ~40 minuti su una GPU Nvidia V100, a parità di batch size. Questo non significa che le TPU vincano sempre: per modelli non ottimizzati o molto fuori dallo standard, la GPU può ancora prevalere. Ma su workload ben parallelizzabili, le TPU possono offrire velocità e costo inferiore per addestramento per dollaro investito.

Va però sottolineato: non ogni modello è adatto alle TPU. Per sfruttarle al massimo, il modello deve potersi compilare con XLA, usare operazioni supportate e preferibilmente avere dimensioni di input fisse. Reti neurali con grafi altamente dinamici, ramificazioni condizionali o operatori personalizzati potrebbero funzionare male o richiedere adattamenti sulle TPU. In confronto, su GPU si può lanciare qualunque codice, anche con operazioni custom scritte in CUDA o con controlli di flusso complicati, la GPU eseguirà tutto, magari con minore efficienza ma senza rifiutare alcun compito. Pertanto, in fase di ricerca e sviluppo e per modelli non convenzionali, le GPU restano la scelta obbligata. Le TPU entrano in gioco quando c’è esigenza di scalare addestramenti enormi in produzione (tipicamente, scenario “Google scale”) o si vogliono ridurre i costi di training su cloud Google per modelli supportati.

Inferenza (esecuzione dei modelli addestrati)

Sul fronte dell’inferenza, le GPU sono ampiamente utilizzate per servire modelli AI in produzione con alte prestazioni. I moderni acceleratori GPU sono ottimizzati anche per l’inferenza: NVIDIA nelle sue ultime generazioni ha introdotto ad esempio il Transformer Engine e il supporto a formati numerici a bassa precisione (FP8, INT4) per accelerare l’inferenza di modelli come GPT-4.

Inoltre, esistono stack software maturi per l’inferenza su GPU a bassa latenza: da NVIDIA TensorRT a ONNX Runtime, fino alle librerie open source ottimizzate per GPU (es. HuggingFace Accelerate per text generation). Molti servizi AI noti girano su GPU per l’inferenza,ad esempio, OpenAI ChatGPT è servito su GPU Nvidia A100/H100 nei data center di Azure. Le GPU infatti garantiscono sia alta throughput sia latenza contenuta a livello di singola query, un bilanciamento ideale per servizi interattivi.

Anche le TPU hanno un ruolo importante nell’inferenza, soprattutto all’interno dei servizi Google. Google ha rivelato che TPU sono impiegate in produzione su Search, Google Foto, Google Maps e altri servizi per alimentare modelli di machine learning su scala planetaria. Per modelli di grandi dimensioni e volumi enormi di richieste, un cluster di TPU v4 o v5 può servire molte query in parallelo con throughput elevatissimo e latenza competitiva.

In effetti, la prima generazione TPU v1 fu progettata esclusivamente per l’inferenza (8-bit) e solo nelle generazioni successive Google aggiunse capacità di training. Oggi le TPU, come la recente TPU v5e, sono ottimizzate anche per l’inferenza ad alte prestazioni, con miglioramenti nel rapporto costo-prestazioni proprio per il serving efficiente di modelli di grandi dimensioni. Google afferma che l’uso delle TPU per inferenza su larga scala può risultare più conveniente in termini di costo per query rispetto alle GPU, soprattutto su batch ampi, pur con latenze simili.

Fuori dall’ecosistema Google, però, l’uso di TPU per inferenza è raro. La maggior parte delle aziende e dei developer utilizza GPU oppure acceleratori specializzati come le soluzioni di AWS per inferenza (Amazon Inferentia) nei propri deployment, perché sono più accessibili e supportati.

Se un’organizzazione esegue i suoi modelli su AWS, Azure o on-premise, praticamente non ha la possibilità di usare TPU (che vivono solo su Google Cloud) e opterà quindi per GPU o eventualmente CPU se il carico è ridotto. In Google Cloud stesso, un cliente può comunque scegliere di mettere in produzione un modello TensorFlow su istanze TPU se vuole massimizzare l’efficienza per query su modelli di grandi dimensioni, a patto di accettare il minor supporto ecosistemico rispetto alle GPU.

L’edge AI

Vale la pena menzionare che il termine TPU appare anche in contesti di inferenza su device edge. Google ad esempio chiama Edge TPU un piccolo acceleratore AI per dispositivi IoT (presente nei moduli Coral), e nei suoi chip mobile “Google Tensor” integra un’unità NPU per AI on-device.

Analogamente Apple ha il Neural Engine nei chip A/M, e altri vendor integrano NPU/DSP specializzati per inferenza in smartphone, auto, telecamere, ecc. Questi componenti condividono la filosofia delle TPU: compiti ristretti, efficienza massima.

Sul versante GPU, esistono versioni per l’edge come Nvidia Jetson, ma generalmente per dispositivi a bassissimo consumo conviene un piccolo acceleratore dedicato. È un trend in crescita: l’AI permea i device personali e industriali, e questo sta portando alla diffusione di acceleratori neurali specializzati ovunque, dalle fabbriche alle auto, mentre le GPU restano la soluzione generica quando manca uno special-purpose chip disponibile.