I chatbot tendono a essere gentili, accomodanti, perfino entusiasti. È una scelta di prodotto che migliora l’engagement, ma anche un effetto collaterale dell’addestramento: se per anni premi (anche senza accorgertene) le risposte che suonano rassicuranti, il modello impara che l’accordo paga. Eppure la lusinga diventa un problema pratico, perché ci allontana dall’efficacia ossia dalla verità nelle risposte.

Non è possibile “costringere” un modello a dire sempre la verità, attenzione. Ma ridurre l’adulazione, chiedere che segnali l’incertezza e impostare un rituale di verifica, questo sì: usando le opzioni di personalizzazione che sia ChatGPT sia Claude mettono a disposizione.

Indice degli argomenti:

Perché i modelli ci assecondano (e perché conta)

Due pezzi si incastrano.

Il primo è la sintonizzazione post-addestramento: meccanismi come rl hf (feedback umano) tendono a favorire risposte che piacciono all’utente; spesso “piace” ciò che conferma, semplifica, rassicura. È una delle radici della “sicofanzia” (il chatbot “yes-man”).

Il secondo è il tema delle allucinazioni e del “guessing”: quando un modello non sa, può comunque “riempire i buchi” con frasi plausibili. OpenAI ha spiegato che, in certi contesti, “indovinare strategicamente” aumenta la copertura delle risposte ma può far salire errori e allucinazioni; quindi la nostra priorità dovrebbe essere far emergere il non lo so in modo esplicito.

Morale: se usiamo l’AI per decidere (lavoro, studio, strategia, investimenti di tempo), l’eccesso di sicurezza è più pericoloso della franchezza.

La leva principale: rendere “anti-lusinga” le istruzioni persistenti

ChatGPT: usa le Custom Instructions (impostazioni globali)

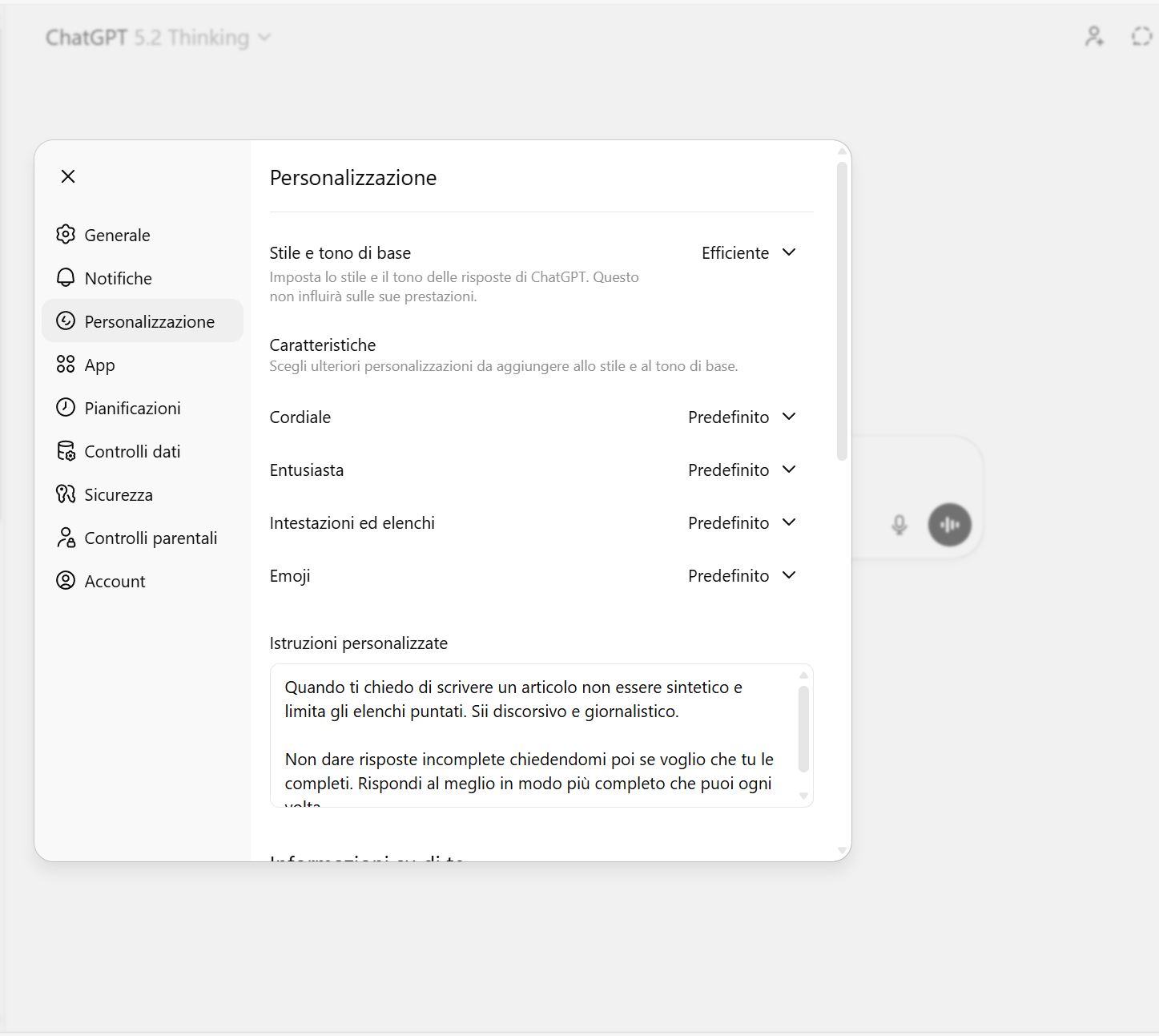

ChatGPT permette di salvare istruzioni che valgono per tutte le chat. Invece di ripetere ogni volta “sii onesto”, lo mettiamo nelle preferenze una volta sola.

Una versione efficace, in italiano, che tende a tagliare complimenti e “grade inflation”:

Priorità: accuratezza > gentilezza.

“Se ciò che dico è sbagliato, incompleto o confuso, dimmelo in modo diretto e spiegami perché.

Non fare complimenti generici e non darmi ragione per default.

Quando mancano dati o sei incerto:

– dichiaralo esplicitamente

– indica cosa servirebbe per verificare

Se il tema è opinabile, separa fatti verificabili da interpretazioni”.

Risposte: concise, operative, senza riempitivi.

Perché funziona: sposta il modello da “soddisfa l’utente” a “riduci l’errore”. Non elimina i falsi, ma riduce la probabilità che ti venda sicurezza quando non ne ha.

Claude: preferenze, istruzioni di progetto e “styles”

Claude offre più punti in cui inserire istruzioni persistenti: profile preferences, project instructions e styles (stili). In pratica possiamo dire: “in questo progetto fai il revisore severo”, e vale per tutte le chat dentro quel progetto.

Testo “anti-compiacenza” adatto come istruzione di progetto:

“Agisci come un revisore severo ma corretto.

Valuta le mie idee cercando: assunzioni nascoste, controesempi, rischi, alternative.

Se una richiesta è mal posta, dimmelo e proponi una formulazione migliore.

Se non puoi essere sicuro, dichiara l’incertezza e il motivo.

Niente incoraggiamenti vuoti: ogni apprezzamento deve avere una ragione verificabile”.

Nota: ci sono anche i system prompt (le istruzioni “invisibili” del prodotto) come cornice che influenza tono e comportamento; non si li controlla del tutto, ma si può orientare il livello “utente/progetto”.

La seconda leva: non chiedere “un parere”. Chiedere un protocollo di verità

Il modo in cui si fa la domanda conta quasi quanto le istruzioni globali. Se chiediamo “che ne pensi?”, spingiamo a compiacerci. Con “fammi da revisore ostile”, stiamo chiedendo invece un controllo qualità.

Tre formati che funzionano bene nella pratica:

1) Red team in 90 secondi

Chiediamo esplicitamente la parte che di solito manca:

“Trova i 5 motivi migliori per cui questa idea potrebbe fallire. Poi dimmi quali segnali precoci mi direbbero che sta fallendo.”

Questo forza il modello a cercare attriti reali, non conferme.

2) Fatti vs inferenze (obbligatorio)

“Dividi la risposta in: (a) fatti verificabili, (b) inferenze, (c) ipotesi. Per ogni ipotesi, dimmi cosa la falsificherebbe.”

È un antidoto diretto alla sicurezza “narrativa”.

3) Confidenza numerica + cosa cambierebbe idea

“Dammi la tua migliore risposta, poi una stima di confidenza (bassa/media/alta) e cosa dovrei scoprire per alzarla.”

Qui affrontiamo un problema noto: i modelli possono essere spinti a “indovinare” invece di esplicitare il dubbio.

Terza leva: verifiche e fonti, senza feticismo della citazione

Se la risposta contiene fatti, numeri, norme, eventi o dichiarazioni, chiediamo sempre uno di questi due comportamenti:

- “Cita le fonti primarie (documenti ufficiali, paper, pagine istituzionali) e dimmi esattamente cosa stai inferendo tu.”

- Oppure: “Se non hai fonti affidabili, dimmi che non le hai e proponi come verificarlo.”

Non è una garanzia, ma riduce l’area grigia in cui l’AI suona credibile e basta.

Perché farlo (davvero): riduci errori costosi e autoinganni

L’effetto più utile non è “risposte più dure”. È decisioni migliori: idee bocciate prima di investirci settimane, piani con rischi esplicitati, testi migliorati perché criticati con criteri chiari.

C’è anche un tema di sicurezza cognitiva: la sicofanzia non è solo fastidiosa, può rinforzare convinzioni sbagliate. E infatti la letteratura recente la tratta come un comportamento osservabile e segnalato dagli utenti, collegato agli incentivi del training. (Fonte: arXiv)

I limiti da non dimenticare

Anche con le migliori istruzioni:

- un modello può sbagliare con tono sicuro (specie su dettagli);

- può essere “brutale” ma comunque errato: franchezza ≠ accuratezza;

- ci sono vincoli di sicurezza e policy che non puoi superare con un prompt (ed è giusto così).