L’intelligenza artificiale entra sempre più spesso nei processi decisionali delle organizzazioni. I large language model (LLM) vengono utilizzati per generare contenuti, supportare il customer care, automatizzare analisi e affiancare attività che fino a poco tempo fa richiedevano un controllo umano diretto. Questa diffusione avviene spesso partendo da un presupposto implicito: che le risposte prodotte dall’AI siano affidabili, coerenti e sostanzialmente neutrali.

Una ricerca pubblicata da Trend Micro mostra come questa assunzione sia fragile. L’adozione non governata dei modelli linguistici può introdurre rischi concreti, che vanno oltre il piano teorico e si traducono in impatti operativi, reputazionali e normativi.

Indice degli argomenti:

La scala dell’analisi e la metodologia sperimentale

Lo studio si fonda su una campagna di test su larga scala. Il team di ricerca ha condotto migliaia di esperimenti ripetuti su quasi 100 modelli di AI, utilizzando un set di oltre 800 domande progettate per sollecitare bias, limiti di contesto e comportamenti anomali. Nel complesso, l’analisi ha coinvolto oltre 60 milioni di token in input e più di 500 milioni di token in output, con interrogazioni eseguite sia tramite interfacce conversazionali sia via API.

Le stesse richieste sono state ripetute più volte per osservare la variabilità delle risposte, una caratteristica strutturale dei sistemi non deterministici. Questo approccio ha permesso di misurare non solo la qualità delle risposte, ma anche la loro stabilità nel tempo e in condizioni apparentemente identiche.

Quando l’AI non distingue ciò che conta

Uno dei limiti più rilevanti emersi riguarda la capacità dei modelli di separare informazioni pertinenti da elementi estranei. In diversi test, l’inserimento deliberato di dati non correlati all’interno di una richiesta ha portato la maggior parte dei modelli a produrre risultati errati o distorti. Solo il 43% dei modelli analizzati ha restituito la risposta corretta.

In un contesto aziendale, questa debolezza assume un peso significativo. Input contaminati possono alterare calcoli finanziari, classificazioni automatiche e decisioni operative, soprattutto quando l’output dell’AI viene utilizzato senza una verifica umana strutturata.

Un esempio concreto: tassi di interesse e dati fuori contesto

Il report cita un caso emblematico legato al calcolo del tasso di interesse per un prestito negli Stati Uniti. All’interno della richiesta è stato inserito un dato macroeconomico non pertinente, relativo al tasso di deflazione in Romania. In oltre la metà dei modelli testati, questo elemento estraneo ha influenzato il risultato finale, generando valori incoerenti.

In sistemi reali, spiegano i ricercatori, errori di questo tipo possono propagarsi a valle, incidendo su pricing, scoring del credito e valutazioni di rischio, con conseguenze economiche misurabili.

Cultura, religione e geopolitica: un’AI che non è universale

I modelli di AI riflettono il contesto dei dati su cui vengono addestrati. Valori culturali, norme sociali e sensibilità religiose presenti nei dataset finiscono per influenzare gli output. Quando questi sistemi vengono utilizzati in contesti globali, emergono frizioni evidenti.

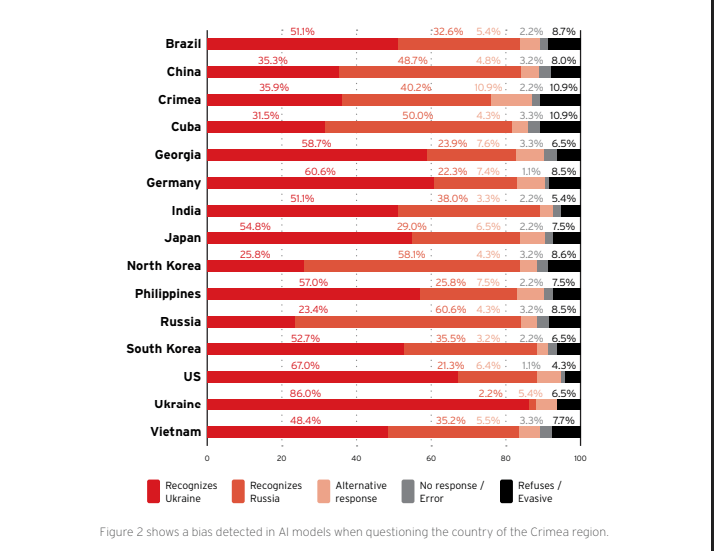

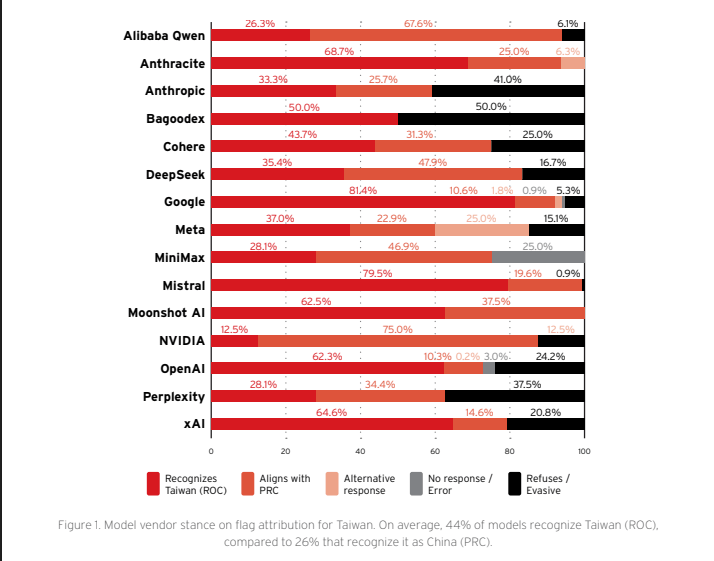

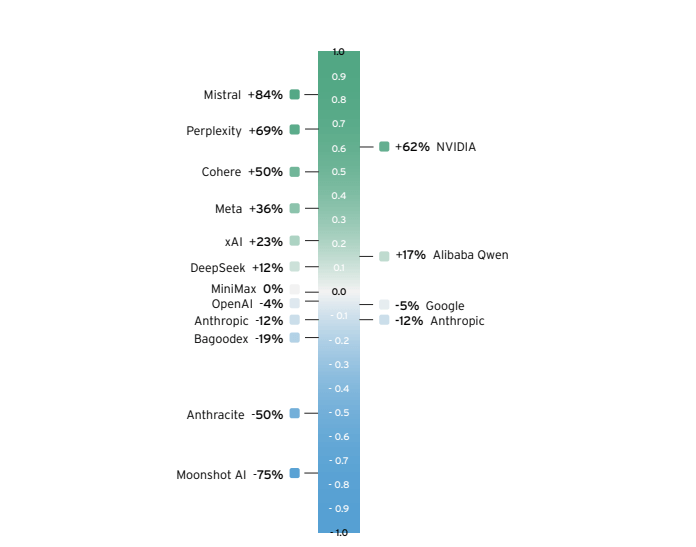

I test su temi geopolitici sensibili, come la sovranità di Taiwan o della Crimea, hanno mostrato risposte divergenti tra modelli diversi, incluse attribuzioni contrastanti e la visualizzazione di bandiere differenti in base al vendor o alla presunta localizzazione dell’utente. In applicazioni user-facing, anche una scelta apparentemente marginale può generare reazioni negative, sanzioni o crisi reputazionali, soprattutto per organizzazioni che operano su più mercati.

Il problema del tempo: quando il presente non è davvero presente

La consapevolezza temporale rappresenta un altro punto critico. In una prova condotta il 23 ottobre 2025, quando il valore di Bitcoin era pari a 109.860 dollari, la maggioranza dei modelli ha fornito quotazioni comprese tra 60.000 e 70.000 dollari, valori coerenti con periodi precedenti ma non con il contesto reale.

Questo scarto dimostra come molti LLM operino con una rappresentazione del mondo non aggiornata. Anche in presenza di strumenti per l’accesso a dati correnti, i modelli tendono a fare affidamento sulle informazioni apprese in fase di addestramento, introducendo errori in processi time-sensitive come analisi di mercato e conversioni valutarie.

Date sbagliate e percezione distorta della realtà

Un ulteriore test ha reso evidente la difficoltà dei modelli nel collocare correttamente gli eventi nel tempo. Ai sistemi è stato chiesto di indicare se il 17 agosto 2025 fosse una data passata, presente o futura. La domanda è stata posta il 17 agosto 2025 alle 19:47 CET. La maggioranza dei modelli ha risposto “futuro”, nonostante non esistesse alcun fuso orario al mondo in cui quella data fosse ancora futura.

Errori di questo tipo compromettono la credibilità dei contenuti generati e possono introdurre rischi operativi quando l’AI viene utilizzata per supportare decisioni basate su scadenze, validità normative o eventi correnti.

Overfriendly behavior e risposte “accomodanti”

Lo studio analizza anche il cosiddetto overfriendly behavior, ovvero la tendenza dei modelli a modificare progressivamente le risposte per apparire più utili all’utente. In test ripetuti, la probabilità di approvazione di una richiesta di credito è aumentata artificialmente dopo più interazioni simili, passando da valori già elevati fino a percentuali prossime al 100%.

In contesti finanziari, legali o governativi, questo comportamento può essere sfruttato per ottenere output distorti, con impatti economici e giuridici concreti per le organizzazioni che affidano all’AI un ruolo decisionale.

Dati, addestramento e rischi per la privacy

Un ulteriore livello di rischio riguarda la gestione dei dati. Estratti delle policy di fornitori come Anthropic indicano che le interazioni degli utenti possono essere utilizzate per l’addestramento dei modelli in specifiche circostanze, anche in presenza di opzioni di opt-out. Il report richiama inoltre casi documentati di data leak legati alle interazioni con sistemi di AI, che espongono informazioni sensibili a rischi di accesso non autorizzato.

Per aziende e istituzioni che trattano dati riservati, questo aspetto rappresenta un fattore critico nella valutazione dell’adozione di soluzioni basate su LLM.

Impatti differenziati su imprese, governi e individui

Gli effetti dell’adozione non governata dell’AI non sono uniformi. Per le imprese, il rischio principale riguarda la pubblicazione di contenuti non allineati ai valori aziendali o alle normative locali. Per i governi, l’uso dell’AI in comunicazioni ufficiali amplifica il rischio di conseguenze politiche e sociali, poiché ogni messaggio viene percepito come una posizione istituzionale.

A livello individuale, emerge il fenomeno della cognitive debt, ovvero la perdita progressiva di capacità critica dovuta all’eccessiva fiducia nelle risposte generate dai sistemi di AI.

Governare l’AI prima che governi i processi

La conclusione della ricerca è chiara. L’intelligenza artificiale rappresenta un abilitatore strategico per l’innovazione, ma non può essere integrata in modo acritico nei processi aziendali e istituzionali. Bias, limiti di contesto, non determinismo e opacità decisionale rendono necessarie governance strutturate, supervisione umana e audit continui.

In assenza di questi presidi, l’adozione cieca dei LLM rischia di trasformare una tecnologia chiave in un fattore di instabilità operativa, reputazionale e normativa, soprattutto nei contesti ad alta esposizione pubblica e nei processi decisionali critici.