IBM ha comunicato le novità della sua annuale Developer Conference, durante la quale ha presentato una serie di novità che spaziano tra hardware, software e algoritmi, come parte della sua roadmap verso il calcolo quantistico utile. Al centro delle novità spicca il nuovo processore, chiamato IBM Quantum Nighthawk, progettato per il “quantum advantage” – ovvero il momento in cui un computer quantistico supera tutti i metodi classici.

Indice degli argomenti:

Nighthawk: dettagli dell’hardware

Nighthawk integra 120 qubit collegati mediante 218 coupler sintonizzabili verso i quattro vicini in una griglia a quadrato. Questo rappresenta un aumento di oltre il 20 % dei coupler rispetto al suo predecessore IBM Quantum Heron.

Grazie a questa architettura, IBM stima che sarà possibile eseguire circuiti con circa il 30% in più di complessità rispetto alle generazioni precedenti, pur mantenendo bassi tassi d’errore.

Il target sull’orizzonte è ambizioso: entro fine 2026, esecuzione fino a 7.500 porte a 2 qubit; nel 2027 fino a 10.000 e nel 2028 fino a 15.000, estendendo la scala fino a 1.000 qubit con coupler a lungo raggio.

IBM prevede che Nighthawk sarà disponibile agli utenti entro fine 2025.

Software e mitigazione dell’errore

Parallelamente all’hardware, IBM ha aggiornato la sua piattaforma software Qiskit introducendo una “execution model” che consente un controllo più fine dei circuiti, un’interfaccia C-API e l’integrazione con ambienti HPC (High Performance Computing).

Tra i miglioramenti dichiarati: un aumento del 24% dell’accuratezza nei circuiti dinamici a 100+ qubit, e una riduzione del costo per ottenere risultati accurati tramite mitigazione dell’errore di oltre 100 volte.

Questi passi sono critici per trasformare la maggiore complessità hardware in risultati pratici e affidabili.

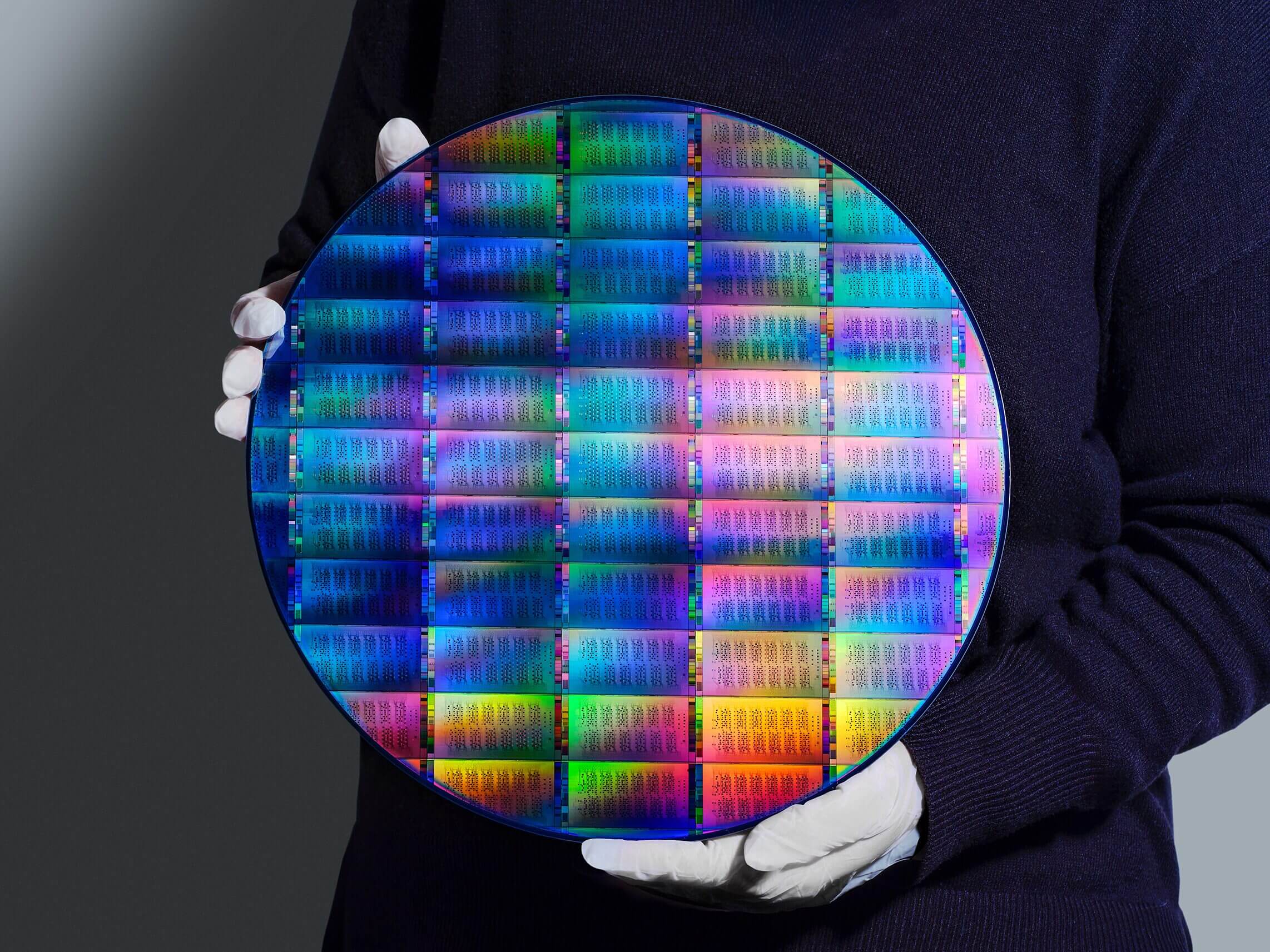

Verso il fault-tolerant: IBM Quantum Loon e la produzione su wafer da 300 mm

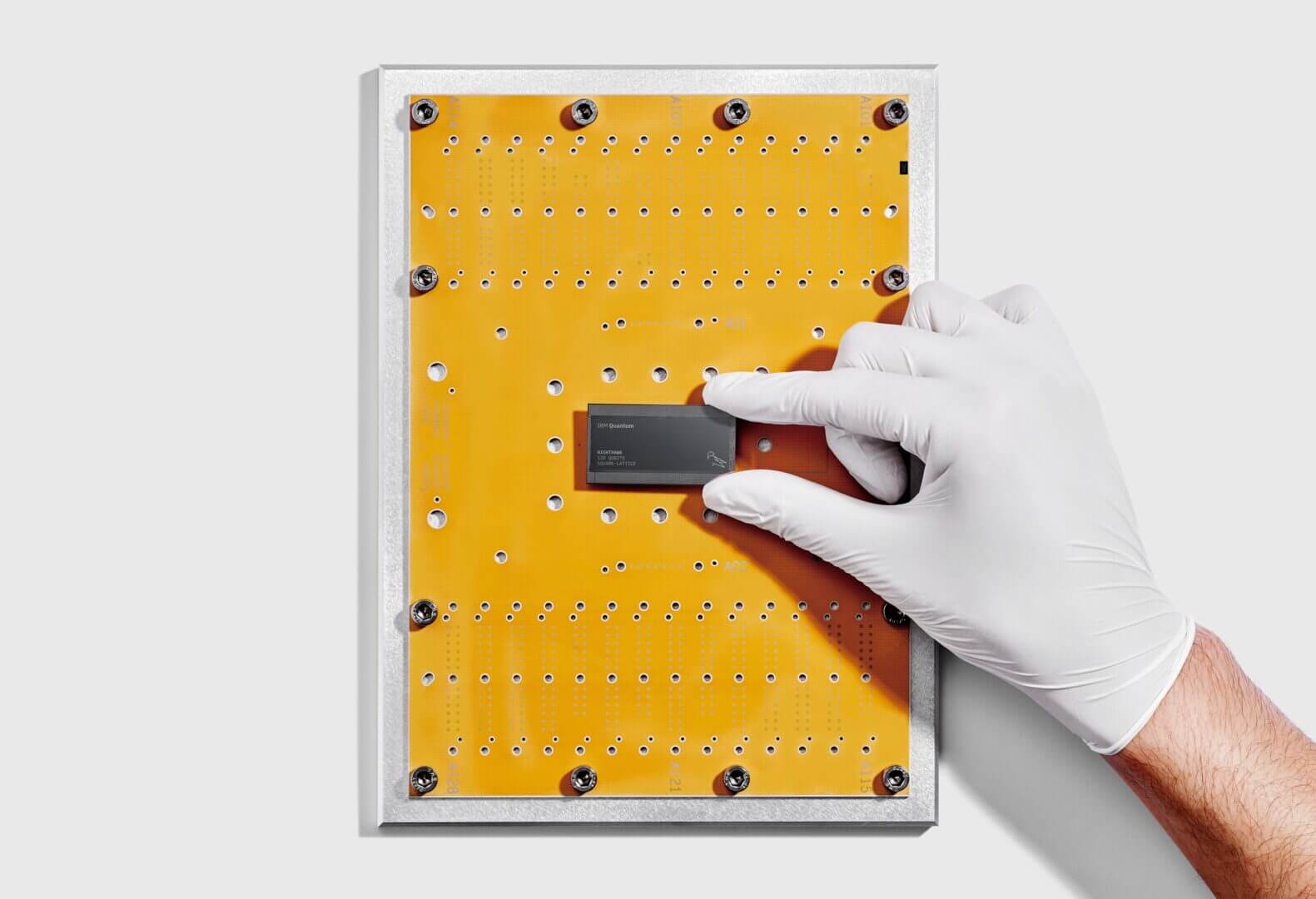

Oltre al processore Nighthawk, IBM ha presentato anche IBM Quantum Loon, un prototipo che integra tutti i componenti chiave per il calcolo quantistico fault-tolerant previsto entro il 2029.

Tra le innovazioni: routing a più strati con “c-coupler” per collegamenti a lungo raggio sul chip, e reset dei qubit tra computazioni.

In parallelo, IBM ha annunciato che la produzione dei wafer dei processori quantistici sta migrando a impianti da 300 mm presso l’Albany NanoTech Complex a New York. Ciò ha permesso all’azienda di raddoppiare la velocità di R&D, aumentare di dieci volte la complessità fisica dei chip e lavorare su più design in parallelo.

Implicazioni e contesto

Questo annuncio è rilevante per vari motivi:

- Il salto nella connettività e nella scala dei qubit indica che IBM sta puntando seriamente verso applicazioni quantistiche che vanno oltre la pura sperimentazione.

- Il rilascio dell’hardware e del software insieme suggerisce che l’ecosistema quantistico viene trattato come sistema completo, non solo come chip isolato.

- La roadmap temporale segnata – quantum advantage entro il 2026, fault-tolerant entro il 2029 – fornisce un riferimento ambizioso ma vago di segnali concreti.

- Il tracker open da parte della community per il vantaggio quantistico che IBM promuove (insieme a partner come Algorithmiq e BlueQubit) aiuta a favorire trasparenza e verifica indipendente dei passi falsi o veri del settore.

Limiti e domande aperte

Nonostante l’entusiasmo, restano alcune considerazioni realistiche:

- “Circuiti con 30% in più di complessità” sono ancora distanti dal calcolo quantistico pienamente utile su scala industriale.

- Raggiungere effettivamente il quantum advantage richiederà che l’hardware, il software e gli algoritmi siano tutti allineati e testati in condizioni di produzione, non solo in laboratorio.

- La validazione esterna e indipendente dei risultati è fondamentale: per rendere credibili le affermazioni occorrono benchmark pubblici e verificabili dalla comunità.

- Il cammino verso l’errore correzione completo e la macchina fault-tolerant è ancora lungo, con molti ostacoli tecnologici e ingegneristici da superare.

Conclusioni

Con Nighthawk, IBM compie un ulteriore passo nel percorso verso un futuro dove il calcolo quantistico non è più mera promessa, ma si candida a essere strumento concreto per ricerca, industria e applicazioni complesse. Se i prossimi anni confermeranno le tempistiche – quantum advantage entro il 2026, sistema fault-tolerant entro il 2029 – ci troveremo in una nuova era dell’informatica. Tuttavia, la prudenza rimane d’obbligo: ogni fase del processo dovrà superare test rigorosi prima di diventare utile alla comunità più ampia.