Il rapido sviluppo dell’intelligenza artificiale pone sfide significative sul piano etico e normativo. Nasce così il concetto di “trustworthy AI”, un’intelligenza artificiale che risulti affidabile, trasparente e responsabile.

Indice degli argomenti:

Cos’è la trustworthy AI?

La trustworthy AI mira a stabilire fiducia negli strumenti di intelligenza artificiale attraverso la formulazione di linee guida specifiche per l’acquisizione, lo sviluppo e la modifica dei modelli e dei dati. Ciò implica una maggiore consapevolezza della natura probabilistica dei sistemi di AI e la capacità di dimostrare la validità delle decisioni prese da questi sistemi tramite spiegazioni chiare e cicli di feedback continui.

Il concetto di trustworthy AI è stato sollevato ufficialmente il 17 luglio 2020, quando l’High-Level Expert Group on Artificial Intelligence (AI HLEG), istituito dalla Commissione Europea, ha presentato il suo documento finale: “Assessment List for Trustworthy Artificial Intelligence (ALTAI)”, che fornisce una lista pratica di criteri per valutare quanto un sistema di AI possa considerarsi affidabile.

Anche Paolo Benanti, esperto di etica delle tecnologie, nuovo presidente della Commissione AI per l’informazione, affronta questo tema introducendo il concetto di “algoretica[1]”. Con questo termine, il teologo e filosofo indica una nuova area di riflessione morale che prende in esame le decisioni prese automaticamente dalle macchine, esplorando come gli algoritmi possano incorporare principi di responsabilità e trasparenza fin dalla progettazione. L’algoretica cerca di prevenire i pregiudizi algoritmici e promuovere l’equità nell’applicazione di queste tecnologie, contribuendo a rendere l’AI più giusta e inclusiva.

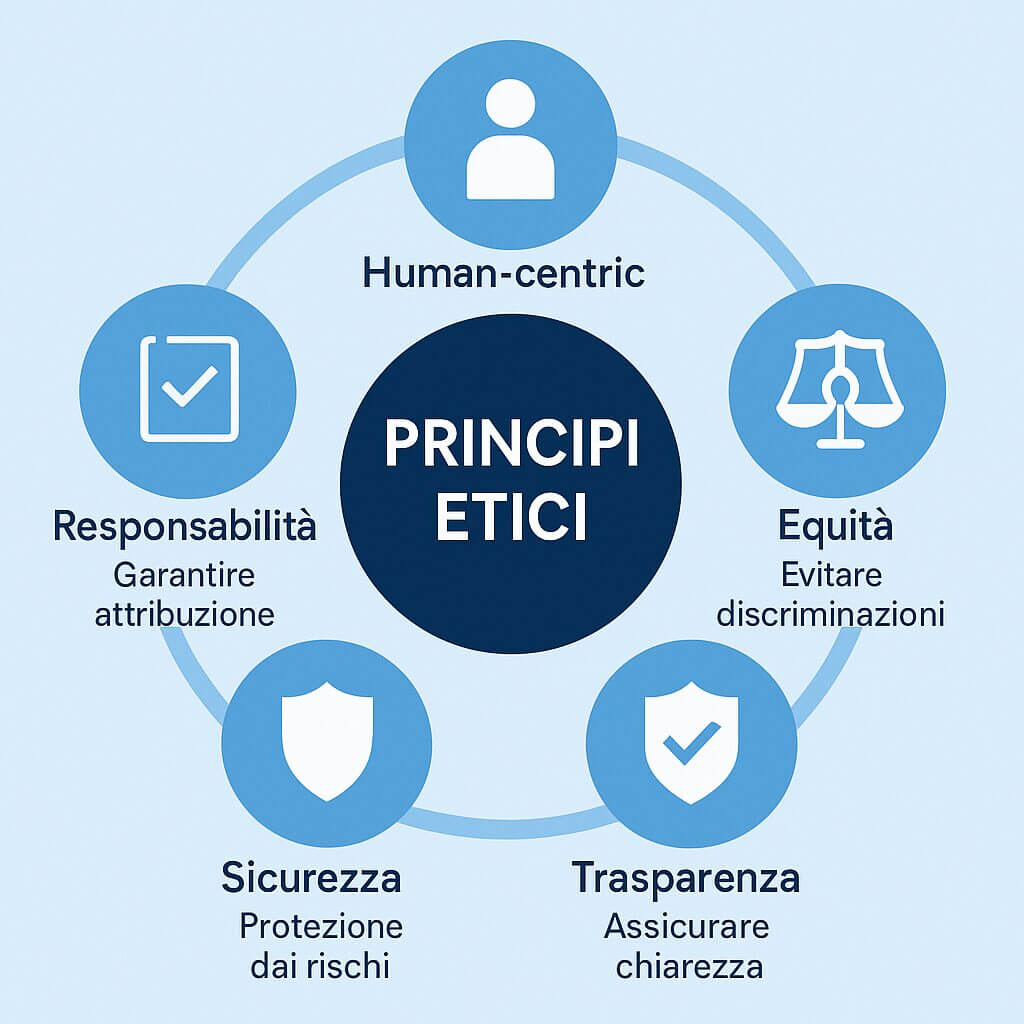

I 5 principi di una AI responsabile

- Human-centric: è fondamentale che le soluzioni di AI siano progettate con un approccio centrato sull’uomo, supportando attivamente gli obiettivi e le attività umane e considerando le esigenze a livello sia personale che collettivo. L’adozione di tecnologie AI che assistono le persone nel superare sfide quotidiane può apportare un significativo valore aggiunto, non solo a livello individuale ma anche sociale, contribuendo a migliorare la qualità della vita e l’efficienza nel lavoro.

- Equità: un aspetto che possiamo definire ormai “must-have” nell’implementazione dell’AI è la promozione dell’equità. Questa tecnologia offre un’opportunità unica per mitigare le disparità esistenti nella società, ma ciò richiede che chi sviluppa queste tecnologie si assuma la responsabilità morale di creare strumenti accessibili a tutti, senza esclusioni, per garantire la piena inclusività. In questo modo, l’AI può diventare un potente strumento per ridurre le disuguaglianze anziché amplificarle. Un grande esempio sono avatar umanoidi che riescono a comprendere la lingua dei segni per la comunità sorda (LIS). Per cui tutto quello che abbiamo menzionato in precedenza, la possibilità di creare un vero e proprio cortometraggio si potrebbe realizzare con un avatar che conosce la lingua dei segni che si occuperebbe di interpretare lo script per darlo in pasto alle macchine e, quindi, alla generazione di elaborati video.[2]

3. Trasparenza: la trasparenza è altrettanto essenziale: gli utenti devono essere pienamente consapevoli degli strumenti che utilizzano. L’implementazione di pratiche come l’esplicito consenso all’utilizzo delle tecnologie AI può migliorare la fiducia degli utenti, promuovendo una percezione di un’intelligenza artificiale più etica e responsabile. Questo implica che ogni applicazione di AI dovrebbe chiaramente indicare come i dati personali vengano raccolti, analizzati e utilizzati, assicurando che gli utenti possano esercitare un controllo informato.

4. Sicurezza: per quanto riguarda la sicurezza, le soluzioni di AI devono proteggere gli utenti, garantendo l’uso sicuro dei loro dati. Ciò comporta l’implementazione di robuste misure di sicurezza per prevenire accessi non autorizzati, perdite di dati e altri rischi potenziali che possono compromettere la privacy e l’integrità dell’utente.

5. Responsabilità: la responsabilità dello sviluppo e dell’implementazione dell’AI ricade sui suoi sviluppatori e sulla loro leadership. È incoraggiante notare che alcune organizzazioni leader stanno già integrando specialisti in etica per assicurare che l’intelligenza artificiale venga sviluppata e impiegata in maniera responsabile e conforme agli standard etici.

Questi principi formano il fondamento della trustworthy AI e assicurano che la tecnologia serva effettivamente il bene comune.

Implementazione pratica: esempi di uso responsabile dell’AI

Un esempio concreto di trustworthy AI riguarda il settore finanziario, dove gli algoritmi di AI valutano l’affidabilità creditizia. Implementare un’AI responsabile significa qui utilizzare modelli trasparenti, evitare discriminazioni razziali o di genere e consentire sempre una revisione umana in casi critici.

Nel settore sanitario, l’AI può diagnosticare precocemente malattie come il cancro. Tuttavia, è essenziale che tali sistemi siano trasparenti nella loro metodologia e nei dati utilizzati, garantendo una comprensione chiara da parte di medici e pazienti. Un esempio virtuoso è il sistema Watson di IBM, che integra tecniche avanzate di intelligenza artificiale mantenendo standard rigorosi di trasparenza e responsabilità. Un altro esempio è rappresentato dagli algoritmi utilizzati negli ospedali per ottimizzare la pianificazione degli interventi chirurgici, che devono rispettare principi di equità e trasparenza assicurando che ogni paziente riceva il trattamento più appropriato e tempestivo senza discriminazioni.

Per garantire che esempi come questi non restino isolati e per promuovere una diffusione capillare dell’utilizzo responsabile dell’AI, è necessario intervenire non solo sul piano tecnico e operativo, ma anche su quello normativo e organizzativo. La responsabilità etica non può essere delegata esclusivamente agli sviluppatori o ai team tecnici, ma deve essere integrata in una visione sistemica che coinvolge le istituzioni, le imprese e la società civile. È in questo contesto che la governance dell’intelligenza artificiale assume un ruolo centrale: definire strutture, regole e processi condivisi per orientare lo sviluppo e l’uso dell’AI in modo coerente con i valori fondamentali della nostra società.

La governance dell’AI

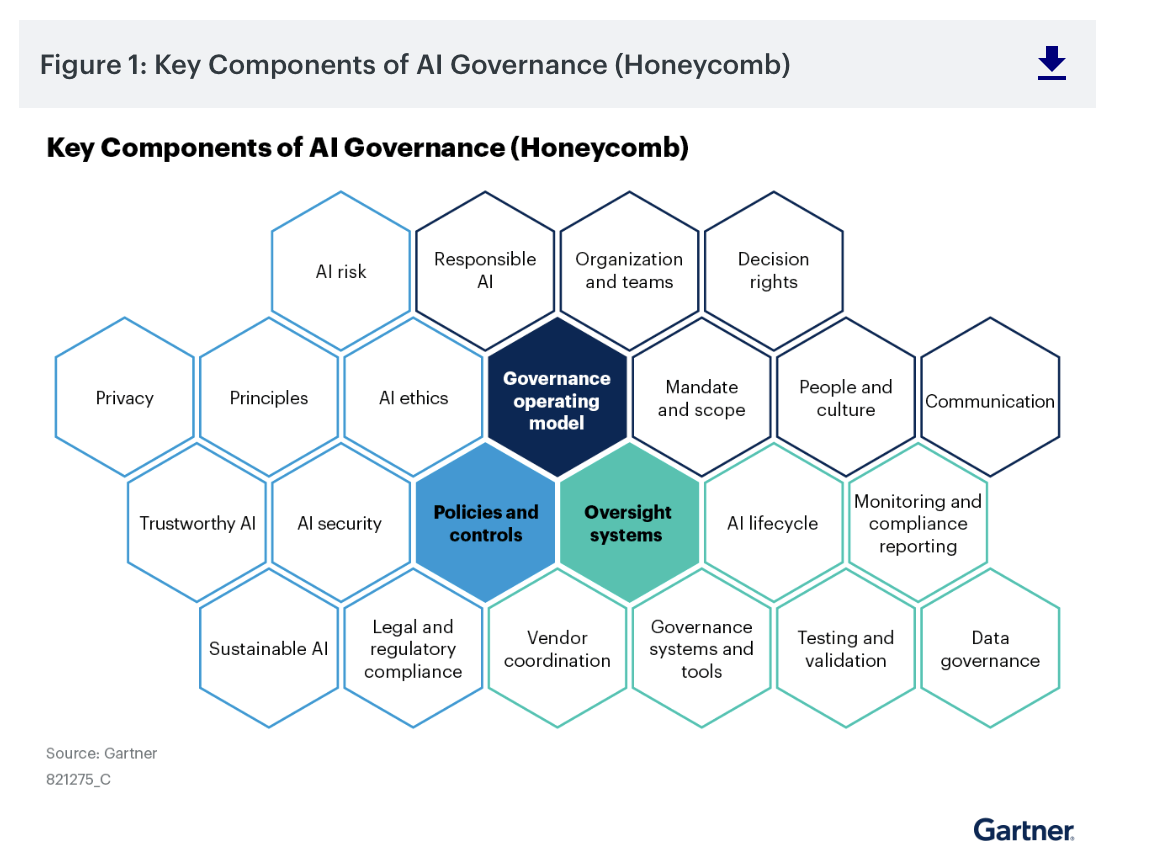

Gartner prevede che entro il 2027 la governance dell’AI diventerà un requisito obbligatorio in tutte le principali normative internazionali.

Questo scenario impone alle organizzazioni un impegno concreto e proattivo nella definizione di standard elevati di responsabilità, trasparenza e sostenibilità. Non si tratta solo di conformità normativa, ma di un vero e proprio asset strategico per il futuro dell’innovazione tecnologica.

La governance dell’AI diventa un “must-have” per bilanciare il valore e i rischi associati all’adozione delle tecnologie intelligenti. Una governance efficace dell’AI implica l’adozione di un modello operativo che includa principi guida, controlli, strumenti abilitanti e una chiara definizione dei ruoli e delle responsabilità.

Le organizzazioni devono stabilire un quadro normativo interno che consenta di monitorare e gestire l’intero ciclo di vita dell’AI: dalla progettazione e sviluppo, fino all’implementazione e al monitoraggio dei risultati.

I principali obiettivi della governance

I principali obiettivi della governance includono: garantire la trasparenza decisionale, mitigare i rischi etici e legali, proteggere la privacy e assicurare la sicurezza dei dati, oltre a promuovere l’affidabilità e la tracciabilità degli algoritmi. Una governance ben strutturata permette inoltre di favorire la fiducia degli stakeholder, interni ed esterni, nei confronti dell’adozione dell’AI, facilitando così la sua accettazione e diffusione.

L’obiettivo dell’intelligenza artificiale oggi non è solo quello di potenziare i processi, ma di semplificare radicalmente l’interazione, rendendola accessibile anche a chi non possiede competenze tecnologiche o tecniche. L’AI ha superato il concetto tradizionale di usabilità, evolvendosi verso una relazione conversazionale simile a quella tra esseri umani. È proprio questa naturalezza che la rende uno strumento potente anche per favorire l’inclusione, facilitando la comunicazione con persone che vivono disabilità linguistiche o cognitive.

In questo contesto, la trasparenza non è più un’opzione, ma un presupposto essenziale: è ciò che alimenta la fiducia nella tecnologia e consente agli utenti di utilizzarla senza esitazione, senza doversi chiedere se siano in grado di comprenderla o controllarla. Solo così l’intelligenza artificiale potrà davvero essere percepita come alleata quotidiana, pronta ad accompagnare le azioni dell’utente in modo intuitivo, sicuro e responsabile.

Note

M. Venini, Il primo avatar che parla la lingua dei segni in Forbes, in www. forbes.it/2023/01/19/questit-lancia-primo-avatar-parlare-lis/, 2023 ↑

P. Benanti, Abbiamo bisogno di un’Algoretica, in https://www.youtube.com/watch?v=cT-2dzUvPXI, 2024 ↑