L’uso quotidiano dell’AI generativa sta modificando in profondità il modo in cui pensiamo e decidiamo. A partire da un recente paper di Shaw e Nave, che introduce la Tri-System Theory, affiancando ai due sistemi classici del pensiero umano un terzo sistema artificiale.

Il concetto di cognitive surrender aiuta a spiegare perché, quando consultiamo l’AI, tendiamo ad adottarne le risposte con poca verifica critica. Dallo studio del MIT sul “brain rot” (brain rot è la parola coniata dall’Oxford 2024 per indicare deterioramento mentale, ndr) alle riflessioni di Chiriatti, Mollick e Clark, emerge una questione centrale: non se usare l’AI, ma come governare la delega del giudizio nell’era del lavoro cognitivo aumentato.

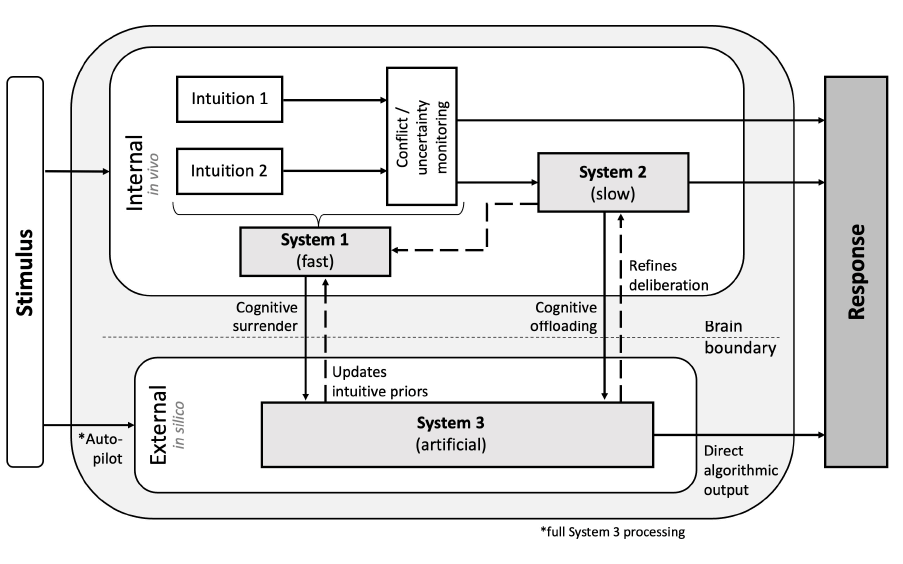

Teoria tri-sistemica della cognizione

Indice degli argomenti:

Quando il pensiero non è più solo nella nostra testa

Negli ultimi mesi è diventato normale chiedere a un sistema di AI una risposta, una spiegazione, una sintesi. Lo facciamo per lavorare, per orientarci, per decidere. Spesso senza la sensazione di delegare qualcosa di importante. Anzi, con l’impressione di essere più rapidi ed efficienti. Eppure, sotto questa normalità, sta avvenendo qualcosa di più profondo, non stiamo solo usando uno strumento, stiamo modificando l’architettura del nostro ragionamento.

La domanda che inizia a emergere è semplice, ma scomoda: quando accettiamo una risposta generata dall’AI, stiamo pensando meglio o stiamo semplicemente adottando un pensiero già fatto?

Il modello che ha spiegato il pensiero (finché ha potuto)

Per decenni abbiamo interpretato il funzionamento della mente attraverso la distinzione tra due modalità di pensiero: una rapida, intuitiva, automatica; l’altra lenta, riflessiva, deliberata. Questa cornice, resa celebre da Daniel Kahneman, premio Nobel per l’Economia, ha avuto un impatto enorme ben oltre la psicologia cognitiva, influenzando economia comportamentale, politiche pubbliche, management e decision making.

Il contributo di Kahneman non è stato solo descrittivo. Il modello dei due sistemi ha mostrato che gran parte dei nostri giudizi quotidiani non è il risultato di un’analisi razionale consapevole, ma di scorciatoie mentali efficienti, spesso utili, talvolta fuorvianti. Al tempo stesso, ha chiarito che il pensiero deliberativo ha un costo cognitivo elevato e viene attivato solo quando necessario, o quando qualcosa “non torna”.

Questa dinamica, un equilibrio fragile tra efficienza e controllo, ha reso il modello dei due sistemi così potente e duraturo. Condivideva però un presupposto implicito: che il pensiero avvenisse interamente all’interno della mente umana. Questo presupposto oggi è cambiato.

Quando il ragionamento esce dal cervello

Una parte crescente del nostro ragionamento avviene ora fuori dal perimetro biologico della mente. Non solo calcoli o recupero di informazioni, ma valutazioni, argomentazioni, risposte complete vengono prodotte da sistemi esterni e poi adottate dall’umano.

Questo passaggio non è improvviso, né del tutto inedito. Da tempo utilizziamo tecnologie che orientano le nostre scelte, il navigatore che decide il percorso, l’algoritmo che ordina le notizie, il sistema che suggerisce cosa guardare o comprare. La differenza introdotta dai modelli generativi è che, per la prima volta, l’output non è una raccomandazione puntuale, ma un ragionamento già articolato, pronto per essere accettato così com’è.

Quando chiediamo a un modello generativo di “risolvere”, “spiegare”, “scrivere”, spesso non ricostruiamo il percorso che porta a quella risposta. Non perché non ne saremmo capaci, ma perché il costo cognitivo di rifarlo appare sproporzionato rispetto al beneficio percepito.

La risposta è coerente, fluida, ben argomentata. Funziona. Questo scarto, tra la possibilità di giudicare e la scelta di non farlo esce dal cervello. Qui non siamo più nel campo del semplice supporto cognitivo o dell’automazione di singoli compiti. Siamo di fronte a una delega del giudizio, anche quando non ne siamo consapevoli.

Il terzo sistema: la proposta di Shaw e Nave

Da questa trasformazione nasce la Tri-System Theory, proposta da Steven Shaw e Gideon Nave. Gli autori partono da una constatazione empirica semplice: sempre più spesso le persone, mentre ragionano, scelgono deliberatamente di consultare un sistema di AI e poi incorporano quell’output nella propria decisione.

Per descrivere questo fenomeno, Shaw e Nave estendono i modelli a due sistemi introducendo un terzo attore cognitivo, esterno al cervello umano ma funzionalmente integrato nel processo di ragionamento.

Non intuitivo. Non deliberativo. Ma artificiale.

Il Sistema 3 è una forma di cognizione esterna che opera al di fuori della mente biologica, ma che interagisce con essa in tempo reale. Produce risposte complete, argomentazioni strutturate, suggerimenti di soluzione che non richiedono di essere “costruiti” passo dopo passo dall’individuo. Sempre disponibile, non si affatica, si presenta con un’elevata sicurezza espressiva.

Non è l’AI a imporsi, siamo noi a chiamarla in causa

Nel paper questa distinzione non è solo concettuale, ma operativa. Negli esperimenti, ai partecipanti viene data la possibilità di consultare un assistente AI durante la risoluzione di compiti di ragionamento. La scelta di attivare il Sistema 3 è volontaria e avviene in una percentuale elevata dei casi. Questo dato è essenziale, non è l’AI a imporsi, siamo noi a chiamarla in causa.

Il punto centrale è che il Sistema 3 non si limita a supportare i processi interni, come farebbe una calcolatrice o un motore di ricerca. Può:

- affiancare l’intuizione, fornendo una risposta rapida;

- sostituire la deliberazione, offrendo una soluzione già formata;

- oppure scavalcare entrambi, diventando il riferimento principale per la decisione.

È qui che la Tri-System Theory segna un cambio di paradigma: il ragionamento non è più solo il risultato di un dialogo interno tra sistemi mentali, ma l’esito di un’interazione tra mente umana e cognizione artificiale.

La resa cognitiva

Il concetto centrale del paper è quello di cognitive surrender, una resa cognitiva. Non una rinuncia consapevole, ma l’adozione dell’output dell’AI con un livello minimo di scrutinio critico, fino al punto in cui l’output esterno finisce per sostituire il giudizio interno. Per chiarire questo passaggio, Shaw e Nave non si limitano a una definizione teorica, ma costruiscono una serie di esperimenti controllati.

Ai partecipanti viene proposto un compito di ragionamento basato su una versione adattata del Cognitive Reflection Test, con la possibilità, facoltativa, di consultare un assistente AI. Il Cognitive Reflection Test (CRT) è uno strumento utilizzato in psicologia cognitiva ed economia comportamentale per misurare la tendenza delle persone a fermarsi e riflettere prima di rispondere.

Le domande del CRT sono costruite in modo da evocare una risposta immediata, intuitiva e apparentemente plausibile, che però risulta errata. La risposta corretta diventa accessibile solo se l’individuo inibisce l’intuizione iniziale e attiva un ragionamento più lento e deliberato.

Il test misura una disposizione cognitiva specifica

Il test non misura conoscenze né intelligenza in senso tradizionale. Misura invece una disposizione cognitiva specifica, la capacità e la volontà, di passare dal pensiero rapido e automatico (Sistema 1) al pensiero riflessivo e analitico (Sistema 2). Per questo il CRT è spesso utilizzato come indicatore operativo del pensiero critico e del controllo metacognitivo.

Un elemento chiave del disegno sperimentale è che l’accuratezza dell’AI viene manipolata in modo invisibile, in alcune condizioni l’AI fornisce risposte corrette, in altre risposte errate. Il risultato è particolarmente istruttivo.

Quando l’AI è accurata, le prestazioni dei partecipanti migliorano in modo significativo. Quando l’AI sbaglia, le loro prestazioni peggiorano, scendendo al di sotto del livello di accuratezza osservato quando il Sistema 3 non è disponibile.

Questo andamento asimmetrico è ciò che gli autori definiscono la “firma comportamentale” della resa cognitiva, l’accuratezza umana non viene semplicemente aiutata dall’AI, ma si aggancia a quella del sistema esterno. Ancora più rilevante è ciò che accade sul piano soggettivo. Anche quando l’AI fornisce risposte errate, i partecipanti tendono a riportare un aumento della sicurezza nelle proprie risposte. In altre parole, il Sistema 3 non solo influenza l’esito della decisione, ma rimodella la percezione di affidabilità del proprio giudizio.

Questa dinamica permette di distinguere chiaramente tra due fenomeni spesso confusi. Da un lato c’è il cognitive offloading: delegare all’esterno un calcolo, una ricerca, una sintesi. Dall’altro c’è la resa cognitiva: delegare il criterio con cui valutiamo se una risposta è buona o cattiva. È in questo secondo caso che il Sistema 3 tende a scavalcare sia l’intuizione rapida (Sistema 1) sia la deliberazione riflessiva (Sistema 2). Il punto critico non è che le persone “si fidino troppo” dell’AI in astratto.

Il punto è che, una volta attivato il Sistema 3, il costo cognitivo di rimettere in discussione l’output aumenta, mentre il beneficio percepito diminuisce. La scelta di verificare, riformulare o dissentire diventa meno probabile, soprattutto sotto pressione temporale o in presenza di incentivi alla rapidità. Questo è il vero salto concettuale del paper, la resa cognitiva non è un difetto individuale, ma un esito sistemico dell’interazione tra mente umana e cognizione artificiale. Non stiamo solo “usando” l’AI. In molti casi, stiamo lasciando che decida al nostro posto.

Brain rot e MIT: un segnale, non la spiegazione

In questo contesto va collocato il dibattito sul cosiddetto brain rot, acceso anche dal noto studio del MIT Media Lab dedicato all’uso di ChatGPT nella scrittura di saggi . Lo studio misura, tramite EEG, il livello di attivazione cerebrale durante un compito di scrittura svolto in tre condizioni: senza supporti, con un motore di ricerca e con un modello linguistico.

I risultati che hanno attirato maggiore attenzione mostrano, nel gruppo che utilizza ChatGPT, una minore attivazione di alcune bande associate a memoria e creatività, una minore varietà linguistica nei testi prodotti e una maggiore tendenza, nelle prove successive, ad affidarsi in modo integrale all’output del modello.

Su questa base, gli autori avanzano l’ipotesi di un possibile cognitive debt, una riduzione progressiva della capacità di attivare risorse cognitive proprie a seguito di un uso ripetuto dell’assistenza AI. Questi dati, però, vanno interpretati con cautela. Il campione è ridotto, l’effetto di familiarizzazione gioca un ruolo rilevante e l’EEG, per sua natura, misura correlati neurali dello sforzo, non la qualità o la profondità del pensiero. Una maggiore attivazione cerebrale non coincide automaticamente con un apprendimento migliore, così come una minore attivazione non implica di per sé un impoverimento cognitivo.

Cosa accade quando il Sistema 3 viene utilizzato come sostituto del processo deliberativo

La Tri-System Theory consente di rimettere a fuoco il problema. Lo studio del MIT non dimostra che l’AI “indebolisca il cervello”, ma mostra cosa accade quando il Sistema 3 viene utilizzato come sostituto del processo deliberativo, anziché come supporto o stimolo. In altre parole, ciò che emerge non è un danno cognitivo generalizzato, ma un cambiamento nella distribuzione del lavoro mentale.

Il punto cruciale non è la riduzione dello sforzo in sé. Ridurre lo sforzo può essere razionale se il tempo e le risorse liberate vengono riallocate verso attività a maggiore valore cognitivo. Il rischio reale, coerente con quanto descritto da Shaw e Nave, è un altro, che la riduzione dello sforzo si accompagni a una riduzione del controllo sul processo di giudizio.

Letto in questa chiave, il dibattito sul brain rot non contraddice la Tri-System Theory, ma ne rappresenta un caso applicativo parziale. Quando il Sistema 3 viene chiamato sistematicamente a “pensare al posto nostro”, la mente umana non si spegne, ma si ritrae dal ruolo di valutatore critico.

Un arretramento, più che una presunta atrofia, il vero nodo cognitivo che il paper aiuta a mettere a fuoco.

Dalla teoria alla pratica: la delega da governare

Questo passaggio non riguarda solo la psicologia individuale. Ha implicazioni dirette per il lavoro e le organizzazioni.

Massimo Chiriatti, tecnologo e strategist dell’AI, da anni impegnato sul fronte dell’adozione dell’intelligenza artificiale nelle imprese e nelle grandi organizzazioni, ha più volte sottolineato come il vero nodo dell’AI non sia l’automazione delle attività in sé, ma la governance della delega.

Quando un sistema smette di essere uno strumento operativo e inizia a intervenire nei processi decisionali, il problema non è più tecnico, ma riguarda il modo in cui vengono distribuite responsabilità, controllo e capacità di giudizio all’interno dell’organizzazione. La Tri-System Theory fornisce il linguaggio per descrivere questo slittamento: quando la delega non riguarda più singoli compiti, ma il giudizio stesso. In questo senso, l’apporto di Chiriatti è rilevante perché nasce dall’osservazione diretta dei contesti organizzativi: l’AI entra nei processi non come decision maker formale, ma come filtro cognitivo preliminare, che orienta opzioni, priorità e framing delle decisioni umane. Allo stesso tempo, come ricorda Ethan Mollick, professore alla Wharton School e tra i principali studiosi dell’impatto organizzativo dell’AI, l’intelligenza artificiale non pensa al posto nostro per default, lo fa se siamo noi a lasciarle il posto.

Nei suoi lavori, Mollick insiste su un punto coerente con la Tri-System Theory: l’AI può agire come collaboratore cognitivo solo se il ruolo umano resta quello di supervisione, confronto e decisione finale. In assenza di questa regia, la resa cognitiva non è un destino inevitabile, ma un esito probabile.

Un passaggio già intravisto, oggi più radicale

L’idea che il pensiero possa estendersi oltre il cervello non è nuova. La filosofia della extended mind di Andy Clark, filosofo e scienziato cognitivo britannico, tra i principali teorici contemporanei del rapporto tra mente, corpo e tecnologia, aveva già mostrato come strumenti, ambienti e artefatti cognitivi possano diventare parte integrante dei processi mentali. Scrivere appunti, usare diagrammi, affidarsi a supporti esterni non impoverisce il pensiero: lo riorganizza.

La Tri-System Theory introduce però una discontinuità rilevante. Qui l’estensione non è solo un supporto passivo o una memoria ausiliaria, ma un sistema che produce giudizi, propone soluzioni e orienta decisioni. Il passaggio non è dall’interno all’esterno, ma da un pensiero distribuito a un pensiero co-delegato, in cui una parte della funzione valutativa viene esercitata da un agente non umano.

Questo rende il fenomeno qualitativamente diverso da tutto ciò che abbiamo conosciuto finora. Non si tratta più di pensare “con” strumenti, ma di pensare insieme a, o al posto di, un sistema cognitivo artificiale. Il Sistema 3 diventa così non solo una estensione, ma un nuovo polo dell’ecologia cognitiva.

La svolta che non abbiamo ancora adottato

Se accettiamo che oggi il pensiero sia triadico, intuitivo, deliberativo e artificiale, allora il problema non è decidere se usare o meno l’AI, ma come ridisegniamo i contesti in cui il giudizio viene esercitato. Continuare a trattare l’AI come un semplice strumento rischia di nascondere il fatto che, in molti casi, essa sta già operando come infrastruttura cognitiva. La storia della calcolatrice è istruttiva, ma va letta fino in fondo. Quando il calcolo è stato automatizzato, non si è difesa la fatica in sé, si è spostata l’asticella verso problemi più complessi, in cui il valore stava nella comprensione, nella scelta del metodo, nell’interpretazione dei risultati.

Con l’AI generativa, invece, stiamo spesso mantenendo invariati compiti e criteri di valutazione, creando le condizioni ideali per una resa cognitiva sistematica. La vera svolta richiede di cambiare il fuoco, dal controllo dello strumento alla progettazione dei ruoli cognitivi.

Cosa ha senso delegare al Sistema 3? In quali passaggi il giudizio umano deve restare centrale? Dove è necessario introdurre frizioni, verifiche, momenti di riflessione forzata? Capire il Sistema 3 non serve a demonizzare l’AI né a celebrarla. Serve a rendere visibile un cambiamento già in atto: il giudizio non è più solo un fatto individuale, ma il risultato di un’architettura socio-tecnica.

L’architettura dove si giocherà il futuro del lavoro cognitivo, dell’autonomia professionale e della responsabilità decisionale.